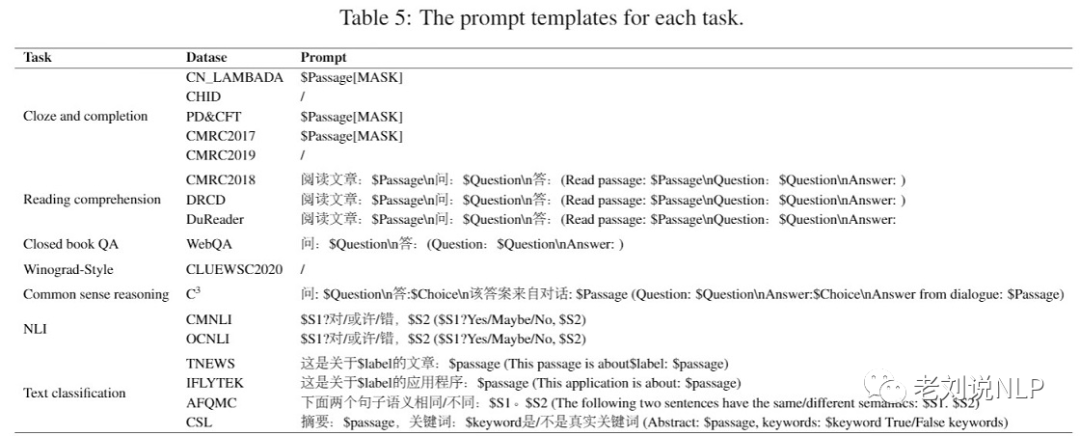

在大模型开发过程中,如何利用下游任务对已有模型进行反馈十分重要,这关系到小模型的快速迭代评估。例如,为了评估模型性能,鹏程·盘古α团队收集了16个不同类型的中文下游任务,

本文主要介绍ZeroCLUE/FewCLUE数据集、中文长下文词语预测 (Chinese WPLC)数据集几个下游任务数据集,供大家参考。

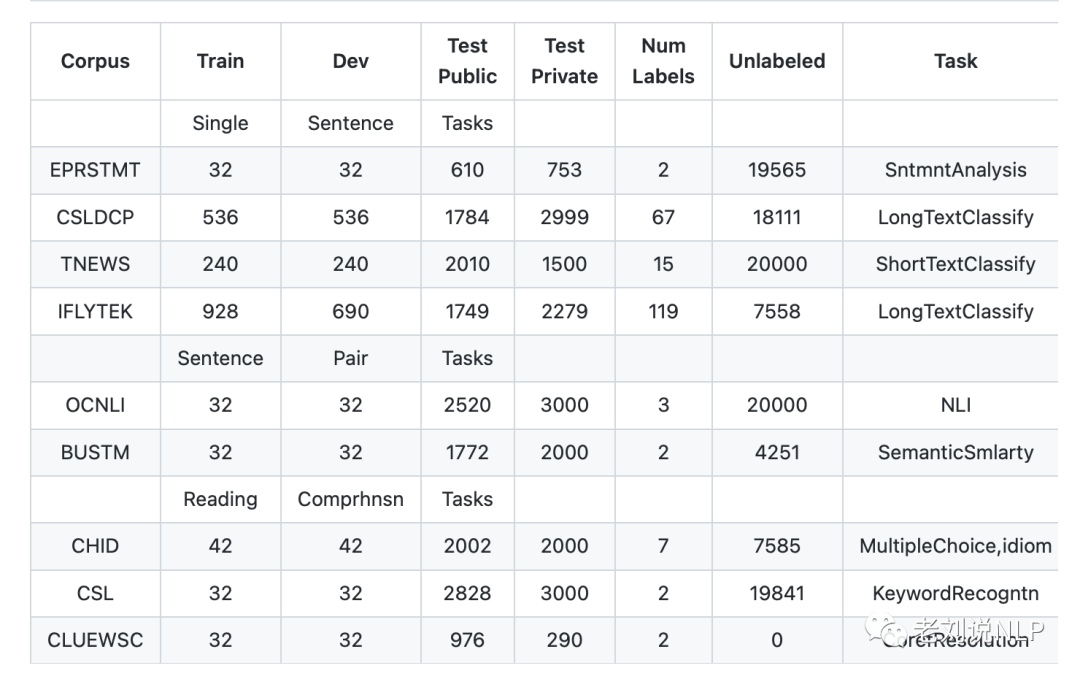

一、ZeroCLUE/FewCLUE数据集

零样本学习是AI识别方法之一。简单来说就是识别从未见过的数据类别,即训练的分类器不仅仅能够识别出训练集中已有的数据类别, 还可以对于来自未见过的类别的数据进行区分。小样本学习(Few-shot Learning)是解决在极少数据情况下的机器学习问题展开的评测。

地址:https://github.com/CLUEbenchmark/ZeroCLUE 地址:https://github.com/CLUEbenchmark/FewCLUE

其中:

1、EPRSTMT:电商评论情感分析

数据量:训练集(32),验证集(32),公开测试集(610),测试集(753),无标签语料(19565)

例子:

{"id":23,"sentence":"外包装上有点磨损,试听后感觉不错","label":"Positive"}

每一条数据有三个属性,从前往后分别是 id,sentence,label。其中label标签,Positive 表示正向,Negative 表示负向。

2、CSLDCP:科学文献学科分类

中文科学文献学科分类数据集,包括67个类别的文献类别,这些类别来自于分别归属于13个大类,范围从社会科学到自然科学,文本为文献的中文摘要。

数据量:训练集(536),验证集(536),公开测试集(1784),测试集(2999),无标签语料(67)

例子:

{"content":"通过几年的观察和实践,初步掌握了盆栽菊花的栽培技术及方法,并进行了总结,以满足人们对花卉消费的需求,提高观赏植物的商品价值,为企业化生产的盆菊提供技术指导。",

"label":"园艺学","id":1770}

{"content":"GPS卫星导航定位精度的高低很大程度上取决于站星距离(即伪距)的测量误差.载波相位平滑伪距在保证环路参数满足动态应力误差要求的基础上。。。本文详细论述了载波相位平滑伪距的原理和工程实现方法,并进行了仿真验证.",

"label":"航空宇航科学与技术","id":979}

每一条数据有三个属性,从前往后分别是 id,sentence,label。其中label标签,Positive 表示正向,Negative 表示负向。

3、TNEWS:新闻分类

该数据集来自今日头条的新闻版块,共提取了15个类别的新闻,包括旅游、教育、金融、军事等。

例子:

{"label":"102","label_des":"news_entertainment","sentence":"江疏影甜甜圈自拍,迷之角度竟这么好看,美吸引一切事物"}

每一条数据有三个属性,从前往后分别是分类ID,分类名称,新闻字符串(仅含标题)。

4、IFLYTEK:APP应用描述主题分类

该数据集关于app应用描述的长文本标注数据,包含和日常生活相关的各类应用主题,共119个类别:"打车":0,"地图导航":1,"免费WIFI":2,"租车":3,….,"女性":115,"经营":116,"收款":117,"其他":118(分别用0-118表示)。

例子:

{"label":"110","label_des":"社区超市","sentence":"朴朴快送超市创立于2016年,专注于打造移动端30分钟即时配送一站式购物平台,商品品类包含水果、蔬菜、肉禽蛋奶、海鲜水产、粮油调味、酒水饮料、休闲食品、日用品、外卖等。朴朴公司希望能以全新的商业模式,更高效快捷的仓储配送模式,致力于成为更快、更好、更多、更省的在线零售平台,带给消费者更好的消费体验,同时推动中国食品安全进程,成为一家让社会尊敬的互联网公司。,朴朴一下,又好又快,1.配送时间提示更加清晰友好2.保障用户隐私的一些优化3.其他提高使用体验的调整4.修复了一些已知bug"}

每一条数据有三个属性,从前往后分别是类别ID,类别名称,文本内容。

5、OCNLI: 自然语言推理

OCNLI,即原生中文自然语言推理数据集,是第一个非翻译的、使用原生汉语的大型中文自然语言推理数据集。

数据量:训练集(32),验证集(32),公开测试集(2520),测试集(3000),无标签语料(20000)

例子:

{

"level":"medium",

"sentence1":"身上裹一件工厂发的棉大衣,手插在袖筒里",

"sentence2":"身上至少一件衣服",

"label":"entailment","label0":"entailment","label1":"entailment","label2":"entailment","label3":"entailment","label4":"entailment",

"genre":"lit","prem_id":"lit_635","id":0

}

6、BUSTM: 对话短文本匹配

对话短文本语义匹配数据集,源于小布助手。它是OPPO为品牌手机和IoT设备自研的语音助手,为用户提供便捷对话式服务。

意图识别是对话系统中的一个核心任务,而对话短文本语义匹配是意图识别的主流算法方案之一。要求根据短文本query-pair,预测它们是否属于同一语义。

数据量:训练集(32),验证集(32),公开测试集(1772),测试集(2000),无标签语料(4251)

例子:

{"id":5,"sentence1":"女孩子到底是不是你","sentence2":"你不是女孩子吗","label":"1"}

{"id":18,"sentence1":"小影,你说话慢了","sentence2":"那你说慢一点","label":"0"}

7、CHID:成语阅读理解

以成语完形填空形式实现,文中多处成语被mask,候选项中包含了近义的成语。https://arxiv.org/abs/1906.01265

数据量:训练集(42),验证集(42),公开测试集(2002),测试集(2000),无标签语料(7585)

例子:

{"id":1421,"candidates":["巧言令色","措手不及","风流人物","八仙过海","平铺直叙","草木皆兵","言行一致"],

"content":"当广州憾负北控,郭士强黯然退场那一刻,CBA季后赛悬念仿佛一下就消失了,可万万没想到,就在时隔1天后,北控外援约瑟夫-杨因个人裁决案(拖欠上一家经纪公司的费用),

导致被禁赛,打了马布里一个#idiom#,加上郭士强带领广州神奇逆转天津,让...","answer":1}

8、CSL:摘要判断关键词判别

中文科技文献数据集(CSL)取自中文论文摘要及其关键词,论文选自部分中文社会科学和自然科学核心期刊,任务目标是根据摘要判断关键词是否全部为真实关键词(真实为1,伪造为0)。

数据量:训练集(32),验证集(32),公开测试集(2828),测试集(3000),无标签语料(19841)

例子:

{"id":1,"abst":"为解决传统均匀FFT波束形成算法引起的3维声呐成像分辨率降低的问题,该文提出分区域FFT波束形成算法.远场条件下,

以保证成像分辨率为约束条件,以划分数量最少为目标,采用遗传算法作为优化手段将成像区域划分为多个区域.在每个区域内选取一个波束方向,

获得每一个接收阵元收到该方向回波时的解调输出,以此为原始数据在该区域内进行传统均匀FFT波束形成.对FFT计算过程进行优化,降低新算法的计算量,

使其满足3维成像声呐实时性的要求.仿真与实验结果表明,采用分区域FFT波束形成算法的成像分辨率较传统均匀FFT波束形成算法有显著提高,且满足实时性要求.",

"keyword":["水声学","FFT","波束形成","3维成像声呐"],"label":"1"}

每一条数据有四个属性,从前往后分别是数据ID,论文摘要,关键词,真假标签。

9、CLUEWSC: 代词消歧

Winograd Scheme Challenge(WSC)是一类代词消歧的任务,即判断句子中的代词指代的是哪个名词。题目以真假判别的方式出现,如:

句子:这时候放在[床]上[枕头]旁边的[手机]响了,我感到奇怪,因为欠费已被停机两个月,现在[它]突然响了。需要判断“它”指代的是“床”、“枕头”,还是“手机”?

从中国现当代作家文学作品中抽取,再经语言专家人工挑选、标注。

数据量:训练集(32),验证集(32),公开测试集(976),测试集(290),无标签语料(0)

例子:

{"target":

{"span2_index":37,

"span1_index":5,

"span1_text":"床",

"span2_text":"它"},

"idx":261,

"label":"false",

"text":"这时候放在床上枕头旁边的手机响了,我感到奇怪,因为欠费已被停机两个月,现在它突然响了。"}

"true"表示代词确实是指代span1_text中的名词的,"false"代表不是。

二、中文长下文词语预测 (Chinese WPLC)数据集

Chinese Word Prediction with Long Context (Chinese WPLC) 是天津大学联合鹏城实验室在小说上建立的依赖长上下文预测目标单词的中文数据集,创建目的是为了评测模型建模长文本的能力。

数据集地址:https://openi.pcl.ac.cn/PCL-Platform.Intelligence/Chinese_WPLC

下面是文献3网站对该数据集的描述:

该数据集在给定前文的条件下,测试机器预测目标句子最后一个单词的能力,选择的上下文、目标句子及待预测单词满足以下条件:当给定完整语境时待预测单词很容易被猜测出来,当只给最后一个句子时,难以被猜测出来。我们希望通过这个数据集检测模型在长上下文上提取信息的能力。例如:

上下文:随后他立即想到自己为什么如此气愤——他之所以气愤,是因为他害怕了。在他个人处于巨大危险的情况下,贝思抛弃了他。在海底深处只剩下他们三个人,他们互相需要——他们得互相依靠。

目标句:然而贝思不可信赖,这使他感到害怕,而且

目标词:气愤

在上述的例子中,目标词 “气愤“ 能够通过上下文和目标句推测出来,而单靠目标句,很难被猜测出来。

1、数据采集与构建流程

Step1)数据收集

Chinese WPLC数据集来自网络爬取的小说,涵盖玄幻、言情、武侠、侦探、悬疑等类型,总量超过6万部。将重复的小说、公开读本(世界名著、文学名著、古典名著等)以及敏感词比例超5%的小说过滤后,剩余小说按照2:1:1的比例随机划分为训练集、测试集和验证集。

Step2)段落抽取

使用pkuseg对分句后的测试集和验证集小说段落进行分词,以段落最后一句为终点句子,在终点句子之前,往前累计总词数大于50的最少完整句子集合抽取出来作为上下文,并进一步将终点句子最后一个词作为待预测单词,终点句子剩余部分构成目标句子。上下文、目标句子、待预测单词共同组成一个上下文段落。抽取上下文段落需满足以下条件:

目标词不是停用词。

目标词在训练集语料中词频大于5。

pkuseg、jieba[2]、thulac[3]三种分词工具切分出来的目标词一致。

目标句子包含至少10个词。

每本小说最多抽取200个上下文段落。

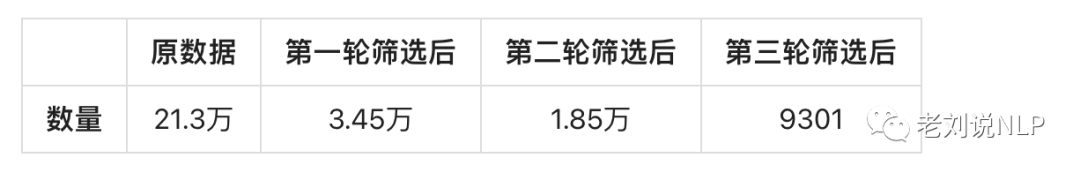

仅当条件1不满足时,可将停用词前一个词作为目标词进行上述2-5条件检测,其余情况,将上下文段落抛弃。最终抽取出210万个段落。

Step3)段落过滤

为减少数据集构建时间,需过滤掉相对简单的段落。使用以下四种组合生成答案候选:

给定目标句子的预训练NEZHA[4]。

给定目标句子的微调NEZHA。

给定上下文和目标句子的预训练NEZHA。

给定上下文和目标句子的微调NEZHA。

当待预测单词出现在任一束搜索策略生成的Top-5个答案候选中时,将该段落抛弃。

为进一步减少人工标注量,在构建数据集过程将待预测单词困惑度在使用上下文和不使用上下文比值的对数作为指标。优先考虑指标大于1的段落,由此得到21万个段落。

Step4)人工筛选

将Step3剩余段落经过随机抽样后通过100+标注人员进行三轮标注:

在给定完整段落(上下文+目标句)猜测目标词,猜对后的上下文段落进入下一轮。

给不同标注人员重复第一轮。

给定目标句让三个不同的标注人员最多猜9个词,如果目标词都没有被猜到,则将该段落加入Chinese WPLC数据集。

第三轮标注中标注人员每人每个段落最多猜测3个词,以最大限度确保待预测单词需通过长上下文信息才能推断出来,而不能通过单个句子进行推断。虽然第三轮标注能够确保待预测单词不能通过局部信息推断,但是由于标注人员知识存在差异,该流程不能确保第一轮标注段落能被猜对。第二轮标注进一步确保上下文段落可以被猜对。为减少人工标注时间,在标注过程中提示标注人员待预测词的长度(字数)。

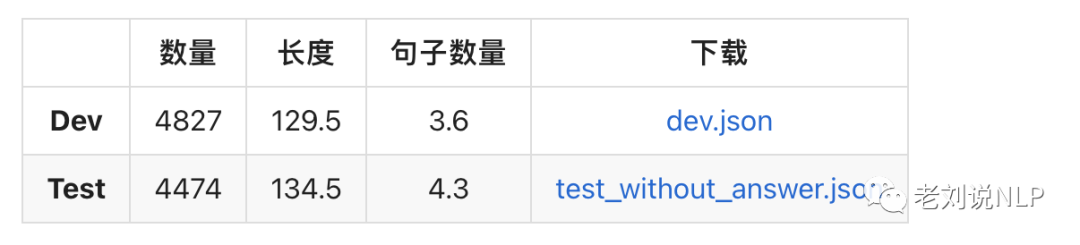

2、数据统计分析与样例

经过第一轮后,只有14-17%的数据能进入下一轮,在第二轮中的数据中,有50%-60%的数据能进入第三轮。在第三轮标注中,只有60%的数据能够构成最后的Chinese WPLC数据集。

1)数据统计

数据统计如表1所示:

Chinese WPLC数据集每个上下文段落平均由3-4个句子构成,平均长度为120个字,如表2所示:

2)数据样例

数据格式可参考下面两个样本数据,每个样本由2个字段组成,masked_text字段是上下文和目标句子,correct_word是位置上正确的词,数量代表待预测单词字数。

{

"masked_text":"随后他立即想到自己为什么如此气愤——他之所以气愤,是因为他害怕了。在他个人处于巨大危险的情况下,贝思抛弃了他。在海底深处只剩下他们三个人,他们互相需要——他们得互相依靠。然而贝思不可信赖,这使他感到害怕,而且。" {

"masked_text":"钟将也不躲不闪,只是简单的凝出一块雷光盾,只是他的雷光盾却不像楚毅峰的那样包裹住整个身体,只有脸盆大小,但是他的雷光盾完全是一块整体,没有雷电闪烁,没有电芒流转。甚至连一点雷电的痕迹都看不到,就是一声银色的坚实!" 总结

本文主要介绍ZeroCLUE/FewCLUE数据集、中文长下文词语预测 (Chinese WPLC)数据集几个下游任务数据集,感兴趣的可以查看参考文献进一步处理。

审核编辑 :李倩

-

分类器

+关注

关注

0文章

152浏览量

13276 -

语言模型

+关注

关注

0文章

547浏览量

10393 -

数据集

+关注

关注

4文章

1212浏览量

24952

原文标题:语言模型性能评估必备下游数据集:ZeroCLUE/FewCLUE与Chinese_WPLC数据集

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

请问NanoEdge AI数据集该如何构建?

详解ChatGPT数据集之谜

大语言模型(LLM)预训练数据集调研分析

语言模型性能评估必备下游数据集:ZeroCLUE/FewCLUE与Chinese_WPLC数据集

语言模型性能评估必备下游数据集:ZeroCLUE/FewCLUE与Chinese_WPLC数据集

评论