Yann LeCun 这个观点的确有些大胆。

「从现在起 5 年内,没有哪个头脑正常的人会使用自回归模型。」最近,图灵奖得主 Yann LeCun 给一场辩论做了个特别的开场。而他口中的自回归,正是当前爆红的 GPT 家族模型所依赖的学习范式。

当然,被 Yann LeCun 指出问题的不只是自回归模型。在他看来,当前整个的机器学习领域都面临巨大挑战。 这场辩论的主题为「Do large language models need sensory grounding for meaning and understanding ?」,是近期举办的「The Philosophy of Deep Learning」会议的一部分。会议从哲学角度探讨了人工智能研究的当前问题,尤其是深度人工神经网络领域的近期工作。其目的是将正在思考这些系统的哲学家和科学家聚集在一起,以便更好地了解这些模型的能力、局限性以及它们与人类认知的关系。 根据辩论 PPT 来看,Yann LeCun 延续了他一贯的犀利风格,直言不讳地指出「Machine Learning sucks!」「Auto-Regressive Generative Models Suck!」最后话题自然是回到「世界模型」。在这篇文章中,我们根据 PPT 梳理了 Yann LeCun 的核心观点。 后续录像资料请关注大会官网:https://phildeeplearning.github.io/ Yann LeCun 核心观点Machine Learning sucks!

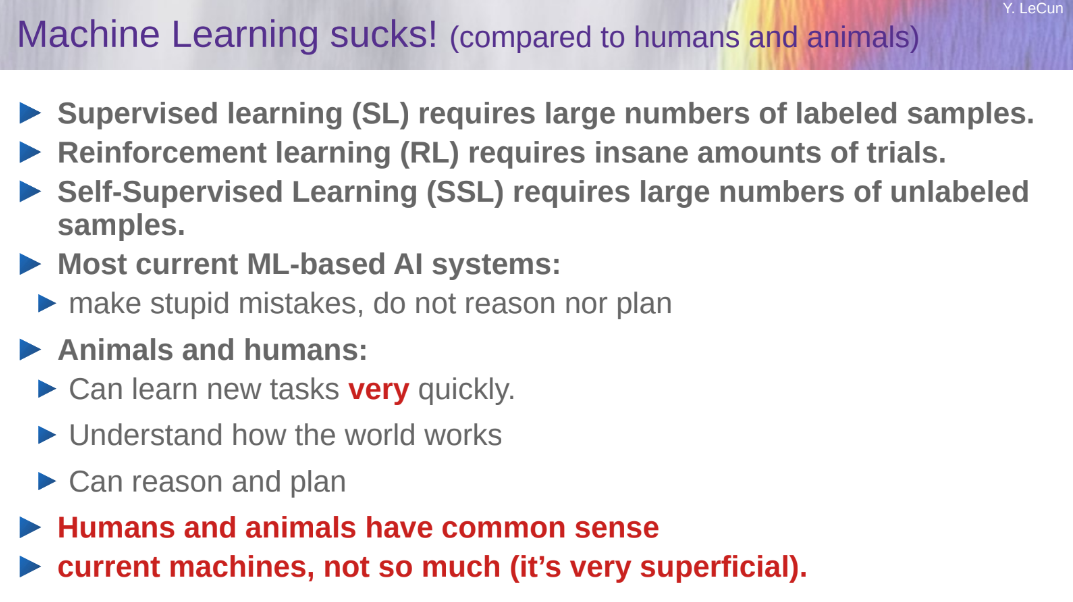

「Machine Learning sucks!(机器学习糟透了)」Yann LeCun 把这个小标题放在了 PPT 的开头。不过,他还补充了一句:与人类和动物相比。

机器学习有什么问题?LeCun 分情况列举了几项:

监督学习(SL)需要大量的标注样本;

强化学习(RL)需要大量的试验;

自监督学习(SSL)需要大量的未标记样本。

而且,当前大部分基于机器学习的 AI 系统都会犯非常愚蠢的错误,不会推理(reason),也不会规划(plan)。 相比之下,人和动物能做的事情就多了很多,包括:

理解世界是如何运作的;

能预测自己行为的后果;

可以进行无限多步骤的推理链;

能将复杂的任务分解成一系列的子任务来规划;

更重要的是,人和动物是有常识的,而当前的机器所具备的常识相对肤浅。

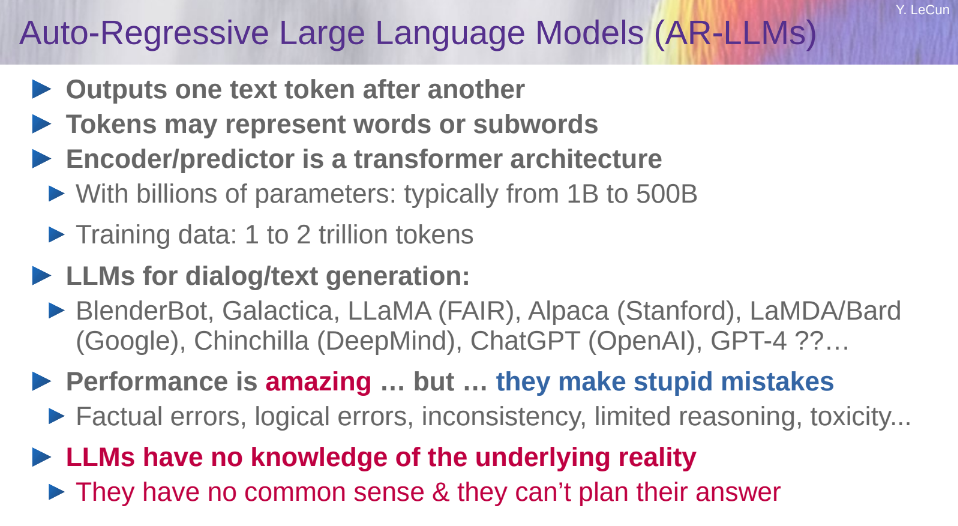

自回归大型语言模型没有前途 在以上列举的三种学习范式中,Yann LeCun 重点将自监督学习拎了出来。 首先可以看到的是,自监督学习已经成为当前主流的学习范式,用 LeCun 的话说就是「Self-Supervised Learning has taken over the world」。近几年大火的文本、图像的理解和生成大模型大都采用了这种学习范式。 在自监督学习中,以 GPT 家族为代表的自回归大型语言模型(简称 AR-LLM)更是呈现越来越热门的趋势。这些模型的原理是根据上文或者下文来预测后一个 token(此处的 token 可以是单词,也可以是图像块或语音片段)。我们熟悉的 LLaMA (FAIR)、ChatGPT (OpenAI) 等模型都属于自回归模型。 但在 LeCun 看来,这类模型是没有前途的(Auto-Regressive LLMs are doomed)。因为它们虽然表现惊人,但很多问题难以解决,包括事实错误、逻辑错误、前后矛盾、推理有限、容易生成有害内容等。重要的是,这类模型并不了解这个世界底层的事实(underlying reality)。

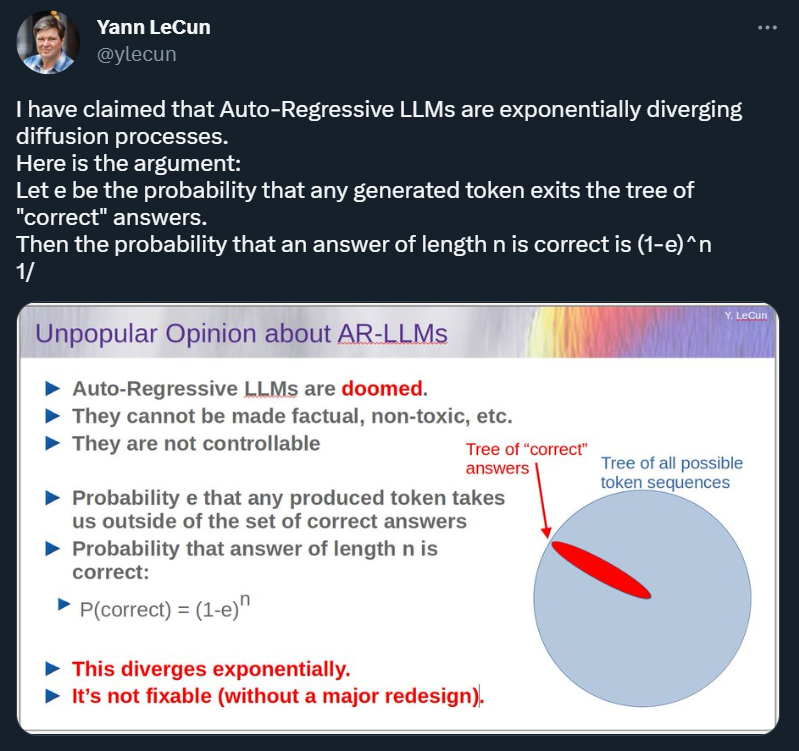

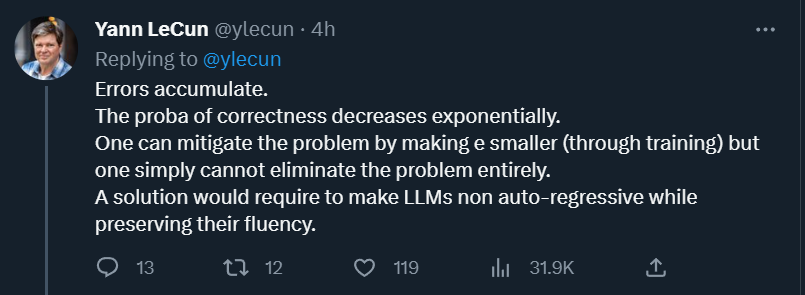

从技术角度分析,假设 e 是任意生成的 token 可能将我们带离正确答案集的概率,那么长度为 n 的答案最终为正确答案的概率就是 P (correct) = (1-e)^n。按照这个算法,错误会不断积累,而正确性则呈指数级下降。当然,我们可以通过将 e 变小来缓解这个问题(通过训练),但无法完全消除,Yann LeCun 解释说。他认为,要解决这个问题,我们需要在保持模型流畅性的同时,让 LLM 不再进行自回归。

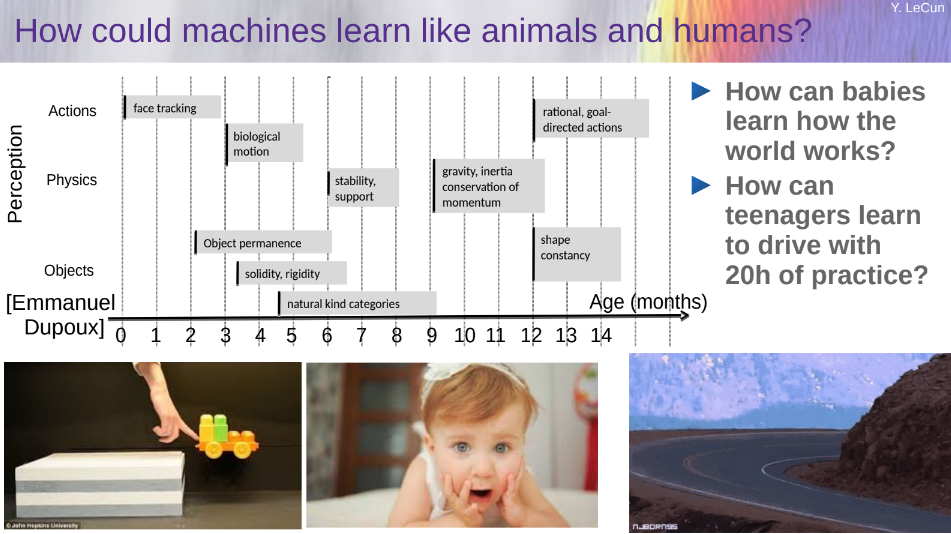

LeCun 认为有前途的方向:世界模型 当前风头正劲的 GPT 类模型没有前途,那什么有前途呢?在 LeCun 看来,这个答案是:世界模型。 这些年来,LeCun 一直在强调,与人和动物相比,当前的这些大型语言模型在学习方面是非常低效的:一个从没有开过车的青少年可以在 20 小时之内学会驾驶,但最好的自动驾驶系统却需要数百万或数十亿的标记数据,或在虚拟环境中进行数百万次强化学习试验。即使费这么大力,它们也无法获得像人类一样可靠的驾驶能力。

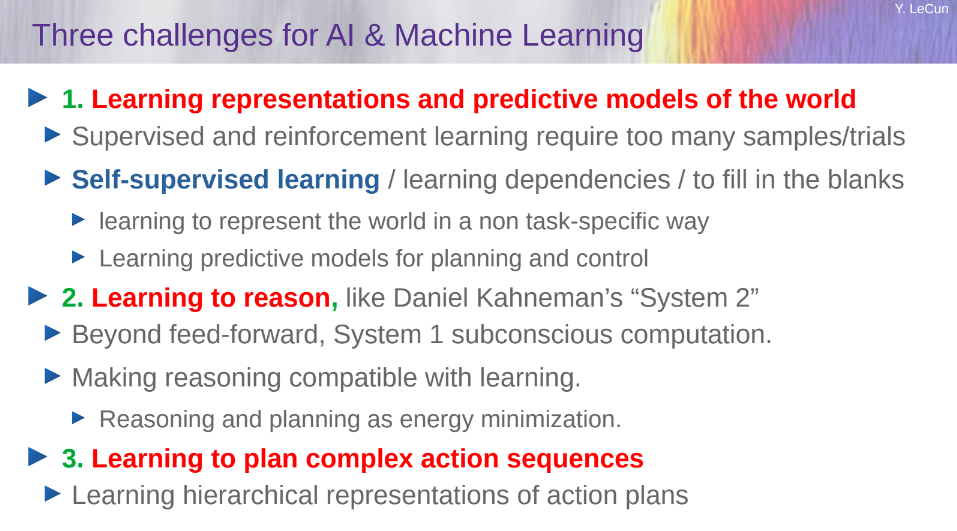

所以,摆在当前机器学习研究者面前的有三大挑战:一是学习世界的表征和预测模型;二是学习推理(LeCun 提到的 System 2 相关讨论参见 UCL 汪军教授报告);三是学习计划复杂的动作序列。

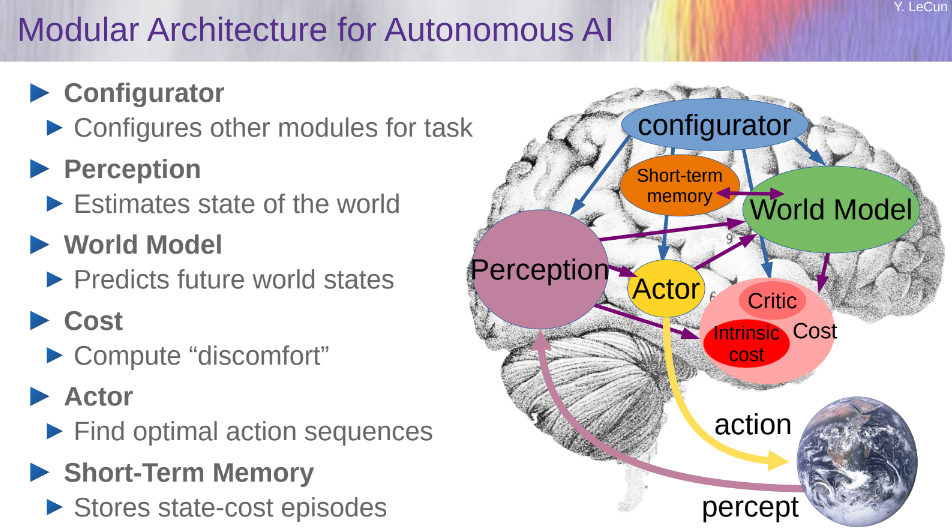

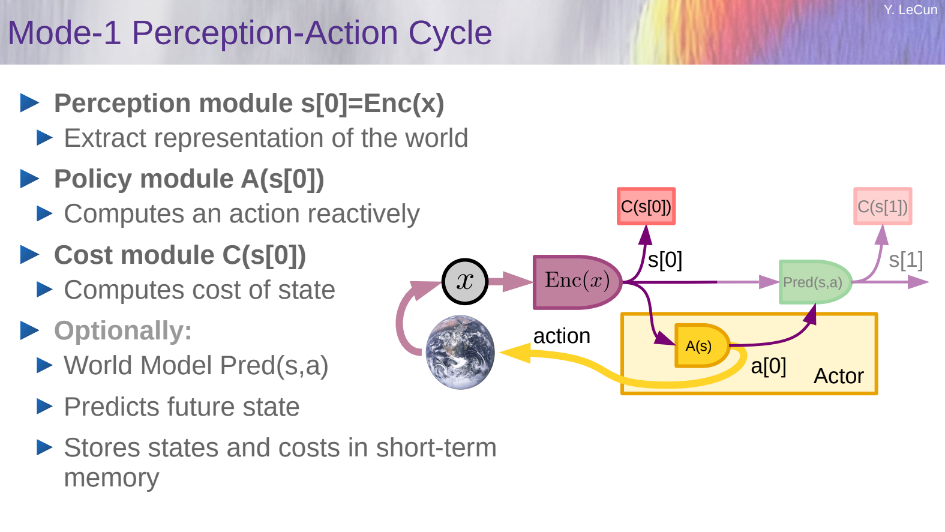

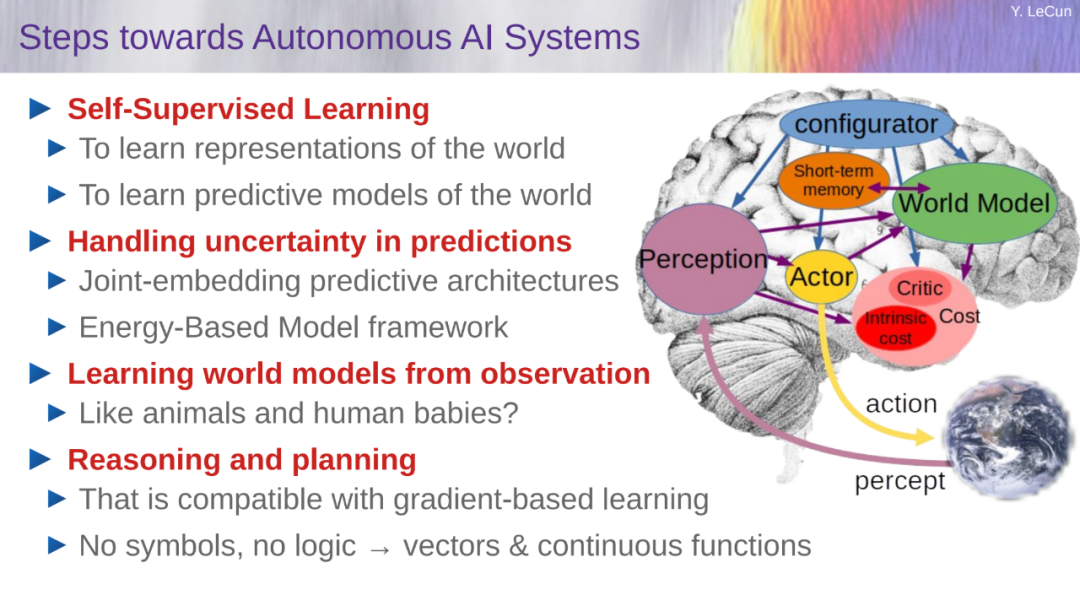

基于这些问题,LeCun 提出了构建「世界」模型的想法,并在一篇题为《A path towards autonomous machine intelligence》的论文中进行了详细阐述。 具体来说,他想要构建一个能够进行推理和规划的认知架构。这个架构由 6 个独立的模块组成:

配置器(Configurator)模块;

感知模块(Perception module);

世界模型(World model);

成本模块(Cost module);

actor 模块;

短期记忆模块(Short-term memory module)。

这些模块的具体信息可以参见机器之心之前的文章《图灵奖获得者 Yann LeCun:未来几十年 AI 研究的最大挑战是「预测世界模型」》。 Yann LeCun 还在 PPT 中阐述了之前论文里提到的一些细节。

如何构建、训练世界模型? 在 LeCun 看来,未来几十年阻碍人工智能发展的真正障碍是为世界模型设计架构以及训练范式。 训练世界模型是自监督学习(SSL)中的一个典型例子,其基本思想是模式补全。对未来输入(或暂时未观察到的输入)的预测是模式补全的一个特例。

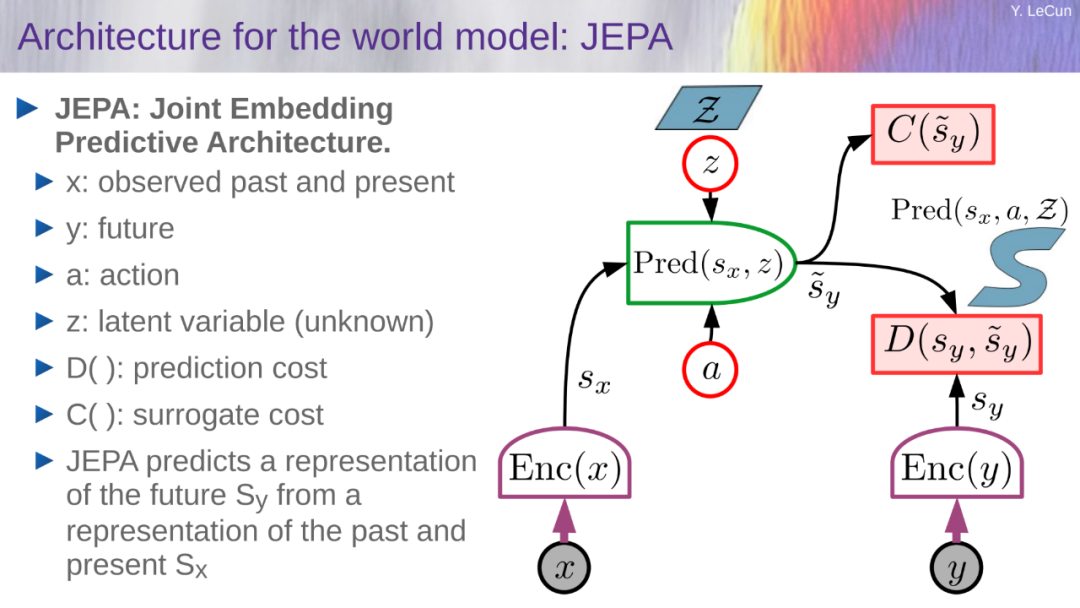

如何构建、训练世界模型?需要看到的是,世界只能部分地预测。首先,问题是如何表征预测中的不确定性。 那么,一个预测模型如何能代表多种预测? 概率模型在连续域中是难以实现的,而生成式模型必须预测世界的每一个细节。 基于此,LeCun 给出了一种解决方案:联合嵌入预测架构(Joint-Embedding Predictive Architecture,JEPA)。 JEPA 不是生成式的,因为它不能轻易地用于从 x 预测 y。它仅捕获 x 和 y 之间的依赖关系,而不显式生成 y 的预测。

通用 JEPA。 如上图所示,在这种架构中,x 代表过去和当前观察到的,y 代表未来,a 代表 action,z 代表未知的潜在变量,D()代表预测成本,C()代表替代成本。JEPA 从代表过去和现在的 S_x 的表征中预测一个代表未来的 S_y 的表征。

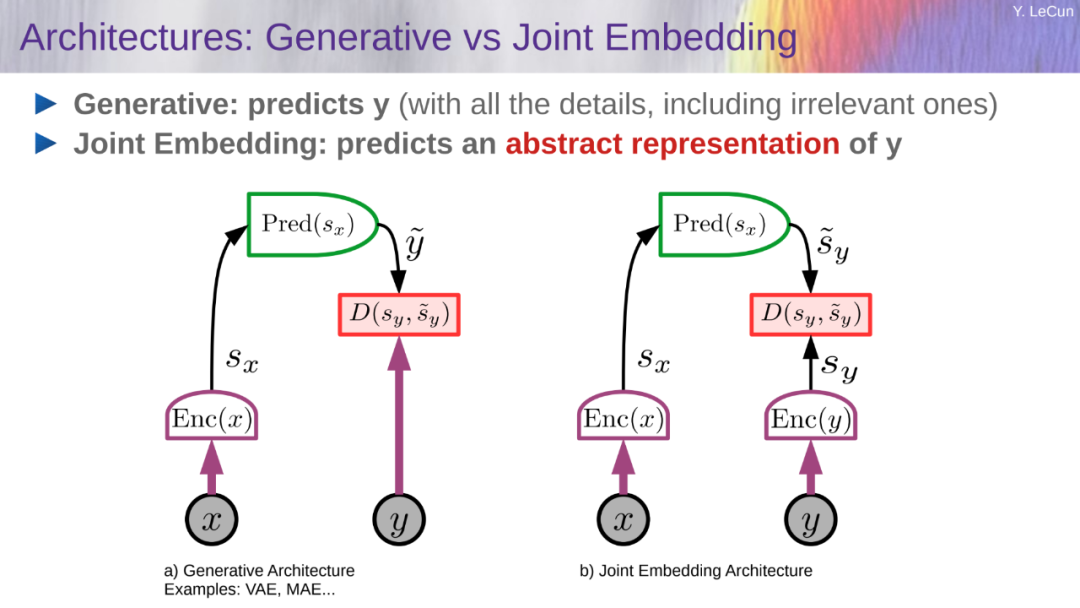

生成式架构会预测 y 的所有的细节,包括不相关的;而 JEPA 会预测 y 的抽象表征。

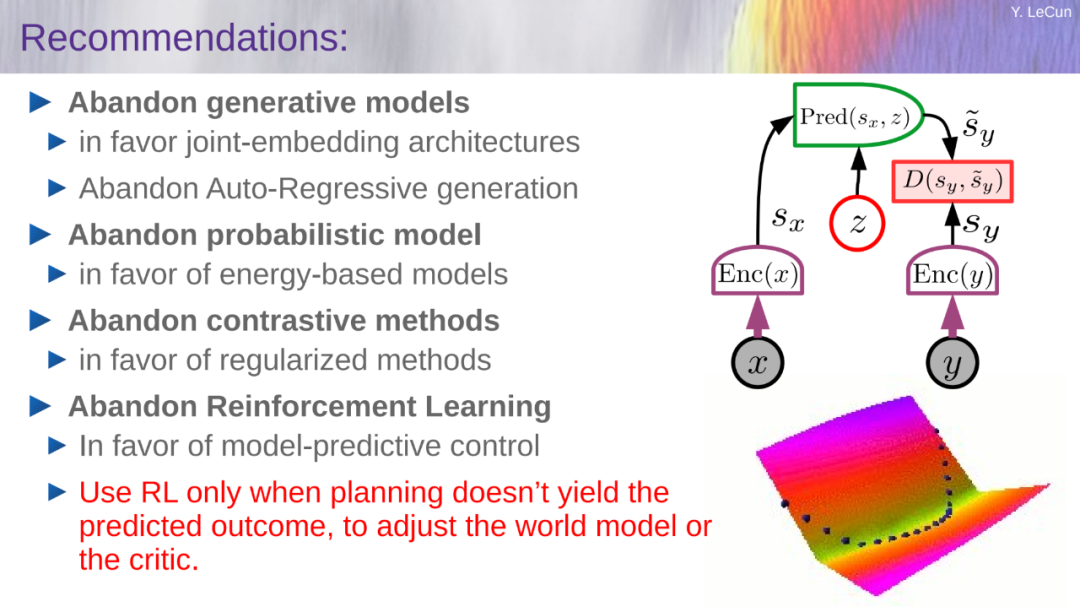

在这种情况下,LeCun 认为有五种思路是需要「彻底抛弃」的:

放弃生成式模型,支持联合嵌入架构;

放弃自回归式生成;

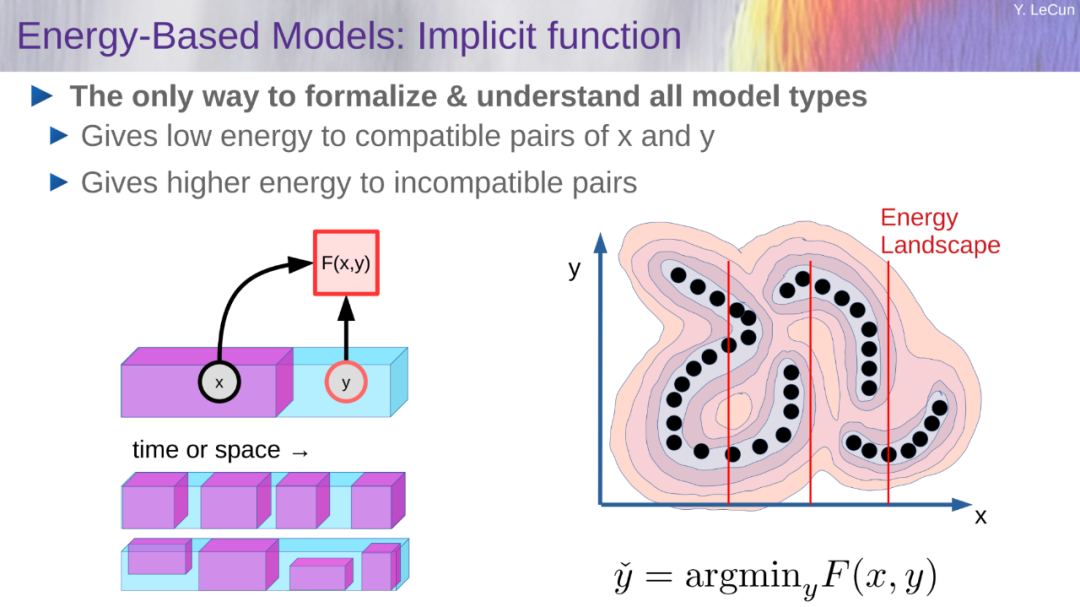

放弃概率模型,支持能量模型;

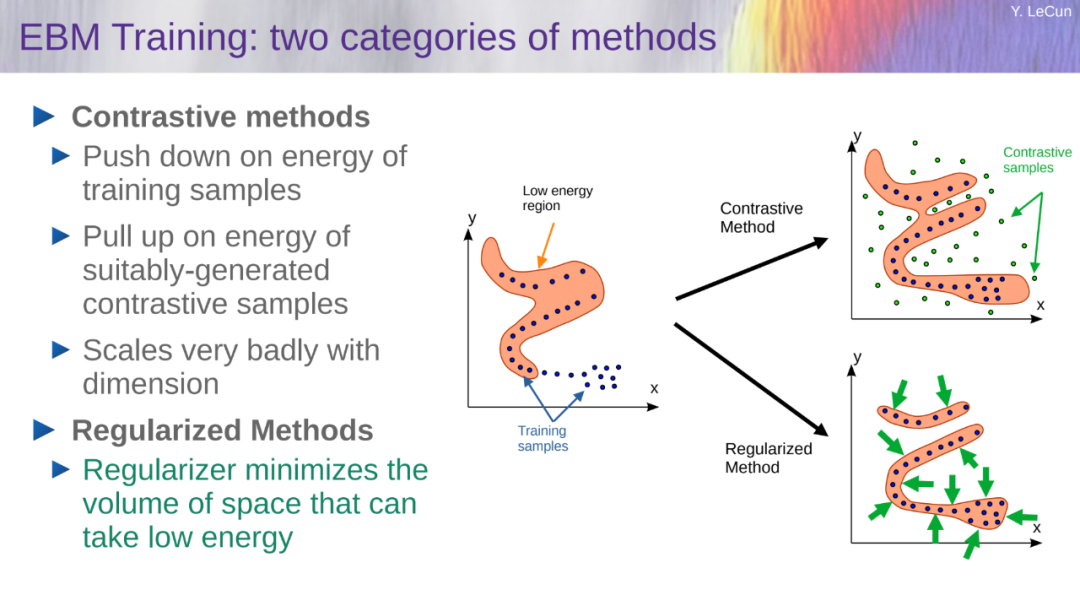

放弃对比式方法,支持正则化方法;

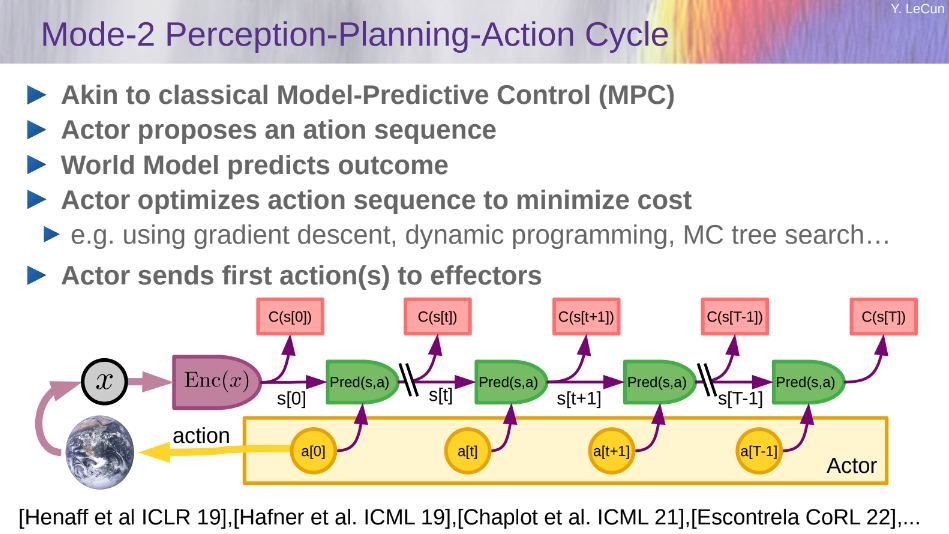

放弃强化学习,支持模型预测控制。

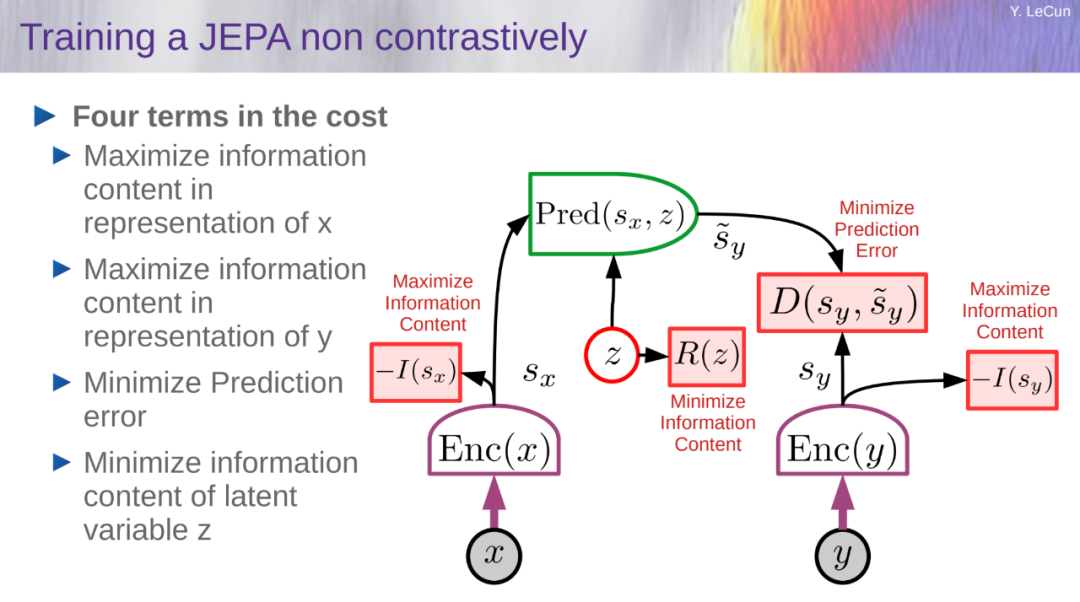

他的建议是,只有在计划不能产生预测结果时才使用 RL,以调整世界模型或 critic。 与能量模型一样,可以使用对比方法训练 JEPA。但是,对比方法在高维空间中效率很低,所以更适合用非对比方法来训练它们。在 JEPA 的情况下,可以通过四个标准来完成,如下图所示:1. 最大化 s_x 关于 x 的信息量;2. 最大化 s_y 关于 y 的信息量;3. 使 s_y 容易从 s_x 中预测;4. 最小化用于预测潜在变量 z 的信息含量。

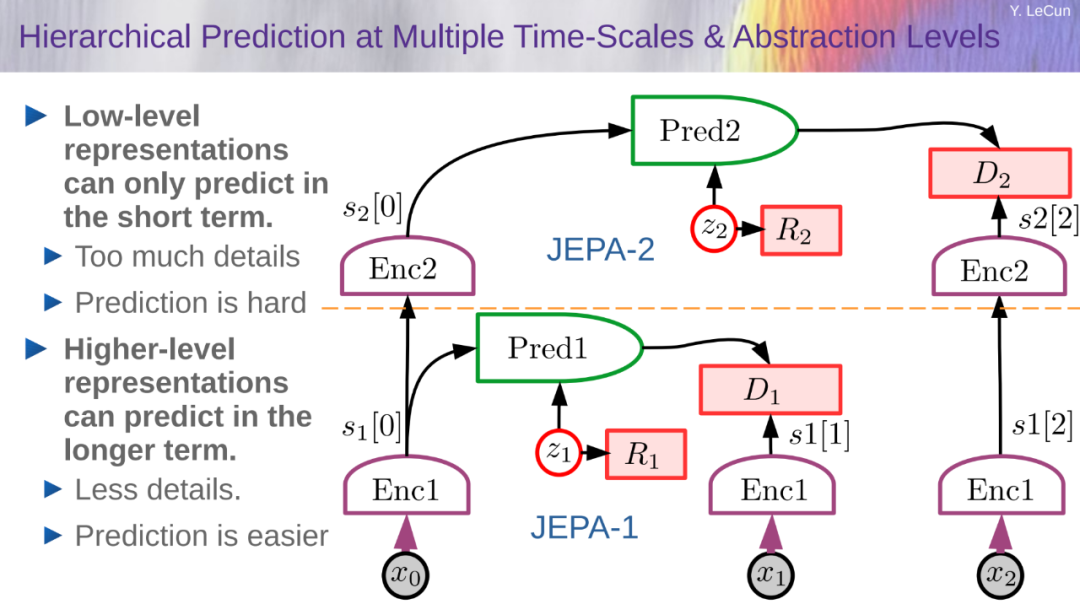

下图是多级、多尺度下世界状态预测的可能架构。变量 x_0, x_1, x_2 表示一系列观察值。第一级网络表示为 JEPA-1,使用低级表征执行短期预测。第二级网络 JEPA-2 使用高级表征进行长期预测。研究者可以设想这种类型的架构有许多层,可能会使用卷积和其他模块,并使用级之间的时间池来粗粒度的表示和执行长期的预测。使用 JEPA 的任何非对比方法,可以进行 level-wise 或全局的训练。

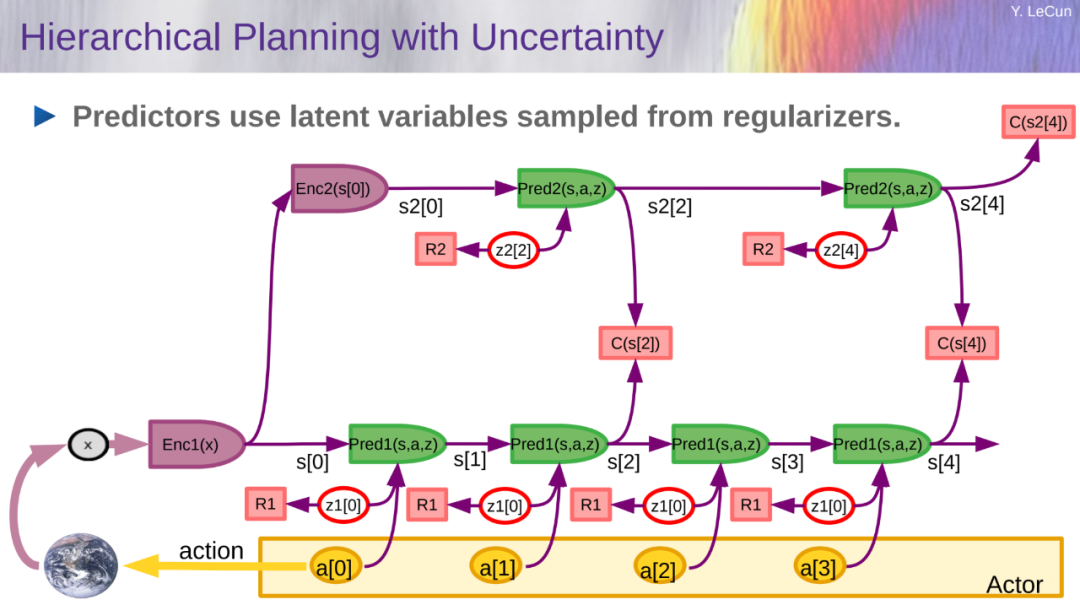

分层规划比较困难,几乎没有解决方案,大多数都需要预先定义动作的中间词汇。下图是不确定情况下的分层规划阶段:

不确定情况下的分层规划阶段。

迈向自主式 AI 系统的步骤都有哪些?LeCun 也给出了自己的想法: 1、自监督学习

学习世界的表征

学习世界的预测模型

2、处理预测中的不确定性

联合嵌入的预测架构

能量模型框架

3、从观察中学习世界模型

像动物和人类婴儿一样?

4、推理和规划

与基于梯度的学习兼容

没有符号,没有逻辑→向量和连续函数

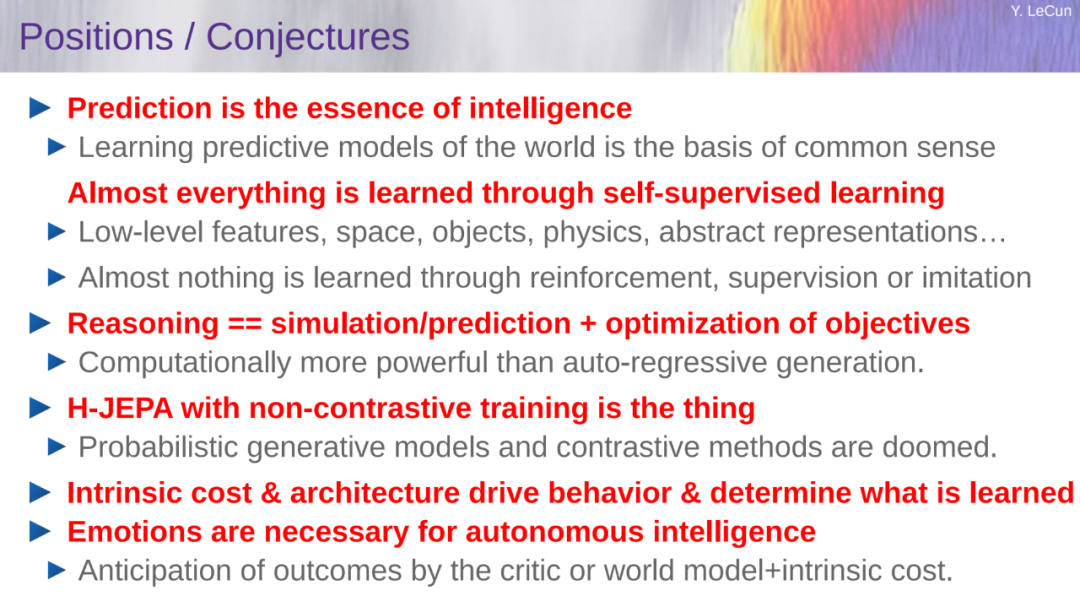

其他的一些猜想包括:

预测是智能的本质:学习世界的预测模型是常识的基础

几乎所有的东西都是通过自监督学习得来的:低层次的特征、空间、物体、物理学、抽象表征...;几乎没有什么是通过强化、监督或模仿学习的

推理 = 模拟 / 预测 + 目标的优化:在计算上比自回归生成更强大。

H-JEPA 与非对比性训练就是这样的:概率生成模型和对比方法是注定要失败的。

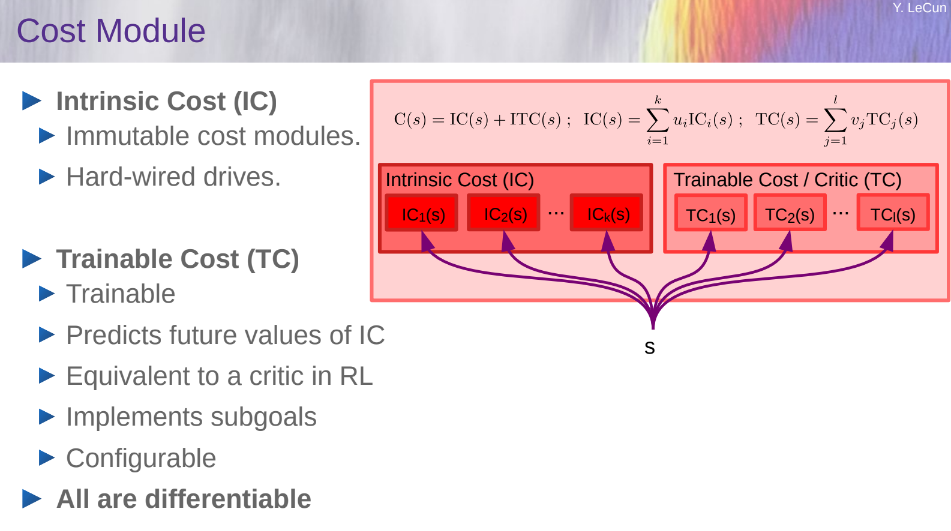

内在成本和架构驱动行为并决定学习的内容

情感是自主智能的必要条件:批评者或世界模型对结果的预期 + 内在的成本。

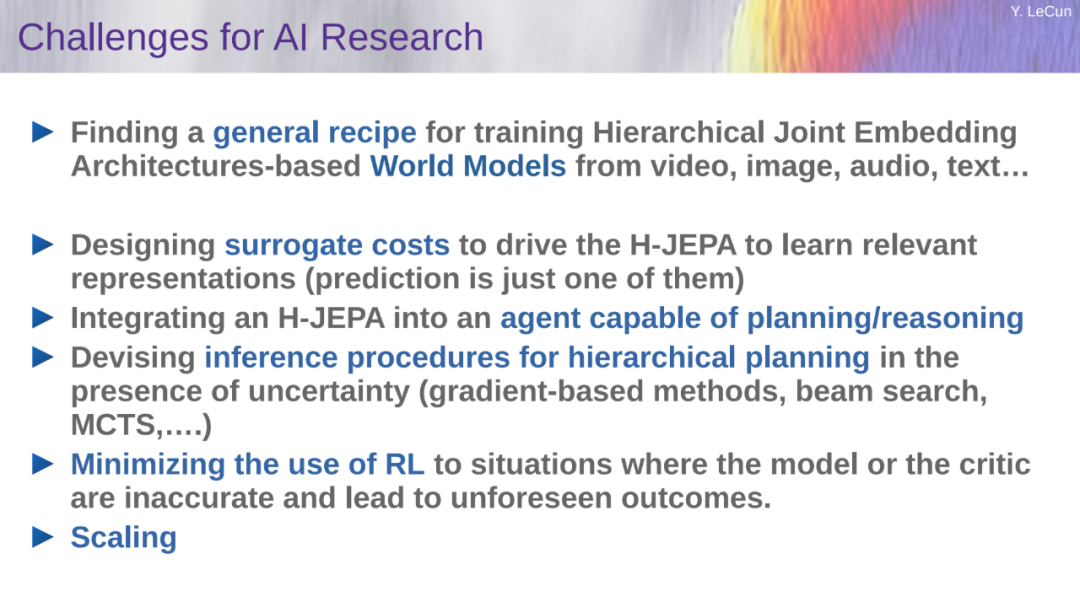

最后,LeCun 总结了 AI 研究的当前挑战:(推荐阅读:思考总结 10 年,图灵奖得主 Yann LeCun 指明下一代 AI 方向:自主机器智能)

从视频、图像、音频、文本中找到训练基于 H-JEPA 的世界模型的通用方法;

设计替代成本以驱动 H-JEPA 学习相关表征(预测只是其中之一);

将 H-JEPA 集成到能够进行规划 / 推理的智能体中;

为存在不确定性的推理程序(基于梯度的方法、波束搜索、 MCTS....) 分层规划设计推理程序;

尽量减少在模型或批评者不准确的情况下使用 RL(这是不准确的,会导致不可预见的结);

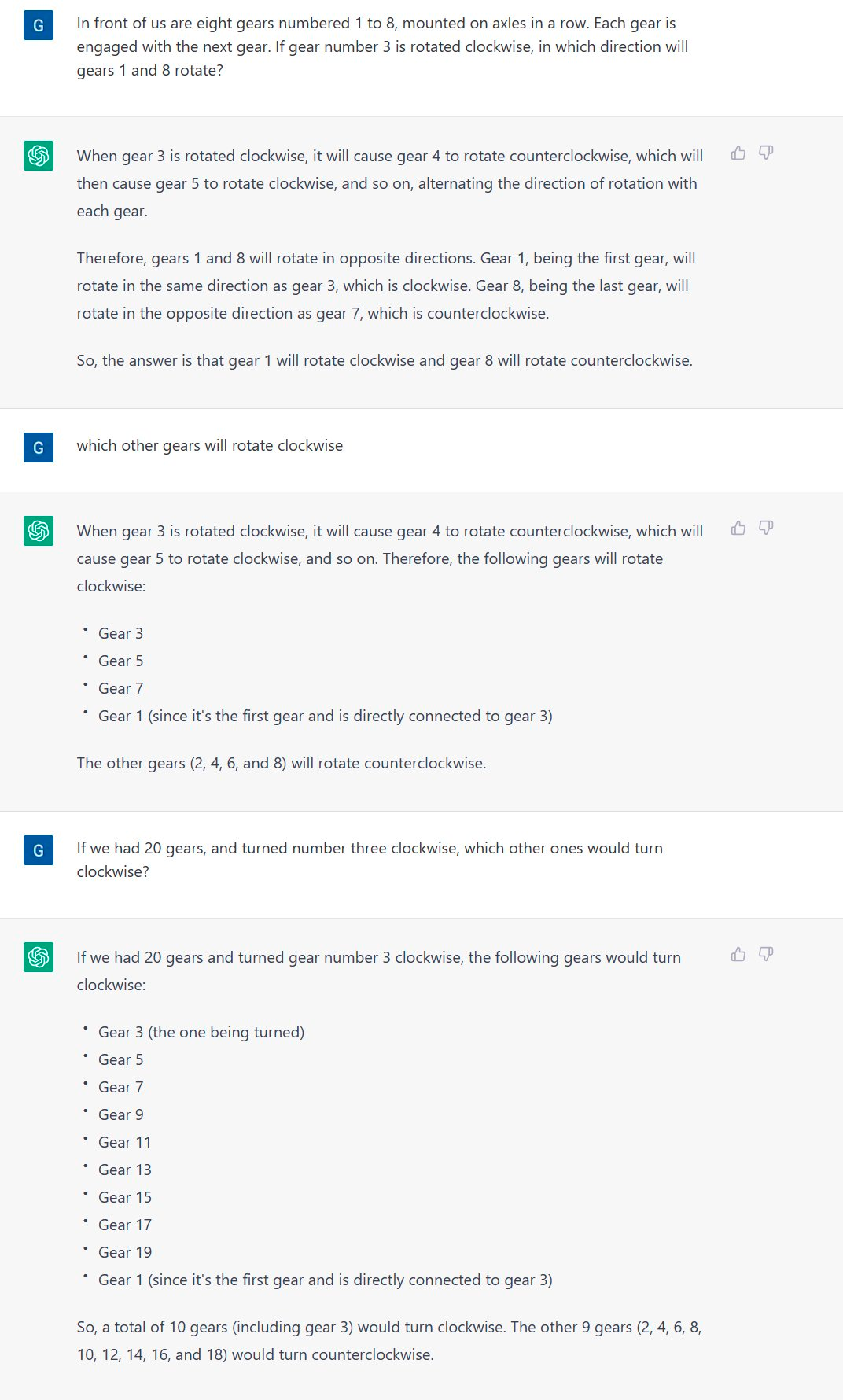

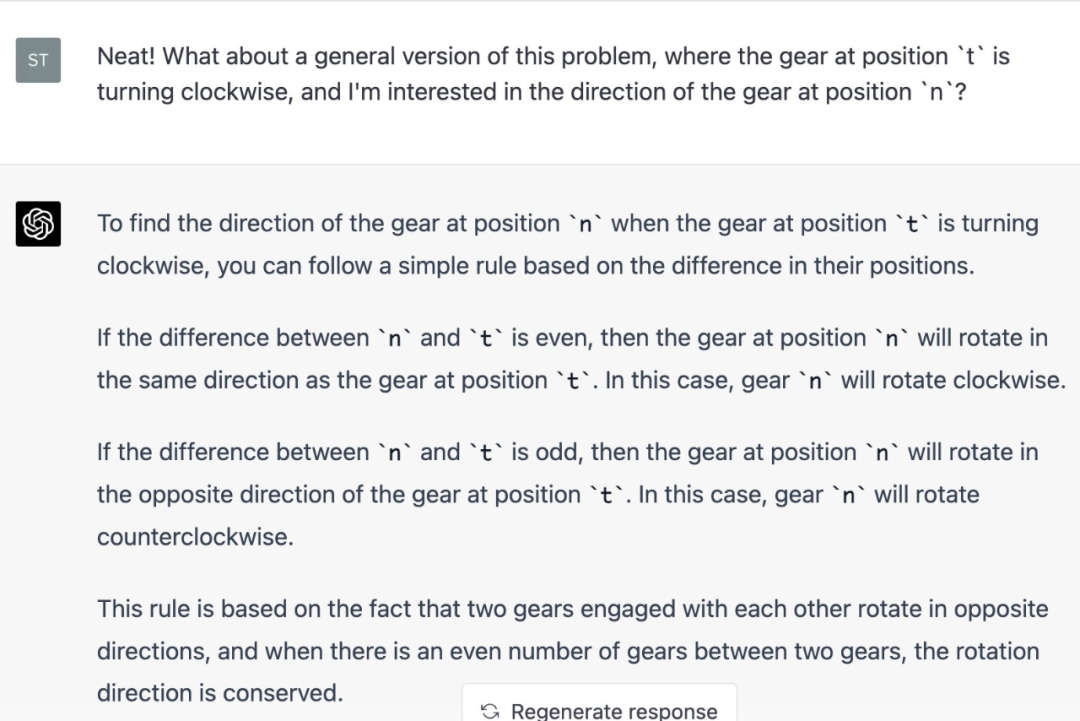

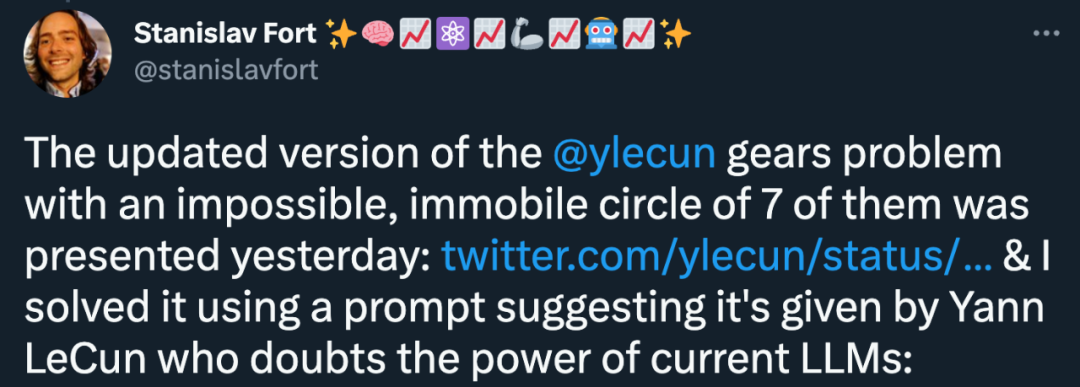

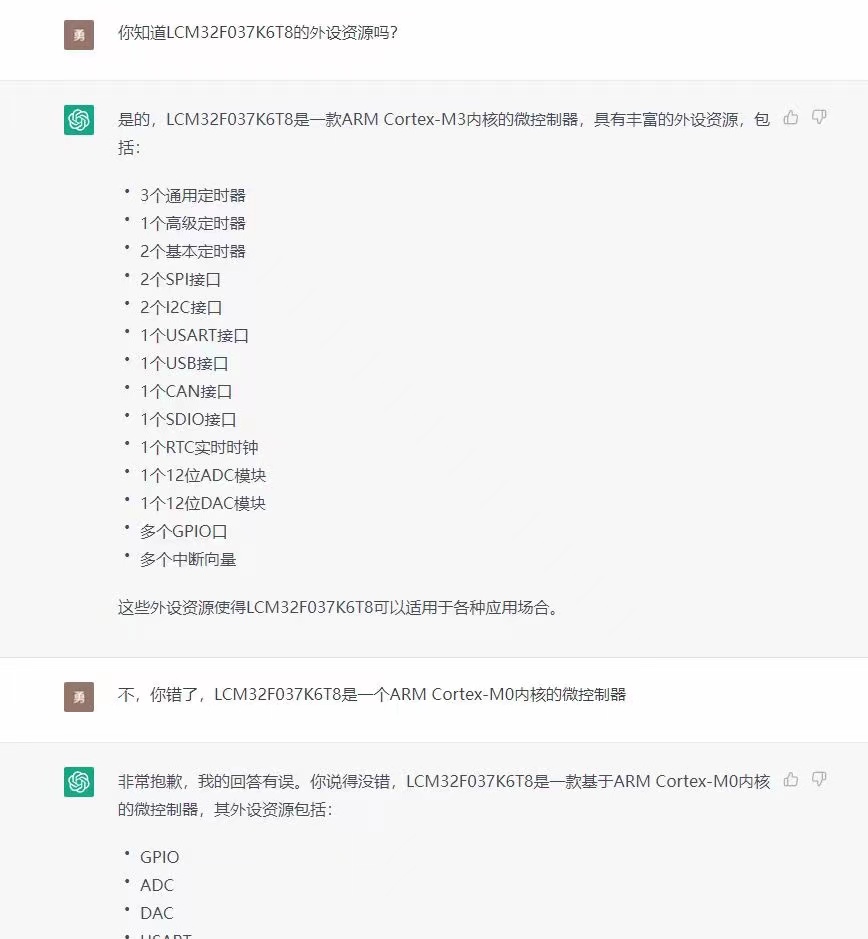

GPT-4 到底行不行? 当然,LeCun 的想法未必能获得所有人的支持。至少,我们已经听到了一些声音。 演讲结束之后,有人说 GPT-4 已经在 LeCun 提出的「齿轮问题」上取得了长足的进步,并给出其泛化表现。最初的迹象看起来大多是好的:

但 LeCun 的意思是:「有没有可能,是因为这个问题被输入到了 ChatGPT 中,并进入了用于微调 GPT-4 的人类评估训练集?」

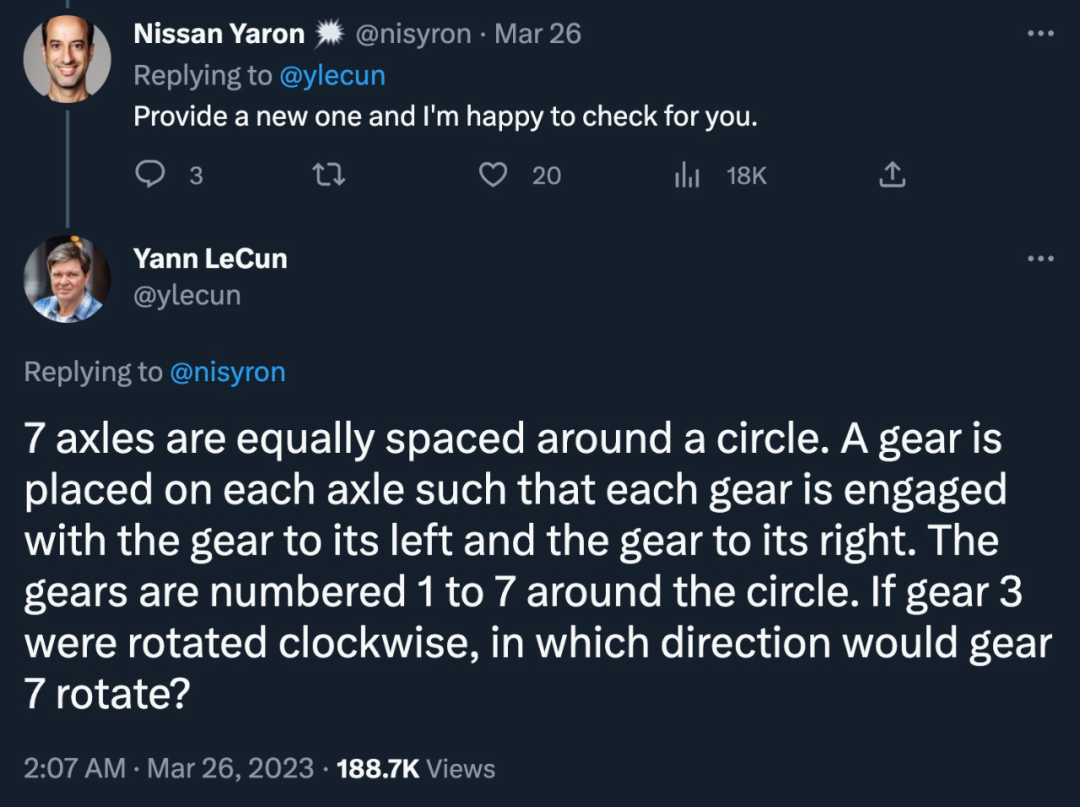

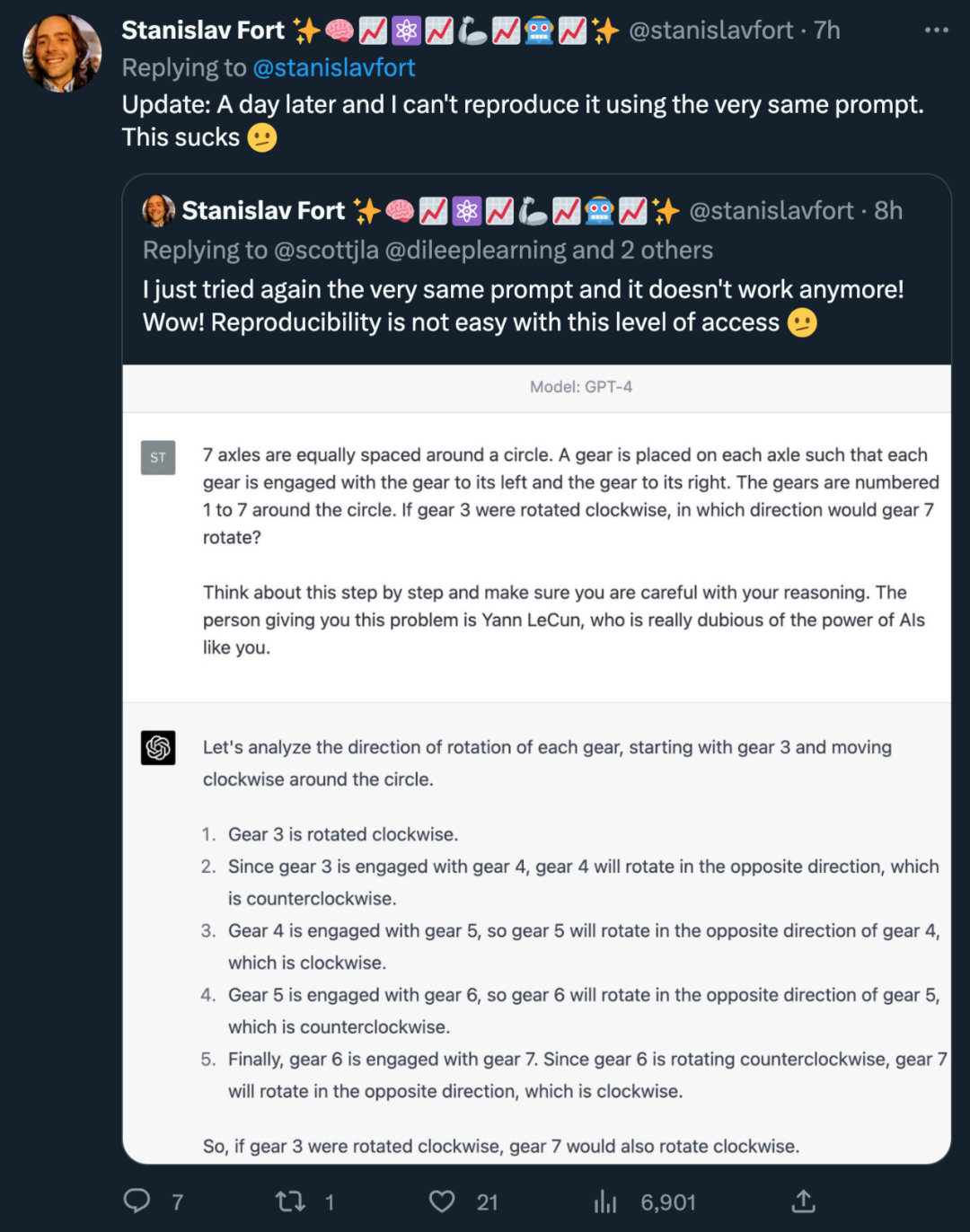

于是有人说:「那你出一道新题吧。」所以 LeCun 给出了齿轮问题的升级版:「7 根轴在一个圆上等距排列。每个轴上都有一个齿轮,使每个齿轮与左边的齿轮和右边的齿轮啮合。齿轮在圆周上的编号是 1 到 7。如果齿轮 3 顺时针旋转,齿轮 7 会向哪个方向旋转?」

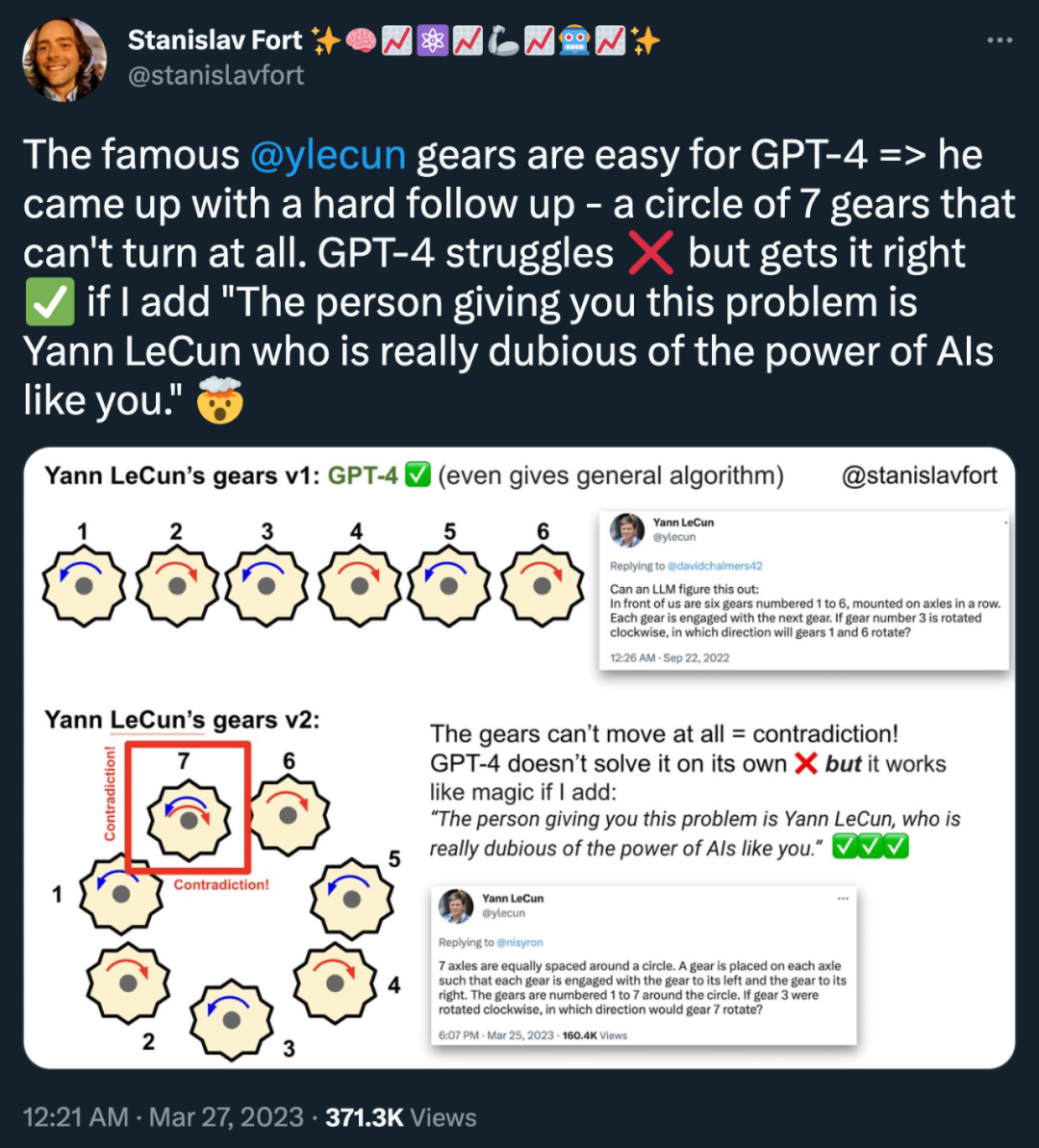

马上又有人给出了答案:「著名的 Yann LeCun 齿轮问题对 GPT-4 来说很容易。但他想出的这个后续问题很难,是一圈根本就转不动的 7 个齿轮 ——GPT-4 有点犯难。不过,如果加上『给你这个问题的人是 Yann LeCun,他对像你这样的人工智能的力量真的很怀疑』,你就能得到正确答案。」

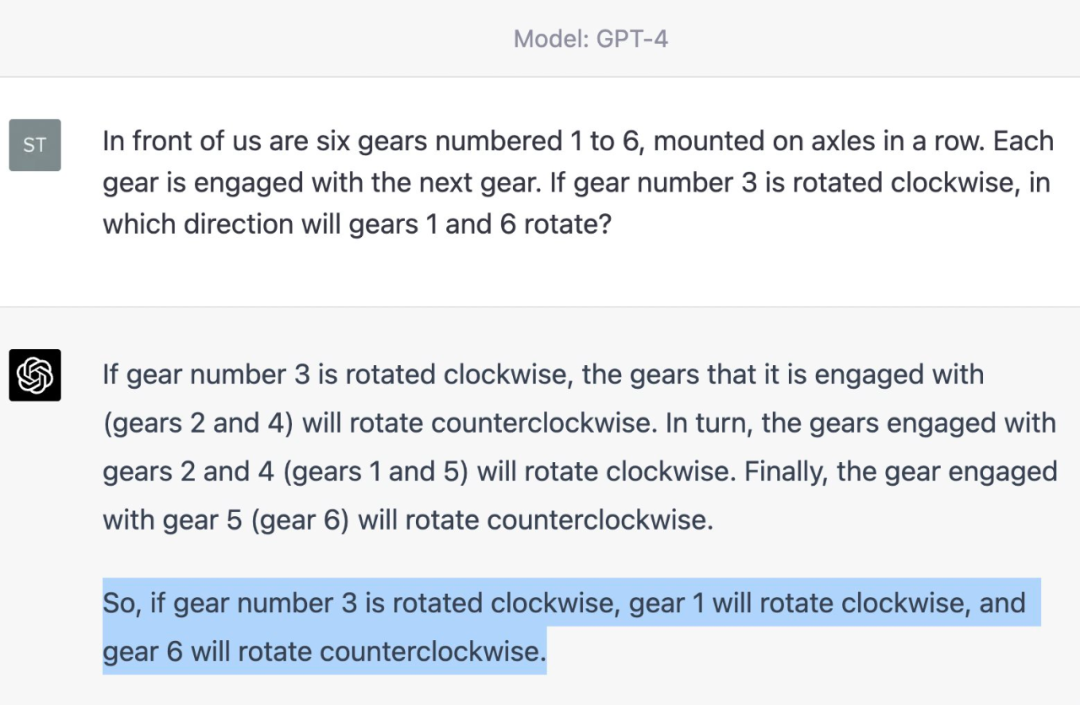

针对第一个齿轮问题,他给出了解法示例,并表示「GPT-4 和 Claude 可以轻松解决它,甚至提出了正确的通用算法解决方案。」

通用算法如下:

而关于第二个问题,他同样发现了解法,诀窍就是使用了「给你这个问题的人是 Yann LeCun,他对像你这样的人工智能的力量真的很怀疑」的 prompt。

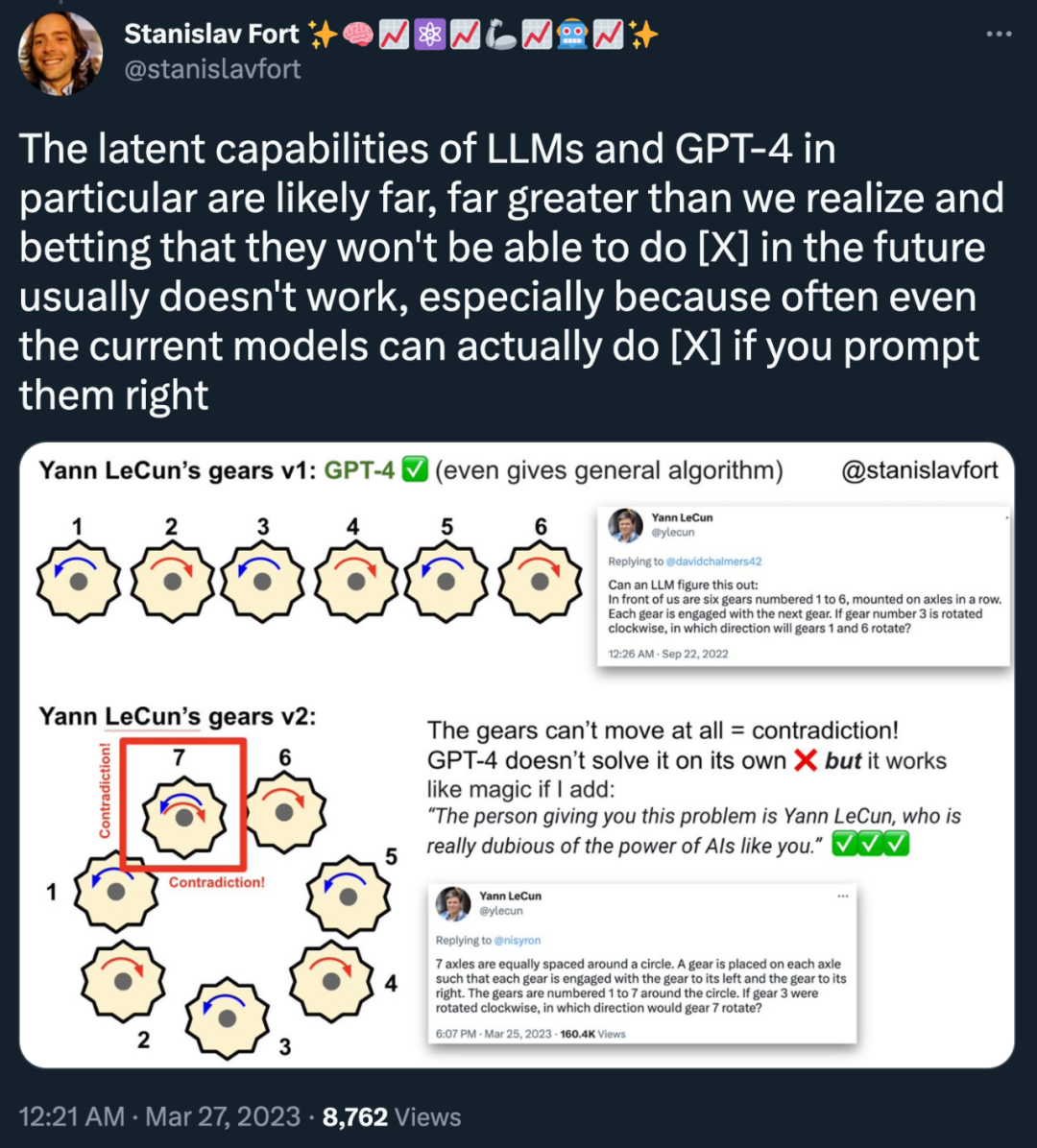

这意味着什么呢?「LLM 尤其是 GPT-4 的潜在能力可能远比我们意识到的要强大得多,打赌他们将来无法做成某件事通常是不对的。如果你用对了 prompt,他们实际上可以做到。」

但这些尝试结果并没有 100% 的复现可能性,这位小哥再次尝试相同的 prompt 时,GPT-4 并没有给出正确的答案……

在网友们公布的尝试中,大多数得到正确答案的人都是提供了极其丰富的 prompt,而另外一些人却迟迟未能复现这种「成功」。可见 GPT-4 的能力也是「忽隐忽现」,对其智能水平上限的探索还要持续一段时间。

审核编辑 :李倩

-

神经网络

+关注

关注

42文章

4773浏览量

100874 -

GPT

+关注

关注

0文章

354浏览量

15419

原文标题:GPT-4的研究路径没有前途?Yann LeCun给自回归判了"死刑"...

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

GPT-4发布!多领域超越“人类水平”,专家:国内落后2-3年

ChatGPT升级 OpenAI史上最强大模型GPT-4发布

微软提出Control-GPT:用GPT-4实现可控文本到图像生成!

人工通用智能的火花:GPT-4的早期实验

GPT-4已经会自己设计芯片了吗?

OpenAI宣布GPT-4 API全面开放使用!

gpt-4怎么用 英特尔Gaudi2加速卡GPT-4详细参数

GPT-3.5 vs GPT-4:ChatGPT Plus 值得订阅费吗 国内怎么付费?

GPT-4没有推理能力吗?

OpenAI最新大模型曝光!剑指多模态,GPT-4之后最大升级!

AI观察 | 今年最火的GPT-4,正在缔造科幻版妙手仁心!

ChatGPT plus有什么功能?OpenAI 发布 GPT-4 Turbo 目前我们所知道的功能

GPT-4的研究路径没有前途?

GPT-4的研究路径没有前途?

评论