人工智能计算是机器学习系统和软件所做的工作,它可以对海量的数据进行筛选,从中获得有洞察的信息并生成新的能力。

算盘、六分仪、算尺和计算机等数学工具见证了人类的进步史。这些数学工具帮助人们往来贸易、征服大海,并提高了人们的认知与生活质量。 如今,人工智能(AI)计算成为了最新的数学工具,正推动着科学和工业的发展。

AI 计算的定义

AI 计算是一种计算机器学习算法的数学密集型流程,通常会使用加速系统和软件,它可以从大量数据集中提取新的见解并在此过程中学习新能力。 我们如今生活在一个数据时代,因此,AI 计算是这个时代的革命性技术,它能够找到人类无法找到的规律。 例如,美国运通使用 AI 计算来检测每年数十亿次信用卡交易中的欺诈行为;医生使用 AI 计算来寻找肿瘤,并在无数医疗影像中发现细微的异常情况。AI 计算的三个步骤

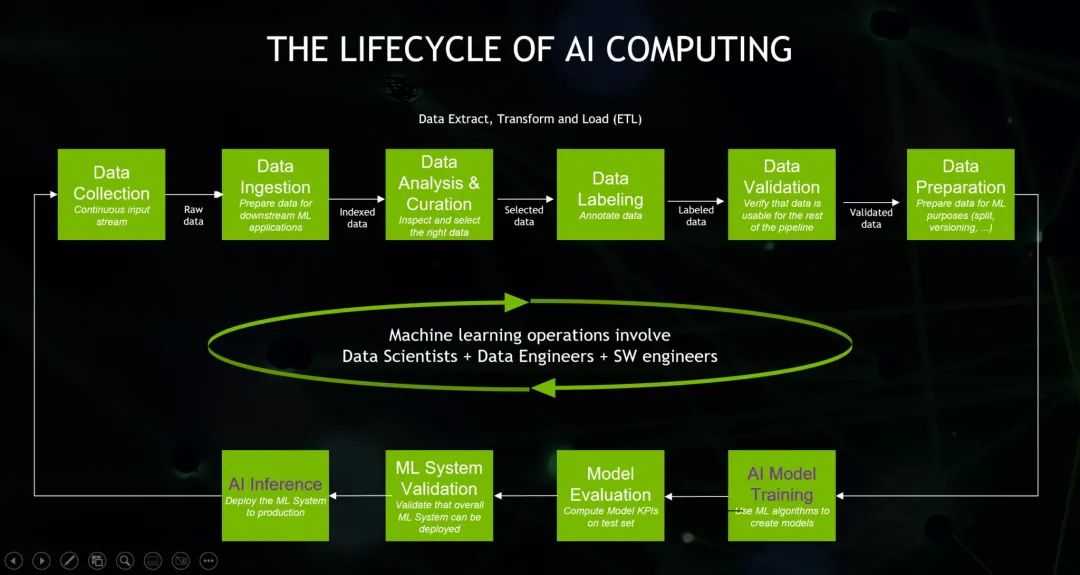

在介绍众多 AI 计算用例前,我们先来了解一下它是如何运作的。 首先,用户(通常是数据科学家)需要整理和准备数据集,这个阶段称为提取/转换/加载(ETL)。这项工作现在可以通过 Apache Spark 3.0 在 NVIDIA GPU 上加速进行。Apache Spark 是目前最流行的开源大数据挖掘引擎之一。 然后,数据科学家会选择或设计最适合其应用的 AI 模型。 一些在开拓新领域或寻求竞争优势的公司会从头开始设计并训练自己的模型。这个过程除了需要一定的专业知识外,还可能需要一台 AI 超级计算机和 NVIDIA 的帮助。 机器学习运维(MLOps)更加详细地描述了 AI 计算的三个主要步骤——ETL(最上面的一行)、训练(右下)和推理(左下)。

许多公司选择采用预训练 AI 模型并根据其应用需求进行自定义。在提供软件、服务和支持的门户网站 NVIDIA NGC 上,有几十种预训练模型和定制工具可供使用。

最后,公司会通过他们的模型来筛选数据。这个关键步骤被称为推理,AI 将会在这个步骤中提供可行的洞察与见解。

这三个步骤需要消耗很多精力,但好在每个人在各种帮助下都能够使用 AI 计算。

例如,NVIDIA TAO 工具套件可以使用迁移学习将三个步骤简化为一个,这种方法不需要大型数据集就能为新的应用定制现有的 AI 模型。除此之外,NVIDIA LaunchPad 还为用户提供了各种模型部署用例的实践培训。

机器学习运维(MLOps)更加详细地描述了 AI 计算的三个主要步骤——ETL(最上面的一行)、训练(右下)和推理(左下)。

许多公司选择采用预训练 AI 模型并根据其应用需求进行自定义。在提供软件、服务和支持的门户网站 NVIDIA NGC 上,有几十种预训练模型和定制工具可供使用。

最后,公司会通过他们的模型来筛选数据。这个关键步骤被称为推理,AI 将会在这个步骤中提供可行的洞察与见解。

这三个步骤需要消耗很多精力,但好在每个人在各种帮助下都能够使用 AI 计算。

例如,NVIDIA TAO 工具套件可以使用迁移学习将三个步骤简化为一个,这种方法不需要大型数据集就能为新的应用定制现有的 AI 模型。除此之外,NVIDIA LaunchPad 还为用户提供了各种模型部署用例的实践培训。

AI 模型的内部构造

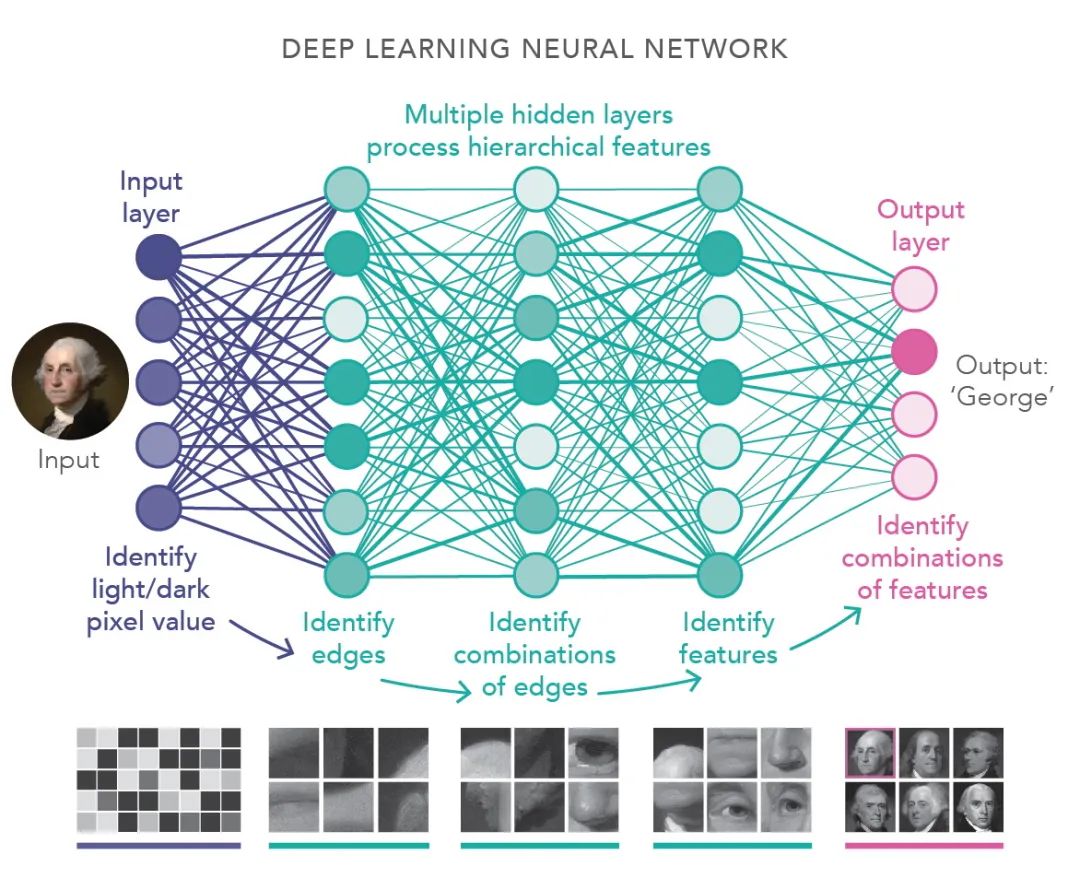

AI 模型被称为神经网络,其灵感来自于人类大脑内部的网状构造。 这些 AI 模型展开后看起来就像是由多层线性代数方程组成的数学“千层面”。深度学习作为目前最流行的一种 AI 形式,得名就是因为它由许多这样的‘层’组成。 识别图像的深度学习模型示例(选自美国国家科学院的一篇关于深度学习的文章,图片来源:艺术家 Lucy Reading-Ikkanda)

进一步聚焦,你就会看到每一层都由众多方程式堆栈组成,每个方程式都代表着一组数据相互关联的可能性。

AI 计算将每一层中的每一个方程堆栈相联系,以寻找规律。这是一项庞大的工程,需要高度并行的处理器在高速计算机网络上共享大量数据。

识别图像的深度学习模型示例(选自美国国家科学院的一篇关于深度学习的文章,图片来源:艺术家 Lucy Reading-Ikkanda)

进一步聚焦,你就会看到每一层都由众多方程式堆栈组成,每个方程式都代表着一组数据相互关联的可能性。

AI 计算将每一层中的每一个方程堆栈相联系,以寻找规律。这是一项庞大的工程,需要高度并行的处理器在高速计算机网络上共享大量数据。

GPU 计算与 AI 的结合

事实上,AI 计算的引擎是 GPU。 NVIDIA 于 1999 年推出了第一款 GPU,用于需要大规模并行计算的电子游戏 3D 图像渲染。 GPU 计算很快被推广到电影大片的图形服务器中。科学家和研究者在世界上最大的超级计算机上使用 GPU,其可应用的研究范围小到化学中的微小分子,大到天体物理学中的遥远星系。 当 AI 计算在十多年前出现时,研究者很快就开始使用 NVIDIA 的可编程平台运行并行处理。下面的视频简单回顾了 GPU 的历史。AI 计算的历史

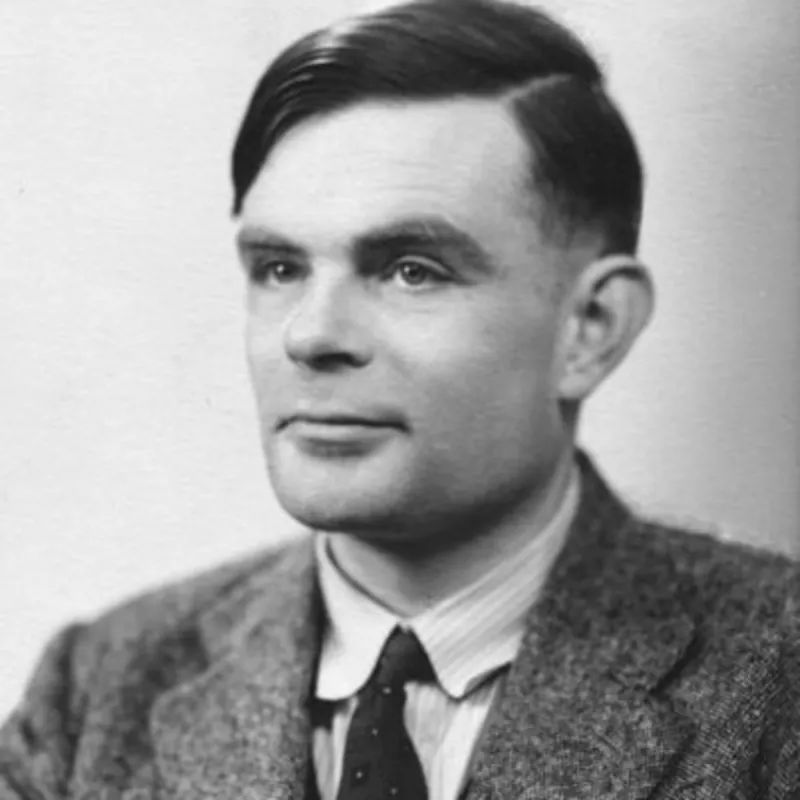

AI 这个概念至少可以追溯到艾伦·图灵所在的时代,这位英国数学家在二战期间帮助破解了密码信息。 艾伦·图灵

1947 年,图灵在一次演讲中说:“我们想要的是一台能够从经验中学习的机器。”

NVIDIA 为了纪念他的远见卓识,以他的名字命名了 NVIDIA 的一个计算架构。

图灵的展望在 2012 年成为了现实。研究者在 2012 年开发出了能够比人类更快、更精准识别图像的 AI 模型。ImageNet 比赛的结果也大大加快了计算机视觉的发展。

今天,以机器学习界大咖 Andrew Ng 创立的 Landing AI 为代表,许多公司正在使用 AI 和计算机视觉提高制造业的效率,与此同时,AI 也在为体育、智慧城市等领域带来更接近真人的视角与思维方式。

艾伦·图灵

1947 年,图灵在一次演讲中说:“我们想要的是一台能够从经验中学习的机器。”

NVIDIA 为了纪念他的远见卓识,以他的名字命名了 NVIDIA 的一个计算架构。

图灵的展望在 2012 年成为了现实。研究者在 2012 年开发出了能够比人类更快、更精准识别图像的 AI 模型。ImageNet 比赛的结果也大大加快了计算机视觉的发展。

今天,以机器学习界大咖 Andrew Ng 创立的 Landing AI 为代表,许多公司正在使用 AI 和计算机视觉提高制造业的效率,与此同时,AI 也在为体育、智慧城市等领域带来更接近真人的视角与思维方式。

AI 计算开启对话式 AI

2017 年 Transformer 模型面世后,AI 计算在自然语言处理方面获得了巨大的进步,出现了一种名为“attention”的机器学习技术。它可以捕捉如文本、语音等连续数据中的上下文。 如今,对话式 AI 已十分普遍。它可以解析用户在搜索框中输入的句子,也可以在用户开车时读出短信并让你口述回复。 这些大型语言模型还被应用于药物研发、翻译、聊天机器人、软件开发、呼叫中心自动化等众多领域。AI+图形:创造 3D 世界

许多意想不到的领域的用户正在体验 AI 计算的力量。 最新的电子游戏凭借着实时光线追踪与 NVIDIA DLSS 将画面真实性提高到了更高级别。后者利用 AI 在 GeForce RTX 平台上为用户提供了超流畅的游戏体验。 这仅仅是个开始。新兴的神经图形学将加速虚拟世界的创建,以填充 3D 互联网与元宇宙。 神经图形学将加速虚拟世界的设计和开发,填充 3D 互联网与元宇宙

神经图形学将加速虚拟世界的设计和开发,填充 3D 互联网与元宇宙

AI 计算用例

汽车、工厂和仓库 汽车制造商正在运用 AI 计算以提供更加平稳、安全的驾驶体验,并为乘客提供智能化车载信息娱乐功能。 梅赛德斯-奔驰正在与 NVIDIA 联手开发软件定义汽车。该公司即将推出的车型将提供由 NVIDIA DRIVE Orin 中央计算机驱动的智能和自动驾驶功能。这些系统将在数据中心使用建立在 NVIDIA Omniverse 基础上的 DRIVE Sim 软件进行测试和验证,以确保它们能够安全应对各类场景。 梅赛德斯-奔驰在 CES 上宣布,它还将使用 Omniverse 设计并规划其全球各地的制造和装配设施。 许多公司通过在 NVIDIA Omniverse 中创建 AI 数字孪生工厂来提高工厂的效率,宝马集团也是其中之一。如下视频所示,百事可乐等消费业巨头也为其物流中心采用了这种方法。 工厂和仓库内的自主机器人进一步提高了制造业和物流业的效率。许多机器人由 NVIDIA Jetson 边缘 AI 平台驱动,并通过 NVIDIA Isaac Sim 在模拟和数字孪生中使用 AI 进行训练。 过去一年里,就连拖拉机和割草机都通过 AI 实现了自主运行。 位于加州利弗莫尔的初创企业 Monarch Tractor 在去年 12 月推出了一款 AI 驱动的电动车,促进了农业的自动化;位于科罗拉多州博尔德的 Scythe 于去年 5 月推出了一款装有八个摄像头和十多个传感器的自主电动割草机 M.52(如下视频所示)。 @2023 Scythe Robotics版权归Scythe Robotics 所有此视频由ScytheRobotics制作,如果您有任何疑问或需要使用此视频,请联系ScytheRobotics 保护网络安全,检测基因序列 AI 计算用例的数量和种类十分惊人。 网络安全软件在数字指纹等 AI 技术帮助下更快检测出网络钓鱼和其他网络威胁。 医疗领域的研究者们在 2022 年 1 月依靠 AI 计算在 8 小时内完成了整个基因组的测序,打破了纪录。其研究成果(如下视频所述)有可能治愈罕见遗传病。 AI 计算还被应用在银行、零售、邮局、电信、交通运输和能源网络等多个领域。 如今,AI 计算技术不断开拓新应用,研究者正在开发更新、更强大的方法。 过去一年中,另一种强大的神经网络——扩散模型开始流行。这种模型可以将文字描述转换成精美的图像。研究者预测这些模型的应用将进一步拓展 AI 计算的版图。

扫描海报二维码,或点击“阅读原文”,即可观看 NVIDIA 创始人兼首席执行官黄仁勋 GTC23 主题演讲重播!

原文标题:什么是 AI 计算?

文章出处:【微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

英伟达

+关注

关注

22文章

3791浏览量

91313

原文标题:什么是 AI 计算?

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

为AI计算释放空间

无论是移动应用程序或数字商务等可见应用程序,还是航空公司定价算法或每次刷卡时激活的欺诈检测系统等幕后流程,AI 都已成为我们日常生活中不可或缺的一部分。尤其是生成式 AI,预计未来十年将以两位数

华迅光通AI计算加速800G光模块部署

ChatGPT引爆的AI大模型市场,数据中心的东西流量和内部服务器流量比例增加。

更新数据中心拓扑结构

数据中心计算规模和东西向流量不断扩大,数据中心网络架构也在不断变化。在传统的三层拓扑结构中

发表于 11-13 10:16

美国老化电网已无法负荷AI计算

外媒《华盛顿邮报》刊发的美国麻省理工学院学者丹妮拉·鲁斯与前美国能源部分析学者尼科·恩里克斯联合署名文章,表达了对于美国老化电网已无法负荷AI计算的担心。 文章称因为AI的爆发使得人工智能系统耗电量

显存技术不断升级,AI计算中如何选择合适的显存

电子发烧友网报道(文/李弯弯)显存,是显卡上用于存储图像数据、纹理、帧缓冲区等的内存。它的大小直接决定了显卡能够同时处理的数据量。 在AI计算中,显存的大小对处理大规模数据集、深度学习模型的训练

从TPU v1到Trillium TPU,苹果等科技公司使用谷歌TPU进行AI计算

,在训练尖端人工智能方面,大型科技公司正在寻找英伟达以外的替代品。 不断迭代的谷歌TPU 芯片 随着机器学习算法,特别是深度学习算法在各个领域的广泛应用,对于高效、低功耗的AI计算硬件需求日益增长。传统的CPU和GPU在处理这些算法时存在效率较低的问

英伟达H200芯片量产在即,引领AI计算新时代

在科技日新月异的今天,每一次技术的飞跃都预示着行业格局的深刻变革。7月3日,台湾媒体《工商时报》传来重磅消息,英伟达(NVIDIA)的旗舰级AI计算产品——H200,已在二季度末正式迈入量产阶段

MWCS 2024 | 广和通荣获边缘AI计算最佳创新方案

2024世界移动通信大会·上海(MWCS 2024)期间,广和通端侧AI解决方案凭借卓越特性与极具潜力的商业价值斩获2024信息通信业“新质推荐”——边缘AI计算最佳创新方案,充分展现了广和通在

MWCS 2024 广和通荣获边缘AI计算最佳创新方案

2024世界移动通信大会·上海(MWCS 2024)期间,广和通端侧AI解决方案凭借卓越特性与极具潜力的商业价值斩获2024信息通信业“新质推荐”——边缘AI计算最佳创新方案,充分展现了广和通在

广和通端侧AI解决方案荣膺MWCS 2024边缘AI计算最佳创新奖

在近日举行的2024世界移动通信大会·上海(MWCS 2024)上,广和通凭借其卓越的端侧AI解决方案荣获2024信息通信业“新质推荐”——边缘AI计算最佳创新方案奖。这一荣誉不仅彰显了广和通在

日本Sakura互联网投资英伟达B200芯片 助力AI计算及数据中心发展

位于大阪的Sakura公司预计将在明年3月起使用这些新购置的AI芯片,并在其位于北海道的工厂内为有需求的企业提供强大的计算能力。此外,该公司还计划在未来十年内,在AI计算能力及数据中心

NVIDIA InfiniBand和UFM平台赋能高性能AI计算

在数据驱动的时代,AI网络解决方案需要在保障数据安全的前提下,实现对庞大数据流的快速处理和对复杂AI模型的高效训练与推理。

AMD AI PC创新峰会圆满落幕,携手中国伙伴共拓AI计算新篇章

近日,AMD成功举办了备受瞩目的AI PC创新峰会,向业界展示了其在中国AI PC生态系统中的蓬勃发展态势,并致力于将前沿的AI计算能力带给广大消费者。

FPGA的力量:2024年AI计算领域的黑马?

随着人工智能(AI)的快速发展,其对计算能力的需求也在持续增长。传统的中央处理器(CPU)和图形处理器(GPU)虽然在AI计算中占据主导地位,但面对日益增长的数据量和

AMD CES 2024:AI计算引领未来

AMD最新推出的Versal AI Edge XA自适应SoC搭载AI引擎,为AI计算、视觉和信号处理提供强大支持,自适应SoC适用于边缘传感器,如LiDAR、雷达和摄像头,可执行大量

什么是 AI 计算?

什么是 AI 计算?

评论