当我们谈论视频技术时,超高清视频(Ultra High Definition,简称UHD)无疑是当今最令人兴奋的领域之一。上期,我们花费大量的篇幅介绍了超高清视频的数字版权管理DRM技术,本篇我们来谈谈超高清视频的制作技术之一——虚拟演播室。

关联回顾

全图说电视的发展历史

全图说视频编解码的发展历史

由浅入深说高清——聊聊高动态范围(HDR)

由浅入深说高清——HDR的标准之争

由浅入深说高清——HDR的适配性与流程化的挑战由浅入深说高清——让人眼花缭乱的超高清视频编解码格式由浅入深说高清——超高清视频的三维声技术由浅入深说高清——基于深度学习的超分技术由浅入深说高清——超高清视频的数字版权管理1.绿幕技术

最早的虚拟演播室,是采用绿幕(英文的标准说法是Chroma key,直接翻译就是色度键控)方式。Chroma key这个词儿是美国电子公司RCA在其NBC电视广播中使用的工艺名称。之所以这么称呼,因为Chroma key的目的是根据色调(色度范围)将两个图像或视频流合成(分层)在一起,而不是分离,绿幕和蓝幕分离只是其中的技术过程的一环。色度键控技术常用于视频制作和后期制作。这种技术也称为颜色键控、颜色分离叠加。

这里面必须要提到佩特罗·弗拉霍斯(Petro Vlahos),正是他改进了这一工艺,并在电影《宾虚》中成功运用,惊艳的效果才得以让这种绿幕/蓝幕技术被迅速广泛运用,至今仍方兴未艾。这位发明家也因此拿到3个奥斯卡奖和一个艾美奖,确实是拿到手软。

为什么是绿幕和蓝幕,是因为它们在色调上与任何人类肤色的差异最为明显。这也是为什么绿巨人或者蓝色外星人,才看起来那么醒目的和与众不同。所以在这个技术运用的时候,演员的着装非常重要,如果和后面的单色幕布色差太小,就会被错误地识别为背景的一部分。有一个趣事,就是2002年的电影《蜘蛛侠》的拍摄中,在在蜘蛛侠和绿魔都在空中的场景中,两个人必须分开拍摄,因为:蜘蛛侠穿着红色和蓝色的服装,必须在绿幕前拍摄,而绿魔穿着完全绿色的服装,必须在蓝幕前拍摄屏幕。如果两个人都在同一个绿幕蓝幕前拍摄,那么一个角色的某些部分就会从镜头中消失。

在绿幕技术中,一个最为关键的算法就是活动轮廓模型(Active contour model)。说白一点儿,就是动态抠图技术。

活动轮廓模型,是计算机视觉中的一个框架,由几位计算机图形学的大佬:迈克尔·卡斯(Michael Kass)、安德鲁·维特金(Andrew Witkin)和德米特里·特佐普洛斯(Demetri Terzopoulos)开发的算法。用于从可能有噪声的2D图像中描绘对象轮廓。这个算法被广泛运用在对象跟踪、形状识别、分割、边缘检测和立体匹配等应用中。与经典的特征提取技术相比,活动轮廓模型具有多个优势:

-

-

自主地、自适应地搜索最小状态。

-

外部形象力以直观的方式作用于活动轮廓模型。

-

在图像能量函数中结合高斯平滑引入了尺度敏感性。

-

可用于跟踪动态对象。

-

正是这些优势,让这个模型在绿幕动态抠图和后期制作中如鱼得水,也让这几位计算机图形学的大佬也都顺便拿了奥斯卡奖。

和这个技术相配合的视频抠图技术还有一项是Alpha透明遮罩(Alpha Mask),当然,这些方法现都可以通过计算机算法实现自动化了。

在电视节目中,绿幕技术,经常用在天气预报广播中,在天气预报直播期间,通常会看到新闻主持人站在大型CGI地图前,但它实际上是一个大的蓝色或绿色背景。使用蓝屏,在图像中颜色为蓝色的部分添加不同的天气图。在计算机技术并未成熟前,电影电视剧的制作过程中,绿幕还经常与转轴(旋转镜)技术和运动追踪结合使用,来制造随着主体移动而背景变化的效果。但计算机生成图像(CGI)技术大大简化了这一过程,可以方便地将运动融入合成镜头中。

2.虚拟演播室后来,随着LED屏幕的普及,尺寸越来越大,以及制作成本越来越低,人们不免会有这种思考,何必要经过绿幕再抠图再合成这么复杂的操作,直接将不同的背景融在一起不行吗?澳大利亚电影导演克莱顿·雅各布森 (Clayton Jacobson)在2016年,和他的儿子使用一组LED 屏幕在他们的棚子里制作了现场虚拟制作(On-set virtual production,简称OEVP,或者VP)的首批原型之一。2年后,他的点子被澳大利亚电影摄影师格雷格·弗雷泽 (Greig Fraser)使用,拍摄了星球大战系列衍生剧《曼达洛人》。现在,全球最大的现场虚拟制作舞台就在澳大利亚澳大利亚墨尔本码头区工作室。

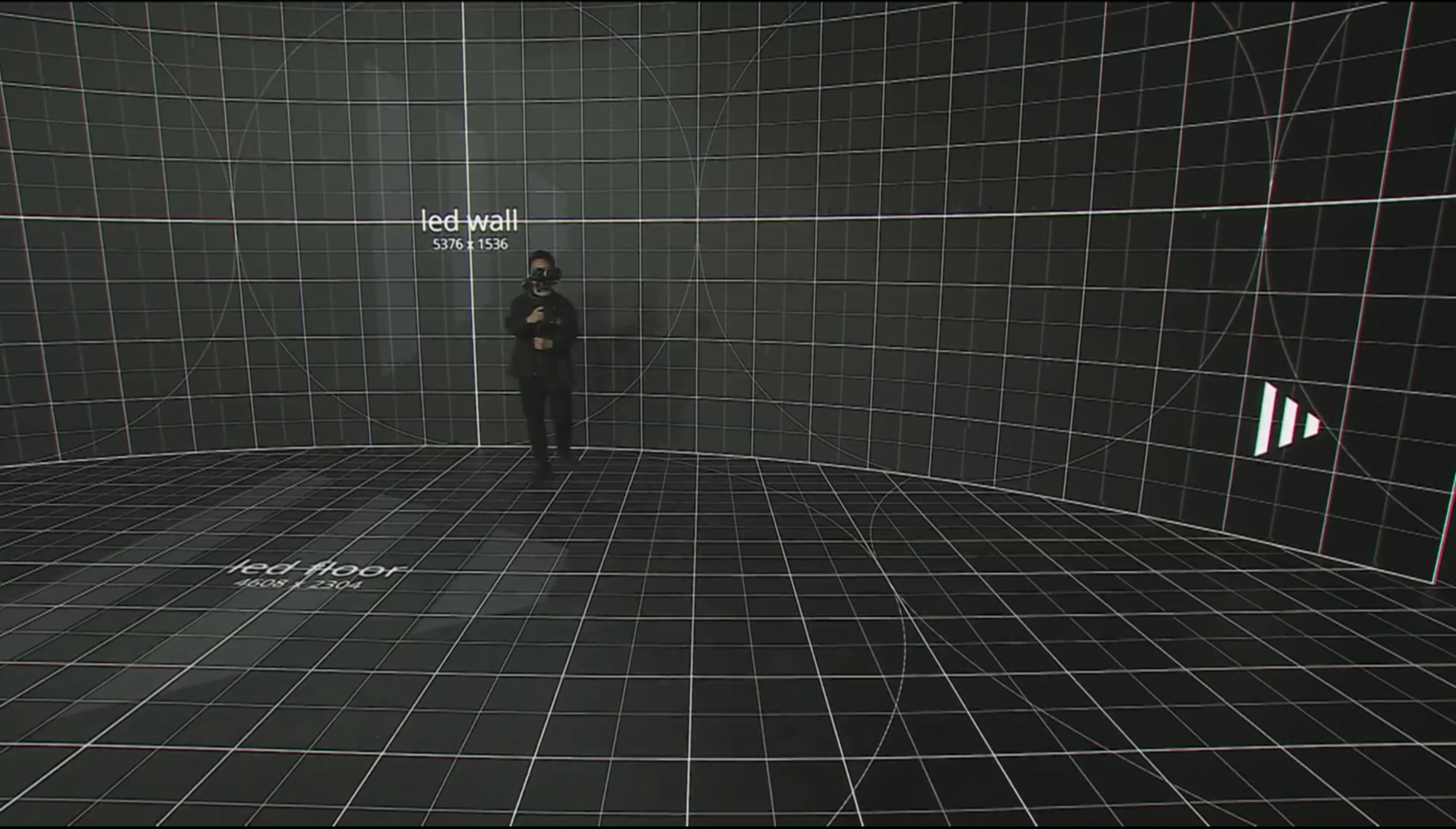

《曼达洛人》使用的虚拟演播室技术叫StageCraft,这是由工业光魔公司(ILM)设计的视频墙组成的。这也被认为是一种革命性的视觉效果技术。StageCraft 过程包括拍摄真人演员和被大型超高清 LED视频墙包围的布景。这些墙显示计算机生成的背景,传统上主要在用绿屏拍摄后的后期制作中合成。这些设施被称为“卷”。拍摄时,制作团队可以根据移动的机位即时调整背景。可以实时操作整个 CG 背景。ILM 使用Epic Games的虚幻引擎(一种流行的游戏引擎)来处理计算机生成环境的实时 3D 渲染。

作为一种新型的影视拍摄方式,虚拟演播室技术更多用于电影、电视剧的拍摄,可以使影视制作人用LED屏取代绿幕,直接在片场现实实时背景和视觉特效。和绿幕技术相比,它的优势可以体现在多个方面:

-

-

摄影空间自由化,可在室内影棚内完成各种场景的拍摄,无论是森林草原雪山,都可以使用渲染引擎实时创建,大幅度减少取景、布景材料损耗,进而降低拍摄成本。

-

制片全流程简单化,可以迅速切换场景所需画面,轻松搭景,相当于影视制作预加工加快拍摄进程。“所见即所得”,在拍摄过程中制作人可以在屏幕上及时查看想要的拍摄画面,场景内容和叙事空间皆可实时修改、调整,大幅度提高换景、改景的效率。在没有运用这个技术之前,通过绿幕方式拍摄,导演必须要通过单独的显示器,快速显示融合后的画面,提前了解后期的效果,然后来指导演员的表演,同时后期还会有视频合成剪辑流程才能进入后期,而这在VP摄影棚中,这些繁琐过程都会被裁减。

-

表演空间沉浸化,在片场的演员站在实时生成场景的R舞台上,不必靠演员自身脑补在傻乎乎做一些表演,而是可以在沉浸式空间内进行表演,直接体验,演员表演更真实、更自然。同时,LED显示屏的光源为现场提供真实光影效果与细腻色彩表现打光,拍摄出的效果更加逼真、完美,极大提升影片整体质量。

-

可节省拍摄、制作时间。缩短投资回报周期。实现对时间的精准把控。通过VP摄影棚轻松切换不同时间、季节、气候,将四季掌握在手里,不用寒暑交替拍摄,可全天候拍摄。虚拟演播室通过LED显示屏构建虚拟场景、节省拍摄团队在实景拍摄时的差旅、舟车劳顿、选景、搭景时间等成本,演员或主持人在可控环境下表演,即使在恶劣的严寒或极热环境下也表演自如。传统制作中最困难的部分之一就是要确保环境恰到好处。这可能意味着有一个 60 分钟的窗口,在太阳落山时获得完美的拍摄(神奇的时刻),或者依靠在雨天晴天——你很可能得不到你需要的东西。张艺谋导演在拍摄《英雄》,在九寨沟的箭竹海上,平静湖面上两个男人点水掠过,激起层层涟漪,为了拍摄完全平静的水面,剧组常常从凌晨五点等到上午十点……有了虚拟制作,您就不必担心这些了。您可以随时控制屏幕上显示的内容,因此如果您希望日落 3 小时,也可以。如果你想让它在冬日阳光明媚,它也可以。这大大减少了等待完美条件所花费的时间。另外通过这种方式使得后期前置实时看到最终呈现画面效果,大幅减少后期制作时间。相比起传统的耗时耗力的电影拍摄流程,虚拟拍摄制作因为效率高,周期大幅度降低,可更快实现影片的上映,加快现金回流,提高现金周转率,节省演员的片酬以及工作人员的支出费用,大幅度降低拍摄成本。这种基于LED背景墙的电影虚拟制作被认为这是电影制作方面的巨大发展,为影视行业的未来提供了全新的动力。

-

虚拟演播室技术及其先进的节目制作方式这两年在国内外普遍使用,得到了迅猛的发展。美国广播公司(ABC)创新推出的虚拟现实新闻报告,让观众能够在叙利亚等新闻现场中自由走动,了解当地发生的事件。新加坡综合媒体和娱乐及创意服务公司使用EVS的直播视频制作解决方案建立了新加坡首个4K准备就绪虚拟现实演播室,该新系统是用于国际体育和娱乐制作的18000平方英尺设施的一部分。好莱坞等内容制作机构已经使用XR等虚拟制作技术制作出了很多影视剧,国内虚拟演播室也表现卓越。但我们还必须清晰地意识到:渲染引擎技术、图像融合拓展技术、虚拟资源生产力工具、动态捕捉跟着技术、摄像成像技术等国内企业尚未完全掌握。其中渲染引擎,虚拟制作系统,摄像机系统,摄像机追踪系统行业中成熟应用都是海外的设备。

虚拟演播室是一个复杂的解决方案。虚拟演播室主要由LED显示屏、渲染服务器、合成服务器、相机追踪系统、灯光系统、摄影系统、音响系统等组成。渲染服务器负责虚拟引擎的渲染工作,通过透视投射将渲染的虚拟画面输出至背景LED屏,由摄像机完成最终采集。其中最为关键的就是虚拟摄像机追踪系统。

3.虚拟摄像机追踪系统虚拟摄像机追踪系统,是虚拟演播室最为关键的技术。

实时的虚拟摄像机追踪系统,又称虚拟摄像机、相机追踪,通过定位摄像机的位置和角度,可以将真实摄像机的运动反映到虚拟摄像机上,并实时地预览虚拟内容的变化。除了位置信息的同步,虚拟摄像机系统还可调整相机的焦距,模拟出镜头的变化,以确保能够完全正确地再现真实摄像机的拍摄效果。合成服务器将不同的硬件设备进行整合链接,控制摄像机追踪与渲染服务器,使LED屏幕及屏幕外的虚拟场景实时跟踪摄像机视角,驱动服务器渲染引擎渲染该视点所需的虚拟画面,在摄像机镜头前与现实拍摄画面合成,营造出无限空间感。镜头合成后,即为观众在镜头前看到的最终影像——无论镜头如何移动,主持人或演员始终身处在符合正确透视关系的画面中。

虚拟摄像机追踪系统一般都会用到以下技术:

-

-

摄像机跟踪:用于拍摄实景镜头的物理摄像机的移动被跟踪并与虚拟环境中的虚拟摄像机的移动相匹配。这允许虚拟环境与真人镜头一起移动和缩放,从而创建更逼真的无缝集成。

-

光照和阴影:调整虚拟环境中的光照和阴影以匹配真人镜头中的光照。这有助于将实景镜头和虚拟环境融合在一起,使它们看起来像是属于同一个场景。

-

颜色分级:调整真人镜头的颜色以匹配虚拟环境的颜色和色调。这有助于在两个元素之间创建更具凝聚力和逼真的外观。

-

转轴技术(Rotoscoping):转轴是从真人镜头中手动分离对象或角色的过程,允许将其放置在虚拟环境中。这种技术通常用于真人角色需要与虚拟对象或环境进行交互的场景。

-

支撑虚拟摄像机需要很多软件能力,以下就是典型的几个:

3D建模和动画软件技术

3D 建模和动画软件是虚拟演播室用来创建用于沉浸式体验的对象、角色和环境的 3D 模型的关键工具。这些模型可以使用建模工具从头开始创建,也可以使用 3D 扫描技术从真实世界的对象中扫描出来。创建模型后,可以对它们进行动画处理和装配以模拟真实世界的运动和交互。动画可以手动创建,也可以使用运动捕捉技术创建,该技术捕捉现实世界中演员或物体的动作并将其转化为 3D 动画。然后将这些 3D 模型和动画导入到 Unity 或 Unreal Engine 等游戏引擎中,用于创建交互式沉浸式体验。除了角色模型,3D 建模和动画软件还可用于创建可在 沉浸式体验中探索的详细环境和对象。例如,可以创建建筑物的 3D 模型并将其导入3D引擎,供演员和观众在虚拟演播室中进行体验。

动作捕捉和图像识别

在虚拟演播室中,动作捕捉通常用于创建可用于交互式体验的角色或对象的逼真动画。首先,设置动作捕捉系统:在虚拟演播室中使用动作捕捉的第一步是设置动作捕捉系统。这通常涉及在被捕获的演员或物体上放置标记或传感器,以及设置相机或其他传感器来跟踪这些标记的移动。接下来,捕捉动作:设置动作捕捉系统后,演员或物体可以执行所需的动作,并由传感器捕捉。这可以包括从步行或挥手等简单动作到战斗或舞蹈等更复杂的动作。再之后就是处理数据:动作捕捉系统捕获的数据随后由专用软件处理,该软件使用算法将运动数据转换为 3D 动画,导入到 Unity 或 Unreal Engine 等引擎中,用于创建交互式沉浸式体验。

以下是在虚拟演播室中使用图像识别的一些具体案例:

-

-

跟踪用户运动:为了创造真正身临其境的沉浸式体验,系统跟踪用户运动并相应地调整虚拟环境非常重要。计算机视觉技术可用于跟踪用户头部、手部和其他身体部位的位置和运动,让 虚拟系统调整视角并显示适当的内容。

-

物体识别:计算机视觉技术还可用于识别和跟踪用户环境中的真实物体,例如家具或其他障碍物。这允许虚拟系统调整虚拟环境以避免碰撞或其他问题。

-

手势识别:计算机视觉技术可用于识别和解释用户的手势和动作,使他们能够以更自然和直观的方式与虚拟系统进行交互。例如,用户可以挥手来选择菜单中的选项,或者做出抓取动作来拾取和操纵虚拟对象。

-

面部识别:计算机视觉技术可用于识别用户的面部和情绪,让虚拟系统相应地调整体验。例如,如果用户皱着眉头,系统可以调整灯光或内容,使环境更加愉悦和吸引人。

-

在虚拟演播室中,人工智能技术被大量的运用。比如上文我们说的3D建模,AI可以通过AIGC 可用于根据特定规则和参数以程序方式生成虚拟环境和对象。这可以为设计人员节省时间和精力,还可以创建更复杂和逼真的环境。AI 算法还可用于生成高质量的 CGI 元素,例如角色、环境和特效。这可以节省时间并提高最终产品的质量。还比如上文说到的动作捕捉,人工智能算法可用于分析演员和观众的数据并预测他们的行为、偏好和对不同沉浸式体验的反馈。这可以帮助虚拟演播室创造更有效和引人入胜的体验。

4. LED屏幕墙壮观的LED屏幕墙,也是虚拟演播室非常重要的技术。

在虚拟演播室搭建过程中,LED墙必须满足一系列关键的指标参数:

-

-

分辨率(Resolution):从人眼识别度来看,像素尺寸要保证在300ppi(每英寸300个像素)或者更高,一般而言,LED显示墙由很多单块的显示屏拼接而成,每块显示屏最好在保证300ppi的基础上满足4K分辨率。

-

亮度(Brightness):虚拟制作工作室 LED 屏幕所需的亮度水平取决于多种因素,例如工作室的环境照明条件、显示的内容以及屏幕所需的视觉效果。一般而言,建议虚拟制作工作室 LED 屏幕的亮度级别至少为 1,000 尼特,以确保即使在光线充足的环境中,屏幕上显示的图像也显得明亮而充满活力。然而,一些高端 LED 屏幕的亮度可高达 2,000 尼特或更高,这有利于创建高对比度、生动的图像。值得注意的是,更高的亮度水平也会导致功耗和发热增加,从而影响 LED 屏幕的整体性能和寿命。因此,重要的是要考虑制作的整体需求,并平衡所需的亮度水平与其他因素,如功耗、散热和维护要求。

-

色彩要求(Color Gamut):一般情况下,虚拟制作工作室的LED屏幕具有广色域和高色彩精度,是创建逼真、充满活力的虚拟环境的首选。建议色域至少为 DCI-P3 色彩空间的 95%,因为这提供了可以在屏幕上准确显示的多种颜色。色彩准确性也是虚拟制作的一个重要考虑因素,因为它确保屏幕上显示的色彩逼真并与虚拟环境的预期外观相匹配。Delta E <2 的色彩准确度等级被认为是优秀的,推荐用于虚拟制作工作室 LED 屏幕。

-

刷新率(Refresh Rate):一般来说,虚拟制作首选较高的刷新率,因为它有助于减少运动模糊并确保快速移动的物体在屏幕上显得流畅自然。建议虚拟制作工作室 LED 屏幕的刷新率至少为 120Hz,但一些高端屏幕的刷新率可能高达 240Hz。再高的刷新率人肉眼已经无法分辨,建议不必过度追求完美。

-

视角(Viewing angle):通常,虚拟制作工作室的 LED 屏幕首选宽视角,因为它可以确保屏幕上显示的图像即使从不同角度观看也能保持清晰和生动。建议虚拟制作工作室 LED 屏幕的视角至少为 160 度,尽管一些高端屏幕的视角可能高达 180 度。值得注意的是,实现宽视角对 LED 屏幕来说具有挑战性,因为它们通常是背光的,并且在极端角度下很难保持色彩准确度和亮度水平。因此,重要的是在购买之前仔细评估任何虚拟制作工作室 LED 屏幕的视角,并考虑预期的拍摄和观看环境等因素。

-

像素间距(Pixel pitch):一般来说,较小的像素间距是虚拟制作工作室 LED 屏幕的首选,因为它可以在虚拟环境中实现更高的分辨率和更高级别的细节。建议虚拟制作工作室 LED 屏幕的像素间距为 1.5 毫米或更小。小间距LED显示屏表现力极好,呈现效果逼真,即使在低亮度下显示屏灰度也表现几乎完美。拍摄无摩尔纹,可以高度还原画面细节。值得注意的是,实现小像素间距对 LED 屏幕来说具有挑战性,因为它需要将更多的单个 LED 紧密放置在屏幕上。因此,重要的是在购买之前仔细评估任何虚拟制作工作室 LED 屏幕的像素间距,并考虑预期观看距离、屏幕尺寸和虚拟环境中所需的细节水平等因素。

-

对比度(Contrast ratio):一般来说,虚拟制作工作室的 LED 屏幕首选高对比度,因为它可以更好地区分图像的暗区和亮区。建议虚拟制作工作室 LED 屏幕的对比度至少为 3000:1,一些高端屏幕的对比度可能高达 10,000:1。

-

重量和薄度(Weight and thinness):重量和薄度是选择虚拟制作工作室 LED 屏幕时要考虑的重要因素,必须要最大程度地减少每平方米显示屏的重量。因为它们会影响屏幕的安全性、移动性和易安装性。轻薄的 LED 屏幕通常是虚拟制作工作室的首选,因为它可以根据需要在不同位置之间轻松安装和移动。此外,较轻的屏幕可以降低安装和维护过程中人身伤害的风险。

-

XR是扩展现实(Extended Reality)的英文缩写。我们可以认为XR是AR和VR都是对现实的补充。XR是将现实和LED上的虚拟环境进行充分融合。XR延展拍摄,是指使用视觉交互技术,通过制作服务器将真实与虚拟相结合,利用LED显示屏打造一个可人机交互的虚拟环境,为观众带来虚拟世界与现实世界之间无缝转换的“沉浸感”。XR 延展影棚通常结合使用3D 建模和动画软件、游戏引擎、动作捕捉系统以及虚拟现实和增强现实硬件来创造身临其境的体验。这里的LED或者象瓷砖一样被安装在空间的天花板,墙体和地面,还可以安装在类似洞穴等异形空间。或者被安装在活动导轨上根据场景需求进行移动。这些屏幕上显示的内容往往是在实时生成软件或游戏引擎(如 Notch 或虚幻引擎)中创建的环境。为了创造一个超越 LED 背景的整个世界,通常会结合了摄像机跟踪和实时渲染。该技术使这些屏幕上的内容能够从相机的角度动态呈现。因此,当相机移动时,观众看到的内容也会移动,这样会创造出真实环境的错觉。与看不到周围环境的绿幕不同,背景可以随镜头移动,任何深处这个环境中的人,不管是演员,还是观众,都不必想象自己身处的地方,他们可以直接体验。XR扩展影棚拥有所有VP摄影棚的优点,而且会增加更多的沉浸感。

XR延展影棚可用于网络直播、电视台直播、虚拟音乐会、虚拟晚会和广告拍摄等场景。XR延展影棚拍摄可以将虚拟内容扩展到LED舞台之外,使虚拟和现实实时叠加,增强观众的视觉冲击感和艺术创意感,让内容创作者在有限的空间创造出无限可能,尽情追求无尽的视觉体验。

这两年,XR延展影棚频频亮相,再次敲响市场的大门。XR制作方案已拥有众多成熟案例。央视春晚XR舞台 、北京冬奥会开幕式、戛纳XR沉浸影像获奖等等……

2020年12月,咪咕文化利用5G+4K/8K+XR技术在广州举行了第十四届音乐盛典“咪咕汇”,在国家大剧院举办“龙凤呈祥”演出,实现云上演出以及云端观众互动2021年3月,爱奇艺正式发布演出产品“虚实之城”沉浸式虚拟演唱会,全程使用XR技术呈现表演,实现沉浸式的虚拟舞台演出,该演唱会网络观看量突破3000万次;2020年第26届格莱美奖获得者Travis Scott选择《堡垒之夜》游戏世界中的一个虚拟地点开展演唱会,据估计有1800万观众在线观看了虚拟演唱会;2021牛年春晚创新采用XR的演播环境,将知名歌手的表演与虚拟背景融为一体,展现出不同寻常的科技感体验;2022年CGN的全球会客厅中秋特辑,全程使用XR演播室进行制作。

5. 写在最后随着5G、人工智能、AR/VR/MR等虚实结合技术的快速发展,文化产业数字化的脚步正在加快,加之人民群众日益提高的物质生活水平,伴随而来的是更高的精神需求,观众不再满足于以往千篇一律的内容呈现形态,近年来对沉浸式、互动式、虚实结合、异地互联等数字文创内容表现出极大的兴趣,人们希望看到超越传统演绎效果的精彩内容。除了电影电视,大型音乐会演唱会之外,还可以实现短视频虚拟制作、虚拟扩展直播、数字人实时互动、展览、广告活动等应用方向。相信,虚拟演播室应用前景必然会更加广阔。

好了,今天,我们就先聊到这里,下一期,我们再展开谈一下超高清视频的另外一个话题:视频云技术。

-

开源技术

+关注

关注

0文章

389浏览量

7933 -

OpenHarmony

+关注

关注

25文章

3722浏览量

16317

原文标题:河套IT TALK 69: (原创) 沉浸式的虚拟演播室技术(万字长文)

文章出处:【微信号:开源技术服务中心,微信公众号:共熵服务中心】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

单日获客成本超20万,国产大模型开卷200万字以上的长文本处理

松下KAIROS助力浙江广电集团演播室全新升级

索尼HXC-FZ90助力气象局演播设备升级

浅谈无线内部通话系统在演播活动中的必要性

宁波电视台融合XR技术虚拟演播室,秀狐科技助力数字化视听革新

万字长文浅谈系统稳定性建设

MiniMax推出“海螺AI”,支持超长文本处理

洲明携手18家生态合作伙伴亮相2024美国广播电视展NAB

Moku + Apple Vision Pro时空之旅: 探索沉浸式光学实验室体验

阿里通义千问重磅升级,免费开放1000万字长文档处理功能

虚拟现实仍不现实,沉浸体验先看视觉跳动智能激光屏

鸿蒙应用/元服务开发-窗口(Stage模型)体验窗口沉浸式能力

使用e2演播室或IAR EW Rev.2.00 Azure RTOS示例项目应用说明

河套IT TALK 69: (原创) 沉浸式的虚拟演播室技术(万字长文)

河套IT TALK 69: (原创) 沉浸式的虚拟演播室技术(万字长文)

评论