2023年4月28日晚,信息科学前沿与产业创新课程暨信息科学技术学院第九期“知存讲座”在理科教学楼106教室顺利举办。知存科技创始人兼CEO、北大校友王绍迪先生受邀进行了以“AI大模型带来算力基础的改变”为主题的分享,30余名师生到场聆听。本次活动由北京大学信息科学技术学院副院长王润声老师主持。

讲座伊始,王绍迪先生简要介绍了目前的形势及知存科技的情况。AI大模型达到奇点,既会产生巨大的经济效益,为人们的生活带来重大变革,也会对从应用场景到底层算力的产业整体产生极大影响,还会为国际竞争创造新的战略支点。作为知存科技的创始人兼CEO,王绍迪先生格外关注AI大模型在底层算力及其基础建设方面产生的影响。知存科技自创立以来一直深耕AI算力领域,在存算一体芯片领域处于国际领先地位,完成了多项从零到一的突破。公司有180余人的专业团队,累计完成了近8亿元融资。在AI大模型不断发展的未来,公司将继续专注存算一体技术,致力提升AI的底层算力。

接下来,王绍迪先生从AI大模型的应用场景、AI计算大模型需求、近存计算技术及应用与存内计算及其大模型应用四个方面介绍了AI大模型给算力基础带来的影响。

01

AI大模型的应用场景

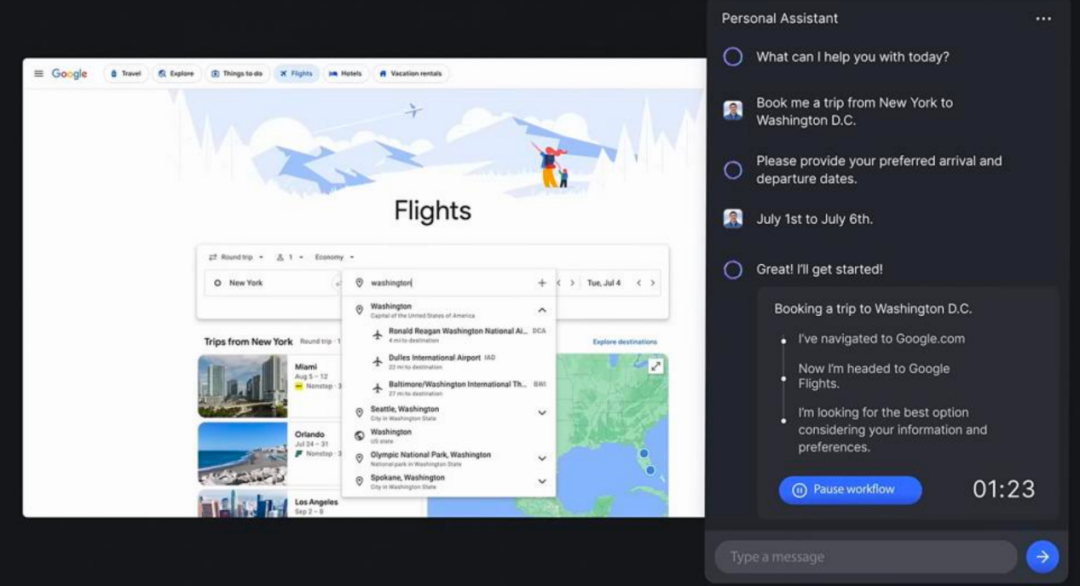

当前,AI大模型已经从单纯的概念革新转变为了能够带来巨大商业价值和生产力飞跃的先进技术,应用场景十分广阔,在图片与视频分析、代码生成、数据分析、视频生成等方面都展现出了极强的实力。预计未来两到三年内,GPT类算法还会有更大幅度的迭代,从而能更好地节约生产成本,提高生产效率。当然,大模型的应用也会带来数据安全威胁等一系列问题,相关监管治理措施也有待进一步研究和探索。

02

AI计算大模型需求

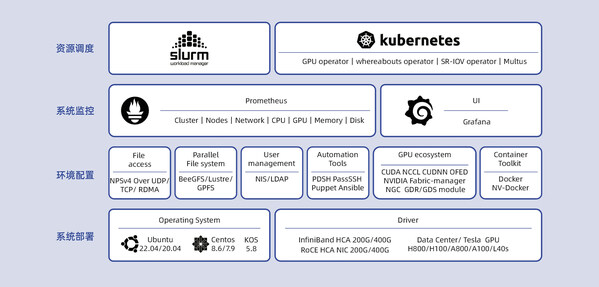

目前算力的发展受到多种制约。一方面,摩尔定律趋于失效,硅基算力增长将逐渐达到极限;另一方面,内存的计算性能及存储器的带宽提升较慢,不能与计算芯片时钟速、核数及存储器存储容量的增加相匹配,导致计算效率增长受限,读写数据功耗增加。功耗是限制算力最大的瓶颈。一定的散热技术下,芯片的功耗存在上限,计算的算力也存在相应的上限。为了提升算力,必须设法提高能效,扩大数据穿透的“门”,让数据更容易在“门”的两侧间流动。

从智能语音、视觉处理到自动驾驶、AIGC,大模型对参数量和算力的要求越来越高。算力越高,对数据的搬运也越多。实际上,现在所谓的计算中,90%的时间在进行数据的搬运。在传统的冯·诺伊曼计算架构中,数据需要在不同的存储之间流动,形成庞大的数据流。这个计算体系下,硬盘容量大但读取慢,缓存读取快但容量小,都不能真正帮助AI进行有效计算。现有AI计算最依赖的器件是内存,它的容量足够大,可以容纳大部分模型的整体或部分,而且带宽也足够高,可以支持高速的数据读写需求。目前,业界的优化也主要集中在对内存与计算芯片之间带宽的优化上。此外,由于单张芯片内存的容量有限,一些大模型需要多张芯片互联来实现训练或推理。在这个过程中,真正构成计算的瓶颈且亟需得到提升的,不是计算芯片单核的计算速度,而是单卡的内存与芯片之间,以及多卡之间数据交换的速度。

架构层面的改进也能够带来计算效率的提高。相比CPU,GPU对于AI模型的运算效率已经高了100倍左右。对于AI大模型这种大参数量计算,通用计算的效率很低,如果针对模型设计专用的计算解决方案,将能带来更大的受益。通过定制化设计开发具有专用计算架构的专用计算芯片,预计还能将大模型计算的效率提高10倍左右。

AI算力市场规模不容小觑。基于现有显卡及云服务价格,短期市场规模预计可达15亿美元,而中期及长期规模预计将分别达到1200亿美元及20000亿美元。基于未来方案的成本优化及计算算力的成本降低,对未来市场作出的较合理预测约为中期300亿美元,长期1000亿美元。可见,AI底层算力的市场将会是一个非常大的专一市场。

03

近存计算技术及应用

怎样持续优化算力,降低计算成本,提高计算效率呢?存算一体被认为是最有效的手段之一。冯·诺伊曼计算架构中,内存和计算是分开的,而现在主流的高算力芯片已经开始采用近存的计算架构,将内存和计算芯片整合到一起。更高效的存内计算架构,以及将近存与存内结合在一起的计算架构也有巨大的发展潜力。

近存计算是目前商业化程度最高的存算一体技术。近存计算起源于2013年AMD和海力士解决内存与显卡之间数据带宽问题的实践,其基本思想是用集成电路的方式将内存和计算芯片结合在一起,拉近二者之间的距离,从而使其间走线长度更短,密度更大,数量更多。近存计算有2.5D与3D两种集成技术。2.5D技术将计算芯片与内存芯片集成到一个芯片上去,从而在二者间实现芯片工艺的走线,以替代原有的PCB版工艺的走线。这种技术运用现有的成熟技术解决问题,是目前最实际的一种解决方案。而3D集成技术将两个芯片“贴”在一起,其间的走线密度还能再提高10至100倍,集成密度更大,计算速度更快。

各大厂商都积极采用近存计算技术,推出了性能先进的产品。现在,英伟达的高带宽内存技术(HBM,High Bandwidth Memory)采用2.5D与3D相结合的封装方式,已经过数次迭代达到了很高的带宽,并为苹果的M1及M2芯片采用;英特尔的智强处理器采用2.5D集成HBM2E内存,集成AI训练和推理加速器,能够更有效地提升相关计算的速度;AMD通过将所有内存直接通过3D方式与计算芯片堆叠在一起,大幅降低了每比特数据的传输功耗;三星则基于3D封装技术,集成计算逻辑芯片与内存。

然而,随着摩尔定律逐渐失效,芯片的成本越来越高。目前,提高10%至20%的速度,要提高约50%的成本,相当于速度提高一倍,成本要提高近五倍。未来,获得更高算力的成本会持续上涨,产品的价格也会相应提高。而且,2.5D与3D的集成方式预计将在两三年内达到带宽极限,未来发展的挑战会越来越大。

04

存内计算及其大模型应用

如上所述,近存计算通过封装、集成的手段“拉近”内存与计算芯片之间的距离,虽然是业界的主流,也终究存在发展的极限。而存内计算作为更加高效的计算技术,正在受到越来越广泛的关注。

采用内存而非硬盘进行AI大模型计算的原因,是硬盘虽有很大的容量,但没有令人满意的读写速度。如果能够让存储单元基于本身的物理特性直接完成计算,就能减少数据的流动,从而减小对高带宽的依赖程度。存内计算技术可分为存内计算SoC、3D存内计算及2.5D+3D存内计算三代技术,内容十分丰富。目前的存内计算技术主要能够使存储单元具备乘法与加法计算的能力,虽不完备,却能覆盖AI计算的90%左右,能够大幅提高整体的计算效率。另外,AI大模型对计算精度的要求相对降低,存内计算精度可以完成有关的计算任务。此外,存内计算技术分布式存储与计算的特性使它适合于混合专家系统的实现。成本驱动是底层算力发展的关键特征。由于对先进工艺的依赖较弱,对内存带宽的需求不高,存内计算技术有望大幅降低AI计算成本,展现出良好的发展前景。

在提问交流环节,到场师生就存算一体芯片的优势、挑战、技术细节,以及知存科技良好发展的经验等问题与王绍迪先生进行了交流。王绍迪先生耐心地解答了大家的问题。

最后,讲座在同学们热烈的掌声中圆满结束。

审核编辑 :李倩

-

AI

+关注

关注

87文章

30946浏览量

269186 -

模型

+关注

关注

1文章

3248浏览量

48860 -

数据安全

+关注

关注

2文章

681浏览量

29952

原文标题:知存讲座 | AI大模型带来算力基础的改变

文章出处:【微信号:gh_c7acc31312b6,微信公众号:知存科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

AI大模型给算力基础带来的影响

AI大模型给算力基础带来的影响

评论