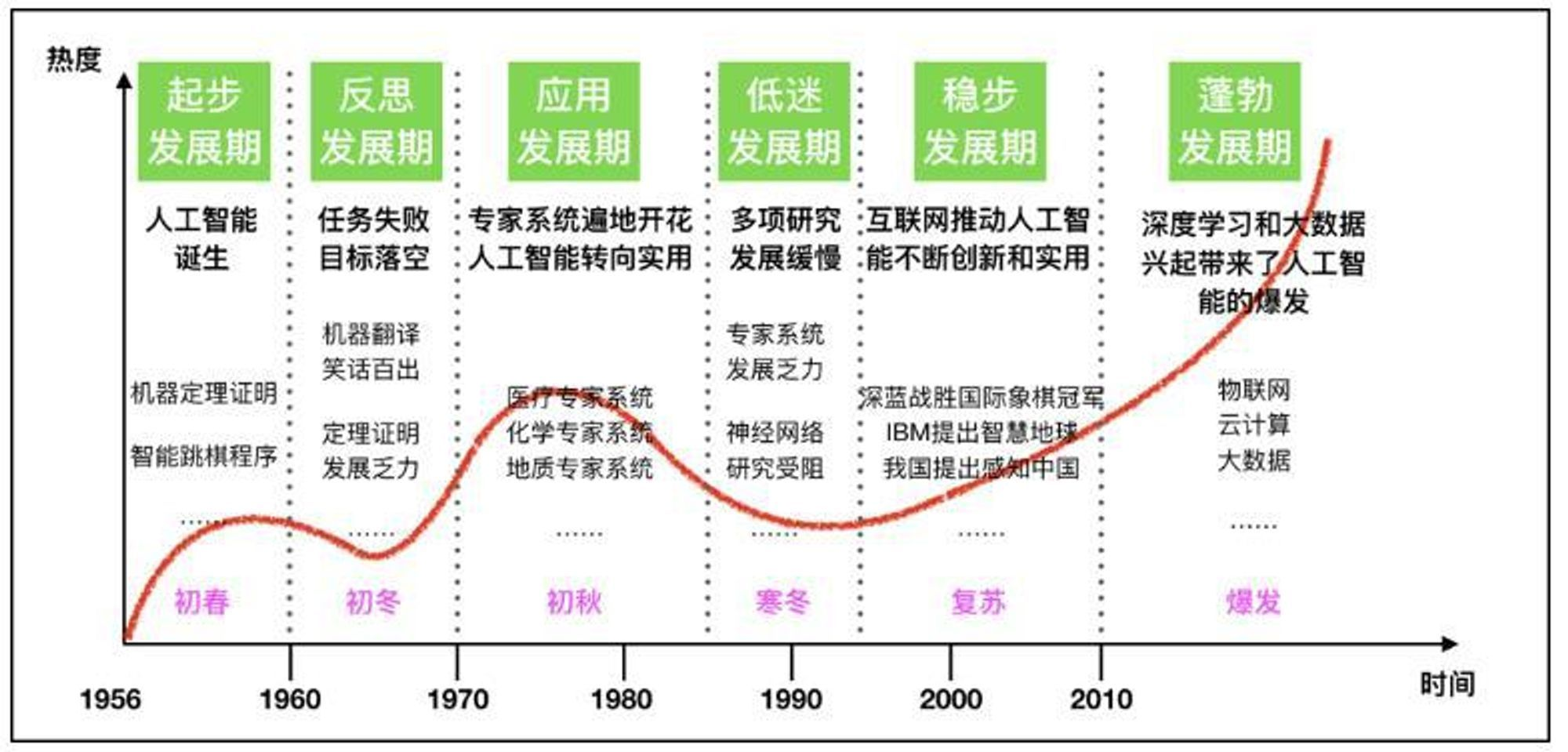

近年来,随着人工智能(Artificial Intelligence, AI)技术的深化发展,大模型(Large Model,也称基础模型,即Foundation Model)技术应运而生。特别是2022年11月底OpenAI发布ChatGPT,一时间引起国内外强烈反响,如同2016年AlphaGo围棋AI战胜人类顶级棋手李世石一样,全社会对AI模型所能达到的智能化水平产生了全新认知。本报告首先对ChatGPT发展情况进行概要介绍和对比分析;在此基础上,分析提出大模型发展带来的启示和思考,特别是对决策智能大模型发展进行分析研判;最后,对当前大模型技术应用提出若干发展展望。

一、ChatGPT相关介绍

(1)ChatGPT总体情况

ChatGPT是由OpenAI于2022年11月30日上线的通用语言处理平台,能以自然语言为交互方式,实现问题回答、文案撰写、文本摘要、语言翻译、计算机代码生成等任务。自发布以来,ChatGPT引起国内外广泛关注,成为“刷爆朋友圈”的现象级应用。据瑞银集团(UBS)发布的研究报告显示,ChatGPT在2023年1月份(发布后2个月)的月活跃用户数已达1亿,成为史上用户数增长最快的消费者应用;相比之下,TikTok历经9个月才实现月活用户数破亿,Instagram为30个月,Meta为54个月,Twitter为90个月。此外,ChatGPT使人工智能内容生成(AI Generated Content, AIGC)技术成为新的热点。

本质上来讲,ChatGPT是一个大语言模型(Large Language Model, LLM), 这是一个概率模型,基于上下文输入来度量下一个词汇出现的可能性,即完成“词语接龙”。语言模型技术始于上世纪70年代,ChatGPT是OpenAI自2018年推出生成式预训练(Generative Pre-training, GPT)模型[1],在经历过GPT-1、GPT-2、GPT-3、InstructGPT等多代模型迭代后,在GPT-3.5基础上发展出来的产物(OpenAI于3月14日发布了基于GPT-4的改进版[2],拥有更强大的语言处理能力)。进一步拆解其核心技术要素,可以认为,ChatGPT并非AI原始理论技术创新产生的重大突破,而是产品思维驱动的重大集成创新成果,是OpenAI坚持生成式AI、长期技术积累,量变产生质变的重大成果,同时其强大的自然语言处理能力,也是迈向通用人工智能(Artificial General Intelligence, AGI)的阶段性成果[3]。

(2)ChatGPT技术发展脉络

自然语言处理技术自诞生以来,先后经历了4种主要任务处理范式[4]。第一种是非神经网络下的完全监督学习,由人工设计一系列特征模板输入模型,模型性能高度依赖所设计的特征和专家知识;第二种是基于神经网络的完全监督学习,由人工进行数据标注,神经网络用于自动特征提取;第三种是“预训练-精调”(Pre-train and Fine-tune)范式,首先在超大规模文本数据集上基于自监督方式预训练一个具备较强泛化能力的通用模型,然后再根据下游任务特点对模型进行针对性微调,从而进一步减少人工参与;第四种是预训练结合提示(prompt)学习范式,在得到预训练模型后,使用时不再进行模型微调,而是将对任务的描述以提示方式输入模型,模型自动适配下游任务。

如前所述,ChatGPT经历了多轮模型迭代。GPT-1于2018年被提出,是在Google于2017年提出的变换器(Transformer)模型[5]基础上发展起来的大语言模型,拥有1.17亿参数,采用“预训练-精调”范式,初步具备了一定泛化能力。GPT-2于2019年被提出,拥有15亿参数,OpenAI希望彻底无需针对下游任务微调而实现模型适配,因此采用了提示学习范式,实现了在零样本或小样本下良好的内容生成和表达能力。GPT-3延续GPT-2的方式,进一步将参数规模扩大到1750亿,并使用45TB语料数据进行训练,性能已相当强大,可完成自然语言处理的绝大多数任务。在OpenAI放弃模型微调的同时,Google坚持采用模型微调技术,并于2021年9月提出采用指令微调(Instruction Fine-Tuning, IFT)技术的大模型FLAN[6],其在许多任务上的表现超越了GPT-3。为此,OpenAI重新采用微调,即在GPT-3基础上增加IFT技术,于2022年初推出InstructGPT[7],由于混合了人类指令,InstructGPT在理解人类意图和拟人化表达方面已非常突出。为进一步提升模型逻辑推理能力,OpenAI采用159 GB的Python代码语料在GPT-3上进行训练,产生了具有强大代码理解/生成能力和逻辑推理能力的模型Codex[8]。最后,InstructGPT与Codex相结合,形成了GPT-3.5的基础架构,即ChatGPT的基础模型。

ChatGPT的另一关键技术是人类反馈的强化学习(Reinforcement Learning with Human Feedback, RLHF),即人类标注员对模型的一系列问答结果进行评分,以此训练一个符合人类判断的奖励模型,基于此奖励模型采用近端策略优化(Proximal Policy Optimization, PPO,2017年由OpenAI提出[9])强化学习算法进行预训练后的模型精调。试验表明,RLHF能极大提升模型表现,仅采用13亿参数的模型即表现出超越原本拥有1750亿参数但未采用RLHF的微调模型或原始的GPT-3模型。OpenAI联合创始人John Schulman认为,RLHF才是ChatGPT的秘密武器。而RLHF技术于2017年即由OpenAI联合DeepMind及Google Brain团队提出[10]。

(3)ChatGPT的局限

当前,ChatGPT展现出通用的意图理解能力(大语料数据训练、人类指令微调、人类反馈的强化学习)、强大的连续对话能力(采用8192个语言单元进行显式建模)、突出的代码生成能力(采用代码和文本混合学习)等特点,但仍存在如下局限性:

缺乏概念构建能力。以ChatGPT为代表的系列大模型本质上仍是一个黑盒概率模型,即使能给出令人满意的结果,但内在并未形成真正的概念范畴,无法进行知识逻辑推演和解释,尚无法形成对真实世界的本质认知。

缺乏自主学习能力。以ChatGPT为代表的系列大模型基于静态数据驱动的学习范式,模型训练成本高,理论上无法实现新知识的快速学习,即当人类输入增量知识后,模型无法及时实现新知识的学习。

缺乏实体交互能力。ChatGPT等大模型主要以文本为核心处理对象,即使是涵盖图、文、音的多模态大模型也仍属感认知范围,缺乏与包含强不确定性和开放边界元素的真实物理世界的交互和决策控制能力。

缺乏垂域泛化能力。ChatGPT等大语言模型在通用语境下已展现出强大能力,但在各垂直细分应用领域,大模型的性能表现仍需提升,特别是对于模型准确性要求严格的应用,此外还需攻克终端资源约束下的大模型部署问题。

二、大模型核心价值与发展启示

(1)大语言模型的核心价值

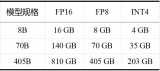

如果说机器学习实现了学习算法的统一,深度学习实现了模型架构的统一,那么大模型则实现了模型本身的统一[11]。大语言模型是当前一轮大模型的成功典范,其本质是以自然语言理解为内核,构建起人-机间互理解、互操作的高效、高性能媒介通道。因此,直观上来看,与人机交互、人机协同、人机融合最相关的领域将最直接体现大模型的应用价值。正向来看,大模型将人对世界的模糊、抽象认知转化为可精确表达、高度量化的特征,供机器进一步计算、推演,解决人机高效交互协作问题。反向来看,大模型将机器高度精确却难以窥探的黑箱计算结果转化为人可理解、可接受的形式进行呈现,解决AI的可解释性问题。例如,大模型可对人的历史经验、判断偏好、直觉认知进行精确理解,变成可供计算的特征表达;反过来,机器的推理计算过程及结果可以自然语言形式输出,供人实时掌握情况并做进一步决策。

人机混合智能是AI的高级形态,而大语言模型展现出的通用性为我们粗浅地勾勒出通用人工智能的图景,因此,大模型为迈向更高级形态的AI奠定了重要的阶段性基础。

(2)大模型发展带来的启示

应谨防关键领域技术突袭。当前,人工智能技术正以史无前例的速度自我迭代,据估计,AI领域约每3个月便会产生一种世界范围内具有重大影响的主流算法。作为对比,传统科学技术的迭代更新较慢,例如,当今全世界控制领域90%以上使用的比例-积分-微分(PID)控制器始于上世纪20年代;即使是迭代较快的集成电路领域,摩尔定律告诉我们,其迭代速度也大概为18-24个月。不久前,我们仍慨叹市面上各种聊天机器人的智能水平较低,ChatGPT的横空出世瞬间颠覆了这一认知。因此,在当前国际关系日益复杂的局势下,我们应谨防关键领域对手的技术突袭,特别是当我们步入多方面并跑的“无人区”领域时,而AI的加速发展使得技术突袭的“黑暗森林法则”越来越成为可能。

应重新审视“人工”的作用。人工智能的发展离不开“人工”的参与,而随着AI技术的迭代,“人工”所扮演的角色也在逐步更迭。早期的监督学习时期,人主要扮演数据标注角色,数据标注被认为是技术含量很低的工作,并一度出现了各种数据标注工厂。到了近些年发展出的指令学习,人不再简单给出标签数据,还需要按要求给出数据指令。而在RLHF中,人需要提供AI模型的输出反馈,从而训练一个良好的奖惩函数。在ChatGPT的代码生成中,具有良好人工注释的训练代码是其掌握推理编程能力的重要基础。随着AI 的发展,“人工”的作用越来越精细。例如,在智能指控领域,高度专业化的人工标注数据、人类指挥员经验和人机混合训练方式,可最大化发挥大模型作用,应提前进行部署。

应审时度势迎接创新范式变革。近些年,AI正加速为其他学科内在发展提供颠覆性范式创新,例如,2020年的AlphaFold展现出惊人的蛋白质结构预测效率,2022年的AlphaTensor发现了迄今效率最高的矩阵乘法运算法则。AI为科学研究和技术创新范式带来了全新机遇和挑战,人工智能驱动的科学研究(AI for Science)也成为当前国际瞩目的热点方向,国家科技部、自然科学基金委也于今年3月联合启动了AI for Science专项部署。为此,应重新审视这一变局下的科技创新范式。例如,在智能指控领域,一是如何以智能技术先行带动体系创新,如概念设计、战法创新,二是重新梳理创新成果体系,重视算法等软实力打造,以及大模型加持下的技术集成、模型训练方式创新等。

三、决策智能大模型展望与思考

当前流行的ChatGPT等大模型主要聚焦在图、文、音等媒体内容的感知理解层面,与之相对应,与指挥控制息息相关的智能认知与决策则是更具挑战性的难题,决策智能大模型是否能快速实现并落地,成为当前广受关注的话题。在此,对决策智能大模型研究现状进行概述,并对其发展路径提出相关思考。

决策智能大模型发展概况

随着预训练模型的兴起,训练一个可完成多种决策任务的智能体在近年来引起广泛关注。DeepMind于2022年上半年提出能够处理数百种任务的“通才”人工智能模型Gato[12],融合了多模态和多任务,智能体可同时完成玩Atari游戏、生成图像、和人类聊天、控制机器人手臂堆叠积木等不同模式的任务。但本质上,Gato是一种监督学习模型,可认为首先学会了各种任务,然后对相关能力进行集成,并未在真正意义上实现面向不同任务的能力迁移和自主学习。进一步,DeepMind在2023年初提出可在开放任务空间实现匹配人类适应能力的自适应智能体AdA(Adaptive Agent)[13], 该模型基于DeepMind自研的开放任务环境XLand进行训练,后者可在虚拟空间产生超过1040种开放任务,被视为可训练通用智能体的游戏“元宇宙”。AdA的技术核心包括三方面:1)在一个巨大、平滑且多样化的任务分布中进行元强化学习;2)一个参数化的基于注意力的大规模记忆结构策略;3)一个有效的自动课程学习机制,为智能体安排恰当的下一阶段训练任务。尽管训练好的AdA模型可在零样本或少样本条件下完成测试任务,但本质上XLand中的任务具有高度相似性,且均为虚拟环境中的任务,当面向真实应用时,真实世界中本质开放性、强不确定性和大量建模细节将给模型带来巨大挑战。

决策智能算法的通用做法是智能体通过深度强化学习等方法,在虚拟空间中不断与环境交互来学得策略,因此内容丰富的虚拟环境对于提高算法通用能力至关重要。当前,已有大量用于提升智能体决策能力的虚拟环境。OpenAI使用内容动态生成(Procedural content generation, PCG)技术开发的Procgen环境[14],为算法在不同游戏任务下的泛化能力提供了一个测试基准。Facebook提出一个沙盒游戏的环境构建框架MiniHack[15],可以由开发者手动搭建或系统随机生成训练环境。DeepMind搭建的3D多智能体协作和竞争开放环境XLand[16],为具有强大环境适应性的多智能体算法训练提供了多样化任务空间。这些研究使得深度强化学习在逐步开放的环境中得以适用,而虚拟环境的重要性使得人工智能三要素“算法、算力和数据”在决策智能研究中变为“算法、算力和环境/模型”。但如前所述,上述环境的边界仍为虚拟世界内的简单边界,无法覆盖真实世界任务的复杂性。

因此,总体来说,相比感知智能大模型,决策智能大模型刚刚起步,且当面向真实环境时,模型的适用性将受到极大考验。

决策智能大模型为何更具挑战

相比于感知大模型,决策大模型更具挑战,当前尚处于初步探索阶段。究其本质原因,首先在于决策范式难以统一表达。感知大模型处理的对象相对具有统一的表达手段,例如图像统一采用像素表达、文本统一采用编码表达、语音统一采用声频信号表达,在统一进行信号级表达后即拥有了大模型统一处理的基础;但决策问题千差万别,有个体决策、也有群体决策,有抽象问题、也有现实问题,当前尚没有对决策问题的统一建模、表达和处理范式。无论是Gato还是AdA,均采用大语言模型中的核心部件Transformer作为模型内核,这类模型在处理语言信号时表现优异,但在刻画决策问题时的性能尚需进一步验证。其次,决策是相比感认知更上层的任务,相对难度更大。当前大模型主要处理感认知问题,借助人机交互辅助人做决策,而决策智能则旨在让机器自主决策,如单体与集群无人系统中的自主决策,任务本身难度更大。此外,同样由于信号的可统一表达性,当前我们在图、文、音领域已形成大量优质训练样本,理论上互联网中一切可获取到的数据均可用于训练,相比之下,决策智能领域尚未建立类似数据样本集。尽管强化学习等方法为无需样本、而是从与环境的交互中获取数据提供了有效手段,但随之而来的环境建模合理性、准确性等问题产生了新的挑战。

决策智能大模型发展思路

一是延续当前预训练思路继续深化研究。采用Transformer等基础模型框架,这是一种在短期内极有可能快速见效的思路。大语言模型等预训练大模型已经大获成功,Gato、AdA等决策大模型也方兴未艾,这类模型均采用预训练思路,通过构建巨大的神经网络模型、并在大量样本上充分训练来表征难以精确量化的内在推理逻辑。这种“大力出奇迹”的范式虽不够“优美”,但ChatGPT产生的性能突变确实让我们看到了这类大模型在复杂问题表达和求解上的能力,尽管当前阶段尚有大量问题无法解释而只能简单归结为巨大参数条件下的行为“涌现”。可以预见,这类范式将成为未来短期内的主流,且能够在各垂直应用领域取得应用表现上的进展。一个亟待解决的难题是,如何保证在虚拟环境中训练的智能体能够在真实环境中表现良好,即实现虚拟向真实迁移(Simulation to Reality, Sim2Real),Sim2Real问题有多种解决路径,其研究刚刚起步,是保障决策智能大模型实际落地的关键。

二是另辟蹊径深入探索智能本质机理。这是一种需要长期探索、但有可能产生本质颠覆的思路。ChatGPT这类大模型尽管表现突出,但无法实现概念知识的自动提取和推理,这与人的认知逻辑具有显著不同(尽管尚无法评判高低)。从本质来看,人类社会是建构在一系列概念范畴及其相互关系之上的,如在哲学基础框架上,通过引入不同概念从而衍生出经济学、法学等不同社会科学范畴,这与大参数表征、大数据训练的大模型思路显著不同。因此,如何综合运用多学科理论分析工具,探索智能产生的本质(或阶段本质)机理,是需要长期坚持的研究思路。坚持这一思路的必要性还在于,ChatGPT这类大模型的一个潜在风险在于,其“大力出奇迹”范式可能因短期内表现“过好”而“锁死”某一学科的研究进展(暂且“夸张”地类比为三体世界中的“智子”),进而在长期来看阻滞其发展,因此我们应一方面高度重视大模型带来的颠覆性变革,另一方面坚持百花齐放、继续探索智能本质机理,并在各基础领域做好相应理论和工程铺垫。

四、大模型技术应用展望

大模型极大推动了科研范式创新和成果体系革新,其意义深远、应用广泛。在此仅抛砖引玉,提出几方面展望。

(1)虚拟想定场景生成

强化学习等AI方法为不显式依赖数据、而在与环境交互中实现智能进化提供了手段,“算法+算力+环境”成为这一范式的核心要素,因此虚拟环境的有效生成至关重要。大模型在商用领域推动了AIGC发展,相似地,在博弈推演领域,可依托大模型强大的内容生成能力,实现虚拟推演想定的场景生成。

(2)人机混合智能推演

大模型为人机自然、高效互操作、互理解提供了重要媒介,为人的经验、偏好、直觉、常识等具有高度抽象和良好可解释性的知识与机器可精确量化表达的数据驱动范式建立了相互融合的桥梁。研究人机高效混合推演方法,正向将人的经验、偏好等转化为机器指令,反向将机器的量化推理结果进行可解释性表达,其本质是知识与数据两类范式的协同驱动[17]。

(3)特定领域专用大模型

当前预训练大模型在通用问题上已具备较强的认知推理能力,但由于缺乏训练样本,其在特定专用领域表现尚显不足。为此,应超前布局,充分发挥理技融合体制优势,融合科研部门、工业部门和各应用部门力量,研发面向特定领域的专用大模型。探索领域内的人工数据采集、标注方法,形成面向特定领域的大规模专用数据集,为大模型在特定智能领域应用奠定基础。

(4)虚实迁移的决策智能

决策智能是当前指挥控制中的核心,深度强化学习等方法为智能体自主学习进化提供了有效手段,但由于其训练是在虚拟环境中实现的,虚实迁移是当前技术手段的关键瓶颈。应发展从虚拟向实体迁移的博弈决策智能技术,拓展算法在应对不确定性和开放问题中的适用边界,为大模型在真实物理环境中的鲁棒应用提供关键支撑。

(5)大模型开放创新生态

开源开放是推动人工智能发展的重要手段。在开源方面,国外Pytorch、Tensor及国内大厂推出的系列开源平台,为人工智能算法快速发展奠定了基础;在开放方面,自2018年以来,我国在各细分行业认定了一大批人工智能开放创新平台,旨在以数据、接口、服务等方式为学界、个人开发者、小微用户提供AI模型便捷使用工具。而大模型的发展,将模型构建方法工具的统一推进到模型本身的统一,因此应以大模型为契机,重新梳理构建开放创新生态,形成既充分开放、又可赋能一大批应用的算法服务平台,实现概念、技术先行,牵引体系智能发展的新范式。

审核编辑 :李倩

-

数据采集

+关注

关注

39文章

6121浏览量

113689 -

AI

+关注

关注

87文章

30946浏览量

269196 -

自然语言处理

+关注

关注

1文章

618浏览量

13562 -

ChatGPT

+关注

关注

29文章

1562浏览量

7701

原文标题:大模型技术发展研判及应用思考

文章出处:【微信号:AI智胜未来,微信公众号:AI智胜未来】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

【「大模型启示录」阅读体验】对大模型更深入的认知

Kimi发布视觉思考模型k1,展现卓越基础科学能力

纳微半导体亮相2024亚洲电源技术发展论坛

直流高压电源技术发展浅析

开关电源的最新技术发展趋势

智能驾驶技术发展趋势

无线充电技术发展趋势

【大语言模型:原理与工程实践】大语言模型的应用

【大语言模型:原理与工程实践】探索《大语言模型原理与工程实践》

张宏江深度解析:大模型技术发展的八大观察点

岩土工程中的振弦采集仪技术发展与前景展望

大模型技术发展研判及应用思考

大模型技术发展研判及应用思考

评论