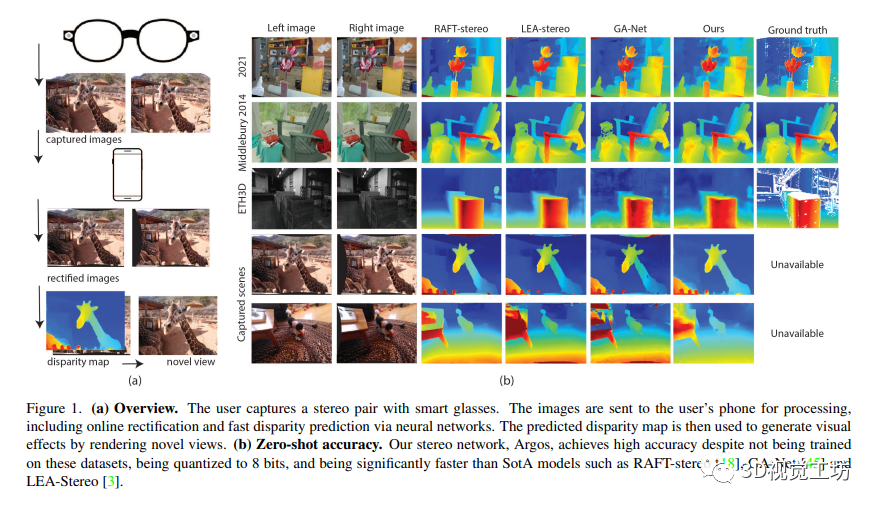

本文提出了一种生产化的端到端立体深度感知系统设计,可以完成预处理、在线立体校正和立体深度估计,并支持纠偏失败后的单目深度估计备选方案。同时,该深度感知系统的输出应用于一种基于智能眼镜拍摄的视角生成管道,创造出具有3D计算摄影效果的视觉效果。此外,该系统设计可以在手机的严格计算预算内运行,具有通用性,可以适用于各种品牌的智能手机。该论文的设计是为了解决智能眼镜中的深度感知问题,可以为智能眼镜提供更好的增强现实体验。

1 前言

本文介绍了一种生产化的端到端深度感知系统,包括预处理、在线立体校正、立体深度估计并支持单目深度估计的备用方案。该系统的输出结果应用于视角生成的渲染管道,创建具有3D计算摄影效果的效果。该系统设计具有通用性和稳健性,可以用于不同品牌的主流手机。

我们的技术和系统贡献包括:

详细描述了一个端到端的立体系统,并提供了小心的设计选择和备用方案,这些策略可以成为其他类似深度系统的基线;

引入了一种新的在线校正算法,具有快速和稳健的特点,有助于提高立体视觉的准确性;

提出了一种新颖的策略,共同设计立体网络和单目深度网络,使两个网络的输出格式相似,从而更好地利用他们的结构信息;

证明了在计算预算有限的情况下,本文的量化网络实现了竞争性的准确度,可以应用于计算资源有限的场景。

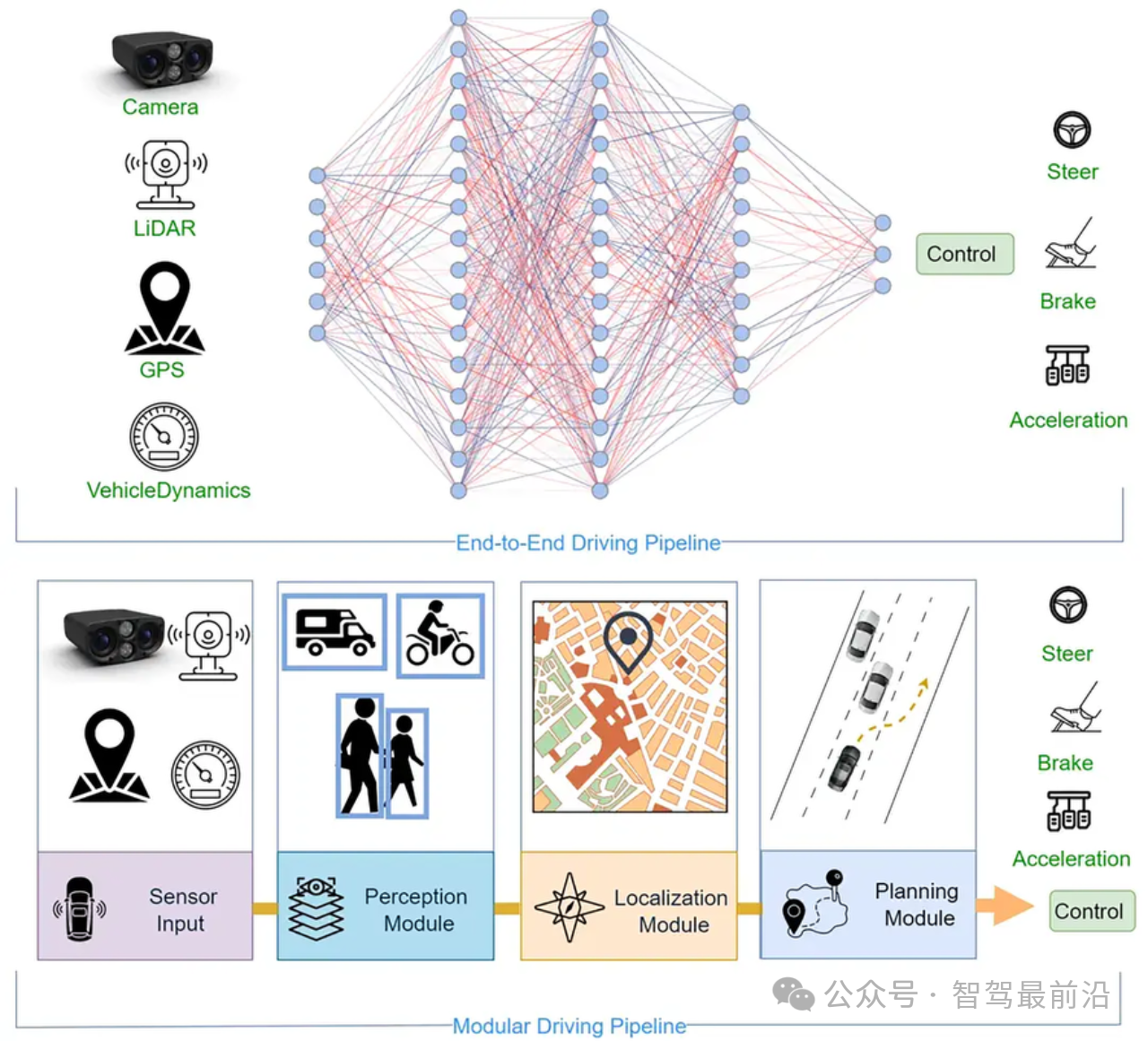

2 相关背景

本文关注于构建用于灵活智能眼镜的完整立体系统,该系统具有鲁棒性和轻量化处理,能够在线校正,具有用于提显和3D效果等功能。现有工作多集中在系统的某些组件,很少有文章着眼于整个系统设计。对于在线立体校正,因为几乎所有实际立体系统都存在校正问题,研究者尝试了一些方法,其中的一个是在匹配代价中只利用水平梯度或使用包含小的垂直视差样本进行匹配代价训练等。对于单目深度估计,有监督和无监督方法都被用于深度学习中,输出通常是相对深度/视差。对于立体深度估计,最近的研究中,立体匹配的特征学习通过深度学习进行替代,目前主要关注于端到端学习,有2D CNNs、3D CNNs和RNNs等三种类型的架构。其中RNN方法得到最先进的性能,但无法在设备上运行,近期的工作则尝试着使立体网络在设备上运行更快。

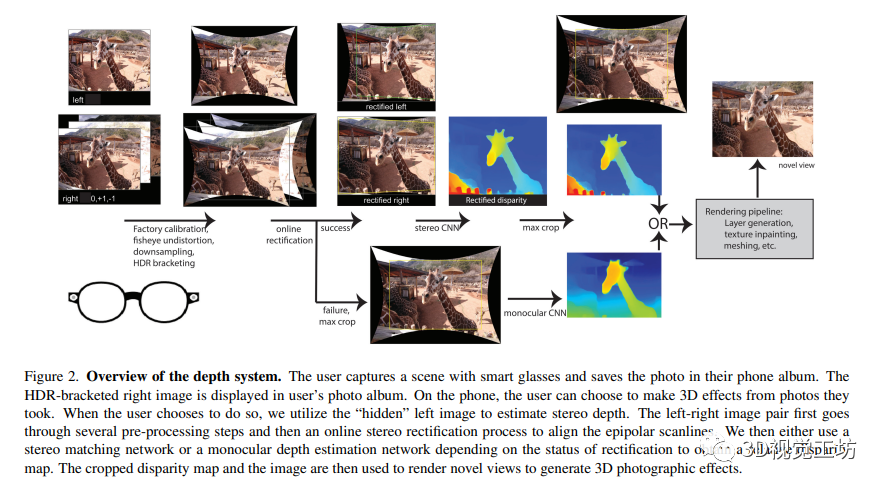

3 系统概述

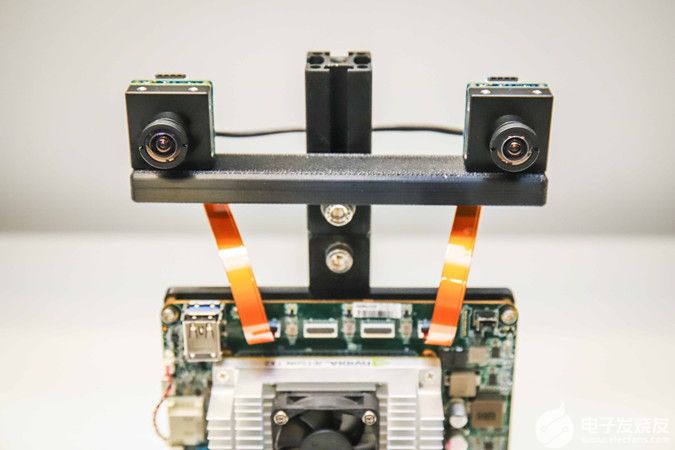

本文提出了一种基于智能眼镜的深度感知计算摄影系统。该系统配备一对硬件同步的鱼眼相机,可拍摄场景图像并将其传输至智能手机进行进一步处理。作者使用在线校准和校准算法估计外部和内部参数进行准确的校准,使用相对视差来创建深度计算摄影效果,并通过共享数据集训练两个网络以实现相同的下游处理。最终,预测的视差和相应的图像被传递到渲染流水线,以创建最终的三维效果。

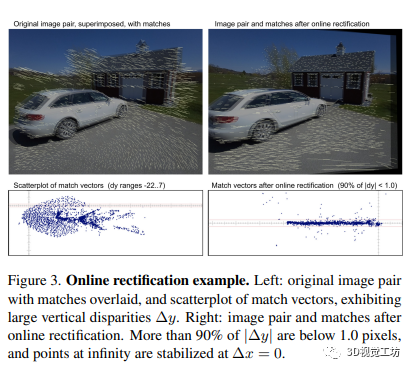

4 在线校正

根据输入的鱼眼图像,通过计算精确的对应特征点,然后在原始图像和重新校正后的图像中保持世界坐标系与立体系统相对,来估计两个摄像机的旋转角度,从而进行在线校正。此方法通过估计相对尺度来补偿焦距随温度的变化,最终使得双视图立体算法更加准确和鲁棒。其中,相对俯仰角是相对的,而绝对俯仰角是一个自由参数。

4.1 Projection model - 投影模型

该部分内容介绍了通过投影模型计算两张图片中点的相对位置和姿态。其中,对内参矩阵和径向畸变进行了校正。通过将点投影到不同的相机中并估计其在两张图片中的深度,可以计算相机之间的相对方向和绝对的旋转和偏航。通过引入尺度修正,可以进一步约束相机之间的相对高度。

4.2 Rectification algorithm - 矫正算法

该算法通过使用Harris角点和层次亚像素ZSSD特征匹配器在图像间匹配特征点,并配合使用鲁棒最小二乘法求解方程组来实现对图像的矫正。该算法能够可靠地提取到特征点并计算出矫正角度。算法采用四个参数模型,包括∆ωx、∆ωy、∆ωz和∆f ,并且通过内点控制实现超约定系统的求解。对于每个匹配,它的表现很稳定并产生了很好的结果。

5 Co-design of monocular and stereo networks - 单目和立体网络的联合设计

本文提出了一种新的方法来协同设计立体和单目深度网络,以使其输出具有一致性,轻量级并且尽可能精确。该方法通过将单目深度网络训练为预测相对深度和相机运动,而不是绝对深度,来保持输出格式的一致性。接着,作者设计了一个立体网络,使用相同的特征提取器来预测相对视差。为了保持一致性,作者还使用了可训练的缩放和偏移参数,并使用一个损失函数来同时考虑单目和立体网络的输出。该方法在联合训练中表现出很好的稳定性和精度。

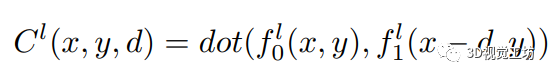

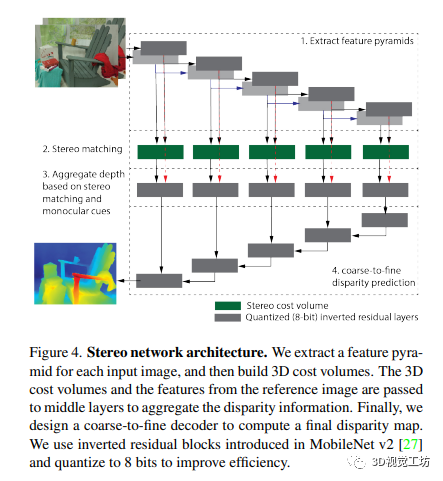

5.1 Stereo network - 立体网络

作者设计了一个立体视网络,其组件灵感来源于经典的和深度的立体视方法:

一个编码器,从输入的立体图像中独立提取多分辨率特征和特征 ,其中 l = 1 … L,用于 L 层特征金字塔。

利用余弦距离比较左右特征距离的三维代价体

使用许多中间层将代价体和参考图像的图像特征作为输入,并汇总视差信息。因为中间层直接从代价体和参考图像获取信息,所以它们可以在立体匹配线索较弱(例如在无纹理区域)或缺失时(例如在半遮挡区域)更好地利用单眼深度线索。

粗到细解码器以预测输出视差图。输出视差图的分辨率与输入右图像相同。每个解码器模块结合低分辨率解码器模块的输出和相同分辨率中间层的输出。

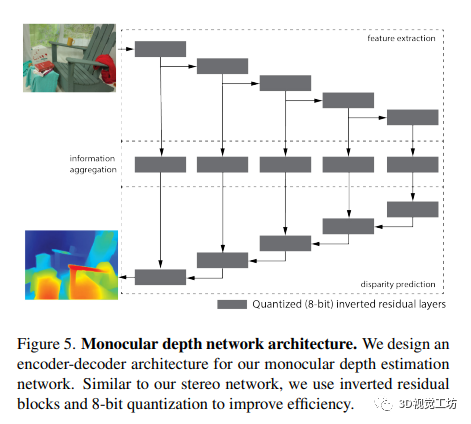

5.2 Monocular network - 单目网络

我们设计了一个单目深度估计网络,其包含三个组件:

用于提取多分辨率图像特征f_l=1...L的编码器;

中间层用于聚合深度信息;

粗到细的解码器用于预测视差图。

5.3 Shared network components - 共享网络组件

作者研究了单目深度估计和立体视觉之间的联合训练,从而提高了深度估计的质量。在共享网络组件方面,该文使用相同的编码器、中间层和解码器,同时使用立体代价体模块,从而提高网络的表现。为了提高效率,文章使用反向残差模块进行所有层的量化,并将权重和激活量化为8位。同时,输出层保持为32位来获得亚像素分辨率。其损失函数使用平滑L1损失和梯度损失项来训练网络。

5.4 Novel training datasets - 新型训练数据集

本文提出了一种通过渲染内部单目数据集来获得立体数据集以进行联合训练的方法。为了使立体数据集具有逼真性和挑战性,作者对其进行了数据增强(亮度、对比度、色相、饱和度、jpeg压缩等),并在遇到高光反射和无效区域(由深度流水线中的变形和矫正引起)时进行了训练,使网络能够忽略这些干扰。文章还探讨了简化立体数据集生成的方法,使得该数据集比任何现有的训练数据集都更具多样性。

6 Novel view synthesis - 新视角合成

本文采用基于LDI的方法来实现新视角合成。对于立体数据集的创建,使用单目真实深度和彩色图像来创建纹理网格,并渲染第二个视角。对于3D效果,使用来自立体系统的预测和预定义的轨迹来生成平滑的新视角视频。其中LDI是层深度图,可以通过LDI修复插值法推测被遮挡的几何形状。

7 实验

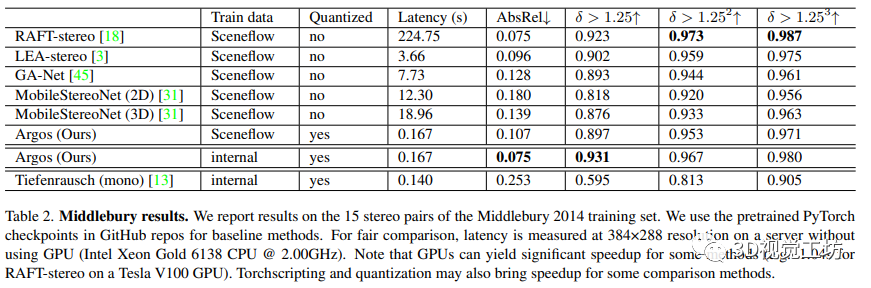

在本文中,作者介绍了一种新的立体视觉深度估计方法,即使用共享编码器、中间层和解码器的高效单目网络Tiefenrausch和附加的成本体积模块来构建立体网络Argos。对于生产模型,作者使用4M内部iPhone数据集重新训练了Tiefenrausch,并使用FBGEMM后端进行量化感知训练(QAT),从而实现了高精度。作者还使用Sceneflow数据集进行了对比实验。

作者在三星Galaxy S8 CPU上对流水线进行了基准测试。校正流水线需要300-400ms,立体网络需要大约965ms。流水线的其他部分总共需要比这两个步骤更低的延迟。作者的模型经过了移动CPU优化,但将SotA模型转换为移动友好的格式并不容易,也不是非常有意义,因为它们并不是为移动设备设计的。为了权衡,作者在Intel(R) Xeon(R) Gold 6138 CPU @ 2.00GHz的计算机服务器上比较所有模型的运行时间。

本文在Middlebury 2014数据集上对作者的方法与几种SotA立体方法进行了定量比较。作者的方法在速度上快于其他方法,并且实现了与SotA方法相当的性能。通过使用内部渲染的立体数据集进行训练,作者的性能进一步提高,并实现了最佳的绝对相对误差。作者新设计有效地从单目数据集呈现了立体数据集以训练模型。虽然作者的设计选择可能在Middlebury等基准测试上导致精度下降,但作者追求的是设计一个稳健的端到端深度系统。作者的量化8位立体模型是首次提出的,比较模型都使用32位权重和激活。尽管存在一些不利因素,但作者还是实现了与SotA方法相当的性能,并且运行速度更快。

本文描述了一项针对3D照片质量的调查。通过渲染深度系统的新视角视频进行调查,参与者对视频质量进行评分。研究结果表明,立体声得分的平均分数为3.44,单目深度得分的平均分数为2.96。结果显示,深度图质量有时与渲染的新视角视频的质量并不直接相关。作者强调了仅使用标准指标来比较方法是不足以评价立体声方法在实践中的表现的

8 结论

本文介绍了一种端到端的立体深度感知系统的设计,可以在智能手机上高效运行。该系统包括了一个在线矫正算法、单目和立体视差网络的协同设计,以及从单目数据集中提取大型立体数据集的新方法。作者还提出了一个8位量化的立体模型,与最先进的方法相比,在标准立体基准测试中具有竞争性能。

-

智能手机

+关注

关注

66文章

18483浏览量

180134 -

感知系统

+关注

关注

1文章

70浏览量

15941 -

智能眼镜

+关注

关注

8文章

652浏览量

72797

原文标题:CVPR2023 I 一种实用的智能眼镜深度感知系统

文章出处:【微信号:3D视觉工坊,微信公众号:3D视觉工坊】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

移动协作机器人的RGB-D感知的端到端处理方案

一种基于端到端基于语音的对话代理

基于深度神经网络的端到端图像压缩方法

端到端的深度学习网络人体自动抠图算法

一种端到端的立体深度感知系统的设计

一种端到端的立体深度感知系统的设计

评论