电子发烧友网报道(文/莫婷婷)随着大模型智能水平的提升,AIGC所需要的算力也在不断增长。根据OpenAI的研究,AI训练所需算力指数增长,且增长速度超越硬件的摩尔定律。燧原科技创新研究院负责人、首席科学家姚建国教授认为,算力分为需求、场景,还有芯片和系统四个层次。算力需求的变化给AI芯片以及系统都带来了一定程度的挑战。

多家厂商发布垂直类大模型,AIGC落地场景逐渐清晰

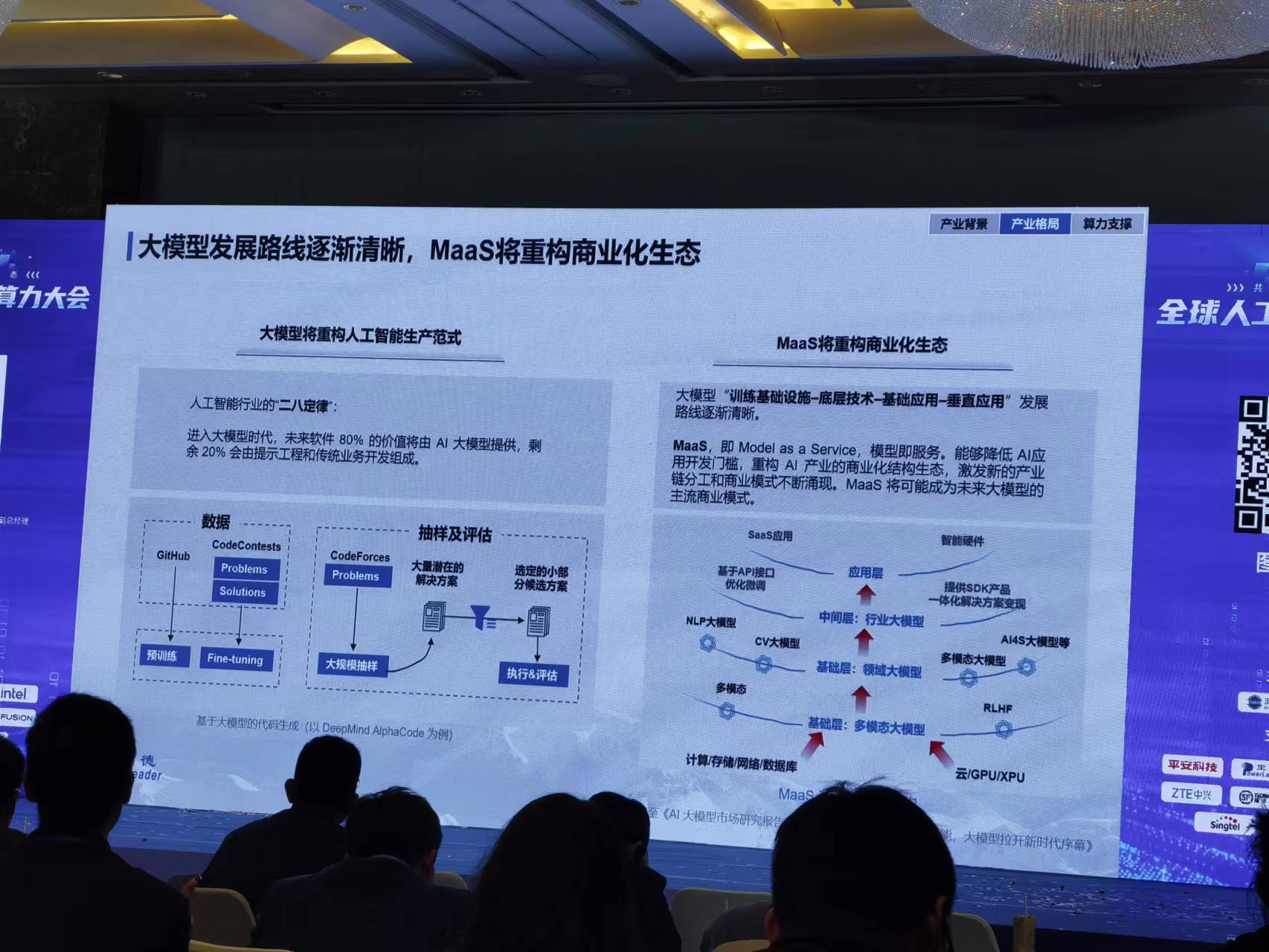

随着各大公司对AIGC研究的不断深入和技术投入,国内外厂商积极推出属于自己的类ChatGPT模型,例如华为的“盘古”,商汤的“日日新”、深兰科技的“硅基知识”、出门问问的“序列猴子”、深信服的“安全大模型”等等大模型。这么多的大模型,若是放在两年前,业内人士可能会头疼于它的落地场景。

得益于ChatGPT的出现,业内人士看到了更多AIGC落地的可能性,并且推动AI行业进入AIGC时代。百度创始人、董事长兼CEO李彦宏近期公开演讲时就表示,“大模型即将改变世界”。

那么,大模型究竟会如何改变世界呢?这还得从落地场景看。目前,AIGC的典型应用分为文生文、文生图、文生视频。近期中国市场开放一些文生文的应用越来越多,具体的应用包括对话式功能,还支持搜索和营销的场景。

尽管国内厂商还未推出像GPT-4如此强大的通用模型,但是在垂直领域的人工智能大模型却迎来飞跃式的发展,并且有着巨大的想象空间。正如李彦宏提到的,每一个行业都应该有属于自己的大模型。未来技术跟业务深度融合是AIGC发展的最终方向。

算力需求变化带来系统级创新

谈及大模型对算力的需求,姚建国教授表示,AIGC智算中心可以分为三类大模型:基础大模型、场景大模型和应用大模型。

基础大模型通过巨大的算力生成,然后通过预训练算力、超大训练算力支撑,例如ChatGPT。场景大模型是在大模型基础进行调优,通过Fine Tune算力支撑,可以适应不同场景,也就能赋能到不同行业,可以引用一些普惠训练算力。应用大模型主要是通过推理算力,包括云端推理和端侧推理。

对于芯片的需求,基础大模型和场景大模型分别需要大算力训练芯片和中算力训练芯片,且对机器之间的数据互联带宽有较高的要求,都需要高速芯片互联。而应用大模型只需要云端推理算力,且可以使用分布式/单机训练和推理,是性价比较高的大模型之一。

算力肉眼可见地不断增长,燧原科技姚建国教授在公开演讲时也提到了一组数据:从2012年到2018年,训练AI算力增长了30万倍,摩尔定律相同时间通用算力只有7倍的增长。从这里可以看出AIGC对算力需求之高。

算力需求变化带来了三大问题,一是存/算性能失配,内存墙导致访存时延高、效率低;二是冯诺依曼架构下,功耗墙导致传输能耗损失;三是满足大模型需求,性能墙导致算力无法满足。姚建国教授表示,未来不仅仅是单核芯片去解决算力问题,一定会是通过一个系统级解决方案去实现整个算力适应变化。

目前,单独的服务器、集群难以解决大模型的预训练,因此需要有大算力加速,比如说H100提供了Transformer引擎;此外还有机密计算、COP互联加速、CXL协议等等各方面的创新。业内人士普遍认为,系统级创新会是未来的发展趋势

对于大模型未来的发展趋势,IDC中国首席分析师武连峰认为,AI大模型应用深化,从专属AI到通用AI,会是趋势之一。当然,最终实现通用AI的道路还有很长。

-

AIGC

+关注

关注

1文章

352浏览量

1470

发布评论请先 登录

相关推荐

大模型时代的算力需求

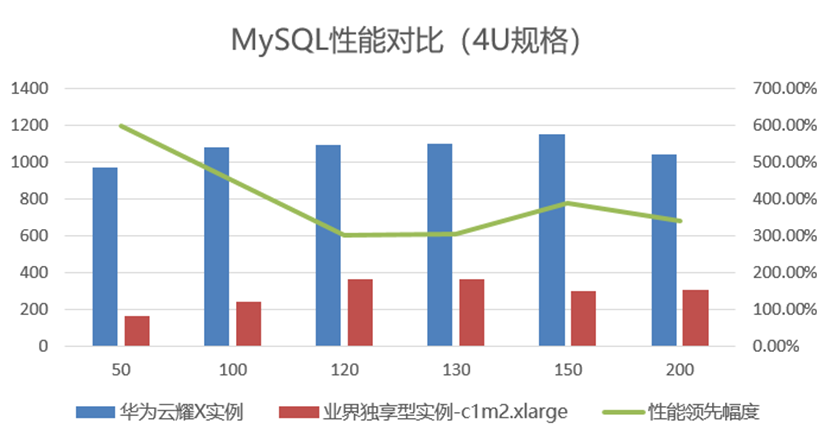

云耀 X 实例:下一代柔性算力新物种,双倍性能加速跃级体验

【算能RADXA微服务器试用体验】Radxa Fogwise 1684X Mini 规格

大模型对算力需求指数级增长,集群成必然选择

算力大升级 英特尔至强可扩展处理器持续技术创新

燧原科技与青云科技达成战略合作,创新异构算力调度

探索AIGC未来:CPU源码优化、多GPU编程与中国算力瓶颈与发展

AIGC加速成长,算力需求变化带来系统级创新

AIGC加速成长,算力需求变化带来系统级创新

评论