芯东西 5 月 22 日报道,生成式 AI 的日益火爆,正对数据中心内存性能提出更加苛刻的要求。无论是云端 AI 训练还是向网络边缘转移的 AI 推理,都需要高带宽、低时延的内存。迈向高性能 GDDR6 内存接口已是大势所趋。

近日,推出业界领先 24Gb/s GDDR6 PHY 的美国半导体 IP 和芯片供应商 Rambus,其两位高管与芯东西等媒体进行线上交流,分享了 Rambus 在 GDDR6 领域的技术创新及行业发展趋势。

"ChatGPT 等 AIGC 应用与我们公司的产品组合是非常契合的。"Rambus 大中华区总经理苏雷说,Rambus China 立足于中国市场,愿意更多、更紧密地支持中国公司在 ChatGPT 产业的发展,为他们保驾护航,"Rambus 面对中国客户的需求,有最好的技术、最快的响应和最好的技术支持来服务中国市场。"

据 Rambus IP 核产品营销高级总监 Frank Ferro 分享,AI 推理应用对带宽的需求通常在 200 到 500Gb/s 的范围之间波动,每一个 GDDR6 设备的带宽都可以达到 96Gb/s,因此通过将 4-5 个 GDDR6 设备组合在一起,就能轻松满足 500Gb/s 及以下的带宽需求。

他谈道,如果用到一个 HBM3 设备,基本上会把这个带宽需求的数字翻倍,能够达到接近 800Gb/s 的带宽,而这超过了 AI 推理本身所需要的 400 到 500Gb/s 带宽,会使成本增加 3~4 倍。在这种条件下,HBM 并非一个经济高效的选择,GDDR6 则是一个更好的替代。

他建议按需选择 HBM 或是 GDDR6 内存,对于对高带宽和低延迟有很高要求的 AI 训练场景,HBM 可能是更好的选择;对于需要更大容量、更高带宽的 AI 推理场景,GDDR6 会是更合适的选择。

高性能内存和互连方案,支持下一代数据中心发展

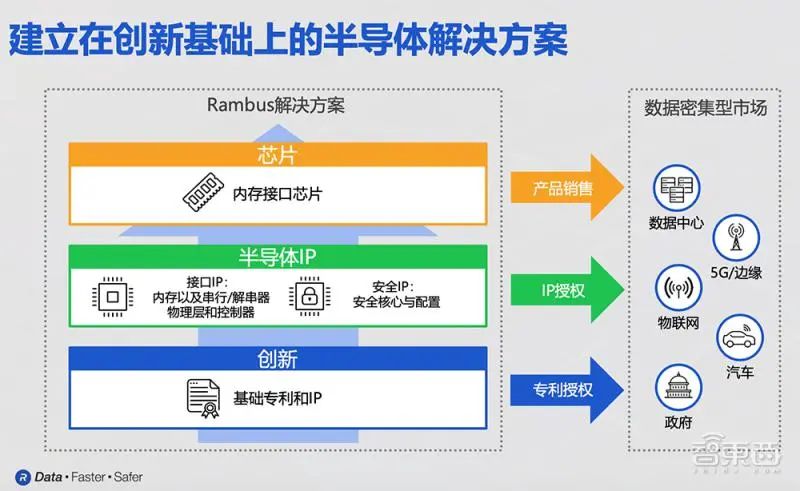

Rambus 大中华区总经理苏雷谈道,Rambus 主要业务包含基础专利授权、芯片 IP 授权和内存接口芯片。其中芯片 IP 又主要分为接口 IP 和安全 IP。其技术和产品面向数据密集型市场,包括数据中心、5G、物联网 IoT、汽车等细分市场,后续还将推出 CXL 家族各产品组合芯片。

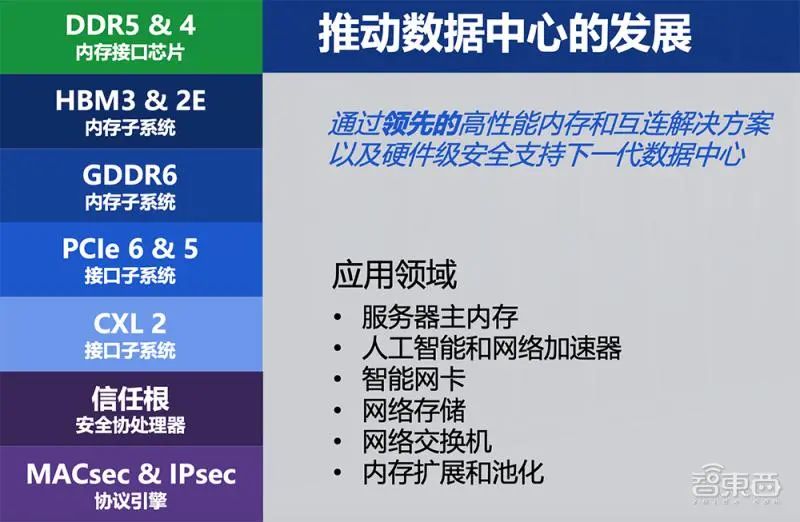

面向数据中心,Rambus 非常注重产品和方案的易用性,通过一站式的解决方案以及完善的服务机制,使产品方案变得更易在客户端集成使用。Rambus 陆续推出了各内存子系统、接口子系统,提供业界领先、可靠的数据传输。其 GDDR6 接口子系统率先实现高达 24Gb/s 的内存接口数据速率,并能为每个 GDDR6 内存设备提供最高达到 96Gb/s 的带宽。

Rambus 的内存接口芯片产品不断提高数据中心内存模块的速度和容量,同时它拥有非常丰富而全面的安全 IP 产品线,对用于静态数据以及动态数据安全保护都有着专门安全的产品方案。

总体来说,Rambus 通过领先的高性能内存和互联解决方案以及硬件级安全,支持下一代数据中心的发展。其产品应用领域聚焦于服务器主内存、人工智能和网络加速器、智能网卡、网络存储、网络交换机以及内存扩展和池化等。

内存是未来 AI 性能的关键

Rambus IP 核产品营销高级总监 Frank Ferro 着重分享了迄今市场推动高性能需求的主要驱动力,以及未来如何更好满足 AI 性能需求。

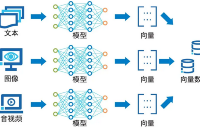

数据需求依旧呈现上涨趋势。ChatGPT 等 AI 相关应用快速发展,对内存带宽需求旺盛,因此市面上越来越多公司开始专注于开发自己个性化、定制化的处理器产品,以更好地满足神经网络以及专属应用的需求。

Frank Ferro 强调说,尽管算力增长非常显著,但带宽的进步与之并不匹配,即现有高算力的基础之上,很多的 GPU 资源其实并没有得到充分的占用和利用,这造成了现在的困境。

AI 训练环节需要录入大量数据进行分析,需要消耗大量算力。AI 推理环节对算力的需求会大幅下降,但对成本和功耗更加敏感。Frank Ferro 谈道,一个重要趋势是 AI 推理越来越多地向边缘设备上进行集成和转移。在这个变化过程中,拥有更高带宽、更低时延特性的 GDDR6 方案,能够帮助边缘端更好地处理数据。

对带宽需求进一步的增加,驱动了像 Rambus 这样的公司不断地在去打造更加新一代的产品,不断地提高内存带宽以及接口带宽的相关速度。

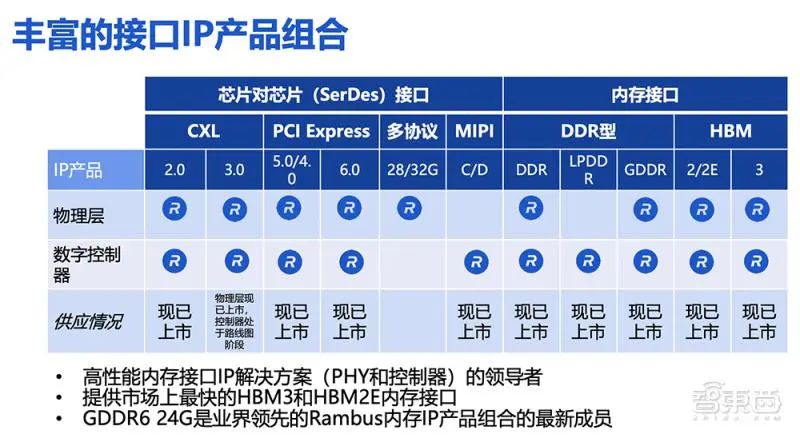

GDDR6 能够提供 AI 推理所需的内存性能

Rambus 有着丰富的接口 IP 产品组合,同时也提供像 DDR、LPDDR 以及 HBM 等产品,并非常关注 SerDes 产品的开发,主要聚焦于 PCIe 和 CXL 接口,会开发配套的 PHY 及控制器。Rambus 的 HBM 产品拥有领先的市占率,同时其 HBM3 产品已经能够提供高达 8.4Gbps/s 的数据传输速率。

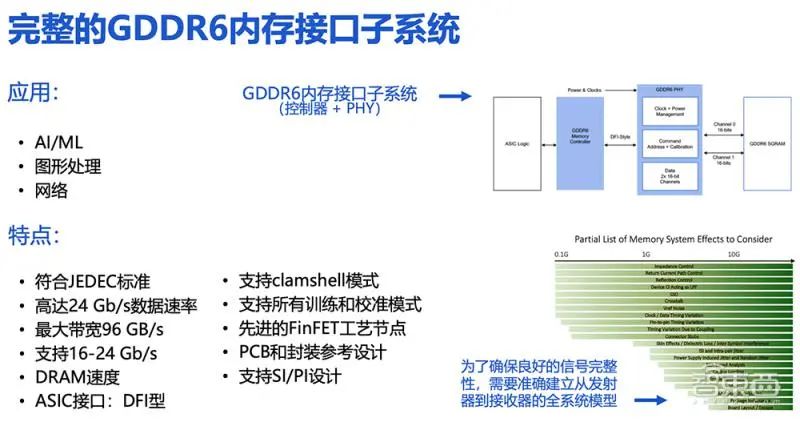

其全新 GDDR6 PHY 及控制器的配套产品已达到业界领先的 24Gb/s 的数据传输速率,可为 AI 推理等应用场景带来巨大性能优势和收益。此外,该产品在功耗管理方面优势明显,并实现了 PHY 以及控制器的完整集成,即客户收到产品后,可以直接对其子系统进行定制化应用。

如图是 GDDR6 内存接口系统,Rambus 提供的是中间标蓝的两个重要环节,也就是完整的子系统。Rambus 会根据客户具体应用场景和实际的诉求对子系统来进行优化,并将其作为完整的子系统来交付给客户。

clamshell 模式指每个信道可支持两个 GDDR6 的设备。换句话说,在 clamshell 模式之下,整个容量是直接翻倍乘以 2 的。值得一提的是,GDDR6 现已支持先进的 FinFET 工艺节点环境。

此外,Rambus 也会针对 PCB 以及封装提供相关的参考设计,同时内部有信号完整度和边缘完整性方面的专家,来帮助客户完成整个设计工作。

市面上很多 GPU 加速器都已经用到 GDDR6。由于在成本和性能之间达到不错的平衡,GDDR6 成为在 AI 应用场景下比较合理的产品和选择。而 Rambus 拥有领先的 SI/PI 专业知识,可以进行早期的协同设计和开发,确保 GDDR6 产品的性能表现,也能更好地去缩短产品的上市时间。

结语:在带宽、成本、方案复杂性之间实现平衡

随着 AI 应用趋于盛行,苏雷谈道,下游厂商首先关注高带宽,并开始关注方案的成本和复杂性,"GDDR 技术是在带宽、成本和方案复杂性的各因素之间提供了一个非常完美的折中技术方案。" 他预计到 2025 年或 2026 年市场上会出现使用 GDDR6 IP 的芯片。

进入全新的 GDDR6 时代,相关产品已开始采用 16 位的双读写通道。双读写通道加起来是 32 位的数据宽度,而 GDDR6 内存有 8 个双读写通道,总共可实现 256 位的数据传输宽度,所以能够显著提高数据传输的速度和效率,系统层效率和功耗管理也能得到进一步的优化。

除了适用于 AI 推理场景外,Frank Ferro 说,GDDR6 也会在图形领域和一些网络应用场景中起到重要作用,能够大幅降低网络边缘设备对 DDR 数量的需求。

审核编辑 :李倩

-

芯片

+关注

关注

456文章

50892浏览量

424343 -

控制器

+关注

关注

112文章

16385浏览量

178380 -

AI

+关注

关注

87文章

31000浏览量

269334

原文标题:【媒体报道】缓解 AI 推理算力焦虑,高带宽 GDDR6 成杀手锏?

文章出处:【微信号:Rambus 蓝铂世科技,微信公众号:Rambus 蓝铂世科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

下一代高端显卡标配,容量和速度双翻倍的GDDR7登场!

冲刺海外高端市场 传音控股也有杀手锏

AI时代核心存力HBM(上)

基站和雷达知识介绍

OpenAI开启推理算力新Scaling Law,AI PC和CPU的机会来了

AI网络物理层底座: 大算力芯片先进封装技术

英伟达推出搭载GDDR6显存的GeForce RTX 4070显卡

成都汇阳投资关于跨越带宽增长极限,HBM 赋能AI新纪元

美光出样业界容量密度最高新一代 GDDR7 显存

如何基于OrangePi AIpro开发AI推理应用

缓解AI推理算力焦虑,高带宽GDDR6成杀手锏?

缓解AI推理算力焦虑,高带宽GDDR6成杀手锏?

评论