代码:https://github.com/Sierkinhane/VisorGPT

论文:https://arxiv.org/abs/2305.13777

论文简介

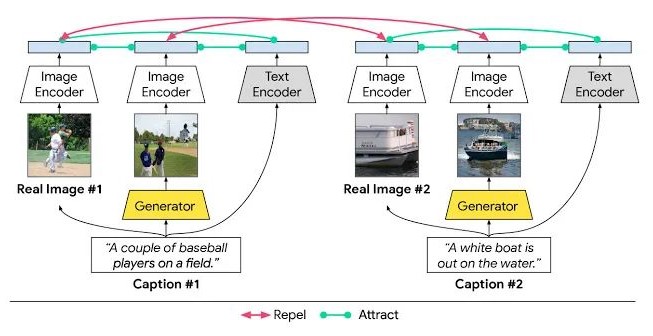

可控扩散模型如ControlNet、T2I-Adapter和GLIGEN等可通过额外添加的空间条件如人体姿态、目标框来控制生成图像中内容的具体布局。使用从已有的图像中提取的人体姿态、目标框或者数据集中的标注作为空间限制条件,上述方法已经获得了非常好的可控图像生成效果。那么如何更友好、方便地获得空间限制条件?或者说如何自定义空间条件用于可控图像生成呢?例如自定义空间条件中物体的类别、大小、数量、以及表示形式(目标框、关键点、和实例掩码)。

本文将空间条件中物体的形状、位置以及它们之间的关系等性质总结为视觉先验(Visual Prior),并使用Transformer Decoder以Generative Pre-Training的方式来建模上述视觉先验。因此,我们可以从学习好的先验中通过Prompt从多个层面,例如表示形式(目标框、关键点、实例掩码)、物体类别、大小和数量,来采样空间限制条件。我们设想,随着可控扩散模型生成能力的提升,以此可以针对性地生成图像用于特定场景下的数据补充,例如拥挤场景下的人体姿态估计和目标检测。

方法介绍

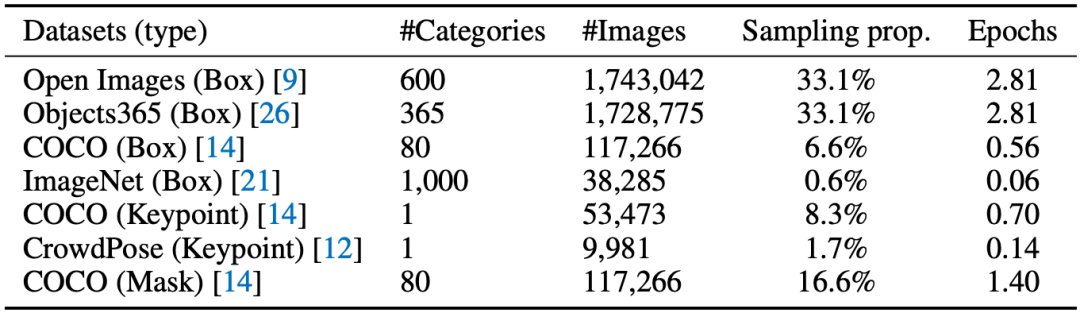

表1 训练数据

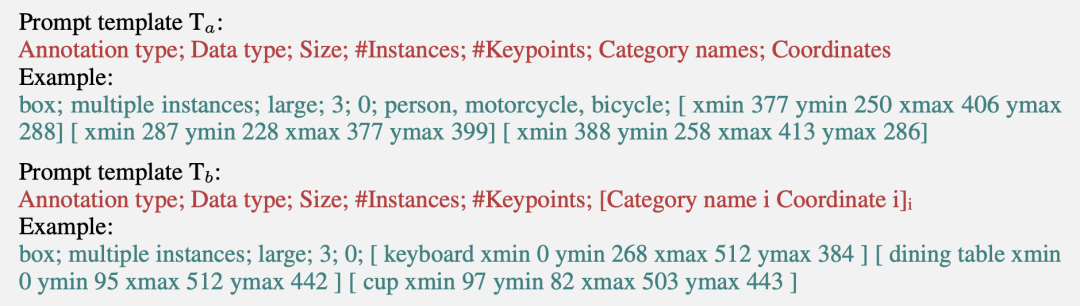

本文从当前公开的数据集中整理收集了七种数据,如表1所示。为了以Generative Pre-Training的方式学习视觉先验并且添加序列输出的可定制功能,本文提出以下两种Prompt模板:

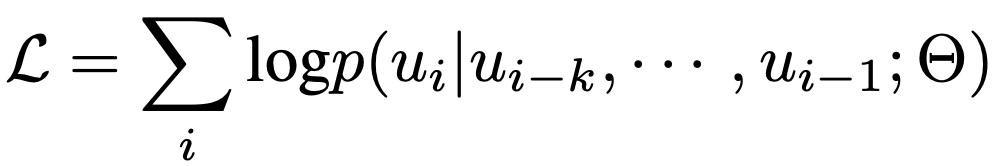

使用上述模板可以将表1中训练数据中每一张图片的标注格式化成一个序列x。在训练过程中,我们使用BPE算法将每个序列x编码成tokens={u1,u2,…,u3},并通过极大化似然来学习视觉先验,如下式:

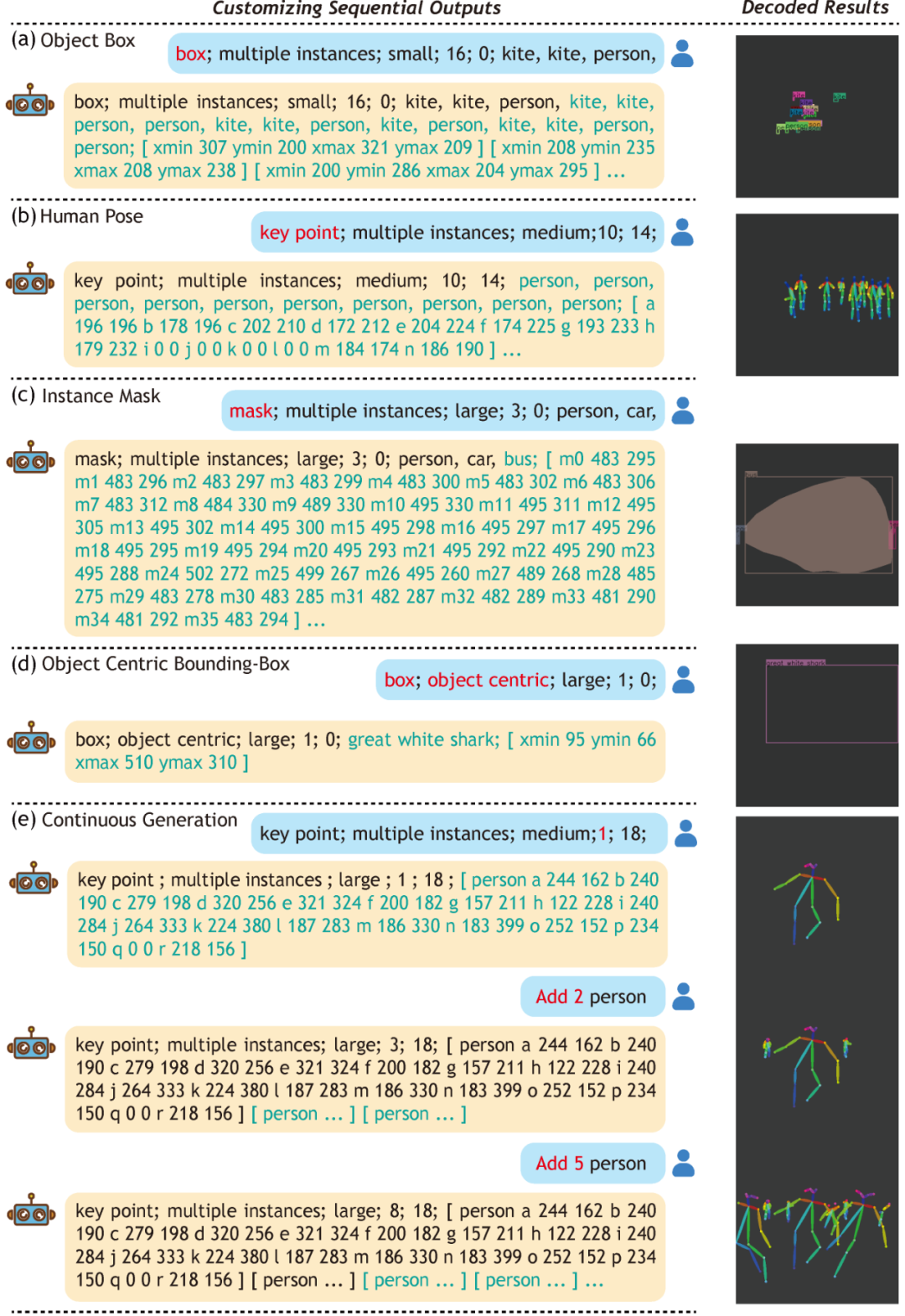

最后,我们可以从上述方式学习获得的模型中定制序列输出,如下图所示。

图1 定制序列输出

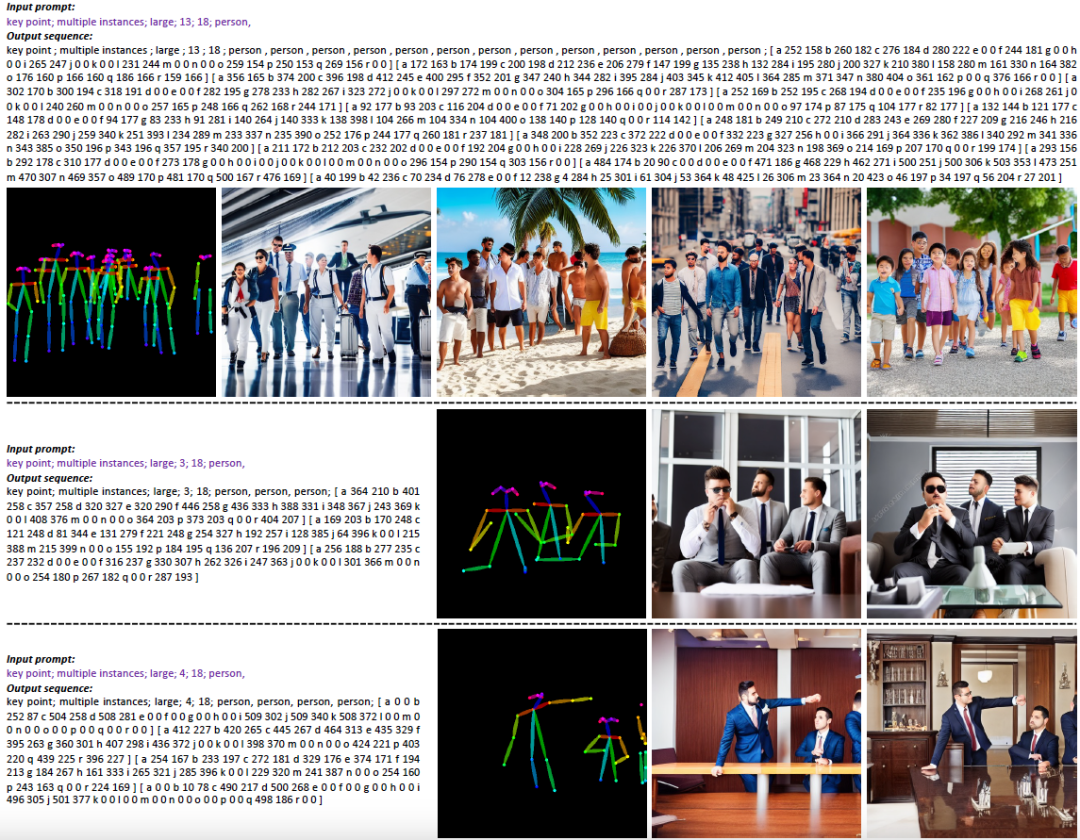

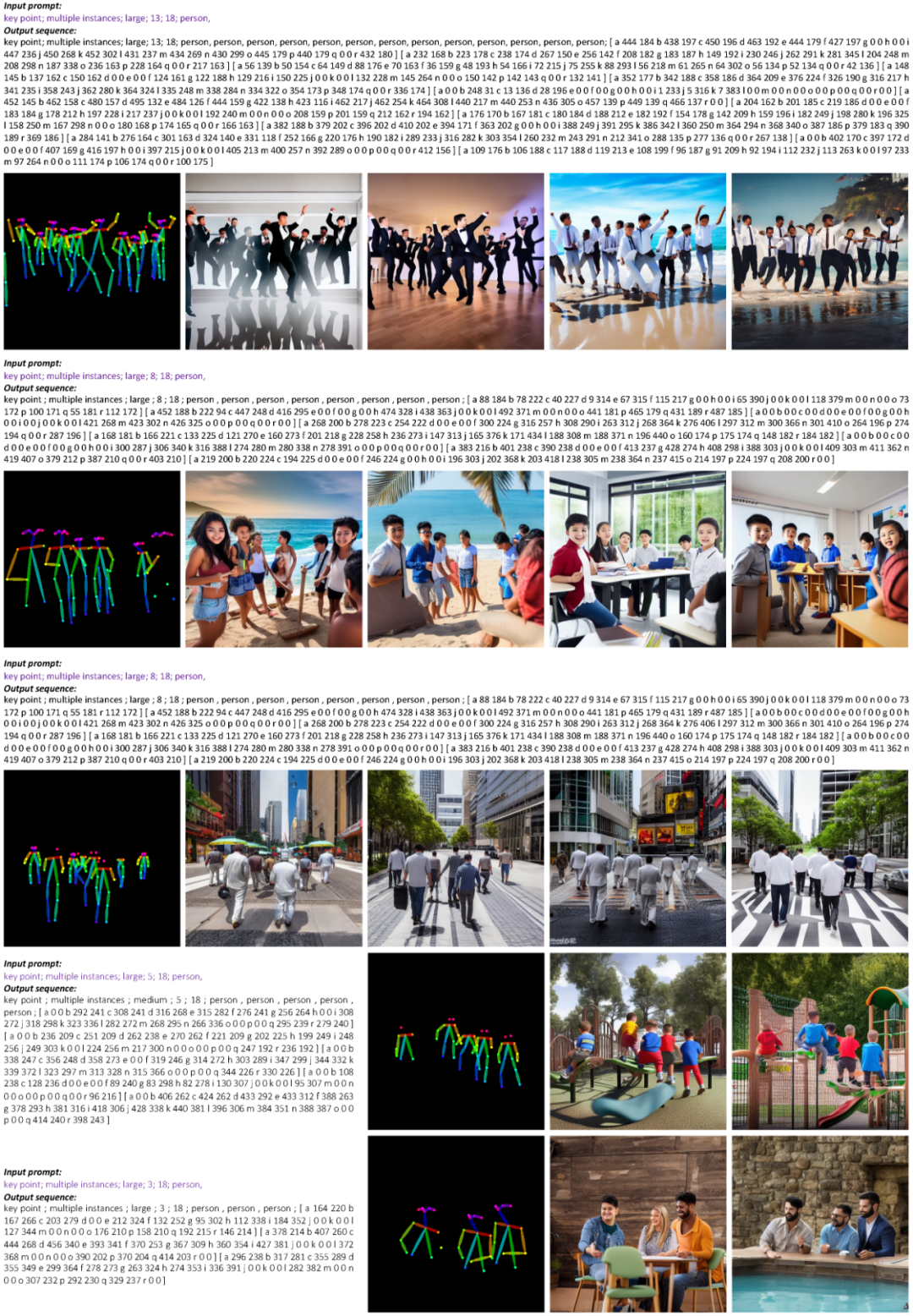

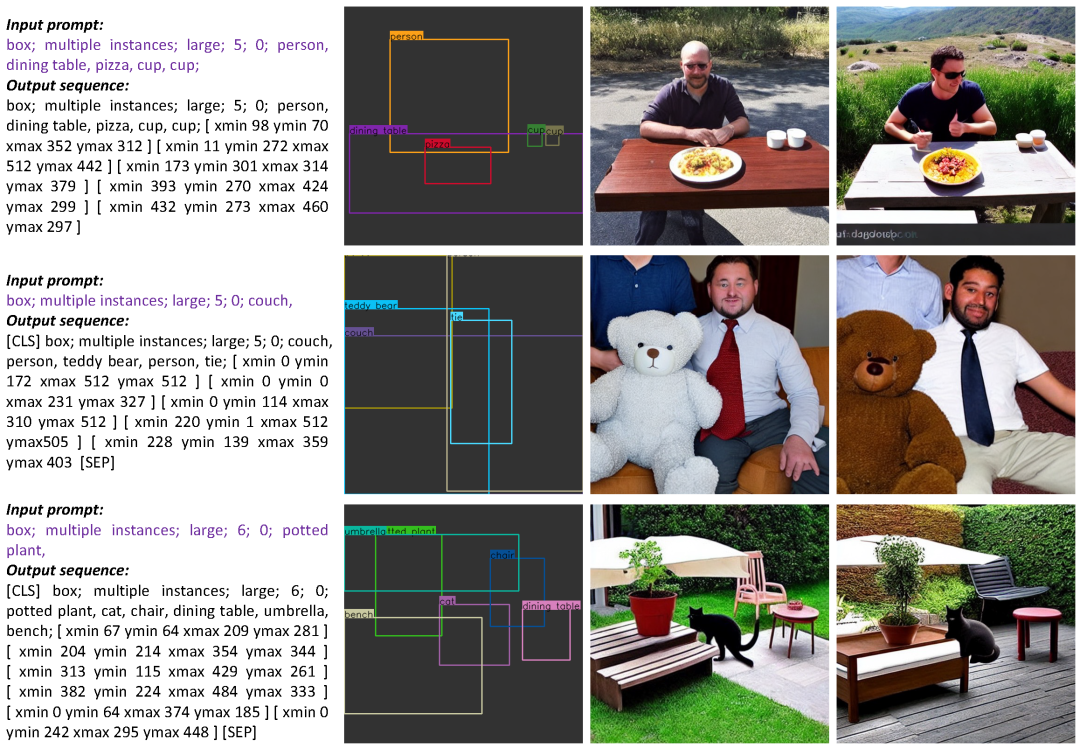

效果展示

-

模型

+关注

关注

1文章

3413浏览量

49470 -

数据集

+关注

关注

4文章

1212浏览量

24983 -

图像生成

+关注

关注

0文章

22浏览量

6933

原文标题:NUS&深大提出VisorGPT:为可控文本图像生成定制空间条件

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

一种有效的文本图像二值化方法

基于相容粗集的二值文本图像数字水印方法

基于多小波变换的文本图像文种识别

基于岭回归的稀疏编码文本图像复原方法

基于Hash函数的文本图像脆弱水印算法

复旦&amp;微软提出OmniVL:首个统一图像、视频、文本的基础预训练模型

如何区分Java中的&amp;和&amp;&amp;

微软提出Control-GPT:用GPT-4实现可控文本到图像生成!

基于文本到图像模型的可控文本到视频生成

HarmonyOS &amp;amp;amp;润和HiSpark 实战开发,“码”上评选活动,邀您来赛!!!

NUS&;amp;深大提出VisorGPT:为可控文本图像生成定制空间条件

NUS&深大提出VisorGPT:为可控文本图像生成定制空间条件

NUS&深大提出VisorGPT:为可控文本图像生成定制空间条件

评论