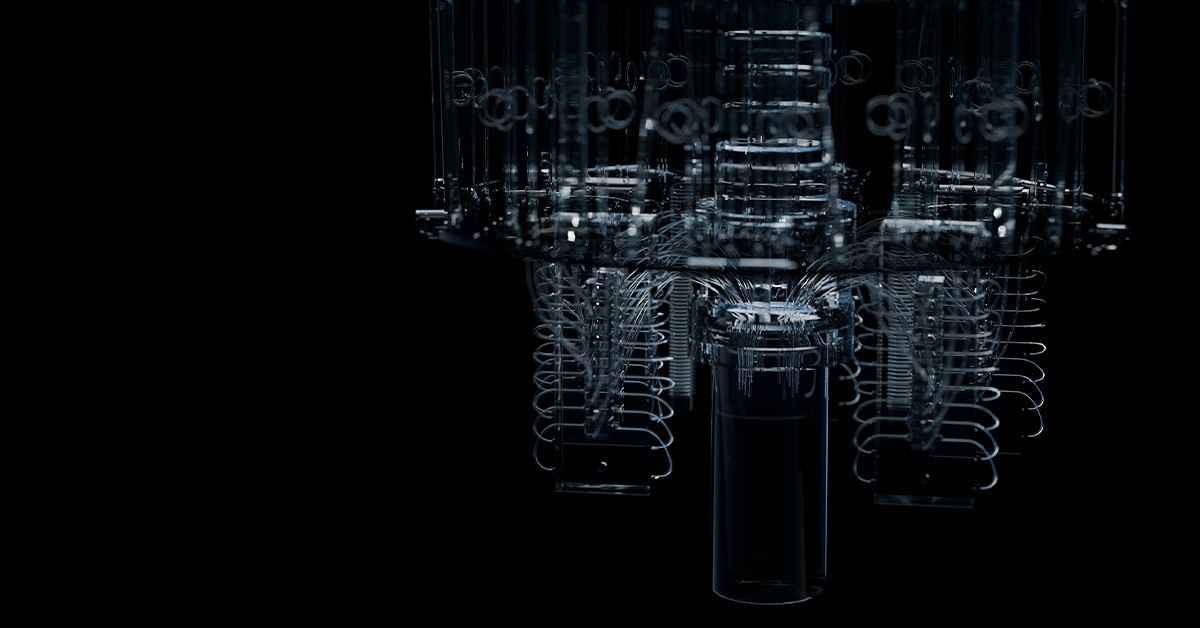

最新发表在国际著名学术期刊《自然》上的一篇论文介绍了一个重要的科学突破 —— 研究人员成功开发出一个具有量子处理能力的IBM127量子比特处理器。该处理器在无需纠错的情况下,能够超越传统经典计算,标志着量子计算又迈向了潜在可用的近未来。

该论文指出,量子计算的关键目标是展示超越经典计算的潜力,并高效地执行特定任务。实验中,研究人员使用了一个包含127个量子比特的处理器,并运行了60层的电路深度。在这个量子电路中,他们使用了大约2800个二量子比特门(作为经典计算机逻辑门的量子版本)。通过这种电路,可以产生非常庞大且高度纠缠的量子态,其特性对于经典计算机来说很难进行可靠的数值近似。但研究人员证明,他们的量子计算机能够通过准确测量期望值来估计这些态的性质,而不会引入过多的计算错误。巨大态的制造和测量需要高质量的芯片制造和后期处理方法来抑制噪音干扰。

实现超越经典计算并高效执行任务是量子计算的关键目标,但要达到这个目标还需要应对许多实际挑战。其中包括保持低错误率、克服量子系统及环境带来的噪声干扰以及扩大量子计算机的规模。错误和噪声会降低或消除量子计算相对于经典计算的优势。在当前技术水平下,容错性仍然具有难度。尽管现有的量子处理器已经在某些特定但人工构建的问题上超越了传统计算机,但噪声问题限制了当前或近未来嘈杂量子计算机在执行实用(对研究目的有意义)量子计算方面的可行性。

来自瑞典查尔姆斯理工大学的格兰·文丁和乔纳斯·白兰德尔对此进行了评价,他们指出:“这一次的量子优势在于规模而不是速度——127量子比特编码了一个巨大的态空间,而传统计算机无法具备如此大的内存容量。”

该论文的发表代表着量子计算领域取得的重要进展,将为未来的量子计算研究和应用提供新的前景和方向。

编辑:黄飞

-

处理器

+关注

关注

68文章

19488浏览量

231545 -

量子计算机

+关注

关注

4文章

534浏览量

25624 -

量子处理器

+关注

关注

0文章

22浏览量

1039

发布评论请先 登录

相关推荐

寻找超导量子比特信息丢失的原因

NVIDIA 助力谷歌量子 AI 通过量子器件物理学模拟加快处理器设计

新突破!无需纠错就能超越经典计算的量子比特处理器

新突破!无需纠错就能超越经典计算的量子比特处理器

评论