随着 ChatGPT 横空出世,预训练大模型对千行百业的革新与改造潜力已尽显无遗,甚至有业界大佬将其问世誉为人工智能“iPhone 时刻”,并预言这“只是更伟大事物的开始”。

ChatGPT 为何显得如此“与众不同”?

借用技术接受理论(TAM)提出者哈佛大学教授 Venky Narayanamurti 的总结:有用性(usefulness)与易用性(ease of use)是一项新兴技术扩散的两大基本前提。以这一标准衡量,2016 年的“AlphaGo vs 李世石”五番棋大战,堪称完成了对人工智能“有用性”的全民科普,而 ChatGPT 则标志着 AI 技术扩散的另一必要条件——易用性已潜移默化渗入公众心智。

基于此,外界有理由乐观期待,人工智能产业的确已站在了巨擘预卜的宏伟蓝图新起点上。

成于算力 困于互连?

在不少“后见之明”的解读中,GPT 家族往往被与 2017 年谷歌推出的 Transformer 模型相联系。

基于自注意力机制的 Transformer,及其后谷歌 BERT 对各类文本任务的“屠榜”表现和惊人的泛化能力,的确堪称为 GPT 做好了前置技术与工程方法的铺垫。站在巨人的肩膀上,GPT 开发者 OpenAI 团队,最终凭借更敏捷的效率和更有力的执行,完成了最后的一跃。

进一步深入看,Transformer 较此前 MLP\LSTM 等传统深度学习模型,正是对硬件算力实现了更高效的运用。

关于这一点,2019 年深度学习泰斗、DeepMind 首席科学家 Richard Sutton 在其《苦涩的教训》一文中就曾感言,从 70 年 AI 研究中可以学到的最大教训是,利用计算的一般方法最终是最有效的,而且有很大的优势,终极原因是摩尔定律,或者更确切地说,是它对每单位计算成本持续呈指数下降的概括,大多数 AI 研究都是在可用算力恒定的情况下进行的(在这种情况下,利用人类经验将是提高性能的唯一方法),但是,在比典型研究项目稍长的时间里,算力会大大增加,从长远来看,唯一重要的是利用计算。

正如 Sutton 所预见的,近年来,AI 硬件算力取得了突飞猛进的发展。除了为人所熟知的 GPU 之外,谷歌 TPU(GPT 系列早期通过 TPUv2 进行训练)、微软 Catapult 等 AI 加速芯片往往省去了传统通用 CPU 微架构中乱序、预取等高级控制措施,能够实现卷积神经网络最核心的乘加运算单元设计最优化,充分挖掘 SIMD 架构并行计算能力。

算法、算力及其相结合的工程方法进步,最终为 OpenAI“大力出奇迹”奠定了基础。

完全可以预期,在 OpenAI 明星效应下,全球科技巨头未来一两年必将推出一系列类 GPT 预训练大模型,也有望带动对数据中心 AI 算力集群的投资进一步加速。

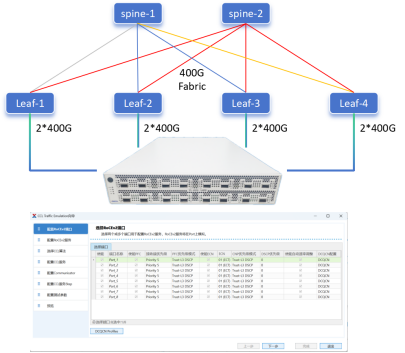

不过值得注意的是,尽管各大芯片厂商争相推出 AI 加速芯片,算力参数不断刷新记录,但预训练大模型参数量动辄上百亿、千亿乃至万亿,其训练仍远远超出一两张 GPU 等 AI 加速卡所能驾驭的范围,往往必须通过网络将多处理器互连、乃至进一步组成 HPC 算力集群,实现算力资源的池化调度,如此方能满足 AI 大模型的分布式、并行化训练。而在评估训练效率时,单批数据(batch)的总训练用时也往往受通信时长的显著影响。

正因如此,随着 AI 大模型揭示的全新想象空间出现,算力集群这一基础设施也将迎来投资热潮,而在其面临的配电、散热、通信等一系列工程挑战中,算力节点间的数据传输尤其堪称制约硬件算力充分释放的关键“瓶颈”。

破解互连瓶颈的“关键支点”

AI 训练、推理所面对的数据量指数增长,使得无论单服务器中多 GPU、CPU 间 C2C 通信,还是在多服务器间组网,数据传输总体都呈现出高带宽、低延迟的技术需求。

在算力集群通信网络拓扑结构趋同的背景下,交换机接口日益成为打通“瓶颈”的重要突破口,并衍生出提升网卡速率、增加网卡数量、乃至应用 RDMA 网络直连等多种工程思路。

而在底层接口技术领域,与传统并行接口相比,SerDes 串行接口由于其显著的成本优势,已然成为应用主流,在 PCIe 6.0 等新标准中,更是在物理层进一步引入对 PAM4(四阶脉冲振幅调变)编码的支持,以进一步提高 SerDes 数据传输速率。

不过 SerDes 的应用,也自然存在不少技术挑战,其中最严峻的,无疑首推信号完整性(SI)问题。

例如在通过背板、连接器、PCB 板的中距离、长距离互连场景中,SerDes 高速链路 TX、RX 端往往间隔着管脚、PCB 过孔、信号线乃至连接器、线缆等环节,存在材料、工艺、布局等复杂原因引入的噪声、串扰和信号衰减,以至于最终抵达接收器的电气信号可能严重失真,很难恢复所传输信息的时钟和数据位,也局限了速率、距离上的设计空间。

新一代 56G、112G SerDes 应用 PAM4 编码,在提供更大网络吞吐量的同时,也因引入更多电平水平,带来了信噪比损失、误码率(BER)恶化、前向纠错(FEC)延迟增加等问题,需要进行精细的权衡取舍。

从上面的分析不难看出,想要充分发挥 AI 硬件算力效能,接口技术是破解互连瓶颈的关键支点,具有极大的杠杆效应,而其应用则必须解决围绕信号完整性的诸多挑战。

目前,尽管大量硬件厂商聘请了专职 SI 工程师负责调试,不过其效果取决于千差万别的个人“手艺”,由于在芯片与系统设计各层面均需保证信号完整性,验证过程也往往旷日持久,只有技能十分熟练且模电领域经验极其丰富的设计团队才能尝试此类设计,且测试验证周期漫长。

正因如此,在芯片设计中,外购高速接口 IP 几乎成为行业“必选项”,也带动接口 IP 成为近年来增速最快的 IP 细分市场,根据专业机构预测,接口 IP 甚至有望在 2025 年前后超越 CPU IP,成为第一大半导体 IP 品类。

授人以鱼,更要授人以渔

接口 IP 市场机遇,也使之成为各大 IP HOUSE 竞争热点。Cadence 同样推出了112G SerDes IP 设计,面向高性能计算(HPC)数据中心 SOC 需求,适用于长距离和中距离传输,已经经过 7nm 制程硅验证,拥有上佳的 PPA 表现,插入损耗 >35dB。

值得一提的是,外购接口 IP 只是从芯片到系统开发及信号完整性测试的起点,与工作流配套的工具是否完备、可及,也是影响开发周期的重要因素,可以说接口 IP 供应商既要授人以鱼,更要授人以渔。

作为 EDA\IP 领域巨头,Cadence 在这方面的实践尤其具有代表性。在 SerDes 等成熟接口 IP 之外,该公司还提供了有机融合的完善设计工具和技术,帮助芯片与系统设计人员应对贯穿各层面的信号完整性挑战。

例如在不同芯片间互连设计与仿真中,建模是必不可少的手段。目前,IBIS 和 AMI 是对 SerDes 信道进行建模的首选方式,IBIS-AMI 的出现,使利用仿真模型快速且精确地模拟大量比特流成为了可能。Cadence 基于Sigrity Advanced IBIS 建模工具,用户可自动创建模型,借助向导程序生成实用算法模型。

在基于 PCB 板/背板/连接器的中长距离互连场景中,SerDes 高速接口开发人员为了精准可靠地分析信号,还需要为总体设计进行信号完整性(SI)、电源完整性(PI)以及电磁兼容性(EMC)协同仿真,开发者往往需要透彻了解数据采集分析理论、精准建立模拟器件特性模型。

针对这一痛点,Cadence 的Clarity 3D Solver为 PCB、IC 封装和 SoIC 关键互连设计提供了更好的工具选择,基于其创建的高精度 S-参数模型,即使在 112G 数据传输速度下,也能实现与实验室测量相匹配的仿真结果。其有限元分析(FEM)过程实现了高度并行化,可极大缩短求解耗时,并支持近乎线性的硬件算力可扩展性。

此外,在分析链路信号完整性时,通常隐含假设是电路板和连接器功能良好,但在极高频率下,单独分析连接器和电路板、然后再将它们“连接"在一起的假设不再适用。电路板和连接器之间交互过多,同样需要 Clarity Solver 等全面的 3D 分析工具实现高质量设计,同时准确预测成品性能。

结

语

在黄仁勋喊出人工智能“iPhone 时刻”后,短短几十天以来,预训练大模型及其下游应用,已经呈现出令人目不暇给的爆发态势。可以想见,在各大云计算巨头的 AI 大模型“军备竞赛”中,算力集群也将迎来一轮新的投资热潮,通信网络与接口技术,也有望进入发展加速期。此外,特斯拉 Dojo、Cerebras WSE-2 等走“超级单芯片”路线的厂商,也可能引领一条大模型训练的新路。

不过无论何种路径,对接口 IP 的“刚需”都清晰可见,在这一热点、难点领域,Cadence 将带来更多完整的解决方案,推动互连瓶颈的缓解与松动,有力释放预训练大模型无限可能,造福千行百业。

-

硬件

+关注

关注

11文章

3429浏览量

66824 -

AI

+关注

关注

87文章

32992浏览量

272716

发布评论请先 登录

相关推荐

芯片、模型生态分散,无问芯穹、沐曦、壁仞谈国产算力瓶颈破局之道

行业资讯 | 释放 AI 大模型潜能,硬件算力亟待突破互连瓶颈

行业资讯 | 释放 AI 大模型潜能,硬件算力亟待突破互连瓶颈

评论