最近,随着人工智能的大肆宣传,我们注意到大多数人都默认所有人工智能工作负载将始终在 GPU 上运行。对于这一思路,我们认为,随着更广泛的芯片发挥作用,现实情况可能会有所不同。

需要明确的是,GPU 非常适合人工智能工作,并且不会对 Nvidia 的股价构成威胁。我们所说的人工智能实际上是应用统计学,更具体地说是非常先进的统计回归模型。

这些问题的核心是矩阵代数,涉及相当简单的数学问题,例如一个数字乘以另一个数字,但需要大规模完成。GPU 的设计采用较小的内核(更简单的数学),且数量较多(大规模)。因此,使用这些处理器代替具有较少数量较大内核的 CPU 是有意义的。

现在,这种情况变得有点模糊了。其一,GPU 变得更加昂贵。他们更擅长人工智能数学,但在某些时候转向 CPU 开始在经济上变得有意义。

人工智能半导体市场实际上分为三个部分:训练、云推理和边缘推理。目前的训练基本上与 Nvidia 相当,但这只是市场的一小部分。云推理将是一个更大的市场——随着越来越多的人使用这些人工智能模型,对推理的需求将会增长,目前大部分工作将在云中完成。对于许多公司来说,扩大产能的成本似乎非常昂贵。半导体分析师迪伦·帕特尔(Dylan Patel)像往常一样,对这个数学进行了最好的阐述,但足以说明推理费用可能会成为未来一年左右消费者采用人工智能的主要障碍。

“考虑到 GPU 的成本和相对稀缺性,我们认为许多公司将开始探索 GPU 的替代品来运行推理工作负载,特别是对于将这些 AI 结果与其他功能(如搜索或社交媒体)相结合的公司,这些工作负载在很大程度上仍然运行得最好无论如何,在CPU上。”Dylan Patel说。

展望未来,我们怀疑人工智能的经济学将需要更多的推理工作来进行边缘计算,这意味着消费者需要付费购买设备。这意味着手机和 PC 将需要人工智能功能,这可能意味着它们在 CPU 和移动 SoC 上运行。

AMD 最近推出了内置于其客户端 CPU 中的人工智能功能,而苹果公司的 A 系列移动处理器和 M 系列 CPU 中都配备了神经引擎。我们预计这很快就会在边缘设备中普及。

当然,许多公司正在寻求构建人工智能加速器——专门用于进行人工智能数学计算的专用芯片。但事实证明,这仅适用于像谷歌这样控制其所有软件的公司。这些专用芯片的一个重要问题是,它们往往针对一组特定的工作负载或人工智能模型进行过度设计,当这些模型发生变化时,这些芯片就会失去性能优势。

所有这些都导致了半导体领域最不为人知的领域之一——FPGA。这些是“可编程”芯片(“P”代表可编程),这意味着它们在生产后可以重新用于不同的任务。这些与专门构建的 ASIC 处于相反的一端,专为 AI 加速器等特定任务而设计。

FPGA 已经存在多年了。半导体的经济学通常意味着,超过一定的容量阈值,ASIC 更有意义,但对于工业和航空航天系统等小容量应用,它们的工作效果非常好。因此,FPGA 无处不在,涉及数十个终端市场,但我们对它们不太熟悉,因为它们通常不会出现在普通消费者每天使用的大批量电子产品中。

人工智能的出现稍微改变了这种计算方式。对于这些工作负载,FPGA 可能对底层模型频繁变化的人工智能推理需求有意义。在这里,FPGA 的可编程性超过了 FPGA 使用的典型经济性。需要明确的是,我们认为 FPGA 不会成为使用数千个 GPU 的大规模人工智能系统的有力竞争对手,但我们确实认为,随着人工智能进一步渗透到电子领域,FPGA 的应用范围将会扩大。

简而言之,GPU 可能仍然是大部分人工智能领域的主导芯片,尤其是对于高调、大容量的模型。但除此之外,我们认为替代芯片的使用将成为生态系统的重要组成部分,这是一个比今天看起来更大的机会。

-

gpu

+关注

关注

28文章

4710浏览量

128781 -

人工智能

+关注

关注

1791文章

46956浏览量

237813 -

AI芯片

+关注

关注

17文章

1862浏览量

34939

原文标题:AI芯片,就是GPU吗?

文章出处:【微信号:晶扬电子,微信公众号:晶扬电子】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

《算力芯片 高性能 CPUGPUNPU 微架构分析》第3篇阅读心得:GPU革命:从图形引擎到AI加速器的蜕变

GPU服务器AI网络架构设计

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--全书概览

名单公布!【书籍评测活动NO.43】 算力芯片 | 高性能 CPU/GPU/NPU 微架构分析

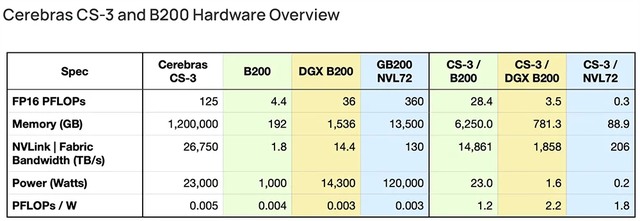

AI初出企业Cerebras已申请IPO!称发布的AI芯片比GPU更适合大模型训练

AI训练,为什么需要GPU?

英伟达发布新一代AI芯片架构Blackwell GPU

FPGA在深度学习应用中或将取代GPU

GPU供不应求,出货是否需延后?

2024年,GPU能降价吗?

AI芯片,就是GPU吗?

AI芯片,就是GPU吗?

评论