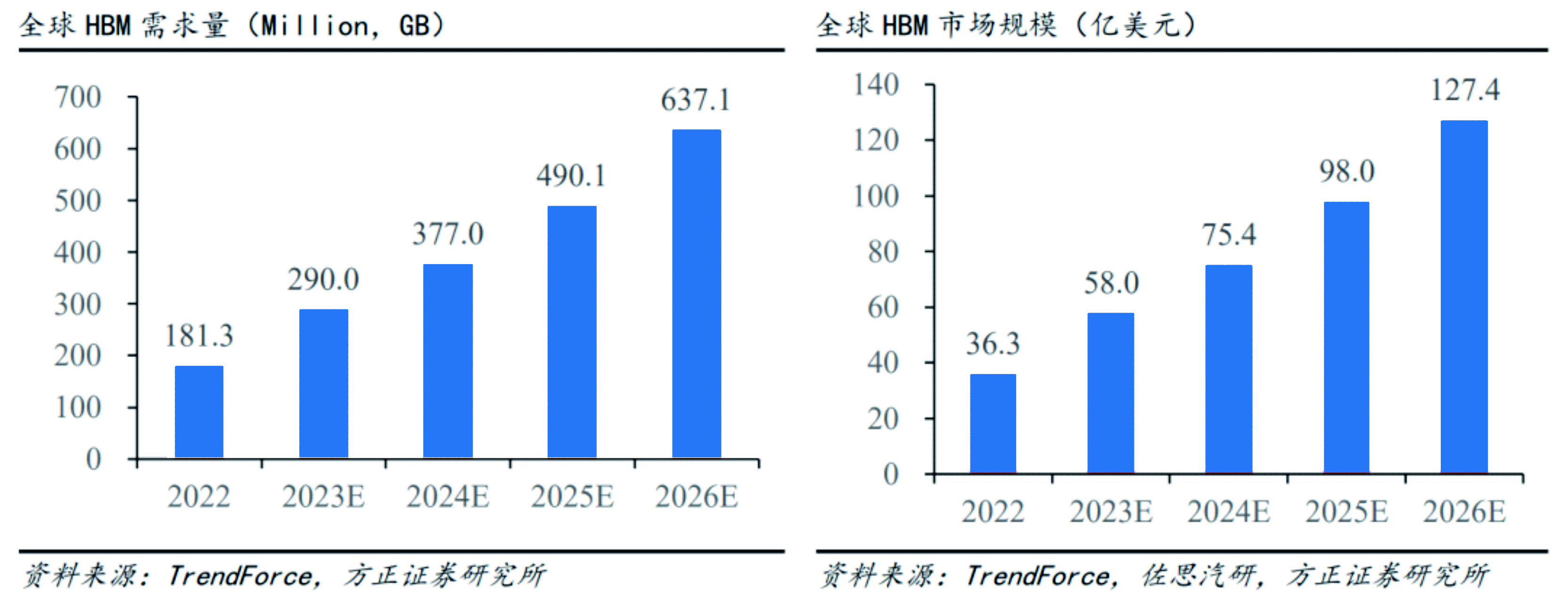

6月28日,trendforce集邦咨询公司发表研究报告称,hbm芯片搭载在尖端ai服务器gpu上,预计到2023年,hbm需求将每年增加60%,达到2.9亿gb,到2024年将增加30%。

到2025年,如果世界上有5个像chatgpt这样的超大型aigc, 25个像midjourney这样的中尺寸产品,以及80个小型产品,那么nvidia a100 gpu将至少包括145,600到233,700个。此外,超级电脑、8k动影像、ar/vr等的应用也可以进一步提高云计算系统的负载。

由于hbm存储器芯片比ddr sdram的带宽更高,电力消耗相对较低,因此,最近上市的主力hpc处理器和加速运算gpu都使用hbm存储器。预计,今后hbm将能够代替部分gddr sd内存和ddr sd内存的普通内存。

据集邦咨询公司预测,目前nvidia a100、h100、amd mi300及大型云提供企业谷歌、aws等自行开发的asic ai服务器需求较强,到2023年ai服务器出货量(包括gpu、fpga、asic等)将达到120万台。年增长率接近38%。ai芯片的出货量也将一致转为上升趋势,预计今年将增加50%。

-

云计算

+关注

关注

39文章

7840浏览量

137569 -

ChatGPT

+关注

关注

29文章

1564浏览量

7831 -

AIGC

+关注

关注

1文章

363浏览量

1563

发布评论请先 登录

相关推荐

AI兴起推动HBM需求激增,DRAM市场面临重塑

HBM明年售价预计上涨18%,营收年增156%

机构:2024年中国大陆芯片出口额将达950亿美元

三星预测HBM需求至2025年翻倍增长

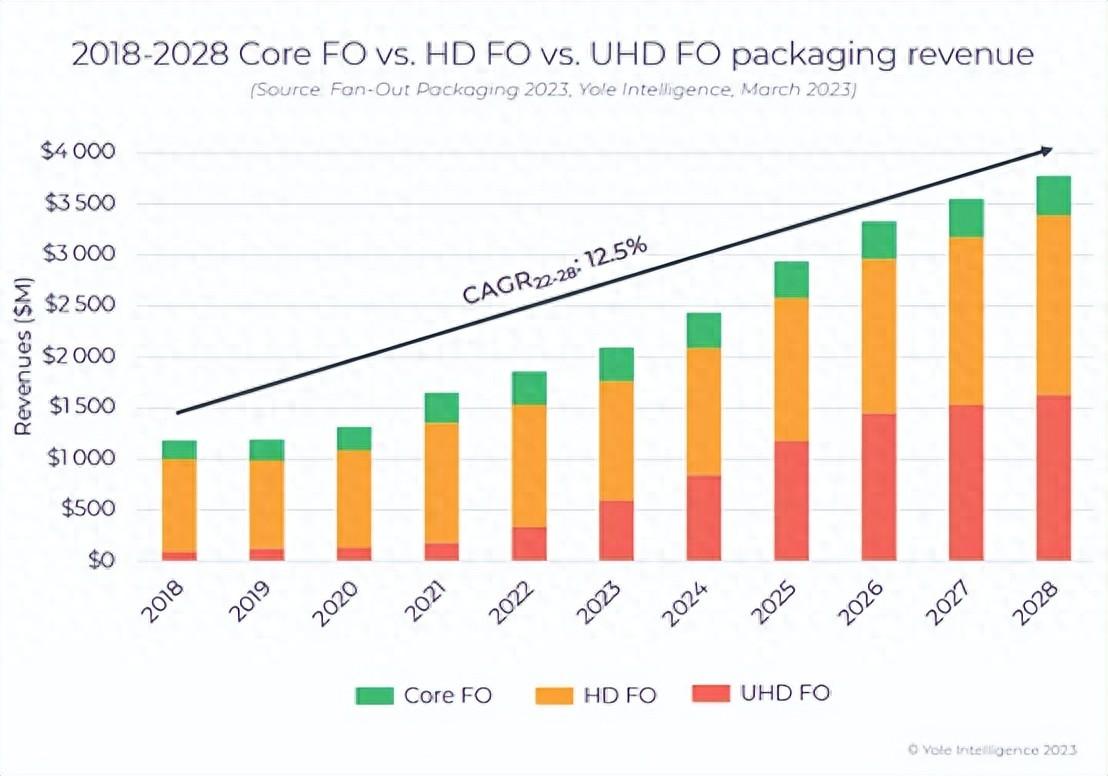

扇出型 (Fan-Out)封装市场规模到2028 年将达到38 亿美元

剑指HBM及AI芯片,普莱信重磅发布Loong系列TCB先进封装设备

预计2023年对HBM需求量将增加60%,达到2.9亿GB

预计2023年对HBM需求量将增加60%,达到2.9亿GB

评论