从2022.11.30的ChatGPT,到2023.6.13的360智脑大模型2.0,全球AI界已为大模型持续疯狂了七个多月。ChatGPT们正如雨后春笋般涌现,向AI市场投放一个个“炸弹”:办公、医疗、教育、制造,亟需AI的赋能。

而AI应用千千万,把大模型打造好才是硬道理。

对于大模型“世界”来说,算法是“生产关系”,是处理数据信息的规则与方式;算力是“生产力”,能够提高数据处理、算法训练的速度与规模;数据是“生产资料”,高质量的数据是驱动算法持续迭代的养分。在这之中,算力是让大模型转动的前提。

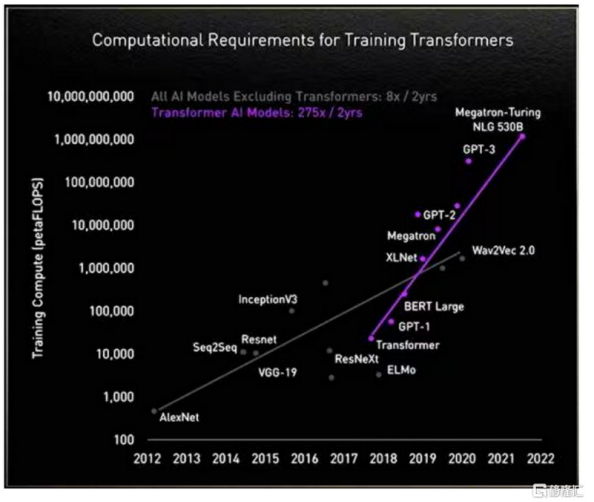

我们都知道的是,大模型正对算力提出史无前例的要求,具体的表现是:据英伟达数据显示,在没有以Transformer模型为基础架构的大模型之前,算力需求大致是每两年提升8倍;而自利用Transformer模型后,算力需求大致是每两年提升275倍。基于此,530B参数量的Megatron-Turing NLG模型,将要吞噬超10亿FLOPS的算力。

(AI不同模型算法算力迭代情况 图源:格隆汇)

作为大模型的大脑——AI芯片,是支撑ChatGPT们高效生产及应用落地的基本前提。保证算力的高效、充足供应,是目前AI大算力芯片厂商亟需解决的问题。

GPT-4等大模型向芯片厂商狮子大开口的同时,也为芯片厂商尤其是初创芯片厂商,带来一个利好消息:软件生态重要性正在下降。

早先技术不够成熟之时,研究者们只能从解决某个特定问题起步,参数量低于百万的小模型由此诞生。例如谷歌旗下的AI公司DeepMind,让AlphaGo对上百万种人类专业选手的下棋步骤进行专项“学习”。

而小模型多了之后,硬件例如芯片的适配问题迫在眉睫。故,当英伟达推出统一生态CUDA之后,GPU+CUDA迅速博得计算机科学界认可,成为人工智能开发的标准配置。

现如今纷纷涌现的大模型具备多模态能力,能够处理文本、图片、编程等问题,也能够覆盖办公、教育、医疗等多个垂直领域。这也就意味着,适应主流生态并非唯一的选择:在大模型对芯片需求量暴涨之时,芯片厂商或许可以只适配1-2个大模型,便能完成以往多个小模型的订单。

也就是说,ChatGPT的出现,为初创芯片厂商们提供了弯道超车的机会。这就意味着,AI芯片市场格局将发生巨变:不再是个别厂商的独角戏,而是多个创新者的群戏。

本报告将梳理AI芯片行业发展概况、玩家情况,总结出大算力时代,玩家提高算力的路径,并基于此,窥探AI大算力芯片的发展趋势。

PART-01

国产AI芯片,正走向AI3.0时代

现阶段的AI芯片,根据技术架构种类来分,主要包括GPGPU、FPGA、以 VPU、TPU 为代表的 ASIC、存算一体芯片。

根据其在网络中的位置,AI 芯片可以分为云端AI芯片 、边缘和终端AI芯片;

云端主要部署高算力的AI训练芯片和推理芯片,承担训练和推理任务,例如智能数据分析、模型训练任务等;

边缘和终端主要部署推理芯片,承担推理任务,需要独立完成数据收集、环境感知、人机交互及部分推理决策控制任务。

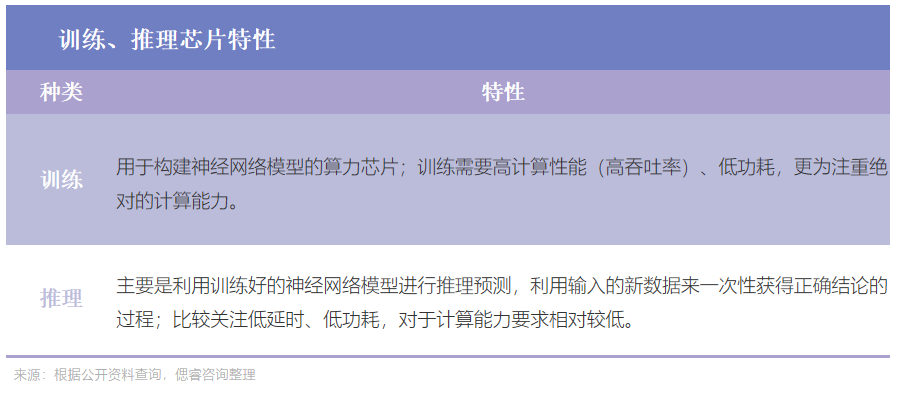

根据其在实践中的目标,可分为训练芯片和推理芯片:

纵观AI芯片在国内的发展史,AI芯片国产化进程大致分为三个时代。

1.0时代,是属于ASIC架构的时代

自2000年互联网浪潮拉开AI芯片的序幕后,2010年前后,数据、算法、算力和应用场景四大因素的逐渐成熟,正式引发AI产业的爆发式增长。申威、沸腾、兆芯、龙芯、魂芯以及云端AI芯片相继问世,标志着国产AI芯片正式启航。

2016年5月,当谷歌揭晓AlphaGo背后的功臣是TPU时,ASIC随即成为“当红辣子鸡”。于是在2018年,国内寒武纪、地平线等国内厂商陆续跟上脚步,针对云端AI应用推出ASIC架构芯片,开启国产AI芯片1.0时代。

ASIC芯片,能够在某一特定场景、算法较固定的情况下,实现更优性能和更低功耗,基于此,满足了企业对极致算力和能效的追求。

所以当时的厂商们,多以捆绑合作为主:大多芯片厂商寻找大客户们实现“专用场景”落地,而有着综合生态的大厂选择单打独斗。

地平线、耐能科技等AI芯片厂商,分别专注AI芯片的细分领域,采用“大客户捆绑”模式进入大客户供应链。

在中厂们绑定大客户协同发展之际,自有生态的大厂阿里成立独资芯片公司平头哥,着眼AI和量子计算。

在1.0时代,刚出世的国内芯片厂商们选择绑定大客户,有综合生态的大厂选择向内自研,共同踏上探索AI芯片算力的征途。

2.0时代,更具通用性的GPGPU“引领风骚”

尽管ASIC有着极致的算力和能效,但也存在着应用场景局限、依赖自建生态、客户迁移难度大、学习曲线较长等问题。

于是,通用性更强的GPGPU(通用图形处理器)在不断迭代和发展中成为AI计算领域的最新发展方向,当上AI芯片2.0时代的指路人。

自2020年起,以英伟达为代表的GPGPU架构开始有着不错的性能表现。通过对比英伟达近三代旗舰产品发现,从FP16 tensor 算力来看,性能实现逐代翻倍的同时,算力成本在下降。

于是,国内多个厂商纷纷布局GPGPU芯片,主打CUDA兼容,试探着AI算力芯片的极限。2020年起,珠海芯动力、壁仞科技、沐曦、登临科技、天数智芯、瀚博半导体等新势力集结发力,大家一致的动作是:自研架构,追随主流生态,切入边缘侧场景。

在前两个时代中,国产AI芯片厂商都在竭力顺应时代潮流,前赴后继地跟随国际大厂的步伐,通过研发最新芯片解决AI算力芯片的挑战。

我们能看到的变化是,在2.0时代中,国产AI芯片厂商自主意识觉醒,尝试着自研架构以求突破。

3.0时代,存算一体芯片或成GPT-4等大模型的最优选

ASIC芯片的弱通用性难以应对下游层出不穷的应用,GPGPU受制于高功耗与低算力利用率,而大模型又对算力提出前所未有的高要求:目前,大模型所需的大算力起码是1000TOPS及以上。

以 2020 年发布的 GPT-3 预训练语言模型为例,其采用的是2020年最先进的英伟达A100 GPU, 算力是624TOPS。2023年,随着模型预训练阶段模型迭代,又新增访问阶段井喷的需求,未来模型对于芯片算力的需求起码要破千。

再例如自动驾驶领域,根据财通证券研究所表明,自动驾驶所需单个芯片的算力未来起码要1000+TOPS:2021年4月, 英伟达就已经发布了算力为1000TOPS的DRIVE Atlan芯片;到了今年,英伟达直接推出芯片Thor,达到2000TOPS。

由此,业界亟需新架构、新工艺、新材料、新封装,突破算力天花板。除此之外,日渐紧张的地缘关系,无疑又给高度依赖先进制程工艺的AI大算力芯片厂商们提出新的挑战。

在这些大背景下,从2017年到2021年间集中成立的一批初创公司,选择跳脱传统冯·诺依曼架构,布局存算一体等新兴技术,中国AI芯片3.0时代,正式拉开帷幕。

目前存算一体,正在上升期:

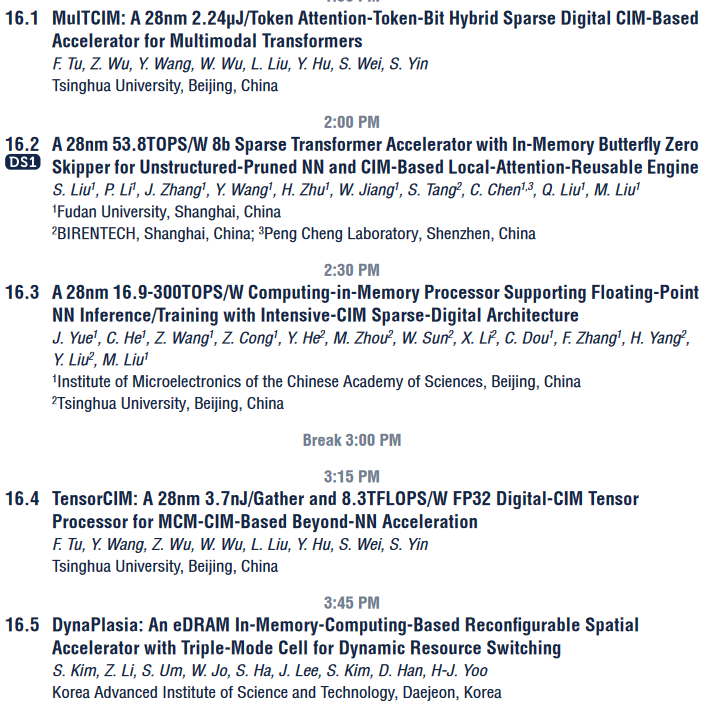

学界,ISSCC上存算/近存算相关的文章数量迅速增加:从20年的6篇上涨到23年的19篇;其中数字存内计算,从21年被首次提出后,22年迅速增加到4篇。

产界,巨头纷纷布局存算一体,国内陆陆续续也有近十几家初创公司押注该架构:

在特斯拉2023 Investor Day预告片末尾,特斯拉的dojo超算中心和存算一体芯片相继亮相;在更早之前,三星、阿里达摩院包括AMD也早早布局并推出相关产品:阿里达摩院表示,相比传统CPU计算系统,存算一体芯片的性能提升10倍以上,能效提升超过300倍;三星表示,与仅配备HBM的GPU加速器相比,配备HBM-PIM的GPU加速器一年的能耗降低了约2100GWh。

目前,国内的亿铸科技、知存科技、苹芯科技、九天睿芯等十余家初创公司采用存算一体架构投注于AI算力,其中亿铸科技偏向数据中心等大算力场景。

现阶段,业内人士表示,存算一体将有望成为继CPU、GPU架构之后的第三种算力架构。

该提法的底气在于,存算一体理论上拥有高能效比优势,又能绕过先进制程封锁,兼顾更强通用性与更高性价比,算力发展空间巨大。

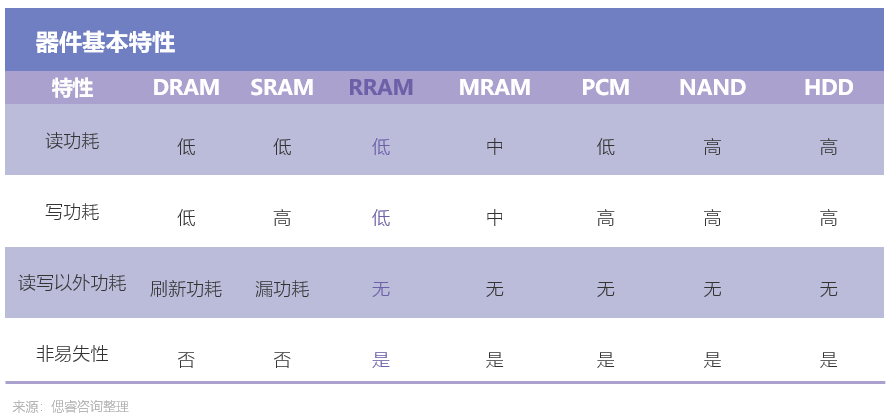

在此基础上,新型存储器能够助力存算一体更好地实现以上优势。目前可用于存算一体的成熟存储器有NOR FLASH、SRAM、DRAM、RRAM(ReRAM)、MRAM等。相比之下,RRAM具备低功耗、高计算精度、高能效比和制造兼容CMOS工艺等优势:

目前,新型存储器RRAM技术已然落地:2022上半年,国内创业公司昕原半导体宣布,大陆首条RRAM 12寸中试生产线正式完成装机验收,并在工控领域达成量产商用。

随着新型存储器件走向量产,存算一体AI芯片已经挺进AI大算力芯片落地竞赛。

而无论是传统计算芯片,还是存算一体芯片,在实际加速AI计算时往往还需处理大量的逻辑计算、视频编解码等非AI加速计算领域的计算任务。随着多模态成为大模型时代的大势所趋,AI芯片未来需处理文本、语音、图像、视频等多类数据。

对此,初创公司亿铸科技首个提出存算一体超异构AI大算力技术路径。亿铸的畅想是,若能把新型忆阻器技术(RRAM)、存算一体架构、芯粒技术(Chiplet)、3D封装等技术结合,将会实现更大的有效算力、放置更多的参数、实现更高的能效比、更好的软件兼容性、从而抬高AI大算力芯片的发展天花板。

站在3.0时代门口,国产AI大算力芯片厂商自主意识爆发,以期为中国AI大算力芯片提供弯道超车的可能。

(中略)

算力解决方案,蓄势待发

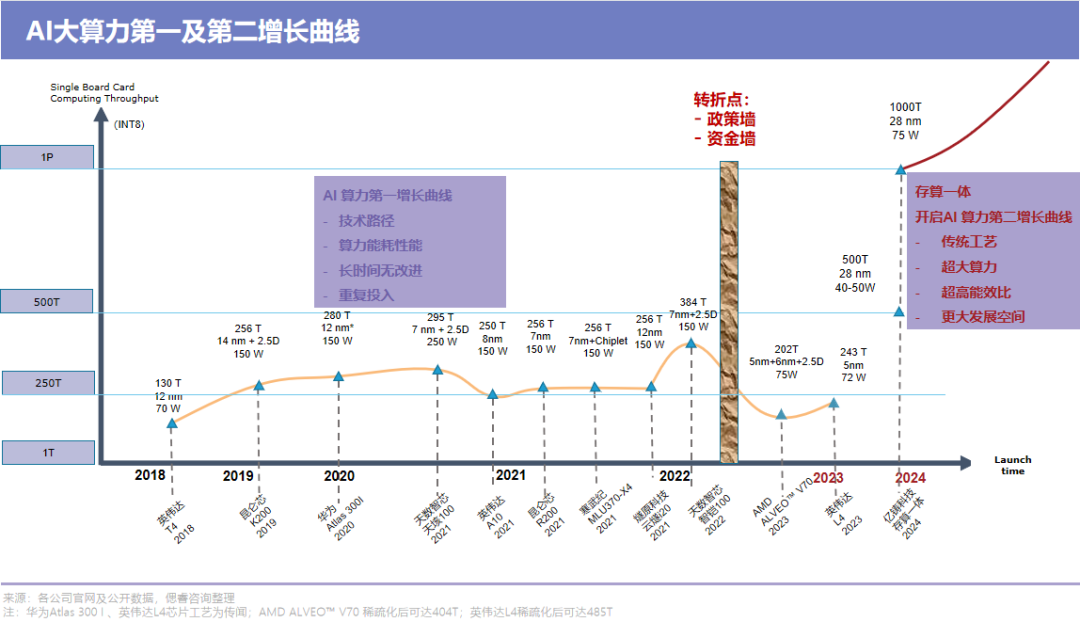

以AI云端推理卡为例,我们能看到的是,2018-2023年,算力由于工艺制程“卷不动”等种种原因,成本、功耗、算力难以兼顾。

但国力之争已然打响,ChatGPT已然到来,市场亟需兼顾成本、功耗、算力的方案。

目前国际大厂、国内主流厂商、初创企业都在谋求计算架构创新,试图找出兼顾性能、规模、利用率的方案,突破算力天花板。

(中略)

AI芯片“新星”存算一体门槛奇高

2019年后,新增的AI芯片厂商,多数在布局存算一体:据偲睿洞察不完全统计,在2019-2021年新增的AI芯片厂商有20家,在这之中,有10家选择存算一体路线。

这无一不说明着,存算一体将成为继GPGPU、ASIC等架构后的,一颗冉冉升起的新星。而这颗新星,并不是谁都可以摘。

在学界、产界、资本一致看好存算一体的境况下,强劲的技术实力、扎实的人才储备以及对迁移成本接受度的精准把控,是初创公司在业内保持竞争力的关键,也是挡在新玩家面前的三大门槛。

存算一体,打破了三堵墙,能够实现低功耗、高算力、高能效比,但想要实现如此性能,挑战颇多:

首先是存算一体涉及到芯片制造的全环节:从最底层的器件,到电路设计,架构设计,工具链,再到软件层的研发;

其次是,在每一层做相应改变的同时,还要考虑各层级之间的适配度。

我们一层一层来看,一颗存算一体芯片被造出来,有怎样的技术难题。

首先,在器件选择上,厂商就“如履薄冰”:存储器设计决定芯片的良率,一旦方向错误将可能导致芯片无法量产。

其次是电路设计层面。电路层面有了器件之后,需要用其做存储阵列的电路设计。而目前在电路设计上,存内计算没有EDA工具指导,需要靠手动完成,无疑又大大增加了操作难度。

紧接着,架构层面有电路之后,需要做架构层的设计。每一个电路是一个基本的计算模块,整个架构由不同模块组成,存算一体模块的设计决定了芯片的能效比。模拟电路会受到噪声干扰,芯片受到噪声影响后运转起来会遇到很多问题。

这种情况下,需要架构师了解模拟存内计算的工艺特点,针对这些特点去设计架构,同时也要考虑到架构与软件开发的适配度。

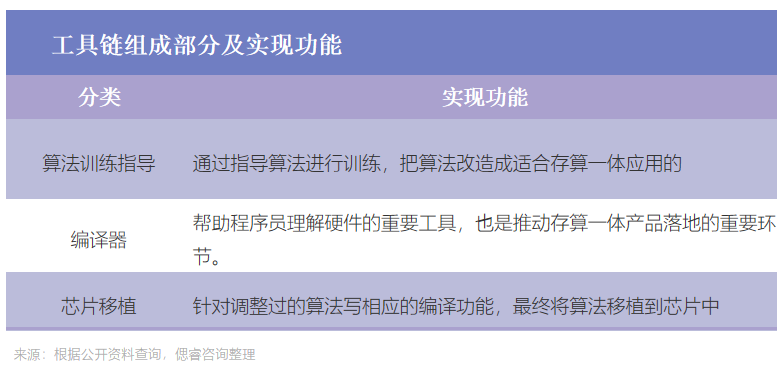

软件层面架构设计完成后,需要开发相应的工具链。

而由于存算一体的原始模型与传统架构下的模型不同,编译器要适配完全不同的存算一体架构,确保所有计算单元能够映射到硬件上,并且顺利运行。

一条完整的技术链条下来,考验着器件、电路设计、架构设计、工具链、软件层开发各个环节的能力,与协调各个环节的适配能力,是耗时耗力耗钱的持久战。

根据以上环节操作流程可以看到,存算一体芯片亟需经验丰富的电路设计师、芯片架构师。

除此之外,鉴于存算一体的特殊性,能够做成存算一体的公司在人员储备上需要有以下两点特征:

1、带头人需有足够魄力。在器件选择(RRAM、SRAM等)、计算模式(传统冯诺依曼、存算一体等)的选择上要有清晰的思路。

这是因为,存算一体作为一项颠覆、创新技术,无人引领,试错成本极高。能够实现商业化的企业,创始人往往具备丰富的产业界、大厂经验和学术背景,能够带领团队快速完成产品迭代。

2、在核心团队中,需要在技术的各个层级中配备经验丰富的人才。例如架构师,其是团队的核心。架构师需要对底层硬件,软件工具有深厚的理解和认知,能够把构想中的存算架构通过技术实现出来,最终达成产品落地;

3、此外,据量子位报告显示,国内缺乏电路设计的高端人才,尤其在混合电路领域。存内计算涉及大量的模拟电路设计,与强调团队协作的数字电路设计相比,模拟电路设计需要对于工艺、设计、版图、模型pdk以及封装都极度熟悉的个人设计师。

落地,是第一生产力。在交付时,客户考量的并不仅仅是存算一体技术,而是相较于以往产品而言,存算一体整体SoC的能效比、面效比和易用性等性能指标是否有足够的提升,更重要的是,迁移成本是否在承受范围内。

如果选择新的芯片提升算法表现力需要重新学习一套编程体系,在模型迁移上所花的人工成本高出购买一个新GPU的成本,那么客户大概率不会选择使用新的芯片。

因此,存算一体在落地过程中是否能将迁移成本降到最低,是客户在选择产品时的关键因素。

目前来看,英伟达凭借着更为通用的GPGPU霸占了中国AI加速卡的市场。

然而,存算一体芯片凭借着低功耗但高能效比的特性,正成为芯片赛道,冉冉升起的一颗新星。

而存算一体市场,风云未定,仍处于“小荷才露尖尖角”阶段。但我们不可否认的是,存算一体玩家已然构筑了三大高墙,非技术实力雄厚,人才储备扎实者,勿进。

PART-04

行业发展趋势

存算一体,算力的下一级

随着人工智能等大数据应用的兴起,存算一体技术得到国内外学界与产界的广泛研究与应用。在2017年微处理器顶级年会(Micro 2017)上,包括英伟达、英特尔、微软、三星、加州大学圣塔芭芭拉分校等都推出他们的存算一体系统原型。

自此,ISSCC上存算/近存算相关的文章数量迅速增加:从20年的6篇上涨到23年的19篇;其中数字存内计算,从21年被首次提出后,22年迅速增加到4篇,23年有6篇。

(ISSCC2023存算一体相关文章 图源:ISSCC2023)

系统级创新,崭露头角

系统级创新正频频现身半导体TOP级会议,展露着打破算力天花板的潜力。

在 AMD 的总裁兼CEO Lisa Su(苏姿丰)带来的主旨演讲“Innovation for the next decade of compute efficiency“(下一个十年计算效率的创新)中,她提到了AI应用的突飞猛进,以及它给芯片带来的需求。

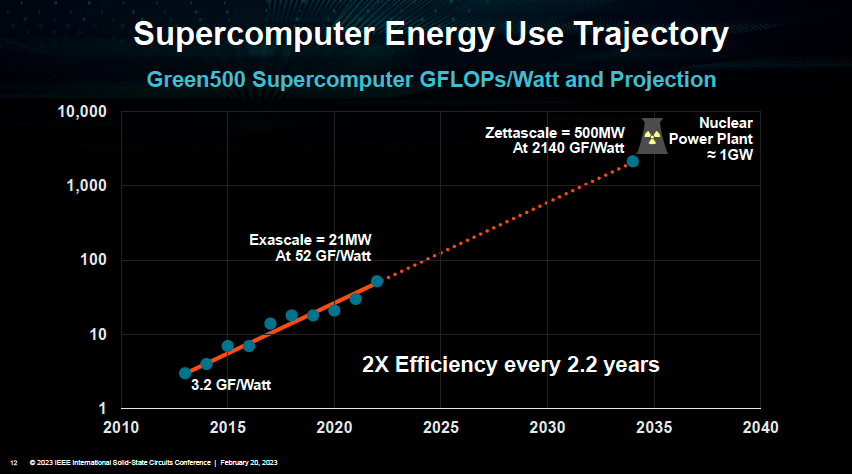

Lisa Su表示,根据目前计算效率每两年提升2.2倍的规律,预计到2035年,如果想要算力达到十万亿亿级,则需要的功率可达500MW,相当于半个核电站能产生的功率,“这是极为离谱、不切合实际的”。

而为了实现这样的效率提升,系统级创新是最关键的思路之一。

(算力与功耗关系 图源:ISSCC2023大会)

在另一个由欧洲最著名三个的半导体研究机构IMEC/CEA Leti/Fraunhofer带来的主旨演讲中,系统级创新也是其核心关键词。

该演讲中提到,随着半导体工艺逐渐接近物理极限,新的应用对于芯片的需求也必须要从系统级考虑才能满足,并且提到了下一代智能汽车和AI作为两个尤其需要芯片从系统级创新才能支持其新需求的核心应用。

“从头到脚”打破算力天花板

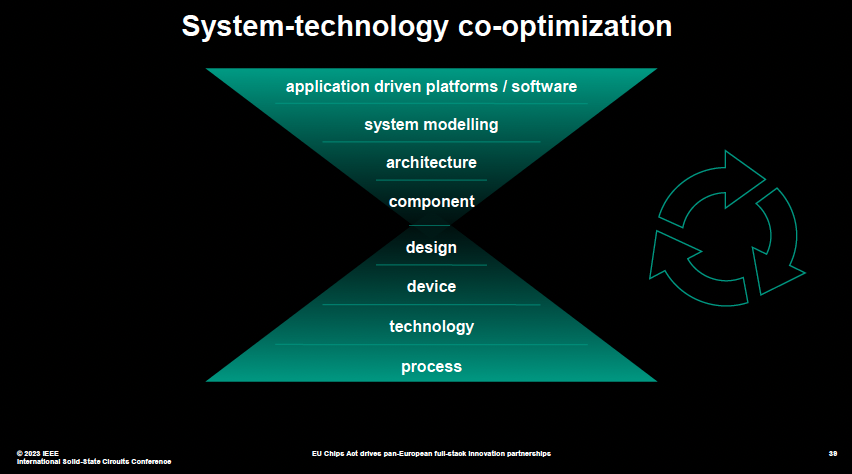

系统级创新,是协同设计上中下游多个环节,实现性能的提升。还有一种说法是,系统工艺协同优化。

系统工艺协同优化为一种“由外向内”的发展模式,从产品需支持的工作负载及其软件开始,到系统架构,再到封装中必须包括的芯片类型,最后是半导体制程工艺。

(系统工艺协同优化 图源:ISSCC2023大会)

简单来说,就是把所有环节共同优化,由此尽可能地改进最终产品。

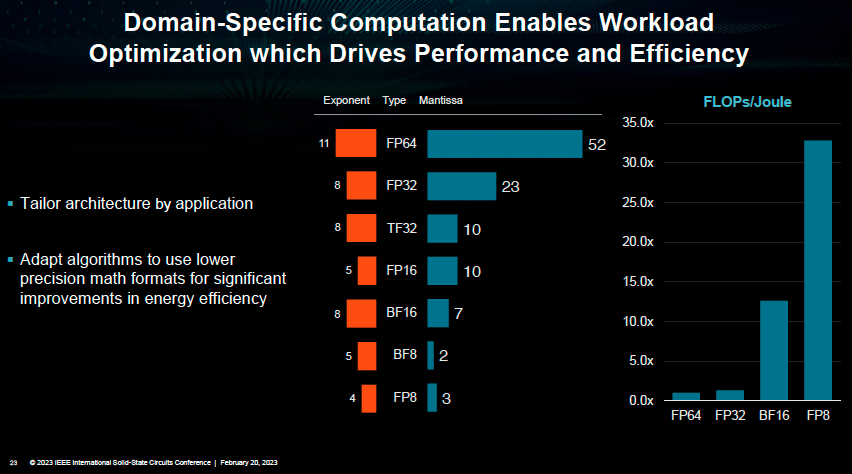

对此,Lisa Su给出了一个经典案例:在对模型算法层面使用创新数制(例如8位浮点数FP8)的同时,在电路层对算法层面进行优化支持,最终实现计算层面数量级的效率提升:相比传统的32位浮点数(FP32),进行系统级创新的FP8则可以将计算效率提升30倍之多。而如果仅仅是优化FP32计算单元的效率,无论如何也难以实现数量级的效率提升。

(特定域计算支持工作负载优化,从而提高性能和效率 图源:ISSCC2023大会)

这便是系统级创新成为关键路径的原因所在:如果电路设计仅仅停留在电路这一层——只是考虑如何进一步优化FP32计算单元的效率,无论如何也难以实现数量级的效率提升。

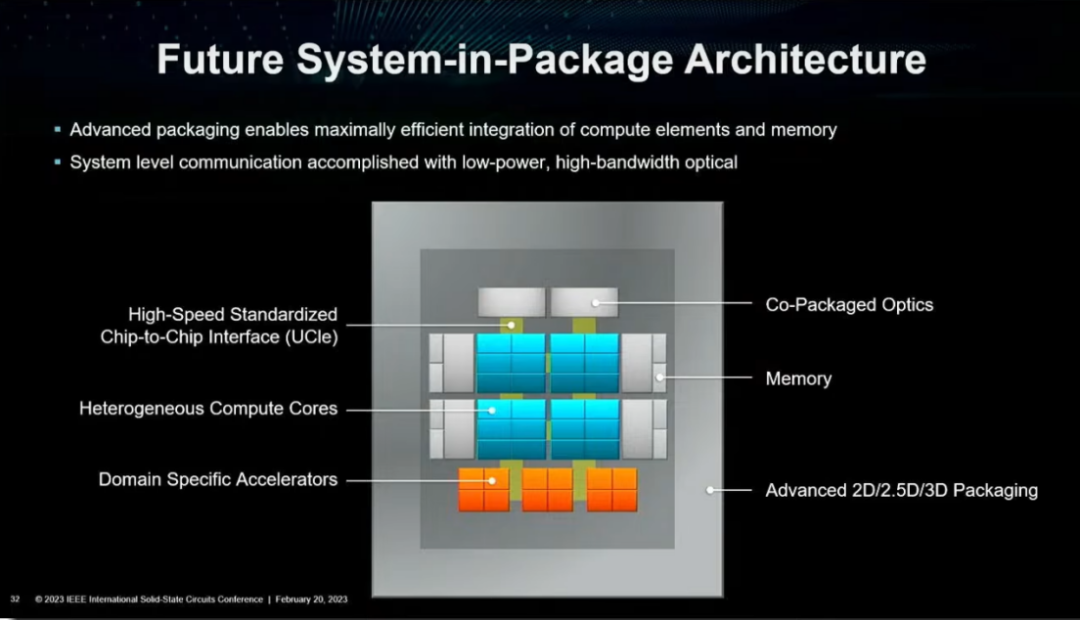

对此,在未来发展机会模块的演讲中,Lisa Su给出了未来系统级封装架构的大致模样:包含异构计算丛集,特定加速单元,先进封装技术,高速片间UCIe互联,存算一体等内存技术。

(未来的系统级封装架构 图源:ISSCC2023大会)

百舸争流,创新者先

技术路径、方案已然明确,接下来就是拼魄力的阶段。

每一个新兴技术的研发厂商,在前期无疑要面临技术探索碰壁,下游厂商不认同等各个层面的问题。而在早期,谁先预判到未来的发展趋势,并用于迈出探索的脚步,铺下合理的资源去尝试,就会抢到先机。

芯片巨头NVIDIA在这方面做出了很好的榜样。

当数据中心浪潮还未铺天盖地袭来、人工智能训练还是小众领域之时,英伟达已经投入重金,研发通用计算GPU和统一编程软件CUDA,为英伟达谋一个好差事——计算平台。

而在当时,让GPU可编程,是“无用且亏本”的:不知道其性能是否能够翻倍,但产品研发会翻倍。为此,没有客户愿意为此买单。但预判到单一功能图形处理器不是长远之计的英伟达毅然决定,在所有产品线上都应用CUDA。

在芯东西与英伟达中国区工程和解决方案高级总监赖俊杰博士的采访中,赖俊杰表示:“为了计算平台这一愿景,早期黄仁勋快速调动了英伟达上上下下非常多的资源。”

远见+重金投入,在2012年,英伟达拿到了创新者的奖励:2012年,深度学习算法的计算表现轰动学术圈,作为高算力且更为通用、易用的生产力工具,GPU+CUDA迅速风靡计算机科学界,成为人工智能开发的“标配”。

现如今,存算一体已显现出强大的性能,在人工智能神经网络、多模态的人工智能计算、类脑计算等大算力场景,有着卓越的表现。

国内厂商也在2019年前后纷纷布局存算一体,同时选择3D封装、chiplet等新兴技术,RRAM、SRAM等新兴存储器,突破算力天花板。

AI大算力芯片的战争,创新者为先。

结语:

ChatGPT火爆来袭,引发AI产业巨浪,国产AI芯片正迎来3.0时代;在3.0时代,更适配大模型的芯片架构——存算一体将崭露头角,同时系统级创新将成为未来的发展趋势,抢先下注的厂商将先吃到ChatGPT带来的红利。

-

gpu

+关注

关注

28文章

4798浏览量

129509 -

AI芯片

+关注

关注

17文章

1917浏览量

35274 -

大模型

+关注

关注

2文章

2660浏览量

3273

原文标题:亿分享 | 大模型背景下,AI芯片厂商面临怎样的机遇与挑战?

文章出处:【微信号:亿铸科技,微信公众号:亿铸科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

AMD MI300X AI芯片面临挑战

Cadence如何应对AI芯片设计挑战

产业"内卷化"下磁性元件面临的机遇与挑战

大模型背景下,AI芯片厂商面临怎样的机遇与挑战?

大模型背景下,AI芯片厂商面临怎样的机遇与挑战?

评论