7月6日至8日,第六届世界人工智能大会(WAIC2023)展览将于上海隆重举办,规模达5万平米,参展企业总数预计突破400家,创历年新高。

作为AI芯片领域的领军企业,昆仑芯再度牵手WAIC,倾力打造特装展区。届时,昆仑芯将携多层级产品矩阵亮相,生动展示公司十余年发展历程、产品优势性能、端到端解决方案及生态共创成果。现场更有工作人员进行互动讲解,欢迎莅临参观。

7月6日 1000

7月7日-8日 900

上海世博展览馆H2馆B601

展区亮点

昆仑芯系列产品展示

自2011年起,昆仑芯团队便基于真实AI场景需求研究AI计算加速,并于2017年正式提出自研XPU架构。基于该架构,昆仑芯先后打造两代云端AI芯片,并相继推出多款AI加速卡及AI加速器组产品。

昆仑芯1代AI芯片

昆仑芯1代AI芯片搭载昆仑芯自研XPU架构,采用14nm工艺,16GB HBM先进内存和2.5D封装技术,提供高达512 GB/s的内存带宽,256 TOPS的算力,是国内为数不多经历过互联网大规模核心算法考验的云端AI芯片。

昆仑芯AI加速卡K100

昆仑芯AI加速卡K100是专为边缘推理打造的AI加速卡,搭载昆仑芯1代AI芯片,支持128 TOPS@INT8算力,功耗低至75W,体积小巧,适用于各类智能边缘计算场景。

昆仑芯AI加速卡K200

昆仑芯AI加速卡K200搭载昆仑芯1代AI芯片,提供高达256 TOPS@INT8算力,HBM 16GB内存和512 GB/s访存带宽,支持计算机视觉、自然语言处理、语音等深度学习及传统机器学习任务,适用于云数据中心或其他高计算密度的训练和推理场景。

昆仑芯2代AI芯片

昆仑芯2代AI芯片搭载昆仑芯自研的新一代XPU-R架构,是国内首款采用GDDR6显存的通用AI芯片。采用7nm制程工艺,相比1代性能提升2-3倍,算力强大,整数精度算力达到256 TOPS,半精度为128 TFLOPS。

昆仑芯AI加速卡R100

昆仑芯AI加速卡R100是一款基于昆仑芯2代芯片,半高半长形态的AI加速卡,可提供高达128 TOPS@INT8 和最高170 TOPS@INT8 两种算力模式,为多样的边缘AI应用场景提供最优的性能及功耗比。

昆仑芯AI加速卡RG800

昆仑芯AI加速卡RG800基于昆仑芯自研的XPU-R架构,是一款定位于数据中心应用场景的AI加速卡,既可用于常规模型的训练,也可用于多业务并发的高性能AI推理应用,助力各行业实现降本增效,推进产业智能化升级。

昆仑芯AI加速卡R200

昆仑芯AI加速卡R200采用昆仑芯2代AI芯片,为数据中心高性能推理提供256 TOPS@INT8的强大算力,全面支持自然语言处理、计算机视觉、语音以及传统机器学习等各类人工智能任务。

昆仑芯AI加速器组R480-X8

昆仑芯AI加速器组R480-X8采用昆仑芯2代AI芯片,搭载8颗昆仑芯AI加速模块R300。R480-X8可实现芯片间互联,提供200 GB/s片间互联双向聚合带宽、高达1 PetaFLOPS@FP16的算力,多机可构建多节点大规模并行计算集群,满足大型模型训练和推理的需求。

左右滑动,了解昆仑芯两代芯片产品

昆仑芯第二代系列产品矩阵首次亮相

针对不同参数级别的昆仑芯第二代系列产品矩阵首次亮相,展现强大产品实力,为千行百业智能化升级注入“芯”动力。

昆仑芯AI加速卡R100

昆仑芯AI加速卡RG800

昆仑芯AI加速卡R200-8F

昆仑芯大模型端到端解决方案(继正式发布后首次参展)

昆仑芯赋能“智慧+”场景案例展示

昆仑芯始终坚持开拓创新,用更快、更强、更省的算力赋能AI应用场景,树立“智慧+”场景新标杆。昆仑芯结合互联网、金融、工业、交通、物流与园区等多场景的实际情况,采用先进AI技术成果打造端到端解决方案,提升管理水平与工作效率,降低人力成本与资金损耗。进入昆仑芯官网(www.kunlunxin.com)「解决方案」栏目,可了解更多昆仑芯行业解决方案详细信息。

继XceedCon2023昆仑芯首届生态大会后,本次展览,昆仑芯再次联合众多知名生态伙伴,集中展示搭载昆仑芯AI芯片及AI加速卡产品的板卡设计参考、服务器、加速模组、工控机、软硬一体机等硬件产品,覆盖互联网、大模型、智慧金融、智慧物流、智慧工业、智慧交通、智能制造等领域,全面展示昆仑芯技术实力及生态布局。

-

AI

+关注

关注

87文章

30084浏览量

268347 -

模型训练

+关注

关注

0文章

18浏览量

1330 -

昆仑芯片

+关注

关注

0文章

13浏览量

2265

原文标题:WAIC 2023 | 昆仑芯携生态伙伴重磅亮相世博展览馆,共筑AI算力芯基建

文章出处:【微信号:昆仑芯科技,微信公众号:昆仑芯科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

IBM与AMD携手将在IBM云上部署AMD Instinct MI300X加速器

FPGA和ASIC在大模型推理加速中的应用

NVIDIA助力丽蟾科技打造AI训练与推理加速解决方案

如何训练自己的AI大模型

AMD助力HyperAccel开发全新AI推理服务器

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

FCom富士晶体振荡器:AI PC和大型模型的关键支持者

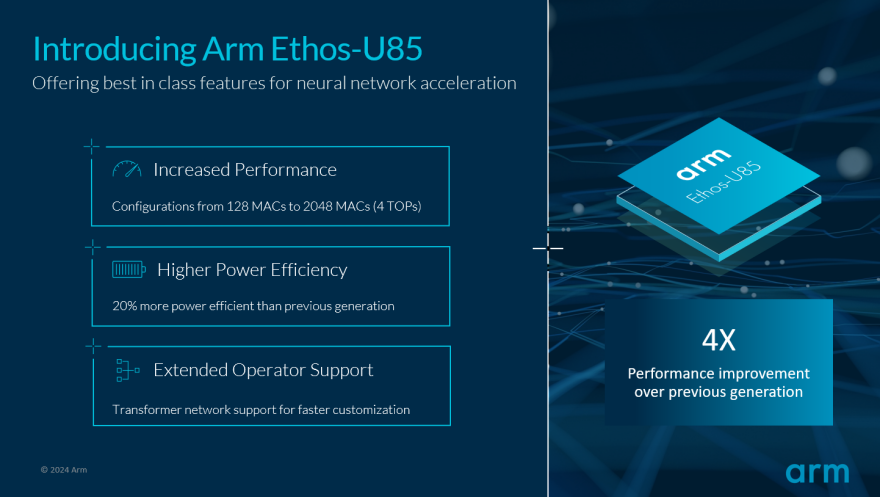

Arm推动生成式AI落地边缘!全新Ethos-U85 AI加速器支持Transformer 架构,性能提升四倍

Hitek Systems开发基于PCIe的高性能加速器以满足行业需求

昆仑芯AI加速器组R480-X8满足大型模型训练和推理的需求

昆仑芯AI加速器组R480-X8满足大型模型训练和推理的需求

评论