这是RISC-V跑大模型系列的第三篇文章,前面我们为大家介绍了如何在RISC-V下运行LLaMA,本篇我们将会介绍如何为LLaMA提供中文支持。

1.模型扩充

以下步骤在X86下进行:

1.1准备工作

| pip install protobuf==3.20.0 | 结构化数据存储格式 |

| pip install transformers | 把原版模型转换为HF格式 |

| pip install sentencepiece | 无监督的文本标记器和去标记器 |

| pip install peft | 使用LoRA的工具 |

1.2模型下载

下载LLaMA原版模型和中文扩充

LLaMA原版模型:

https://ipfs.io/ipfs/Qmb9y5GCkTG7ZzbBWMu2BXwMkzyCKcUjtEKPpgdZ7GEFKm/

中文扩充:

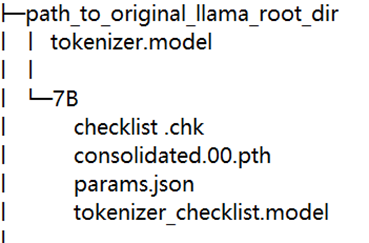

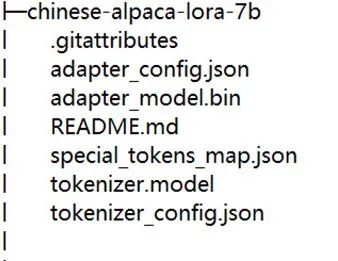

下载后的目录如下:

1.3合并模型

(1) 将LLaMA原版模型转换为Huggingface格式。这一步需要借助transformers提供的脚本convert_llama_weights_to_hf.py。

下载链接:https://github.com/huggingface/transformers/blob/main/src/transformers/models/llama/convert_llama_weights_to_hf.py

请执行以下命令:

python convert_llama_weights_to_hf.py --input_dir path_to_original_llama_root_dir --model_size 7B --output_dir path_to_original_llama_hf_dir

命令解释:将原版LLaMA的tokenizer.model放在--input_dir指定的目录,其余文件放在${input_dir}/${model_size}下。执行以下命令后,--output_dir中将存放转换好的Huggingface版权重。

(2) 合并LoRA权重,生成Huggingface全量模型,这一步需要借助:merge_llama_with_chinese_lora.py。

下载链接:

https://github.com/ymcui/Chinese-LLaMA-Alpaca/blob/main/scripts/merge_llama_with_chinese_lora.py

执行命令:

python merge_llama_with_chinese_lora.py --base_model path_to_original_llama_hf_dir --lora_model chinese-alpaca-lora-7b --output_dir path_to_output_dir

命令解释:这一步的参数可以参照上一步。

2.移植模型

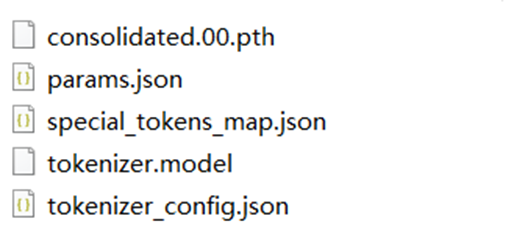

在完成前面的步骤后会得到一个path_to_output_dir的目录,目录内容如下:

将目录下的consolidate.00.path和params.json上传到RISC-V中的llama.cpp/models目录下,这一步可以借助scp来实现:scp “源文件路径” 账户@地址:目的路径。之后的步骤可以参考本系列的第二篇文章。链接如下:RISC-V 跑大模型(二):LLaMA零基础移植教程

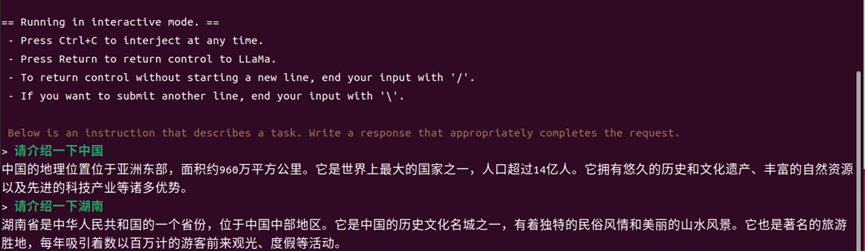

最后的运行效果:

3.结语

我们也为大家准备好已经扩展了中文的LLaMA供大家使用,只要扫描下面的二维码,进群即可获得下载地址。之后我们还会对LLaMA进行优化加速,敬请期待。

另外,RISC -V跑大模型系列文章计划分为四期:

3.RISC-V跑大模型(三):LLaMA中文扩充(本篇)

4.更多性能优化策略。(计划)

审核编辑 黄宇

-

处理器

+关注

关注

68文章

19351浏览量

230389 -

RISC-V

+关注

关注

45文章

2300浏览量

46276 -

大模型

+关注

关注

2文章

2493浏览量

2897 -

LLM

+关注

关注

0文章

294浏览量

355

发布评论请先 登录

相关推荐

RISC-V指令集概述

关于RISC-V学习路线图推荐

什么是RISC-V?以及RISC-V和ARM、X86的区别

RISC-V,即将进入应用的爆发期

RISC-V近期市场情况调研

加入全球 RISC-V Advocate 行列,共筑 RISC-V 的未来 !

RISC-V Summit China 2024 青稞RISC-V+接口PHY,赋能RISC-V高效落地

RISC-V Summit China 2024 | 青稞RISC-V+接口PHY,赋能RISC-V高效落地

为什么要有RISC-V

RISC-V的MCU与ARM对比

解锁RISC-V技术力量丨曹英杰:RISC-V与大模型探索

RISC-V 跑大模型(三):LLaMA中文扩展

RISC-V 跑大模型(三):LLaMA中文扩展

评论