来源:DeepHub IMBA

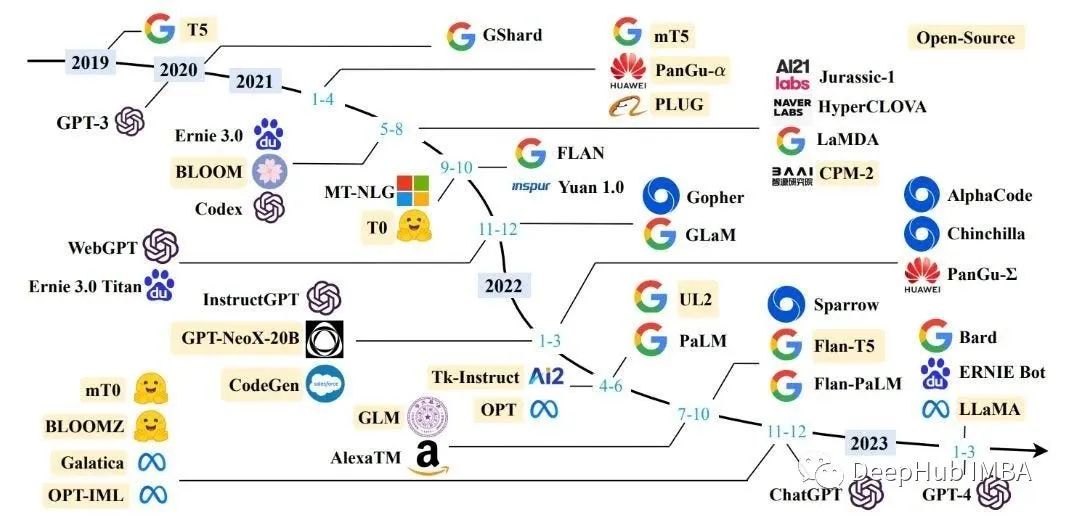

大型语言模型(llm)是一种人工智能(AI),在大量文本和代码数据集上进行训练。它们可以用于各种任务,包括生成文本、翻译语言和编写不同类型的创意内容。

今年开始,人们对开源LLM越来越感兴趣。这些模型是在开源许可下发布的,这意味着任何人都可以使用、修改和分发它们。这使得研究人员、开发人员和企业都可以尝试LLM,并为它们开发新的应用程序。使用开源llm有很多好处。首先它们通常比专业的LLM更价便宜。并且它们更加透明,这意味着研究人员可以研究它们是如何工作的以及它们是如何做出决定的。最主要的是它们更加灵活,可以针对不同的任务进行定制。 本文总结了当前可用的开源llm的全部(几乎全部)列表,以及有关其许可选项和源代码存储库的信息,希望对你有所帮助。▎SAIL 7B

本文总结了当前可用的开源llm的全部(几乎全部)列表,以及有关其许可选项和源代码存储库的信息,希望对你有所帮助。▎SAIL 7B基于LLaMa的搜索增强

参数:7B

许可类型:GPL-3.0

发布日期:2023年5月

论文:SAIL — Search Augmented Instruction Learning

▎Guanaco

采用高效微调方法QLoRA发布的LLM模型

参数:65B

许可类型:MIT

发布日期:2023年5月

论文:QLoRA — Efficient Finetuning of Quantized LLMs

▎RMKV

与transformer的LLM性能相当的RNN模型

参数:100M–14B

许可类型:Apache 2.0

发布日期:2023年5月

论文:Scaling RNN to 1.5B and Reach Transformer LM Performance

▎MPT-7B

MosaicML的基础系列模型

参数:7B

许可类型:Apache 2.0

发布日期:2023年5月

论文:MPT-7B — A New Standard for Open-Source, Commercially Usable LLMs

▎OpenLLaMa

在RedPajama数据集上训练的Meta AI的LLaMA 7B的另一个开源复制。

参数:3,7B

许可类型:Apache 2.0

发布日期:2023年5月

论文:Meet OpenLLaMA — An Open-Source Reproduction of Meta AI’s LLaMA Large Language Model

▎RedPajama-INCITE

基于RedPajama数据集上训练的指令调整和聊天Pythia模型。

参数:3B, 7B

许可类型:Apache 2.0

发布日期:2023年5月

论文:RedPajama-INCITE family of models including base, instruction-tuned & chat models

▎h2oGPT

H2O的微调框架和文档问答功能的聊天机器人UI

参数:12B,30B

许可类型:Apache 2.0

发布日期:2023年5月

论文:Building the World’s Best Open-Source Large Language Model:H2O.ai’s Journey

▎FastChat-T5

通过微调Flan-t5-xl对从ShareGPT收集的用户共享对话进行训练的聊天机器人

参数:3B

许可类型:Apache 2.0

发布日期:2023年4月

论文:FastChat-T5 — our compact and commercial-friendly chatbot!

▎GPT4All

用于训练和部署强大的定制llm的完整工具系统

参数:7–13B

许可类型:MIT

发布日期:2023年4月

论文:GPT4All:An ecosystem of open-source on-edge large language models.

▎MiniGPT-4

基于BLIP-2和Vicuna LLM的Visual LLM模型

参数:13B

许可类型:BSD-3-Clause

发布日期:2023年4月

论文:MiniGPT-4 — Enhancing Vision-Language Understanding withAdvanced Large Language Models

▎StableLM

StableLM的LLM模型系列

参数:7B

许可类型:CC BY-NC-SA-4.0

发布日期:2023年4月

论文:Stability AI Launches the First of its StableLM Suite of Language Models

▎BloomZ

通过多任务微调实现跨语言泛化

参数:176B

许可类型:Apache 2.0

发布日期:2023年4月

论文:Cross-lingual Generalization through Multitask Finetuning

▎Dolly

Pythia 12B LLM在Databricks ML平台上训练的模型

参数:12B

许可类型:Apache 2.0

发布日期:2023年4月

论文:Free Dolly — Introducing the World’s First Truly Open Instruction-Tuned LLM

▎Baize Chatbot

基于LLaMa的开源聊天模型

参数:30B

许可类型:GPL-3.0 license

发布日期:2023年4月

论文:Baize — An Open-Source Chat Model with Parameter-Efficient Tuning on Self-Chat Data

▎ColossalChat

由ColossalAI开源发布的一个完整的RLHF流程训练的模型

参数:N/A

许可类型:Apache 2.0

发布日期:2023年4月

论文:ColossalChat — An Open-Source Solution for Cloning ChatGPT With a Complete RLHF Pipeline

▎Lit LLaMa

来自Lightning AI的LLaMA的开源实现

参数:13B

许可类型:Apache 2.0

发布日期:2023年4月

论文:Why We’re Building Lit-LLaMA

▎Cerebras-GPT

开放的,计算效率高的,大型语言模型

参数:111M-13B

许可类型:Apache 2.0

发布日期:2023年3月

论文:Cerebras-GPT — Open Compute-Optimal Language ModelsTrained on the Cerebras Wafer-Scale Cluster

▎Open Flamingo

Deepmind的Flamingo模型的开源实现

参数:9B

许可类型:MIT License

发布日期:2023年3月

论文:Openflamingo — An Open-source Framework For Training Vision-language Models With In-context Learning

▎Chat GLM

使用开放式双语(中英文)双向密集预训练模型

参数:6B-130B

许可类型:Apache 2.0

发布日期:2023年3月

论文:GLM-130B:An Open Bilingual Pre-trained Model

▎DLite

通过微调Alpaca数据集上最小的GPT-2模型

参数:124M

许可类型:Apache 2.0

发布日期:2023年3月

论文:Introducing DLite, a Lightweight ChatGPT-Like Model Based on Dolly

▎Alpaca 7B

描述:斯坦福大学发布的指令遵循LLaMA模型

参数:7B

许可类型:Apache 2.0

发布日期:2023年3月

论文:Alpaca — A Strong, Replicable Instruction-Following Model

▎Flan UL2

在预训练的UL2检查点上训练Flan 20B模型。

参数:20B

许可类型:MIT License

发布日期:2023年3月

论文:A New Open Source Flan 20B with UL2

▎Flan-T5

T5在各种数据集上的指令微调,提高预训练语言模型的可用性

参数:60M–11B

许可类型:Apache 2.0

发布日期:2023年2月

论文:Scaling Instruction-Finetuned Language Models

总结最后再补充2个刚刚发布的模型,一个是llama-2,这个我们文章也在前几天介绍了微调和使用的方法。另外一个就是昨天刚看到的新闻,stabilityai发布的 FreeWilly2,它是在 Llama2 70B 上微调的结果,目前在open_llm_leaderboard上排第一。开源大型语言模型正在迅速发展,开源社区发布了许多模型。这些模型为开发人员、研究人员和爱好者提供了一个非常大机会,可以在没有专有系统的情况下试验尖端的语言技术。随着越来越多的组织和个人为这些模型的发展做出贡献,我们可以期待看到更强大、更容易使用和更创新的语言模型,它们将塑造自然语言处理的未来。作者:Manikanth

END

欢迎加入Imagination GPU与人工智能交流2群

(添加请备注公司名和职称)

推荐阅读 对话Imagination中国区董事长:以GPU为支点加强软硬件协同,助力数字化转型 下载白皮书 | 通过Photon架构创建身临其境的图形体验

Imagination Technologies是一家总部位于英国的公司,致力于研发芯片和软件知识产权(IP),基于Imagination IP的产品已在全球数十亿人的电话、汽车、家庭和工作 场所中使用。获取更多物联网、智能穿戴、通信、汽车电子、图形图像开发等前沿技术信息,欢迎关注 Imagination Tech!

原文标题:2023年发布的25个开源大型语言模型总结

文章出处:【微信公众号:Imagination Tech】欢迎添加关注!文章转载请注明出处。

-

imagination

+关注

关注

1文章

573浏览量

61323

原文标题:2023年发布的25个开源大型语言模型总结

文章出处:【微信号:Imgtec,微信公众号:Imagination Tech】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

谷歌计划12月发布Gemini 2.0模型

基于CPU的大型语言模型推理实验

英伟达开源Nemotron-4 340B系列模型,助力大型语言模型训练

谷歌发布轻量级开源人工智能模型Gemma

谷歌大型模型终于开放源代码,迟到但重要的开源战略

机器人基于开源的多模态语言视觉大模型

2023年发布的25个开源大型语言模型总结

2023年发布的25个开源大型语言模型总结

评论