业界首款8层堆叠的24GB容量第二代HBM3,带宽超过1.2TB/s,先进的1β制程节点提供卓越能效。

2023年7月27日,中国上海——Micron Technology Inc.(美光科技股份有限公司,纳斯达克股票代码:MU)今日宣布,公司已开始出样业界首款8层堆叠的24GB容量第二代HBM3内存,其带宽超过1.2TB/s,引脚速率超过9.2Gb/s,比当前市面上现有的HBM3解决方案性能可提升最高50%。美光第二代HBM3产品与前一代产品相比,每瓦性能提高2.5倍,创下了关键型人工智能(AI)数据中心性能、容量和能效指标的新纪录,将助力业界缩短大型语言模型(如GPT-4及更高版本)的训练时间,为AI推理提供高效的基础设施,并降低总体拥有成本(TCO)。

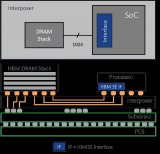

美光基于业界前沿的1β DRAM制程节点推出高带宽内存(HBM)解决方案,将24Gb DRAM裸片封装进行业标准尺寸的8层堆叠模块中。此外,美光12层堆叠的36GB容量产品也将于2024年第一季度开始出样。与当前市面上其他的8层堆叠解决方案相比,美光HBM3解决方案的容量提升了50%。美光第二代HBM3产品的性能功耗比和引脚速度的提升对于管理当今AI数据中心的极端功耗需求至关重要。美光通过技术革新实现了能效的显著提升,例如与业界其他HBM3解决方案相比,美光将硅通孔(TSV)数量翻倍,增加5倍金属密度以降低热阻,以及设计更为节能的数据通路。

美光作为2.5D/3D堆叠和先进封装技术领域长久以来的存储领导厂商,有幸成为台积电3DFabric联盟的合作伙伴成员,共同构建半导体和系统创新的未来。在第二代HBM3产品开发过程中,美光与台积电携手合作,为AI及高性能计算(HPC)设计应用中顺利引入和集成计算系统奠定了基础。台积电目前已收到美光第二代HBM3内存样片,正与美光密切合作进行下一步的评估和测试,助力客户的下一代高性能计算应用创新。

美光第二代HBM3解决方案满足了生成式AI领域对多模态、数万亿参数AI模型日益增长的需求。凭借高达24GB的单模块容量和超过9.2Gb/s的引脚速率,美光HBM3能使大型语言模型的训练时间缩短30%以上,从而降低总体拥有成本。此外,美光HBM3将触发每日查询量的显著增加,从而更有效地利用训练过的模型。美光第二代HBM3内存拥有业界一流的每瓦性能,将切实推动现代AI数据中心节省运营开支。在已经部署的1,000万个图形处理器(GPU)用例中,单个HBM模块可节约5W功耗,能在五年内节省高达5.5亿美元的运营费用。

美光副总裁暨计算与网络事业部计算产品事业群总经理Praveen Vaidyanathan表示:“美光第二代HBM3解决方案旨在为客户及业界提供卓越的人工智能和高性能计算解决方案。我们的一个重要考量标准是,该产品在客户平台上是否易于集成。美光HBM3具有完全可编程的内存内建自测试(MBIST)功能,可在完整规格的引脚速度下运行,使美光能为客户提供更强大的测试能力,实现高效协作,助力客户缩短产品上市时间。”

英伟达超大规模和高性能计算副总裁Ian Buck表示:“生成式AI的核心是加速计算,HBM的高带宽至关重要,并带来更出色的能效。我们与美光在众多产品领域保持了长期合作,非常期待与美光在第二代HBM3产品上继续合作,加速AI创新。”

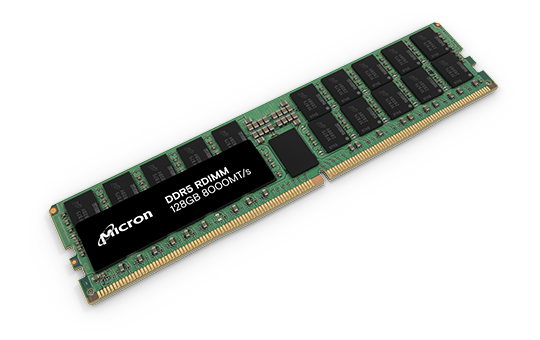

第二代HBM3是美光领先技术的又一个里程碑。美光此前宣布推出基于1α(1-alpha)节点、24Gb单块DRAM裸片的96GB容量DDR5模组用于大容量服务器解决方案;如今推出基于1β节点、24Gb单块DRAM裸片的24GB容量HBM3产品,并计划于2024年上半年推出基于1β节点、32Gb单块DRAM裸片的128GB容量DDR5模组。这些新品展现了美光在AI服务器领域的前沿技术创新。

2023年7月27日,中国上海——Micron Technology Inc.(美光科技股份有限公司,纳斯达克股票代码:MU)今日宣布,公司已开始出样业界首款8层堆叠的24GB容量第二代HBM3内存,其带宽超过1.2TB/s,引脚速率超过9.2Gb/s,比当前市面上现有的HBM3解决方案性能可提升最高50%。美光第二代HBM3产品与前一代产品相比,每瓦性能提高2.5倍,创下了关键型人工智能(AI)数据中心性能、容量和能效指标的新纪录,将助力业界缩短大型语言模型(如GPT-4及更高版本)的训练时间,为AI推理提供高效的基础设施,并降低总体拥有成本(TCO)。

美光基于业界前沿的1β DRAM制程节点推出高带宽内存(HBM)解决方案,将24Gb DRAM裸片封装进行业标准尺寸的8层堆叠模块中。此外,美光12层堆叠的36GB容量产品也将于2024年第一季度开始出样。与当前市面上其他的8层堆叠解决方案相比,美光HBM3解决方案的容量提升了50%。美光第二代HBM3产品的性能功耗比和引脚速度的提升对于管理当今AI数据中心的极端功耗需求至关重要。美光通过技术革新实现了能效的显著提升,例如与业界其他HBM3解决方案相比,美光将硅通孔(TSV)数量翻倍,增加5倍金属密度以降低热阻,以及设计更为节能的数据通路。

美光作为2.5D/3D堆叠和先进封装技术领域长久以来的存储领导厂商,有幸成为台积电3DFabric联盟的合作伙伴成员,共同构建半导体和系统创新的未来。在第二代HBM3产品开发过程中,美光与台积电携手合作,为AI及高性能计算(HPC)设计应用中顺利引入和集成计算系统奠定了基础。台积电目前已收到美光第二代HBM3内存样片,正与美光密切合作进行下一步的评估和测试,助力客户的下一代高性能计算应用创新。

美光第二代HBM3解决方案满足了生成式AI领域对多模态、数万亿参数AI模型日益增长的需求。凭借高达24GB的单模块容量和超过9.2Gb/s的引脚速率,美光HBM3能使大型语言模型的训练时间缩短30%以上,从而降低总体拥有成本。此外,美光HBM3将触发每日查询量的显著增加,从而更有效地利用训练过的模型。美光第二代HBM3内存拥有业界一流的每瓦性能,将切实推动现代AI数据中心节省运营开支。在已经部署的1,000万个图形处理器(GPU)用例中,单个HBM模块可节约5W功耗,能在五年内节省高达5.5亿美元的运营费用。

美光副总裁暨计算与网络事业部计算产品事业群总经理Praveen Vaidyanathan表示:“美光第二代HBM3解决方案旨在为客户及业界提供卓越的人工智能和高性能计算解决方案。我们的一个重要考量标准是,该产品在客户平台上是否易于集成。美光HBM3具有完全可编程的内存内建自测试(MBIST)功能,可在完整规格的引脚速度下运行,使美光能为客户提供更强大的测试能力,实现高效协作,助力客户缩短产品上市时间。”

英伟达超大规模和高性能计算副总裁Ian Buck表示:“生成式AI的核心是加速计算,HBM的高带宽至关重要,并带来更出色的能效。我们与美光在众多产品领域保持了长期合作,非常期待与美光在第二代HBM3产品上继续合作,加速AI创新。”

第二代HBM3是美光领先技术的又一个里程碑。美光此前宣布推出基于1α(1-alpha)节点、24Gb单块DRAM裸片的96GB容量DDR5模组用于大容量服务器解决方案;如今推出基于1β节点、24Gb单块DRAM裸片的24GB容量HBM3产品,并计划于2024年上半年推出基于1β节点、32Gb单块DRAM裸片的128GB容量DDR5模组。这些新品展现了美光在AI服务器领域的前沿技术创新。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

发布评论请先 登录

相关推荐

美光:人工智能影响PC内存的供需平衡

美光是内存业务的主要参与者之一,包括分别用于SSD和RAM的NAND和DRAM。

“我们三巨头,海力士、我们、三星,都在花费大量的精力和财力打造HBM 产品,”美

HBM4需求激增,英伟达与SK海力士携手加速高带宽内存技术革新

随着生成式AI技术的迅猛发展和大模型参数量的急剧增加,对高带宽、高容量存储的需求日益迫切,这直接推动了高

美光科技推出多路复用双列直插式内存模块(MRDIMM)

基础设施的效能与价值。专为那些需要单个DIMM插槽内存超过128GB的应用场景设计,美光MRDIMM在带宽、容量、延迟及能效方面均展现出显著

HBM投资增加,美光2024年资本支出预测上调至80亿美元

美光科技适度调整了2024年的资本开支预估,加大对高带宽存储(HBM)半导体生产线的投入力度,以迎合人工

什么是HBM3E内存?Rambus HBM3E/3内存控制器内核

Rambus HBM3E/3 内存控制器内核针对高带宽和低延迟进行了优化,以紧凑的外形和高能效的封装为人工智能训练提供了最大的

发表于 03-20 14:12

•2286次阅读

美光科技开始量产HBM3E高带宽内存解决方案

美光科技股份有限公司(Micron Technology, Inc.)是全球内存与存储解决方案的领先供应商,近日宣布已经开始量产其HBM3E高

美光量产行业领先的HBM3E解决方案,加速人工智能发展

2024 年 3 月 4 日全球内存与存储解决方案领先供应商 Micron Technology, Inc.(美光科技股份有限公司,纳斯达克股票代码:MU)近日宣布已开始量产其 HBM

美光高性能内存和存储助力荣耀 Magic6 Pro 智能手机提升边缘 AI 体验

移动闪存助力荣耀最新款旗舰智能手机荣耀 Magic6 Pro 提供端侧人工智能体验。该手机支持 70 亿参数的大语言模型(LLM)——“魔法大模型”(MagicLM),开创了端侧生成

美光率先为业界伙伴提供基于 32Gb 单裸片 DRAM 的高速率、低延迟 128GB 大容量 RDIMM 内存

美光基于 1β 先进制程的 DRAM 速率高达 8,000 MT/s,为生成式 AI 等内存密集型应用提供

发表于 11-24 15:08

•1801次阅读

美光推出性能更出色的大容量高带宽内存 (HBM) 助力生成式人工智能创新

美光推出性能更出色的大容量高带宽内存 (HBM) 助力生成式人工智能创新

评论