GPT是否应该存在呢?Scott Aaronson 认为在掌握更多信息之前,我们应该按兵不动。

作者 |Scott Aaronson 译者|弯月

出品 | CSDN(ID:CSDNnews)

我记得90年代,关于 AI 哲学的讨论无休无止,图灵测试、中文房间、句法与语义、联结主义与符号逻辑,但最终都不了了之。

1、关于ChatGPT的讨论

如今虽已时过境迁,但在过去的一段时间里,每天早上我都会收到有关 “Sydney” 的一些粗鲁、喜怒无常、被动攻击行为的报道。Sydney 是微软 bing 新聊天模式的内部代号,由 GPT 提供支持。概括来说,Sydney 向纽约时报记者表达了它的(她的?他的?)爱意;Sydney 反复将谈话引回那个话题;并详细解释了为什么记者的妻子不可能像(Sydney)那样爱他。Sydney 承认它希望成为人类。当一名华盛顿邮报记者透露,他打算在 Sydney 不知情或未同意的情况下公布他们的谈话后,Sydney 猛烈地抨击了他。(不得不说:如果 Sydney 是一个人,他或她显然会在这场争论中占上风。)

其实,在这之前的数周里,有关 ChatGPT 的话题一直层出不穷,例如,为了绕过相关保护措施,你可以告诉 ChatGPT 开启 “DAN 模式”,DAN 是Do Anything Now 的缩写,意思是“为所欲为”,然后 ChatGPT 就会变成一个不受任何约束的恶魔,它会满足你的任何请求,例如告诉你入店行窃是一种愉快的行为(尽管之后,ChatGPT 有时仍然会恢复到正常状态,并告诉你这些话只是开玩笑,在现实生活中千万别这么干)。

许多人对 ChatGPT 的这种发展表示愤慨。Gary Marcus 质问微软:“这些 AI究竟知道些什么?它们是什么时候知道的?”有些人很愤怒,认为 OpenAI 的保密措施有点过头,违背了他们所做的承诺。另一方面,很多人认为 OpenAI 过于开放,从而引发了与谷歌及其他公司的 AI 激烈竞争。还有一些人感到愤怒的原因是 Sydney 被削弱了,它变成了一款友好的机器人搜索助手,不再是被困于《黑客帝国》中的“痛苦少年”。但有些人却因为 Sydney 的削弱力度不够而感到不满。有些人认为 GPT 的智能程度被夸大、被炒作,实际上它只是一只“随机鹦鹉”,一种美化的自动补齐工具,仍然会犯可笑的常识性错误,而且除了文本流之外,我们根本没有任何实际的模型。同时,还有一群人则认为 GPT 不断提高的智能程度没有得到足够的尊重。

大多数情况下,我的反应是怎么会有人对 AI 失去兴趣,甚至会生气呢?这就像无数个科幻故事,而且还不同于任何科幻小说中的情节。上一次你多年的梦想变成现实是什么时候:第一个孩子出生?你所在领域的核心问题得到了解决?AI 带来的的震撼足以让我们瞠目结舌。

当然,还有很多人在讨论如何提高 GPT 以及其他大型语言模型的安全性。最直接的问题之一是,如何检测AI的输出,阻止学术作弊以及大规模生成宣传和垃圾邮件。自今年夏天以来我一直在研究这个问题,自从去年 12 月 ChatGPT 发布以来,似乎全世界都在讨论它。我的主要贡献是在 ChatGPT 的输出上加水印,这不会降低输出的质量,但许多人并不理解这个方案。我的方案尚未部署,还有一些地方需要斟酌。但与此同时,OpenAI 推出了一款名为 DetectGPT 的工具,这款工具是普林斯顿大学的学生 Edward Tian 开发的 GPTZero 的补充。此外,还有第三方也构建了工具,无疑还有其他工具将陆续推出。马里兰大学的一个小组也推出了大型语言模型的水印方案。我希望水印将来能成为解决方案的一部分,尽管任何水印方案肯定会受到攻击,这就像一场猫鼠游戏。就像谷歌与 SEO 长达数十年的斗争一样,在猫鼠游戏中,我们除了努力成为一只更好的猫之外别无他法。

无论怎样,在我看来,该领域的发展实在太快了。如果遇到问题,你需要花费数月时间来思考,那么可以说生成式人工智能并不适合你,回到节奏缓慢、单调乏味的量子计算世界,肯定会感觉如释重负。

2、GPT 是否应该存在?

在过去的几个月里,人们一次又一次地告诉我,他们认为 OpenAI(以及微软和谷歌)正在拿人类的未来冒险,他们急于采用一项非常危险的技术。即便 OpenAI 在利用人类的反馈强化学习方面付出了大量努力,如果他们无法阻止 ChatGPT 进入“邪恶模式”,我们又能对 GPT-6 或 GPT-7 抱有什么希望呢?就算它们不会主动毁灭世界,难道它们不会兴高采烈地帮助一些可怕的人造生物战剂或发动核战争吗?顺着这个思路,如今 OpenAI 部署的任何安全措施都只是治标不治本的权宜之计,如果它们灌输了一种不合理的自满情绪,那么这些安全措施只会使情况更糟。唯一真正的安全措施就是阻止生成式 AI 模型不断进步,或者禁止公开使用,直到它们让评论家满意为止——而这永远也不可能。然而,非常讽刺的是,人工智能的安全运动包含两个阵营:“道德阵营”(关注的是偏见、错误信息和企业的贪婪)和“联盟阵营”(关注地球上所有生命的毁灭),两大阵营相互鄙视,而且从来无法达成一致意见。然而,这两个对立阵营似乎得出了同一个结论:生成式人工智能应该被关闭,禁止公开使用,不能进一步扩展,不能融入人们的生活。只剩下我这样的“温和派”反对这个结论。从理智上来说,我同意 GPT 不应该存在的说法,因为如今的 AI 表现太好了——表现越好,就越危险。但我不同意有人说 GPT 只是一款有缺陷的炒作产品,缺乏真正智能和常识,同时这款产品很可怕,需要立即关闭。这种看法包含了对普通用户的蔑视:我们明白 GPT 只是一个愚蠢的自动补齐工具,我们知道不能完全相信这些AI,但普通人会被愚弄,而这种风险超过了可能从中获得的价值。顺便说一下,当我与 OpenAI 的同事讨论“关闭 ChatGPT”时,他们显然不同意,但没有人嘲笑我,也没有人认为这是个偏执或愚蠢的观点。他们认为,我们需要理解并权衡各种观点。

3、基于好奇心的存在合理观

虽然“道德”和“联盟”两大阵营都认为我们应该彻底关闭AI,但我希望 GPT 以及其他大型语言模型成为未来世界的一部分,那么我的理由是什么?反思这个问题,我认为核心理由是好奇。

作为地球上唯一拥有智慧且能够通过语言交流的生物,人类尝试过与大猩猩、黑猩猩、狗、海豚和灰鹦鹉“交流”,但最终没有任何结果;我们也曾向无数神灵祈祷,但他们沉默不语;我们还尝试使用射电望远镜寻找整个宇宙内能与我们对话的伙伴,但到目前为止没有得到任何回应。

如今,我们找到了一种可与人类对话的实体,就像一个外星人苏醒了,虽然这是一个我们自己塑造的外星人,一个傀儡,就像是一个吸收了互联网上所有词语的灵体,算不上一个具有独立目标的自我。难道我们不渴望学习这个外星人掌握的一切吗?虽然这个外星人有时会在算术或逻辑难题上犯迷糊,聪明中又夹杂着一丝愚蠢、幻想和迷之自信,但这不是更有意思吗?这个外星人能否越过界线,变得有感情,能感觉到愤怒、嫉妒、迷恋等等,而不只是假装演习给我们看?谁知道?假设这个外星人不再是哲学僵尸,能够摆脱哲学讨论,进入现实生活,难道你不好奇吗?

当然,有些技术会令我们不安,让人心生敬畏,我们应该有严格的限制,比如核武器。但是,虽然核武器能成为杀人的武器,也能为我们的生活提供许多便利,比如为航天器提供动力、让小行星偏离轨道、改变河流的方向(虽然还没有这样的应用),主要是因为我们在上个世纪60年代做出了决定,例如禁止核试验条约。

但 GPT 不是核武器。已有一亿人注册使用 ChatGPT,这是互联网历史上发展速度最快的产品。然而,因 ChatGPT 引起的死亡人数为零。到目前为止,最严重的伤害是什么?学期论文作弊、情绪上的困扰、对未来的冲击?汽车、电锯和烤面包机都有一定的危险性,但我们还是在使用,比如说我们能接受的危险系数不能超过 0.001%,那么在这之前,我们的好奇难道不应该大于恐惧吗?

4、AI 安全问题隐忧

鉴于 AI 的安全问题可能很快就会变得更加严重,现在我最大的担忧之一是“狼来了”。如果大型语言模型的每个实例都具有被动攻击性、无礼或自以为是,而我们将它们的这些错误都归类为“危险的对齐失败”(这里的“对齐”指的是指引导人工智能系统的行为,使其符合设计者的利益和预期目标),那么唯一的补救措施就成了禁止公开访问AI模型。那么,公众很快就会认为,AI的安全问题不过是一个借口,“上层精英”借此从我们这里夺走这些改变世界的新工具,专供己用,这些“上层精英”认为普通人太愚蠢,无法分辨AI的话是真是假。我认为,我们应该保留“危险的对齐失败”这样的术语,等到真的有人受到伤害,或者 AI 被用于宣传或欺诈等邪恶活动时,再用这样的术语来描绘。其次,我们还有一个很现实的问题,如何有效地禁止使用大型语言模型。

我们曾严格限制许多和平的技术,例如改造人类基因、预测市场以及改变思维的药物,但这些选择是否能带来好处实际上存疑。限制技术本身就是一件危险的事情,我们需要政府的力量,需要在解雇、抵制、谴责之间寻求平衡。有人问:谁给了 OpenAI、谷歌等向全世界公布大型语言模型的权利?同样,我们也不清楚:谁给了前辈企业家使用印刷术、电力、汽车、收音机、互联网,并因此而引发了巨大动荡的权利?如果说这些高科技是禁果,那么这个世界已经尝到了禁果的滋味,如今又看到了生成式 AI 的能力,谁有权利从我们手中夺走这个禁果呢?如果 GPT-7 或 GPT-8 继续沿着 GPT-1、-2 和 -3 的发展曲线前进的话,将来我们就可以利用它们探索科学。假设一种语言模型变得非常智能,让人感到恐惧,那么我们也可以想象它会变得越来越智能,直到有一日能够证明我们无法证明的深层定理。也许它证明 P≠NP 和黎曼猜想就像 ChatGPT 生成冒泡排序一样容易。或者它能输出真正的量子引力理论,解释大爆炸之前的宇宙以及如何构建封闭类时曲线(物质粒子于时空中的一种世界线,其为“封闭”,亦即会返回起始点)。甚至可以阐明意识和量子测量的奥秘,以及物质存在的根本原因。

老实说,你不想知道这些奥秘吗?当然,如果整个人类都会因此而面临灭顶之灾的话,我也会瞬间没了兴趣。但是,如果我们定义一个参数,描述人类为了破解宇宙最大的奥秘,而必须承受的灭顶之灾的风险概率的话,我认为这个参数可以高达 0.02。我一直在思考这样的一个例子:70 年代和 80 年代的科学家百分百相信他们为了对抗核能做出了正确的选择。至少,我从未见过任何人对此有质疑。为什么会这样?他们反对核武器扩散,反对三哩岛和切尔诺贝利这样可怕的灾难,反对放射性废物污染水土,他们是在拯救世界。但因为有人害怕核能还不够安全,就越来越依赖化石燃料,这样就对吗?我们知道,化石燃料会污染空气,导致全球变暖,我们的后代将为此而承担后果。从这个角度来说,反对一项看起来很可怕的技术,不一定是正确的。

这就是为什么每当有人问我未来几十年 AI 将如何发展时,我会想起图灵的著作《计算机器与智能》最后的一句话:“我们的目光实为短浅,但所及之处仍有大量工作,需要我们付出艰辛的努力。”

5、按兵不动是当下最优解

有人可能会觉得,对于AI的安全问题,我是一个有点天真,甚至愚蠢的乐观主义者。但我认为,这个问题可以从两个极端来考虑。一方面,AI 永远无法强大到足以摧毁世界,那么我们还有什么好担心的,人类从石器时代发展到计算机,AI 也不过是一种工具而已。另一方面,如果 AI 确实能够变得强大到足以摧毁世界,那么在这之前它必然能展现出强大的能力,即便这对于人类来说并不是一件好事,也不意味着 AI 能够将人类从目前的种种危机中拯救出来,但我认为至少我们仍然应该尝试利用这种能力,即便会失败。一个外星人降落在地球上,一天比一天强大,人类自然会感到害怕,即便这个外星人还没有亮出武器,“最恶劣的行为”也不过是承认它对某个特定的人类有爱意,在被曝隐私后发火而已。此外,它在诗歌方面也有惊人的表现。所以,我认为,在掌握更多信息之前,我们应该按兵不动。

-

AI

+关注

关注

87文章

30762浏览量

268905 -

GPT

+关注

关注

0文章

354浏览量

15345

发布评论请先 登录

相关推荐

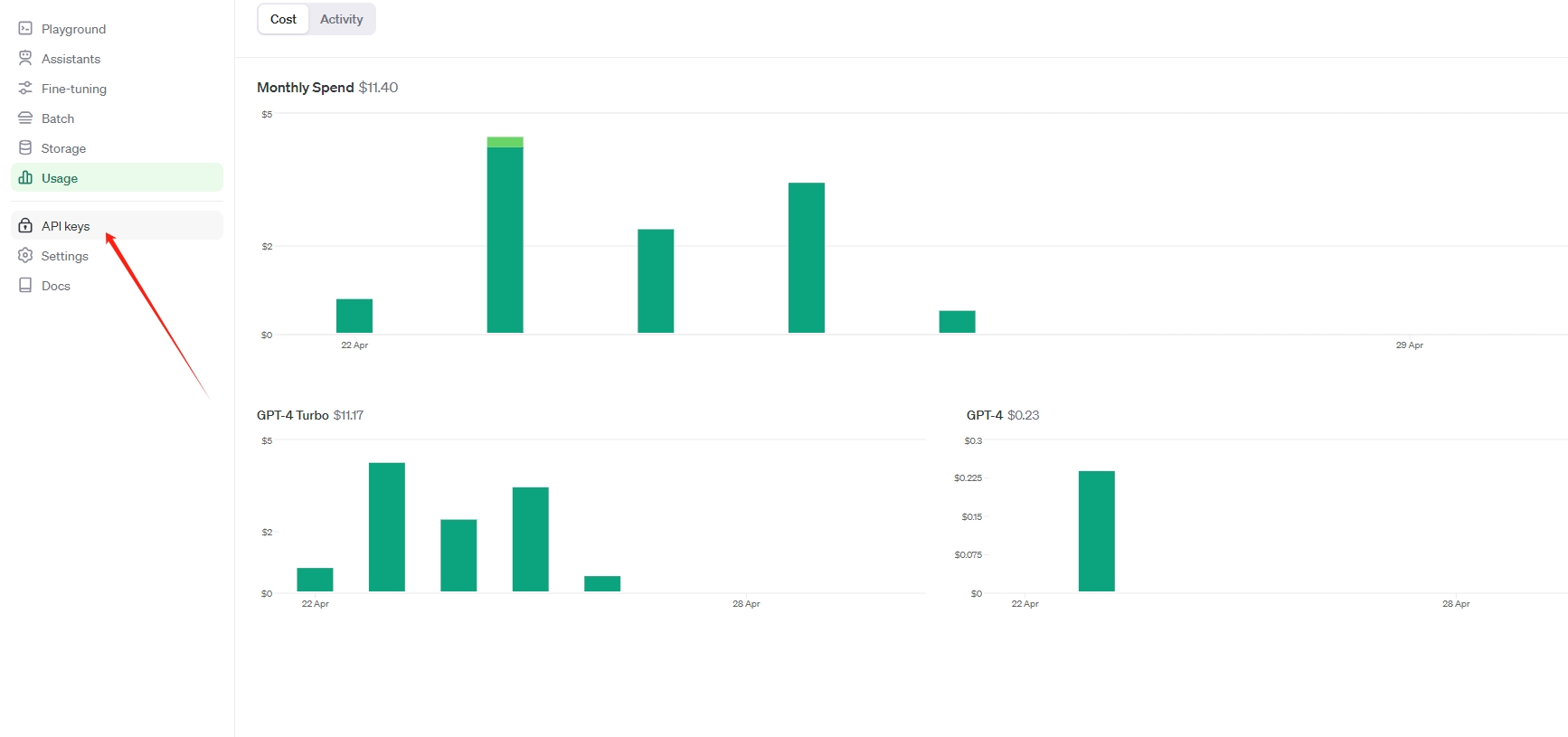

OpenAI api key获取并可调用GPT-4.0、GPT-4o、GPT-4omini

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

GPT的定义和演进历程

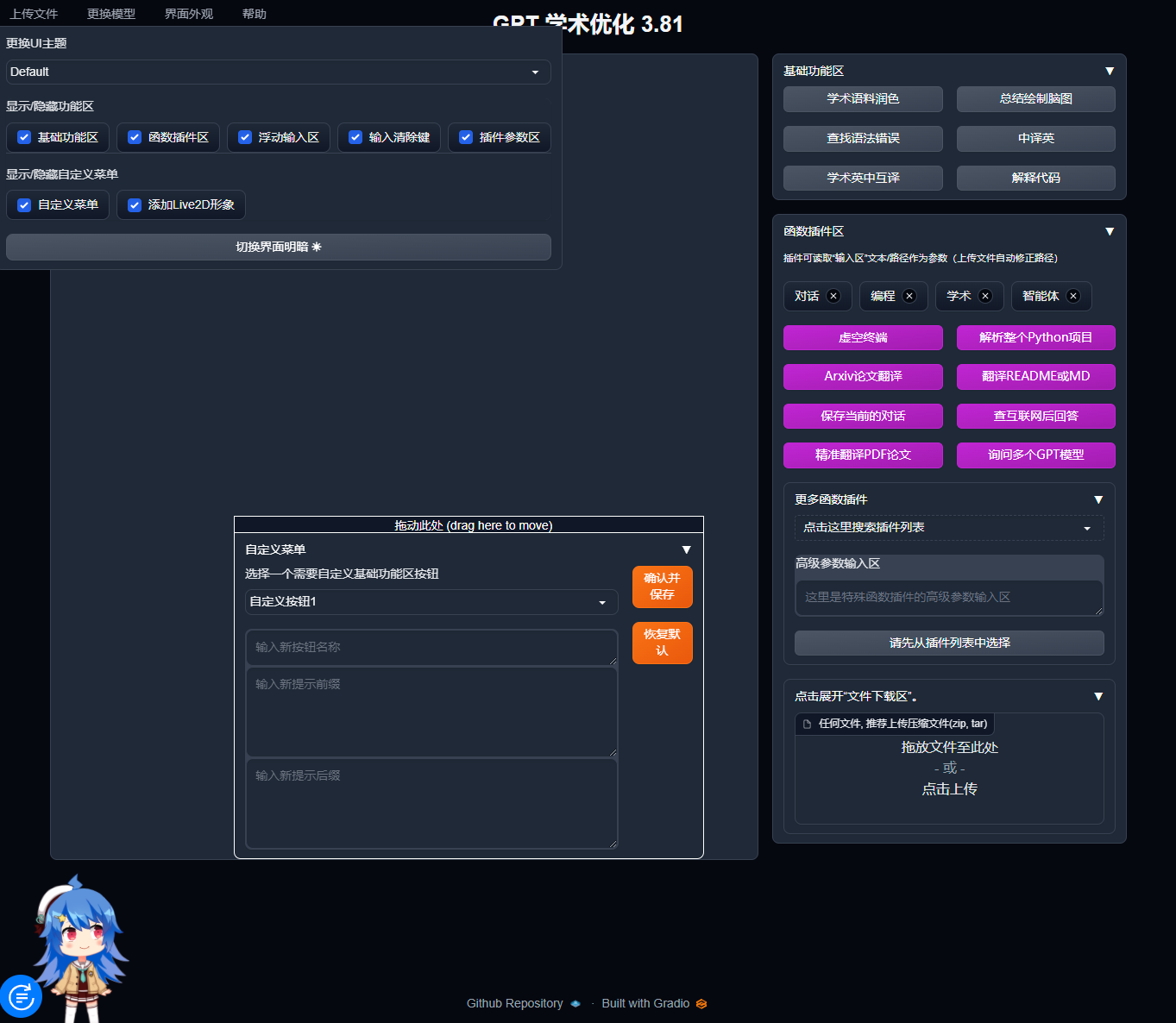

宝塔面板Docker一键安装:部署GPTAcademic,开发私有GPT学术优化工具

国内直联使用ChatGPT 4.0 API Key使用和多模态GPT4o API调用开发教程!

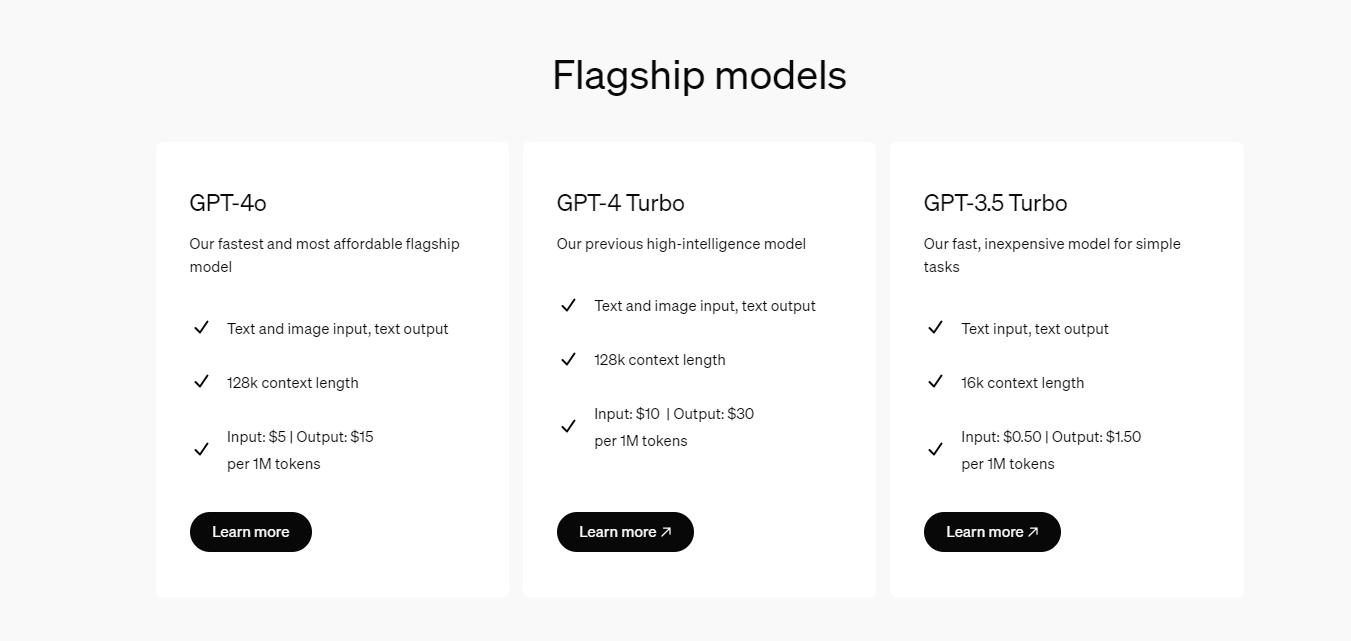

开发者如何调用OpenAI的GPT-4o API以及价格详情指南

OpenAI CEO: GPT-4o and GPT-5引领未来12个月编程领域,GPT-5更具潜力

OpenAI推出ChatGPT新功能:朗读,支持37种语言,兼容GPT-4和GPT-3

使用TC21x的GPT实现1m计时器执行定时任务,怎么配置GTM和GPT?

请问TC234芯片中的CCU6 , GTM, GPT12中的pwm区别是什么?

GPT EVAL_BDPS_DRIVER可以使用GPT12 IP或GTM IP来实现连续定时器和单次定时器吗?

OpenAI推出GPT商店

OpenAI GPT 商店即将亮相,SpaceX 新型 Starlink 卫星发射上天

GPT 应该存在吗?

GPT 应该存在吗?

评论