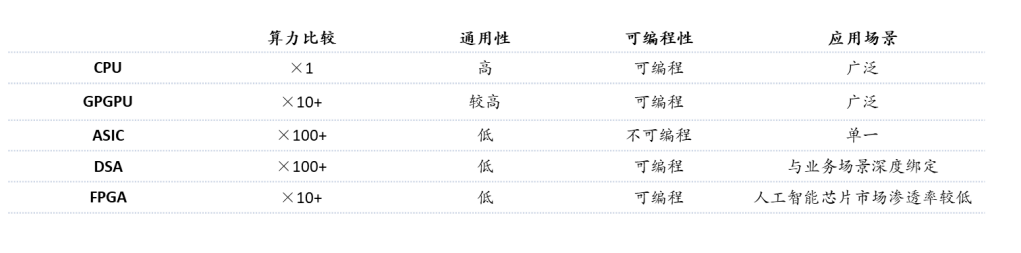

随着人工智能、云服务等新兴需求的迅猛增长,算力正在从满足多任务的通用芯片,向单一任务的多种专用芯片发展,传统以CPU为核心的计算架构,已经不能满足新兴业务需求,异构计算成为重要趋势。

近年来,在云计算蓬勃发展的同时,异构计算市场也乘风得到了长足的发展。对芯片设计企业而言,过去进入服务器计算芯片市场只有通过有竞争力的X86 CPU,而现在GPU、FPGA、AI芯片各类架构CPU等多种计算芯片均在服务器中得到广泛应用,为国产CPU及AI芯片公司,以及基于***的智能计算产业链提供了良好的发展机会。

CPU是中央处理器作为计算机系统的运算和控制核心,是信息处理、程序运行的最终执行单元。 FPGA是基于通用逻辑电路阵列的集成电路芯片,其最大的特点是芯片的具体功能在制造完成以后由用户配置决定。 GPU/GPGPU是并行计算的主力算力引擎。随着业务越来越复杂,数据流量呈现指数级增长,全部业务和数据靠CPU处理,性价比极低。AI加速芯片为专门针对AI深度学习,结合标量计算、矢量计算和张量计算真的专用架构应运而生,针对AI推理应用,实际算力利用率可超过90%。 DPU作为数据处理器,其核心是通过协处理器协助主控CPU处理网络负载,编程网络接口功能。支持数据中心底层存储、安全、服务质量管理等基础设施层服务,提升整个计算系统的效率、降低整体系统的总体拥有成本。 目前,我国服务器计算芯片主要从英特尔、AMD超威半导体、英伟达等企业进口,未来计算芯片国产化市场空间大,进口替代空间广阔。本文主要关注计算芯片,包括CPU、GPU/GPGPU、FPGA、AI加速芯片等和以DPU为代表的网络通信芯片。

1、CPU

CPU中央处理器作为计算机系统的运算和控制核心,是信息处理、程序运行的最终执行单元。CPU是整个IT生态的定义者,无论是服务器端的X86还是移动端的ARM(安谋),都各自构建了稳固的生态系统,不仅形成技术生态圈,还形成闭合价值链。

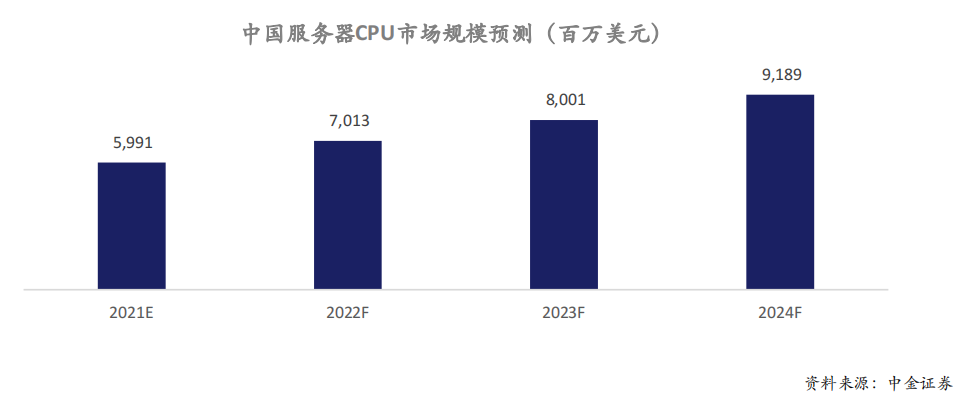

市场空间

数据中心应用CPU价格高,利润最为丰富,根据不同配置,CPU占据服务器总成本约1/3到1/2。预计到2025年,随着中国数据中心的不断扩容和升级,以及云计算、大数据、人工智能等应用的快速发展,中国数据中心应用CPU市场规模有望继续增长。根据中金证券研究数据,2021年中国服务器CPU市场规模60亿美元,预计2024年达到92亿美元,3年年均复合增长率15%。

发展趋势

国产CPU各个技术赛道全方面布局。X86、ARM、RISC-V(Reduced Instruction Set Computer-V,第五代精简指令集计算机 )是CPU三大技术架构。服务器市场上X86处理器市占率超过90%,占据绝对主导地位。CPU产业链巨头大多集中在海外,位居产业链各个环节核心,对全球CPU行业影响力较大。在设计环节,英特尔和AMD几乎垄断通用型CPU市场。借助台积电先进制程,AMD服务器CPU霄龙强势崛起,根据IDC数据2021年第四季度, AMD数据中心CPU市场占有率自2016年之后首超10%。为应对新的挑战,英特尔2021年底历史第一次宣布开放X86指令集给第三方公司。 ARM开放指令集以及在移动端构建的良好生态,数据中心巨大市场以及丰厚利润吸引各家巨头入局开发ARM架构服务器CPU,其市场占有率稳步提升。除美满、富士通、英伟达、海思等传统芯片巨头之外,亚马逊、谷歌、阿里等手握资金、技术以及应用场景的新型互联网公司也加入这一战局,给市场带来变数。ARM架构服务器CPU性能不断提升、生态不断完善,与X86架构正面竞争,蚕食之势不容小觑。 RISC-V作为后起之秀发展迅速,英特尔在2021年提出20亿美元收购专注于高性能计算的RISC-V初创公司SiFIVE。RISC-V是开源指令集,开放程度比ARM更好,支持指令集扩展。RISC-V开放的定位是***实现全产业链自主可控的重要基础,截至2022年末,我国大约有50款不同型号的国产RISC-V芯片量产,应用场景集中在MCU、电源管理、无线连接、存储控制、物联网等中低端场景。而目前已有多家创新企业计划在2023年发布对标64核高性能的服务器级处理器,应用领域也有望从专业应用场景逐步拓展到通用计算场景。 在信创市场驱动下,国产CPU各个技术赛道全方面布局,不同于以往的国产化替代,信创更强调生态构建。从IT基础设施到应用软件,再到IT安全,2022年信创产业规模达到9220.2亿元,近五年复合增长率35.7%,预计2025年突破2万亿,国产CPU在信创领域存在巨大的市场发展机会。同时,中国CPU另外一个特点就是各个技术赛道全方面布局,中国全自主架构唯一代表有龙芯LoongArch架构,X86架构有海光、兆芯,ARM架构有飞腾、海思,RISC-V架构有阿里等。

2、GPU/GPGPU

传统CPU为核心的计算架构中所有数据和指令都由CPU来处理。然而CPU的架构不适合处理高并行度数据计算业务,更适合进行逻辑运算和整个计算机的管理。随着业务越来越复杂,数据流量呈现指数级增长,全部业务和数据靠CPU处理,性价比极低。因此出现了各种协处理器XPU,专门帮助CPU处理各种特定应用场景业务。最早出现的就是计算机3D图形渲染专用加速芯片,特点是大量的并行小核,需要在CPU调度下工作。1999年英伟达发布第一款GPU产品NV10,在市场上第一次推出GPU概念。随后英伟达把GPU应用推广到GPGPU和CUDA编程框架推广,GPU成为并行计算的主力算力引擎。2012年的ImageNet比赛,取得突破的AlexNet的发明人亚历克斯使用了英伟达的GPU,证明了GPU非常适合用于多并行计算的神经网络,从此GPU成为深度学习标配,引爆市场。

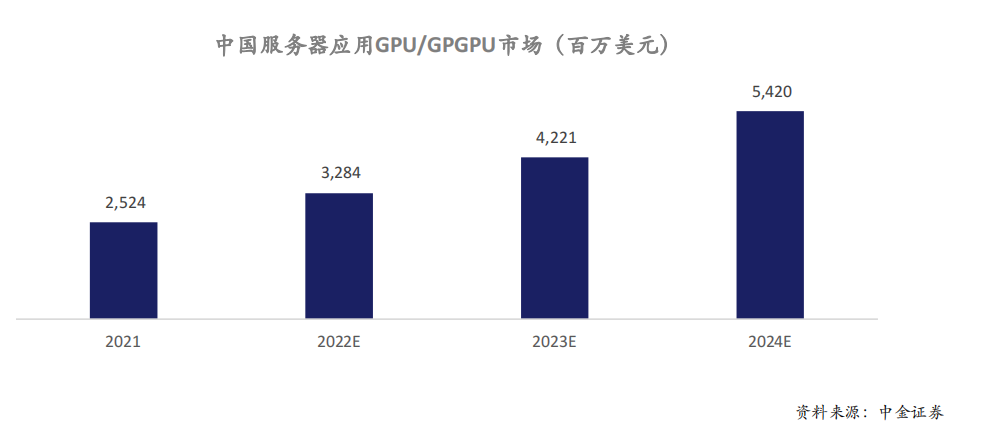

市场空间

目前中国深度学习加速服务器90%还是采用GPU/GPGPU,根据中金证券测算,2021年中国2022年中国服务器应用GPU/GPGPU市场规模达到32亿美元,预计2024年市场规模达到54亿美元。

发展趋势

GPT应用激发算力需求,国产GPU加速补位,仍面临巨大算力缺口。GPU采用最先进的逻辑工艺,不考虑巨大的生态建设费用,单芯片研发成本10亿人民币起步,过去鲜有资本和创业团队涉足。然而,英伟达、AMD高端GPGPU产品受美国政府禁令的影响已经预示了国产GPGPU供应链安全问题的严重性,中国政府及资本市场也对于国内GPU企业予以高度重视,国产GPU厂商存在替代补位的机会,GPU初创公司不断涌现,融资金额屡创新高,估值动辄超百亿。英伟达、AMD高管为主的创业团队,超一线VC机构重金支持,成为国产GPU初创公司范式。 另一方面,今年爆火的ChatGPT和GPT-4等新一代AI应用的商用化,对芯片算力的技术要求将大幅提高,并有望创造出可观AI芯片增量市场空间。

3、FPGA

FPGA是基于通用逻辑电路阵列的集成电路芯片,和ASIC芯片不同,其最大的特点是芯片的具体功能在制造完成以后由用户配置决定。用户可通过配套的FPGA专用EDA软件实现具体功能,首先由专用EDA软件接受用硬件语言描述的用户电路,其次编译生成二进制位流数据,最后将位流下载到芯片中实现用户所需特定功能的集成电路芯片。每颗FPGA芯片均可以进行多次不同功能配置,从而实现不同的功能。 服务器和存储器作为数据中心的通用基础设备,为了应对复杂多变的应用情景,需要FPGA芯片实现逻辑控制、数据转换、功能扩展、系统升级等功能。在数据中心运算处理领域,相比CPU,FPGA芯片由于其无指令、无需共享内存的体系结构,能够同时提供强大的计算能力和足够的灵活性;相比GPU,FPGA芯片在数据中心具有低延迟及高吞吐的优势;相比ASIC,FPGA芯片在性能、灵活性、同构性、成本和功耗等五个方面达到出色平衡。

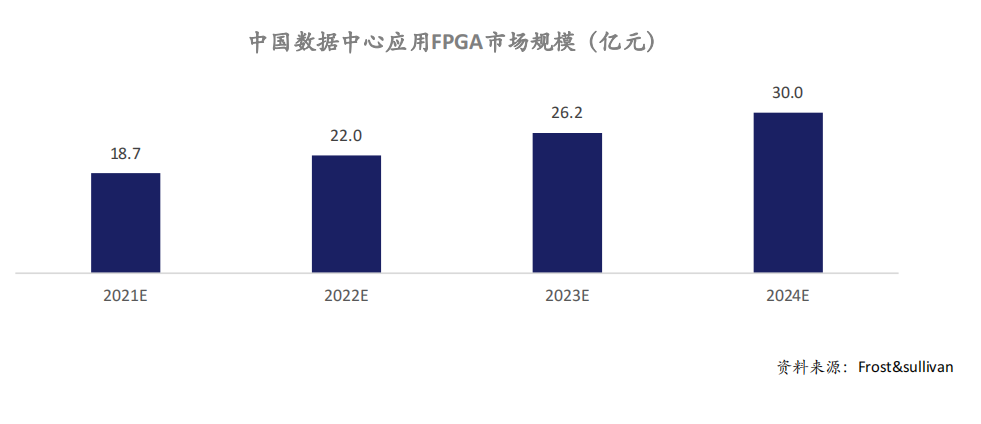

市场空间

FPGA芯片具有灵活性高、应用开发成本低、上市时间短等优势。数据中心是FPGA芯片的新兴应用市场之一,根据Frost&sullivan数据,2020年应用于该领域的FPGA芯片中国销售额将达到16.1亿元,占中国FPGA芯片市场份额的10.7%,预计2024年将达到30亿元,2021年至2024年年均复合增长率将达到16.6%。

发展趋势

FPGA芯片在数据中心领域主要用于硬件加速,数据中心使用FPGA芯片代替传统的CPU方案后,处理其自定义算法时可实现显著的加速效果。因此从2016年开始,微软Azure、亚马逊AWS、阿里云的服务器上都开始部署FPGA加速器用于运算加速。在云计算大面积应用的背景下,未来数据中心对芯片性能的要求将进一步提升,更多数据中心将采纳FPGA芯片方案,这将进一步提高FPGA芯片在数据中心芯片中的价值占比。 FPGA芯片向高集成化的现场可编程系统级芯片发展。英特尔2015年收购Altera阿尔特拉,AMD 2022年完成收购Xilinx赛灵思,CPU和FPGA融合成为趋势。国际主流FPGA芯片公司逐渐形成了在FPGA芯片中加入处理器的技术路线,并产生了可编程系统级芯片这一新产物。和传统FPGA芯片不同,现场可编程系统级芯片的特点是单芯片高度集成电子信息设备所需的CPU、FPGA、存储接口、I/O外设接口甚至人工智能专用引擎等所有模块,单颗芯片可完成应用情景的所有功能需求。

4、AI加速芯片

深度学习涉及少量标量计算、大量的矢量计算和张量计算。GPU是标量计算核,在处理深度学习数据时,需要消耗大量资源把矢量和张量计算转变为标量计算,因此GPU实际算力利用率最高只能达到40%。固定算法的ASIC芯片利用率最高,但是不适合业务复杂、算法在一直更新的云计算应用,而更适合边缘端应用。因此专门针对深度学习应用,结合标量计算、矢量计算和张量计算的DSA(Domain SpecificArchitectures,特定领域专用架构)架构应运而生,针对AI推理应用,实际算力利用率可超过90%,并且其芯片提供最基本的深度学习算子,保证芯片在深度学习应用的通用性和扩展性,从而实现数据中心降本增效。2019年英特尔20亿美元收购了以色列初创公司Habana Lab,证明了DSA架构在商业和技术上的成功。国内希姆计算、瀚博、燧原等初创公司都采用DSA架构技术路线,并开始商业落地。

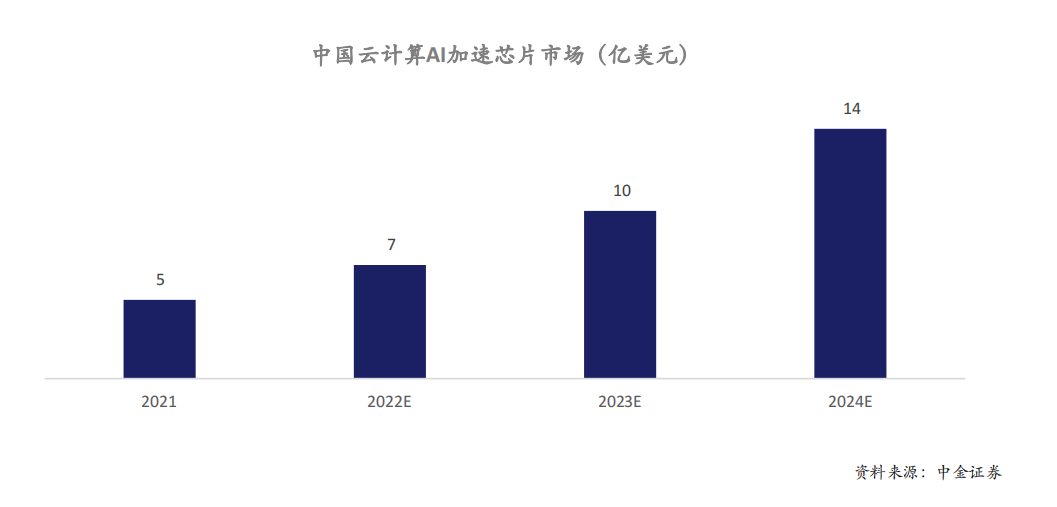

市场空间

根据中金证券测算,2021年中国云计算应用AI加速芯片市场规模约5亿美元,预计2024年市场规模将达到14亿美元,三年年均复合增长率达到47%。

发展趋势

面向场景专用的云端AI芯片进一步加速渗透。互联网公司成为AI加速芯片主力。互联网公司直接面向终端提供服务,既拥有丰富的业务场景,又具备技术和资金实力,于是开始绕过英特尔、英伟达等传统芯片供应商下场自研芯片或者投资芯片初创公司,满足自身需求。比如谷歌TPU,百度昆仑芯片,亚马逊,字节跳动等,都在结合自身应用场景自研AI加速芯片。 场景专用的云端AI推理加速芯片,有望依靠性价比取胜。互联网公司推理应用场景主要是内容推荐和内容审核,内容和用户都已经完成向量化,对芯片实时性要求高,对芯片生态和通用性要求低。并且推理芯片的需求量和增速远高于训练芯片,根据Facebook给出的预测,今后推理芯片和训练芯片的需求量是9:1。专门针对AI云端推理计算的AI推理加速芯片,实际任务负载达到90%以上,实现相同工艺节点GPU的2倍以上性价比。

5、DPU

数据中心规模越来越大,任务越来越复杂,根据亚马逊统计仅处理网络通信就需消耗CPU 30%的算力,亚马逊称之为“datacenter tax(数据中心税)”。DPU是以数据为中心构造的专用处理器,支持数据中心底层存储、安全、服务质量管理等基础设施层服务。DPU要解决的核心问题是基础设施的“降本增效”,即将“CPU处理效率低下、GPU处理不了”的负载卸载到专用DPU,提升整个计算系统的效率、降低整体系统的总体拥有成本(TCO)。

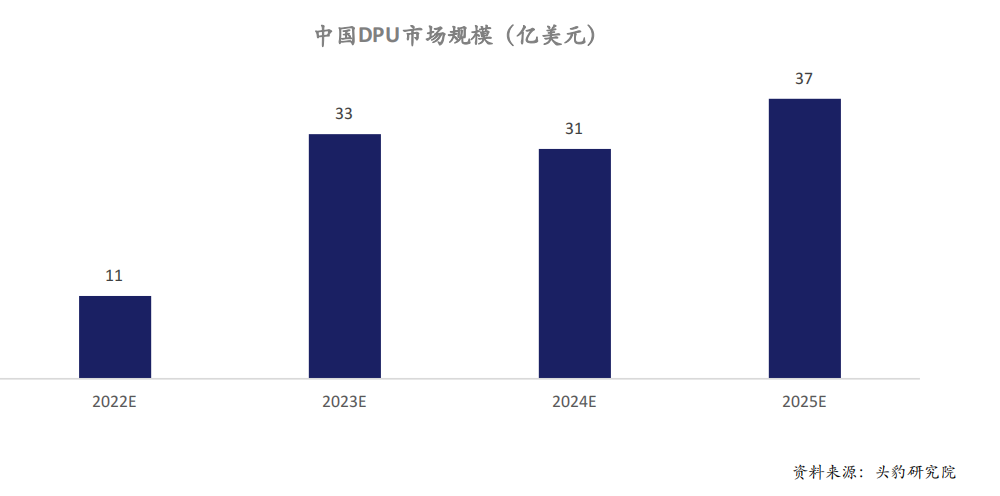

市场空间

根据头豹研究院测算,2022年中国DPU市场规模约11亿美元,预计到2025年市场规模将达到37亿美元。

发展趋势

存在广阔的应用前景和巨大的市场空间。DPU存在广阔的应用前景和巨大的市场空间。国际巨头近年来也先后布局DPU产品,英伟达于2021年发布新一代DPU BlueField 3,英特尔发布基础设施处理器IPU,AMD收购DPU厂商Pensando。同时,DPU作为专门负责数据中心底层网络通信的算力芯片,是一个新兴赛道,国内外发展差距小,竞争格局还较为分散,没有像CPU和GPU那样的明确巨头。因此,各大国内芯片厂商正在积极通过中国在云计算领域积累的市场规模、增速、特别是用户数量的优势来推动国内DPU的开放生态建设。 DPU作为新兴赛道,最大的挑战是行业标准化。由于数据中心本身的复杂性,各大厂商一方面采用现成商业软件来构建系统,追求低成本,一方面又设法分层服务化(IaaS、PaaS、SaaS),打造面向不用类型客户的标准化产品。除此之外的所有技术实现几乎都是“八仙过海,各显神通”,例如各大公有云厂商、电信运营商等都有比较完整,同时比较封闭的底层架构和应用生态。上层负载不同,必然对底层架构有各异的需求,这也许是目前DPU标准化面临的最大的挑战。

-

FPGA

+关注

关注

1630文章

21766浏览量

604565 -

gpu

+关注

关注

28文章

4757浏览量

129107 -

网络通信

+关注

关注

4文章

809浏览量

29860

原文标题:中国云生态:基础硬件及芯片(2023)

文章出处:【微信号:架构师技术联盟,微信公众号:架构师技术联盟】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

OpenHarmony人才生态大会南向生态社区发展论坛在武汉圆满举办

2024 RISC-V 中国峰会:华秋电子助力RISC-V生态!

中科驭数“驭云”解决方案入选2024中国云生态典型应用案例

RISC-V在中国的发展机遇有哪些场景?

因智而兴 向“新”而行 | 软通动力携子公司鸿湖万联亮相数字中国建设峰会·智算云生态大会

云知声荣登“2023年度中国高科技高成长企业系列榜单”

中国云生态:基础硬件及芯片(2023)

中国云生态:基础硬件及芯片(2023)

评论