英伟达A100这个AI芯片怎么样?英伟达A100是一款基于英伟达Ampere架构的高性能计算卡,主要面向数据中心和高性能计算领域。其拥有高达6912个CUDA核心和432个Turing Tensor核心,可以实现高达19.5 TFLOPS的FP32浮点性能和156 TFLOPS的深度学习性能。此外,它还支持NVIDIA GPU Boost技术和32GB HBM2显存,能够提供卓越的计算性能和内存宽带。英伟达A100还配备了英伟达的第三代NVLink互连技术和第二代NVSwitch交换机,可以实现高带宽、低延迟的GPU-GPU通信,提升集群中的计算效率。

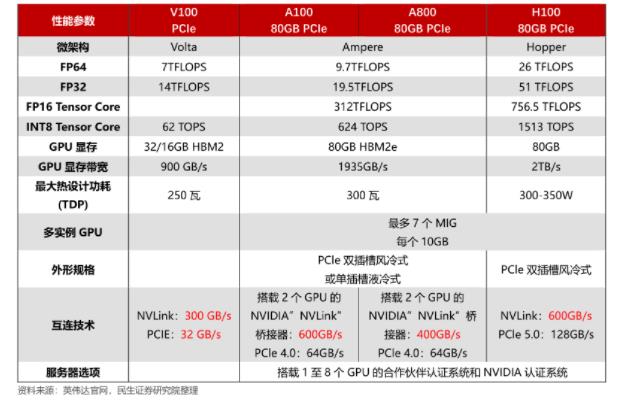

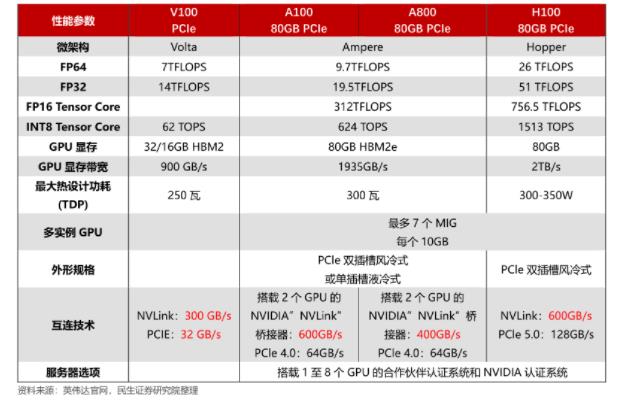

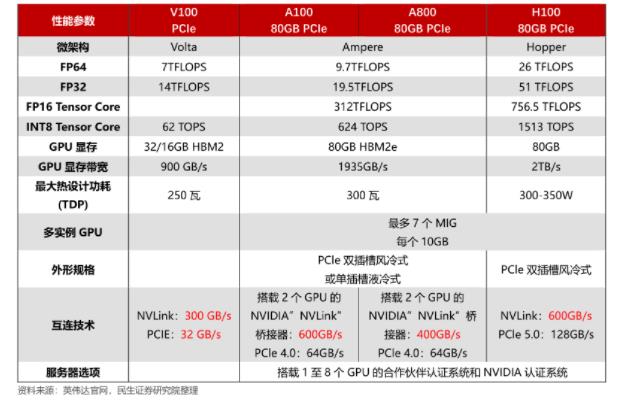

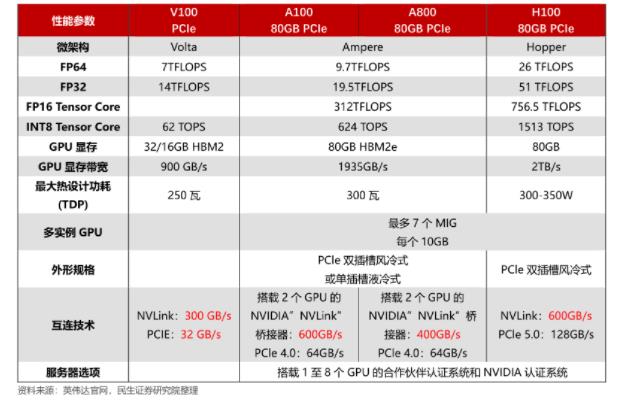

英伟达A100和V100参数对比

以下是英伟达A100和V100的主要参数对比:

| 参数 | 英伟达 A100 | 英伟达 V100 |

| 架构 | Ampere | Volta |

| 制程 | 7 纳米 | 12 纳米 |

| CUDA 核心数 | 6912 | 5120 |

| Tensor 核心数 | 432 | 640 |

| RTX 加速器数 | 112 | 0 |

| Boost 时钟频率 | 1.41 GHz | 1.38 GHz |

| FP32 性能 | 19.5 TFLOPS | 15.7 TFLOPS |

| FP64 性能 | 9.7 TFLOPS | 7.8 TFLOPS |

| Tensor 性能 | 624.6 TFLOPS | 125 TFLOPS |

| 内存容量 | 40 GB HBM2 | 16 GB HBM2 |

| 内存带宽 | 1.6 TB/s | 900 GB/s |

| TDP | 400 W | 300 W |

| 支持的 PCIe 版本 | PCIe 4.0 | PCIe 3.0 |

| 相关软件支持 | CUDA, cuDNN, TensorRT, NCCL, NVLink, NVSwitch, Docker, Kubernetes | CUDA, cuDNN, TensorRT, NCCL, NVLink, Docker, Kubernetes |

,英伟达 A100 在架构、制程和性能上都有显著的提升,同时内存容量和带宽也大幅提高。另外,A100 支持 RTX 加速器,可以实现实时光线追踪渲染等功能,而 V100 则不支持。不过,A100 的功耗也相应增加,需要更好的散热解决方案。

适用领域 |AI、机器学习、高性能计算 | 虚拟桌面、虚拟应用、多媒体等。

英伟达A100和V100参数对比

以下是英伟达A100和V100的主要参数对比:

| 参数 | 英伟达 A100 | 英伟达 V100 |

| 架构 | Ampere | Volta |

| 制程 | 7 纳米 | 12 纳米 |

| CUDA 核心数 | 6912 | 5120 |

| Tensor 核心数 | 432 | 640 |

| RTX 加速器数 | 112 | 0 |

| Boost 时钟频率 | 1.41 GHz | 1.38 GHz |

| FP32 性能 | 19.5 TFLOPS | 15.7 TFLOPS |

| FP64 性能 | 9.7 TFLOPS | 7.8 TFLOPS |

| Tensor 性能 | 624.6 TFLOPS | 125 TFLOPS |

| 内存容量 | 40 GB HBM2 | 16 GB HBM2 |

| 内存带宽 | 1.6 TB/s | 900 GB/s |

| TDP | 400 W | 300 W |

| 支持的 PCIe 版本 | PCIe 4.0 | PCIe 3.0 |

| 相关软件支持 | CUDA, cuDNN, TensorRT, NCCL, NVLink, NVSwitch, Docker, Kubernetes | CUDA, cuDNN, TensorRT, NCCL, NVLink, Docker, Kubernetes |

,英伟达 A100 在架构、制程和性能上都有显著的提升,同时内存容量和带宽也大幅提高。另外,A100 支持 RTX 加速器,可以实现实时光线追踪渲染等功能,而 V100 则不支持。不过,A100 的功耗也相应增加,需要更好的散热解决方案。

适用领域 |AI、机器学习、高性能计算 | 虚拟桌面、虚拟应用、多媒体等。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

英伟达

+关注

关注

22文章

3739浏览量

90790 -

A100

+关注

关注

0文章

27浏览量

7784 -

v100

+关注

关注

0文章

3浏览量

9398 -

AI芯片

+关注

关注

17文章

1859浏览量

34900 -

Ampere

+关注

关注

1文章

62浏览量

4532

发布评论请先 登录

相关推荐

英伟达H100芯片市场降温

随着英伟达新一代AI芯片GB200需求的不断攀升,其上一代明星产品H100芯片却遭遇了市场的冷落。据业内人士透露,搭载H100的服务器通常以8卡的形式进行出售或出租,而在去年,这类服务

英伟达或取消B100转用B200A代替

今年3月份,英伟达在美国加利福尼亚州圣何塞会议中心召开的GTC 2024大会上推出了Blackwell架构GPU。原定于今年底出货的B100/B200被寄予厚望,将替代现行H100/H

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

计算工作负载、释放百亿亿次计算能力和万亿参数人工智能模型的全部潜力提供关键基础。

NVLink释放数万亿参数AI模型的加速性能,显著提升大型多GPU系统的可扩展性。每个英伟达Black

发表于 05-13 17:16

Hi3519A V100 4K智能IP摄像头SoC数据手册

电子发烧友网站提供《Hi3519A V100 4K智能IP摄像头SoC数据手册.pdf》资料免费下载

发表于 04-09 16:25

•4次下载

英伟达:预计下一代AI芯片B100短缺,计划扩产并采用新架构

近期热门的 H100 芯片运期短缩数天后,英伟达新型 AI 旗舰芯片 B100搭载全新的 Blackwell,有望使 AI 计算性能提升至 2~3 倍。鉴于 AI 芯片市场需求旺盛,外

英伟达缩短AI GPU交付周期,持续推进算力产业链发展

与此同时,随着人工智能的迅猛发展及其广泛应用,对像H100和A100这类专为数据中心设计的高性能GPU的需求也大幅增长。而包括Yotta在内的多家公司因此纷纷加大向英伟达的采购力度,导

【机器视觉】欢创播报 | 英伟达拿下全球90%的AI芯片市场

预计最高可能已经达到了90%,创下新高纪录。在目前的人工智能智能加速芯片市场,英伟达的A100/H100系列AI GPU可谓是市场的首选。 而根据一些研究机构的预测,

2024年,GPU能降价吗?

首当其冲的就是A100GPU。OpenAI使用的是3,617台HGXA100服务器,包含近3万块英伟达GPU。国内云计算相关专家认为,做好AI大模型的算力最低门槛是1万枚

英伟达A100和V100参数对比

英伟达A100和V100参数对比

评论