电子发烧友网报道(文/黄山明)尽管近期生成式AI热度有所减弱,甚至不少企业已经曝出禁止自己的员工使用ChatGPT等产品,担心会导致信息的泄露。但这并没有阻止相关企业对AI大模型的深入研究,并且还在加大向英伟达下芯片订单。

与此同时,英伟达还在近期推出了一款升级版的下一代Grace Hopper超级芯片平台,性能超过过去的A100,搭载Nvidia的DGX系统能够以更少的芯片、更低的成本完成对大模型的训练。

国内互联网大厂抢购英伟达订单

不可否认,当前想要训练AI大模型,购买英伟达的芯片产品是最优的选择。不过由于此前美国的限制,国内企业几乎只能购买到英伟达专为中国市场设计的A800系列。虽然性能稍低,但并未阻止国内企业的购买热情。

据英国金融时报报道,中国数据互联网巨头正在抢购对构建生成式AI最为关键的高性能芯片,包括百度、字节跳动、腾讯、阿里巴巴已经向英伟达下了达10亿美元的订单,将从英伟达处购买约10万个A800处理器,预计在今年交付。

此前字节跳动已经为其社交媒体TikTok测试了一个名为TikTok Tako的生成式AI,并授权使用OpenAI的ChatGPT。为此,字节跳动已经储备了至少1万块英伟达GPU,并且下单了近7万块A800,价值约在7亿美元。

阿里巴巴同样从英伟达收到了数千块H800芯片,许多客户已经联系到阿里,希望能够借助由这些芯片驱动的云服务,来帮助他们训练AI大模型。百度也在制作自己的生成式AI项目,并将其命名为Ernie Bot。

报道还称,中国企业还购买了价格40亿美元的图形处理器,将于2024年交付。不过英伟达相关发言人并未对这一消息进行详细说明,只是透露消费者互联网公司和云提供商每年在数据中心组件上投资数十亿美元,通常会提前几个月下订单。

有意思的是,据行业人士透露,想要拿到大批量的英伟达芯片,还需要看与英伟达CEO黄仁勋是否“有关系”。并且相关企业能否购买到A800,更多是看商业关系,也就是过去是否为英伟达大客户的企业。

随着国内对A800需求的上升,其市场价格也水涨船高。经销商透露,A800显卡已经从一周之前的9万元以上涨到了当前的13万元,甚至一些经销商手中的A800涨幅超过了50%,服务器现货则是从120万元涨到了140万元左右。

不仅是国内的企业,国外如谷歌云、微软云Azure、甲骨文等都在大量抢购英伟达芯片,谷歌云大概囤积了2.5万块H100,微软云则拥有1-4万块左右的H100。

对于H100的需求,统计国外市场需求大概每家企业都需要3万块左右,加上部分初创企业,市场中需要总共43.2万块H100,加上国内对H800拥有大量需求的企业,短时间内英伟达很难完全满足市场的需求。

毕竟英伟达目前只是指定台积电作为H100的唯一生产商,未来或许有望与英特尔或三星合作,但在当下,台积电一家的产能短时间还无法满足市场中快速膨胀的需求,因此英伟达芯片的供不应求应该会持续一段时间。

推出GH200超级芯片,性能远超A100

或许是看到市场中对大算力高端芯片的渴求,英伟达在近期推出新一代GH200 Grace Hopper超级芯片,新芯片将于2024年第二季投产。其实早在数月前,英伟达便已经推出了GH200芯片,而此次推出的版本是加入了HBM3e内存的升级版。

即便是原来的GH200,对比A100仍然有着巨大提升,标称算力提升了3.2倍,结合带宽优化等综合训练算力提升5-6倍,推理算力提升10-12倍。

并且GH200在新AI数据中心架构下,光模块升级明显,一张GH200卡对应12个800G光模块,1个400G光模块,2个200G光模块需求,而在此前A100架构下,一张GPU对应2.5个800G光模块。

在加入了HBM3e内存后,也让GH200 Grace Hopper的性能得到大幅提升。相比HBM3,HBM3e要更快50%,可以提供10TB/sec的组合带宽,使新平台能够运行比之前版本大3.5倍的模型,同时通过3倍更快的内存带宽提高性能。

在HBM3e的帮助下,GH200 Grace Hopper可以提供高达141GB的内存和每秒5TB的带宽。与前代产品相比,新一代的双GH200系统拥有144个Grace CPU核心、8PFLOPS的GPU和282GB HBM3e内存,是当前一代产品的3.5倍内存和3倍带宽。

升级了GH200不仅在性能上有了大幅提升,并且功耗与成本也有了大幅降低。据黄仁勋透露,1亿美元可以买到8800块x86 CPU组成的数据中心,总功耗达到5MW。而同样的资金可以购买2500块GH200组成的数据中心,功耗仅为3MW,并且算力性能则是过去CPU系统的12倍,能效达20倍。

与此同时,英伟达还推出了DGX GH200超级计算机,内部加入了256 张GH200 Grace Hopper,相比过去的DGX A100 系统仅限于八个A100 GPU作为一个整体单元串联工作,DGX H200则可以提供大规模可扩展性的吞吐量系统和数据分析,通过使用英伟达的定制NVLink交换机芯片来回避标准集群连接选项的限制。

打个比方,过去Meta训练LLaMA-2模型时,采用了2000张A100的超级集群,如今只需要购买一台DGX GH200就能够实现对模型的训练。

当前英伟达在AI芯片市场占据主导地位,市场份额超过80%。预计将在2023年底前向其主要客户谷歌、Meta和微软提供DGX GH200参考蓝图,还将该系统作为参考架构设计提供给云服务提供商和超大规模厂商。

至于生产交付,就需要到明年二季度了,一个重要原因是HBM3e将在明年才会供货。市场消息显示,目前HBM3基本由韩国企业垄断,最早便是在2015年由AMD与SK海力士合作制造出了该产品,一举实现了高带宽存储,并从2D进入到了2.5D堆叠。

包括SK海力士、三星都表示,会先从HBM3开始开发,预计到2024年一季度才会送样HBM3e,而美光则选择跳过HBM3,直接开发HBM3e。届时,依靠新款英伟达芯片,AI大模型有望迎来新一轮的爆发。

写在最后

在经历了上半年生成式AI的火热,到了下半年,相关行业的热度有所下降,但未来的商业潜力已经被许多企业看在眼里。生成式AI几乎成为企业在未来商业竞争中的核心技术,这也是为何如今国内外的互联网企业都开始加速研发相关产品。

想要尽快的实现对模型的训练,采购英伟达芯片是最快的方法。但目前国内仍然只能采购H800系列产品,在英伟达芯片的不断推陈出新下,国内的大模型或许将与国外的产品产生代差,想要尽可能缩小差距,只能倒逼国内企业加速相关产品的研发。

这种局面显然不是英伟达愿意看到的,在今年6月份,英伟达财务主管便公开表示,限制向中国出口AI芯片,将导致美国工业永久失去机会。

-

芯片

+关注

关注

455文章

50791浏览量

423472 -

英伟达

+关注

关注

22文章

3775浏览量

91034

发布评论请先 登录

相关推荐

英伟达或取消B100转用B200A代替

英伟达巨资预订HBM3E,力拼上半年算力市场

亚马逊AWS暂缓采购英伟达GH200芯片,期待Blackwell更强

亚马逊未中断英伟达订单,等待Grace Blackwell更强性能

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

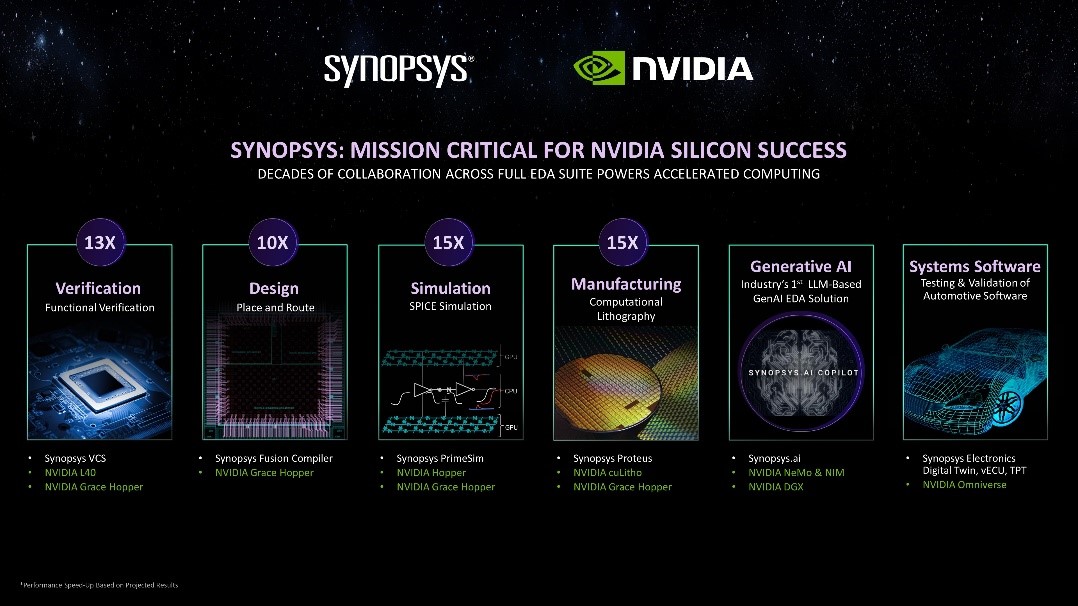

新思科技携手英伟达:基于加速计算、生成式AI和Omniverse释放下一代EDA潜能

英伟达收到国内大厂50亿美元大单,推出GH200超级芯片,性能远超A100

英伟达收到国内大厂50亿美元大单,推出GH200超级芯片,性能远超A100

评论