近期,Hugging Face 低调开源了一个重磅 ML 框架:Candle。Candle 一改机器学习惯用 Python 的做法,而是 Rust 编写,重点关注性能(包括 GPU 支持)和易用性。

根据 Hugging Face 的介绍,Candle 的核心目标是让 Serverless 推理成为可能。像 PyTorch 这样的完整机器学习框架非常大,这使得在集群上创建实例的速度很慢。Candle 允许部署轻量级二进制文件。另外,Candle 可以让用户从生产工作负载中删除 Python。Python 开销会严重影响性能,而 GIL 是众所周知的令人头疼的问题。

Rust 真的可以吗?

Pytorch 框架是用 Python 编写的,API 也是基于 Python 的,这让用户上手开发会非常快。另外,Python 本身就是一种简洁而易于学习的编程语言,很适合初学者和专业开发者使用。

但基于 Python 的 Pytorch 框架问题也很明显。相对于一些静态图框架(如 TensorFlow),Python 在某些情况下可能会导致性能问题。Python 的全局解释器锁(GIL)可能会在多线程的情况下影响性能,尤其是在涉及 CPU 密集型任务时。Python 的解释性质还可能会引入一些运行时开销。另外,将基于 Python 的 PyTorch 模型部署到生产环境中可能需要一些额外的步骤,不如其他编译型语言那么方便。

显然,Hugging Face 一直在寻找解决办法,它给出的答案是用时下最快的语言 Rust 重写一个 ML 框架。“最酷的是,这是来自 Hugging Face 的,不仅仅是某人的爱好项目。”有网友赞叹道。实际上,许多 HF 生态系统已经使用 Rust,例如 safetensors、tokenizer。

不过,Rust 的难度也让一些开发者望而却步,“编写 Rust 是一件艰难的事情,你必须跳来跳去,花更多的时间思考编程语言的抽象,而不是思考要解决的问题。所以,我现在还不着急重写任何 Python 的东西。”

开发者“fooblaster”指出,Pytorch 部署模型有多个生产路径无需 Python 解释器,如 torchscript 和 libtorch,或是更烦人的路径如 onnx export 和 onnx runtime,所以不需要 Rust 来解决这个问题。另外很人知道,现在可以使用 C++ 编写 Torch 训练代码,并与推理和训练共享一种通用语言。

对此,开发者“malcolmgreaves”表示,这些是使模型推理独立于 Python 的伟大技术。然而,总是有大量的预处理、后处理或其他业务逻辑需要围绕模型推理。这种事情需要在通用编程语言中完成,因此 Python 经常被使用(因为支持模型的代码通常是由同一个人编写的,并且这些代码很可能是 Python,因为您的模型训练和 eval 代码很可能也是 Python)。这就是非 Python PL(如 Rust)可以在简化生产部署 / 维护以及具有真正高效的生产推理方面发挥巨大作用的地方。

当然,也有开发者为 Python 打抱不平。

“任何编程语言在生产环境中都可能是一种痛苦。Python 的缺点之一也是它的优点之一。使用 Python 或 JavaScript 等‘混乱’语言很容易陷入糟糕的生产环境,因此避免这些痛点的工具已经非常成熟。有了这些,Python 在生产中就会变得很棒。”开发者“devjab”进一步表示,“是的,这将要求您的组织做出一些严肃的 CI 文化决策并强制执行。但问题是,虽然使用某些编程语言可以不必如此,但当企业达到一定规模时,总是会需要它们。因此,更早建立这个流程就会容易得多,而且如果您认真使用 Python,早就会这样做了。我认为,如果在生产环境中工作很痛苦,那么问题不在于技术,而在于流程。”

实际上,业内一直在努力解决 Python 带来的问题。

5 月份,LLVM 和 Swift 编程语言联合创始人 Chris Lattner 创办的新公司 Modular AI 发布了一个名为 Mojo 的新编程语言。Mojo 将 Python 特性与 C、C++ 和 CUDA 的系统编程功能结合了起来,并通过其所谓“极限加速”与其他 Python 速度增强方案区分了开来。据悉,凭借着硬件加速,Mojo 在运行 Mandelbrot 等数字算法时比原始 Python 快上 3.5 万倍。

另一方面,Python 自身也在做改进。最近,Python 终于宣布要删 GIL,Python 默认版本将逐渐过渡到无 GIL 版本。这一决定能否巩固其在机器学习领域的地位,也需要时间验证。

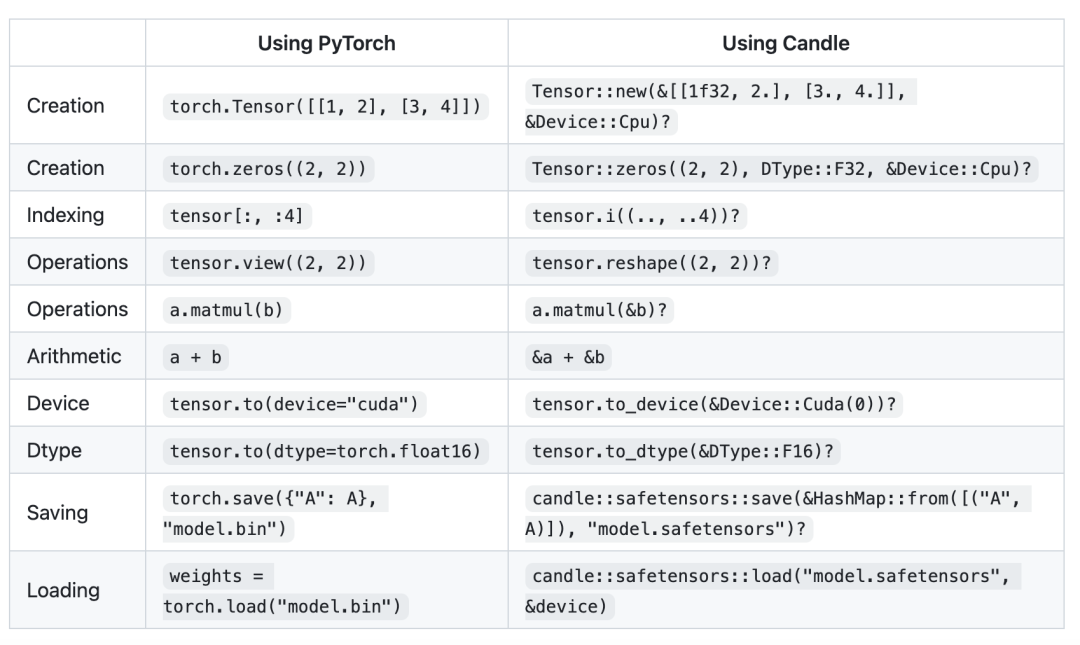

与 PyTorch 对比

据悉,当前 Candle 已经支持如今的前沿模型,像 Llama2。经过改写的模型,比如 Llama2 能够方便、快速的运行在容器环境,甚至可以运行在浏览器中。Candle 结构包括:

Candle-core:核心操作、设备和 Tensor 结构定义。

Candle-nn:构建真实模型的工具。

Candle-examples:在实际设置中使用库的示例。

Candle-kernels:CUDA 自定义内核;

Candle-datasets:数据集和数据加载器。

Candle-Transformers:与 Transformers 相关的实用程序。

Candle-flash-attn:Flash attention v2 层。

Pytorch 和 Candle 对比

该项目正在处于快速迭代过程中,更新非常频繁,很多功能在不断开发中,目前包含如下功能和特点:

语法简单, 风格与 PyTorch 相似。

CPU 和 Cuda Backend:m1、f16、bf16。

支持 Serverless(CPU)、小型和快速部署

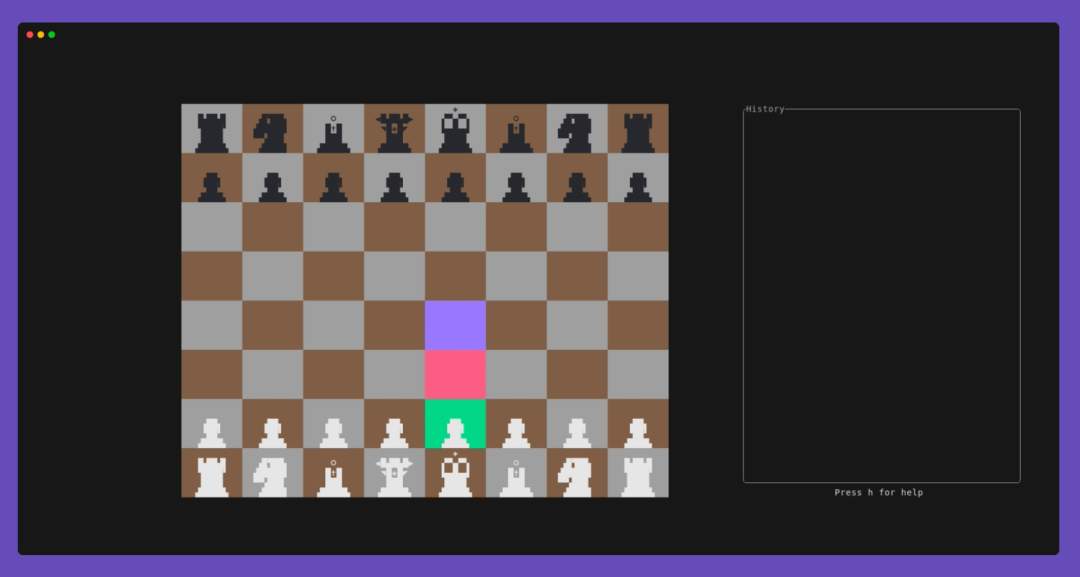

支持 WASM,可在浏览器中运行模型。

模型训练

使用 NCCL 进行分布式计算。

开箱即用的模型:Llama、Whisper、Falcon、StarCoder...

嵌入用户定义的操作 / 内核,如 flash-attention v2。

对于 Hugging Face 的这一新 ML 框架,大家有什么感想或使用感受?欢迎在评论区分享!

-

框架

+关注

关注

0文章

398浏览量

17429 -

pytorch

+关注

关注

2文章

803浏览量

13143 -

Rust

+关注

关注

1文章

228浏览量

6568

原文标题:Python 失宠!Hugging Face 用 Rust 新写了一个 ML框架,现已低调开源

文章出处:【微信号:AI前线,微信公众号:AI前线】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

如何使用 Llama 3 进行文本生成

如何用Rust编写一个ChatGPT桌面应用(保姆级教程)

pytorch和python的关系是什么

Hugging Face科技公司推出SmolLM系列语言模型

Python中的人工智能框架与实例

用pycharm进行python爬虫的步骤

亚马逊云携手AI新创企业Hugging Face,提升AI模型在定制芯片计算性能

Hugging Face提供1000万美元免费共享GPU

Hugging Face推出开源机器人代码库LeRobot

ServiceNow、Hugging Face 和 NVIDIA 发布全新开放获取 LLM,助力开发者运用生成式 AI 构建企业应用

一次Rust重写基础软件的实践

Transformers.js 2.13、2.14 发布,新增8个新的架构

Python失宠!Hugging Face用Rust新写了一个ML框架

Python失宠!Hugging Face用Rust新写了一个ML框架

评论