在当今数字化时代,文本数据已成为人类活动的主要载体,无处不在的信息交流塑造着我们的社会、经济和文化。而正是这些海量的文本数据,为大型模型的训练和应用提供了丰富的资源,成为其重要的基石与洞察力之源。

大型模型,特别是基于深度学习的预训练语言模型,如GPT-3.5,依赖于大规模的文本数据来进行训练。这些模型之所以强大,源于它们从这些数据中学习到的语义、关联和结构。文本数据中蕴含着丰富的知识、思想和信息,通过模型的学习,这些数据转化为了模式、规律和表征,使得模型能够更好地理解和生成文本。

文本数据在大型模型的训练中发挥了多重角色。首先,它们构建了模型的知识图谱,帮助模型建立单词、短语、句子之间的关联。这使得模型能够在生成文本时更好地把握上下文,生成更加连贯、自然的输出。其次,文本数据丰富了模型的语义理解能力。模型通过学习大量语境中的词义和用法,能够更准确地理解词汇的多义性,从而提高了文本生成的质量。此外,文本数据还为模型提供了丰富的主题、领域知识,使得模型在特定主题下能够生成更专业、有深度的文本内容。

不仅如此,文本数据还是大型模型在多个领域应用中的洞察力之源。在自然语言处理领域,大型模型通过学习文本数据中的信息,能够进行文本分类、情感分析、命名实体识别等任务。在信息检索领域,模型可以根据文本数据的内容和语义,更精准地进行搜索和推荐。智能对话系统也依赖于文本数据,通过学习大量的对话语境,模型可以进行更自然、连贯的人机对话。

然而,文本数据也带来了一些挑战。数据的质量、标注的准确性、数据的多样性等问题都可能影响模型的性能。此外,文本数据中可能存在偏见和敏感信息,模型需要学会如何处理这些问题,以确保生成的文本是中立、公正、无偏的。

综上所述,文本数据在大型模型的发展和应用中扮演着不可或缺的角色。它们为模型提供了知识、智能和洞察力,推动着人工智能在自然语言处理、信息检索、智能对话等领域的不断创新和进步。随着文本数据的不断积累和模型的不断演进,我们可以期待大型模型在未来发挥更大的潜力,为人类创造更智能、更丰富的文本体验。

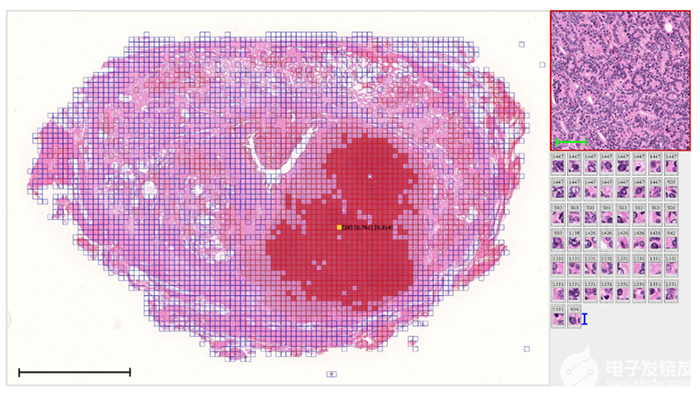

数据堂除了提供丰富的成品文本数据集之外,还提供文本数据的清洗、文本分类、信息抽取、实体关系标注、意图标注、情感标注等数据定制服务。针对数据定制标注服务,我们自研数据标注平台具备成熟的标注、审核、质检等机制,可支持多种类型的文本数据标注。

审核编辑 黄宇

-

人工智能

+关注

关注

1791文章

46877浏览量

237614 -

模型

+关注

关注

1文章

3176浏览量

48721 -

数字化

+关注

关注

8文章

8620浏览量

61643 -

自然语言处理

+关注

关注

1文章

614浏览量

13511

发布评论请先 登录

相关推荐

从一个文本数据的文件夹中,怎样实现数据的连续提取

文本数据分析:文本挖掘还是自然语言处理?

NVIDIA分享音乐和诗歌领域中AI创作能量与洞察力

弱监督学习解锁医学影像洞察力

问答对话文本数据:解锁智能问答的未来

对话文本数据是培养大模型的智能与交流之源

对话文本数据的珍贵贡献:训练大模型赋予智能与情感理解

使用Brocade Gen 6为大型机存储网络提供更好的性能和洞察力

大型模型的重要基石与洞察力之源之文本数据

大型模型的重要基石与洞察力之源之文本数据

评论