电子发烧友网报道(文/周凯扬)英伟达于今年发布了新一代的GH200 Grace Hopper硬件平台,预示着其发展HPC与AI的重要路线迈进了新阶段。GH200将用于应对世界上最复杂的生成式AI负载,涵盖大语言模型、推荐系统和矢量数据库等应用,且英伟达依然为GH200准备了不同的配置选项,无疑这一芯片很快就会用于各大数据中心和超算中。

NVLink,从片外互联走向片内互联

或许在多数人眼中,GH200不过是新一代Grace CPU和Hopper GPU结合的又一新产品,但这必然不是英伟达追求的“1+1=2”效果。事实上,GH200是象征着英伟达在芯片互联技术先进设计水平的集大成者。

在英伟达的第四代NVLink技术和第三代NVSwitch技术下,创造一个256个GH200连接在一起的系统也不在话下。但这样的片外互联技术并不算罕见,市面上也有不少初创公司的AI芯片可以做到类似或者更夸张的扩展性。

然而在片内芯片互联上,NVLink-C2C这一互联技术确实达到了新的高度。NVLink-C2C是英伟达专为其superchip系列打造的内存一致、高带宽、低延迟互联技术。也是其实现高达900GB/s总带宽的关键所在。900GB/s的带宽是什么概念呢?与现代AI/HPC加速器常用的16路的PCIe 5.0相比,还要快上6倍。

NVLink-C2C的优势

NVLink-C2C的第一大优势就是其内存一致性,这不仅提高了开发者的效率、芯片性能,还提高了GPU可以访问的内存量。在这一互联技术的支持下,如今CPU、GPU线程都可以并行访问CPU和GPU各自的内存,无需页迁移,所以开发者可以专心于优化算法本身,而不是内存管理。

其次就是900GB/s的带宽了,有了NVLink-C2C,应用程序可以直接用满GPU的内存,再以超高的带宽直接调用Grace CPU的内存。毕竟即便是最新的HBM3e版GH200,也只有144GB的内存,而Grace CPU可以支持到最高480GB的LPDDR5X内存。甚至在NVSwitch的支持下,可以高速访问整个系统中最高达144TB的内存。

如此一来在GPT这样的LLM模型中,可用的内存也就变多了。这对于batch size增加后,推理所需内存数增加的生成式AI来说至关重要。相比过去x86 CPU+PCIe 5.0 H100的搭配组合,GH200在更大的batch size下推理速度有着数倍的提升。

英伟达也对高带宽在HPC加速上的优势进行了解读,以ABINIT的标准执行时间为例,ABINIT是一个用于计算材料光学、机械、振动等特性的模拟软件。以只用x86 CPU的执行时间作为标准,在x86 CPU与Hopper GPU的结合下,超高性能的Hopper GPU极大地缩短了执行时间。

然而在CPU与GPU之间的传输开销下,这一组合最终只能做到快上1.16倍的优势。而如果是使用Grace Hopper方案的话,在NVLink-C2C的超大带宽下,CPU与GPU之间的传输开销迅速缩减,最终实现了缩短4.25倍的执行时间。

写在最后

英伟达会走上自研CPU和Superchip的路线其实并不令人意外,为CPU与GPU之间打通一个更快的接口一直是英伟达的努力方向之一。此前由于x86的CPU设计主要还是有英特尔和AMD两家厂商完成,而Grace这样的自研Arm芯片则没了设计限制,可以掺入英伟达的各种定制化开发。

NVLink-C2C也为市面上其他的AI芯片带来了更大的挑战,毕竟英伟达在性能、软件生态上已经处于领先地位,又有着如此高效的互联技术。可以预见未来其他厂商也会在芯片互联、高速接口等领域发力,否则很难与英伟达同台竞争。

-

英伟达

+关注

关注

22文章

3773浏览量

91029

发布评论请先 登录

相关推荐

英伟达Blackwell芯片量产加速,Q4预计出货达45万片

英伟达带领芯片股飙升 英伟达大涨4.76%

亚马逊AWS暂缓采购英伟达GH200芯片,期待Blackwell更强

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

Meta将率先使用英伟达最新人工智能芯片

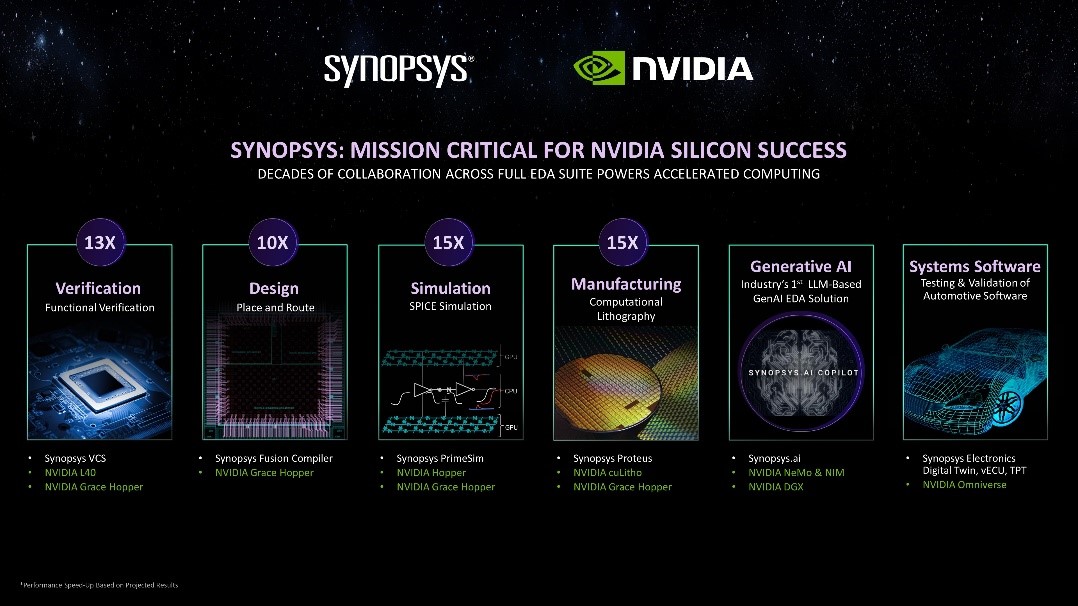

新思科技携手英伟达:基于加速计算、生成式AI和Omniverse释放下一代EDA潜能

英伟达超级芯片的真正杀手锏,C2C互联技术

英伟达超级芯片的真正杀手锏,C2C互联技术

评论