深度学习服务器怎么做 深度学习服务器diy 深度学习服务器主板用什么

随着人工智能的飞速发展,越来越多的人开始投身于深度学习领域。但是,随着深度学习的算法越来越复杂,需要更大的计算能力才能运行。因此,深度学习服务器逐渐成为了人们进行深度学习实验的必要工具。本文将介绍深度学习服务器的DIY,并讨论如何选择主板。

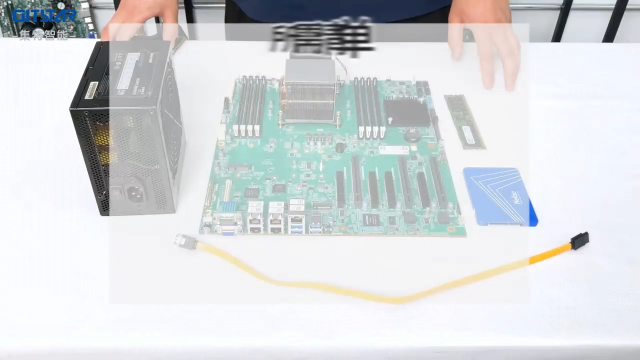

一、深度学习服务器的DIY

1.选择适合的处理器

深度学习对处理器的要求非常高,因为训练一个深度学习模型需要进行大量的矩阵和张量计算。相比之下,GPU对张量和矩阵计算有着优异的性能。当前,市面上主流的GPU厂商有Nvidia和AMD,深度学习使用的主要是Nvidia的GPU。Nvidia公司提供了专业的GPU加速计算库CUDA,使得开发深度学习模型变得更加简单。

2.选择适合的内存

深度学习的训练过程需要大量的算力和存储空间。因此,为了存储所有的权重、梯度和误差等计算结果,需要选择一定的内存容量。目前,16GB、32GB和64GB的内存比较常见,但是如果训练数据量非常大,需要更多的内存。因此,选择适合的内存还要看具体的应用需求。

3.选择适合的硬盘

选择恰当的硬盘是必不可少的,因为深度学习的训练过程可能会产生大量的日志和数据文件。深度学习使用的数据量通常是非常大的,因此需要大量存储空间。为了方便传输数据,最好选择SSD存储器。

4.选择适合的散热模块

深度学习需要大量计算,因此处理器和GPU会产生大量的热量。如果散热不好,可能会导致硬件损坏,严重的甚至会导致整台服务器崩溃。因此,选择适合的散热模块非常重要。

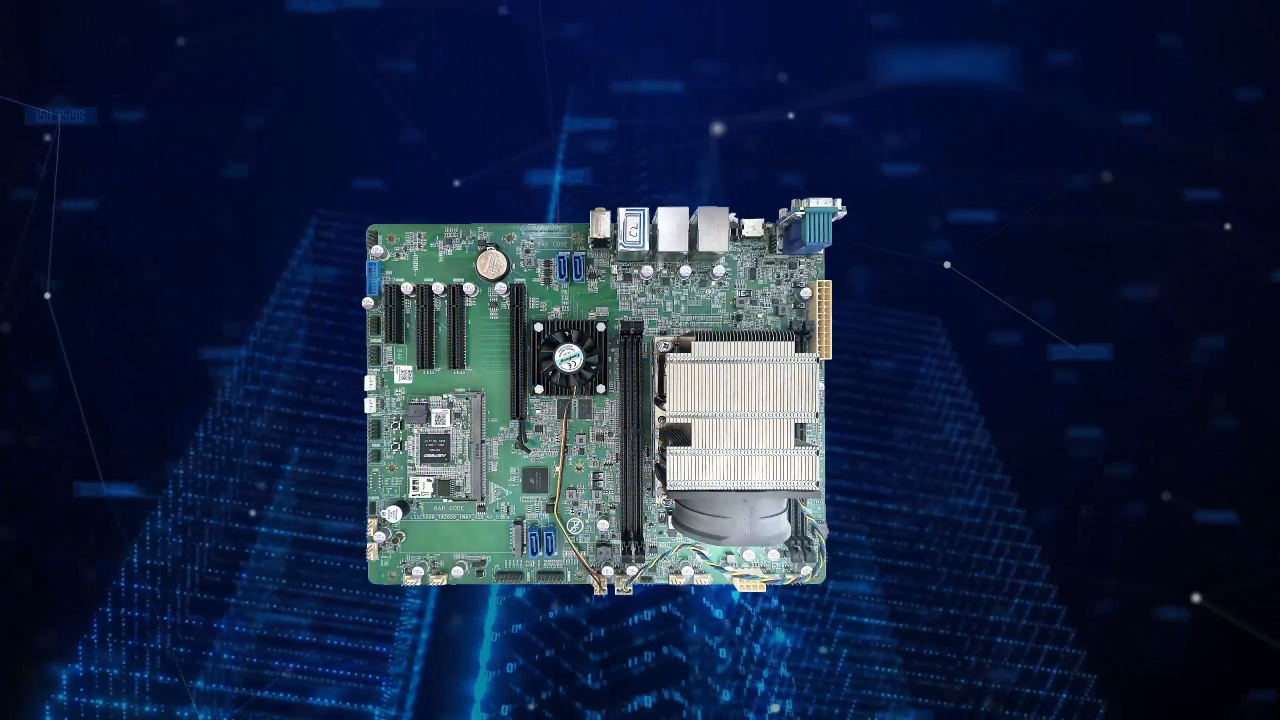

二、深度学习服务器主板的选择

1.选用适合的芯片组

选择适合的芯片组对深度学习服务器的性能有着重要的影响。市面上常见的芯片组有Intel的X58、X79以及X99等,其中X99是目前被广泛使用的芯片组。与此同时,AMD也推出了许多芯片组,例如AMD的TRX40芯片组,该芯片组与AMD CPU配合使用,可以获得非常好的性价比。

2.选用支持多卡的主板

深度学习通常需要多块GPU,并且需要支持PCI-E的3.0版本,因为GPU带宽大、存储容量大、计算量大,使得多GPU完成训练任务,计算速度更快。

3.选用支持高速传输的主板

深度学习需要将数据从CPU传输到GPU,并确保没有丢失和错乱。因此,主板上的传输速度非常重要。市面上有一些主板支持的传输速度比较高,例如USB 3.0和PCI-E 3.0等,这些主板都非常适合进行深度学习。

4.选用适合的扩展卡槽

扩展卡槽是指能够增加扩展卡的插槽。深度学习服务器通常需要添加各种类型的扩展卡,如InfiniBand、FPGA、NVMe和SSD RAID等,因此选择适合的扩展卡槽是很重要的。

总结:

深度学习服务器的DIY需要考虑诸多因素,在选择主板时需要注意芯片组、多卡支持、高速传输和扩展卡槽等等。行业中部分企业为后期维护方便,倾向于找主流品牌的服务器厂商来购买深度学习服务器,诸如HPE,Dell R740等;而有一些企业会购买DIY的深度学习服务器。

在为你的实验选择合适硬件方案时,需要了解你期望实现的数学模型和训练数据以及预计的训练时间。虽然基于GPU的加速训练速度非常快,但深度学习服务器的效率并不仅仅取决于GPU本身,整个系统协调工作才能达到最佳效果。建议在选择配件时认真考虑价格、性能和可扩展性等因素,才能得到更优的性价比。

最后,DIY深度学习服务器需要有比较强的电脑硬件知识,如果你没有相应的经验,建议选择有相关技术支持的厂商进行购买。

-

处理器

+关注

关注

68文章

19404浏览量

230998 -

深度学习

+关注

关注

73文章

5512浏览量

121466

发布评论请先 登录

相关推荐

做网站云服务器还是服务器好一些?

云服务器怎么做负载均衡?

独立服务器与云服务器的区别

什么是AI服务器?AI服务器的优势是什么?

AI云服务器:开启智能计算新时代

gpu服务器与cpu服务器的区别对比,终于知道怎么选了!

网络资源管理的新宠:洛杉矶裸机云多IP服务器深度解析!

云服务器和虚拟服务器的区别是什么

新手小白怎么学GPU云服务器跑深度学习?

服务器数据恢复—分享几个服务器数据恢复的案例

【算能RADXA微服务器试用体验】Radxa Fogwise 1684X Mini 规格

服务器远程不上服务器怎么办?服务器无法远程的原因是什么?

linux服务器和windows服务器

深度学习服务器怎么做 深度学习服务器diy 深度学习服务器主板用什么

深度学习服务器怎么做 深度学习服务器diy 深度学习服务器主板用什么

评论