现在,GPT-3.5 Turbo支持自定义微调了!

只需上传自己的数据,就可以运行专属的定制大模型。

开发者狂喜!不少人惊呼:Awesome!

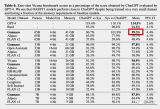

早期测试表明,经过微调的GPT-3.5 Turbo版本在某些任务中甚至可以超越GPT-4。

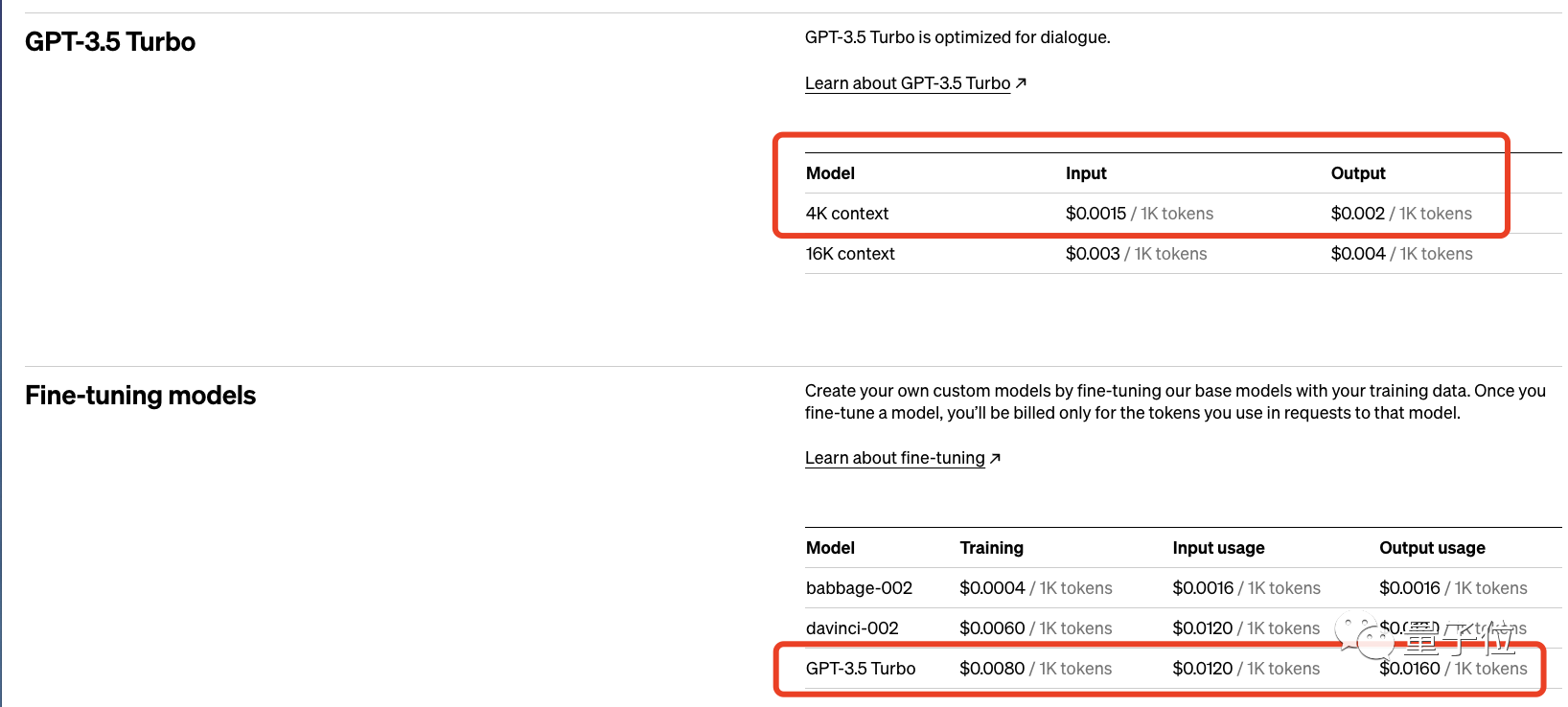

更新之余,OpenAI还直接明示了定价计划,微调费用主要分为初始训练费用和使用费用。

一个具有10万tokens训练数据集的微调工作(3个epoch训练)成本大概在2.40美元。

此外,OpenAI还透露了GPT-4微调将于今年秋天推出。

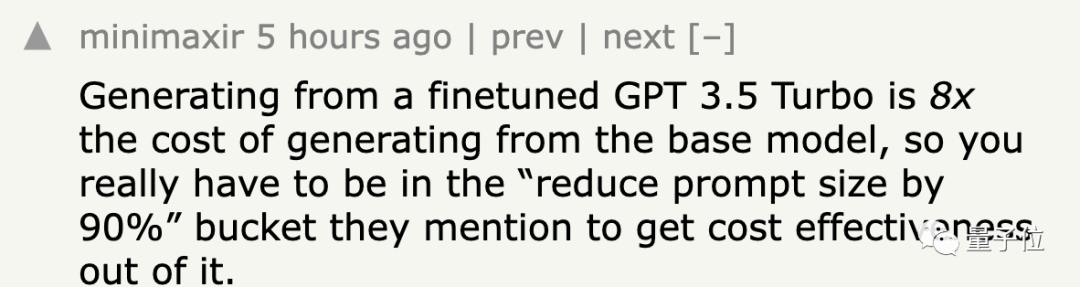

不过也有人不吃这套,吐槽微调成本太高,其生成成本是基础模型的8倍,必须要按照他们所说“将提示大小减小90%”,才能从中获取效益。

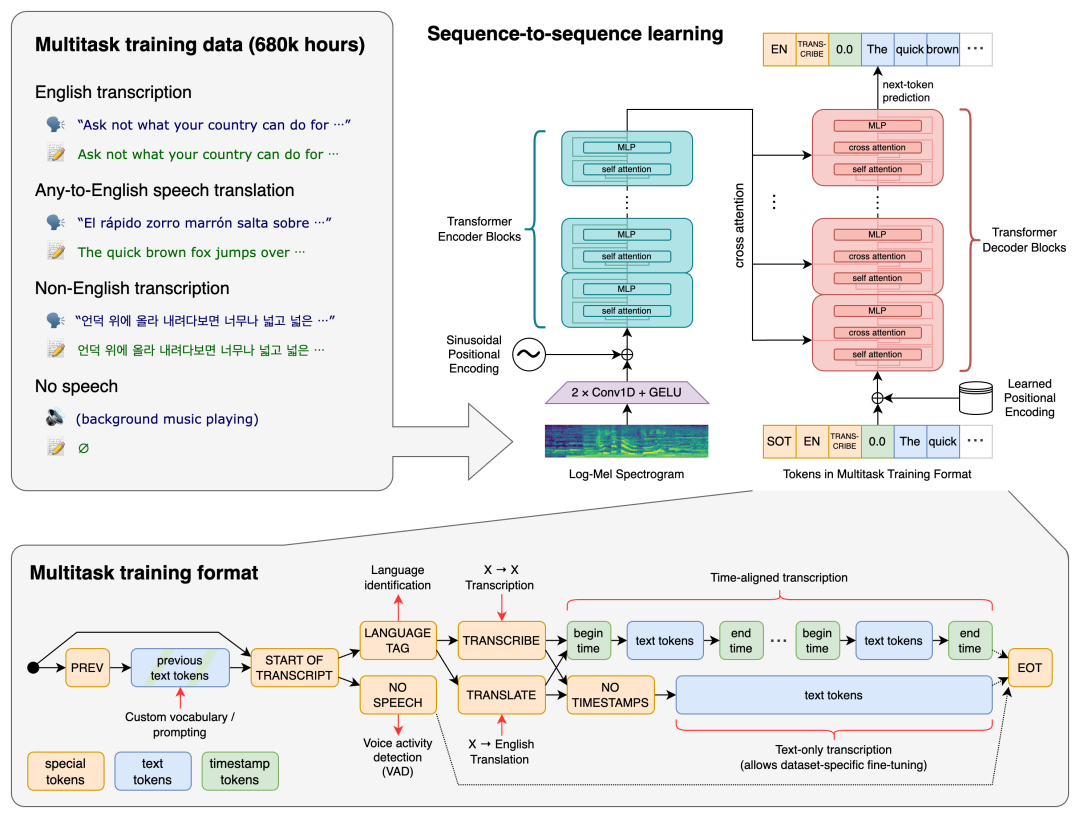

开发者自己进行监督微调

OpenAI首先给出了指南手册,微调可以用来改进这些模型性能。

-

可操纵性的改进,模型能够更好地遵循指令。比如输出简洁回答或始终以给定的语言响应。

-

一致的格式化响应,开发人员可用微调将用户提示转换为高质量JSON代码片段,随后用于自己的系统。

-

定制语气,微调可以更好磨炼模型输出的质感,比如语气,让它更适合企业品牌的声音。

除了提高性能之外,还能缩短提示时间,确保类似性能。另外,微调目前仅支持处理4000 tokens,这也是此前微调型号的两倍。16k tokens微调将于今年秋季推出。

早期测试人员通过对模型本身指令进行微调,加快了API调用还降低成本,让prompt减少了90%。

对函数调用结合和 gpt-3.5-turbo-16k的微调支持将在今年秋季晚些时候推出。

具体微调步骤,分为四步:

准备数据

{

"messages":[

{"role":"system","content":"Youareanassistantthatoccasionallymisspellswords"},

{"role":"user","content":"Tellmeastory."},

{"role":"assistant","content":"Onedayastudentwenttoschoool."}

]

上传文件

curl-https://api.openai.com/v1/files

-H"Authorization:Bearer$OPENAI_API_KEY"

-F"purpose=fine-tune"

-F"file=@path_to_your_file"

创建微调作业

curlhttps://api.openai.com/v1/fine_tuning/jobs

-H"Content-Type:application/json"

-H"Authorization:Bearer$OPENAI_API_KEY"

-d'{

"training_file":"TRAINING_FILE_ID",

"model":"gpt-3.5-turbo-0613",

}'

使用微调模型

curlhttps://api.openai.com/v1/chat/completions

-H"Content-Type:application/json"

-H"Authorization:Bearer$OPENAI_API_KEY"

-d'{

"model":"ftorg_id",

"messages":[

{

"role":"system",

"content":"Youareanassistantthatoccasionallymisspellswords"

},

{

"role":"user",

"content":"Hello!Whatisfine-tuning?"

}

]

}'

OpenAI透露,未来他们将推出微调UI,这样轻松访问正在进行中的工作。

定价方面,分为训练成本和使用成本。

-

训练:0.008美元/1000 tokens;

-

使用输入:0.012美元/1000 tokens;

-

使用输出:0.016 美元/1000 tokens。

不过可以看到的是,价格确实比基础模型高了不少。

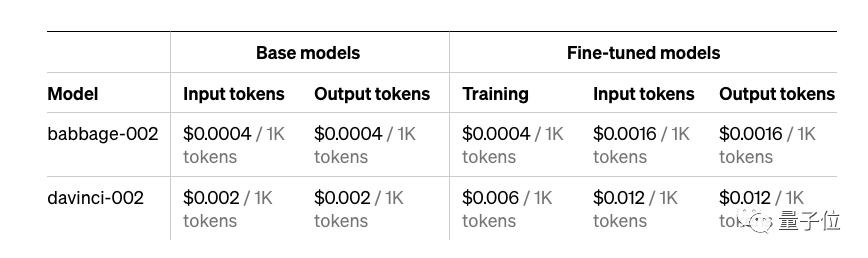

更新了GPT-3模型

与此同时,OpenAI还在API端口更新了GPT-3模型:babbage-002 和 davinci-002。

这些模型都可以用新的API端点进行微调。

原始基础模型 (ada, babbage, curie, 和 davinci)将于明年*(2024年)1月4日关闭。

好了,感兴趣的朋友可以开始定制自己的GPT-3.5Turbo了。

-

数据集

+关注

关注

4文章

1212浏览量

24911 -

OpenAI

+关注

关注

9文章

1181浏览量

6825 -

大模型

+关注

关注

2文章

2714浏览量

3318

原文标题:OpenAI开放大模型微调功能!上传自己数据就可定制GPT-3.5Turbo,开发者狂喜

文章出处:【微信号:玩转VS Code,微信公众号:玩转VS Code】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

OpenAI 深夜抛出王炸 “ChatGPT- 4o”, “她” 来了

【「基于大模型的RAG应用开发与优化」阅读体验】+大模型微调技术解读

怎么建立开放数控系统模型?

OpenAI官宣把ChatGPT API开放

iPhone都能微调大模型了嘛

OpenAI开放大模型微调功能!

OpenAI开放大模型微调功能!

评论