TPU和NPU的区别

在IT领域中,TPU和NPU属于两种不同类型的芯片。这两种芯片都是专为人工智能(AI)和大型数据分析设计而开发的,但它们的功能和优点却有所不同。在本文中,我们将详细介绍TPU和NPU之间的区别。

什么是TPU?

TPU,即Tensor Processing Unit,是由Google公司开发的專用於深度学习的加速器。它被设计成一个ASIC(应用特定集成电路),可延长深度学习模型的训练和推理速度。TPU可以处理大量的矩阵数学运算,这是深度学习任务中最常见的操作。目前,TPU主要用于Google Cloud和TensorFlow等Google的机器学习框架。

TPU采用8位整数和浮点数形式的数值运算,协议栈采用标准的TensorFlow API。通常情况下,TPU的性能提高了15到30倍,而功耗比GPU更低,这意味着在每瓦特功耗下完成相同的任务时,TPU可以提供比GPU更多的计算性能。而且,TPU具有高度可扩展性,可以连接多达128个TPU设备。

什么是NPU?

NPU(Neural Processing Unit)是一种专为进行人工智能处理而设计的芯片。与TPU类似,NPU也由一些大型科技公司如华为、三星、苹果、英伟达等开发。NPU的目的是提高智能设备(如智能手机、平板电脑、车载系统和其他物联网设备)的AI性能。NPU可以提供快速的图像处理、语音识别和自然语言处理能力,并通过训练和推理算法来改进输出结果。

NPU的设计和TPU比较不同,它的一个主要区别在于内存体系结构。NPU通常使用整个片上系统(System-on-chip或SOC)来完成不同的计算操作。这包括一个芯片上的CPU和GPU,以及用于处理深度神经网络的专用NPU。NPU主要特点是在计算和存储量之间进行优化,这使得它在多任务处理方面表现出色,而且更擅长于小数据集的弱帧计算处理。

TPU与NPU的区别

从上述介绍可以看出,TPU和NPU在某些方面有所相似之处,但是它们在目的和功能上也存在巨大差异。

目的和适用场景

首先,在硬件设计上,TPU的目的在于加速深度学习模型的训练和推理速度,它主要适用于传统的深度学习应用,例如计算机视觉和自然语言处理。而NPU的目的是提高智能设备的AI性能,包括图像处理、语音识别和自然语言处理等,在智能手机、平板电脑、车载系统和其他物联网设备上应用广泛。

内存体系结构

其次,NPU和TPU在内存体系结构方面存在差异。NPU在设计上更侧重于内部计算和存储量之间的优化,原因是它更加注重多任务处理。而TPU的设计更注重高通量的数据处理,采用了一些不同于GPU的架构和特性,提供了更强大和更高效的良好功能。

数字精度和通用性

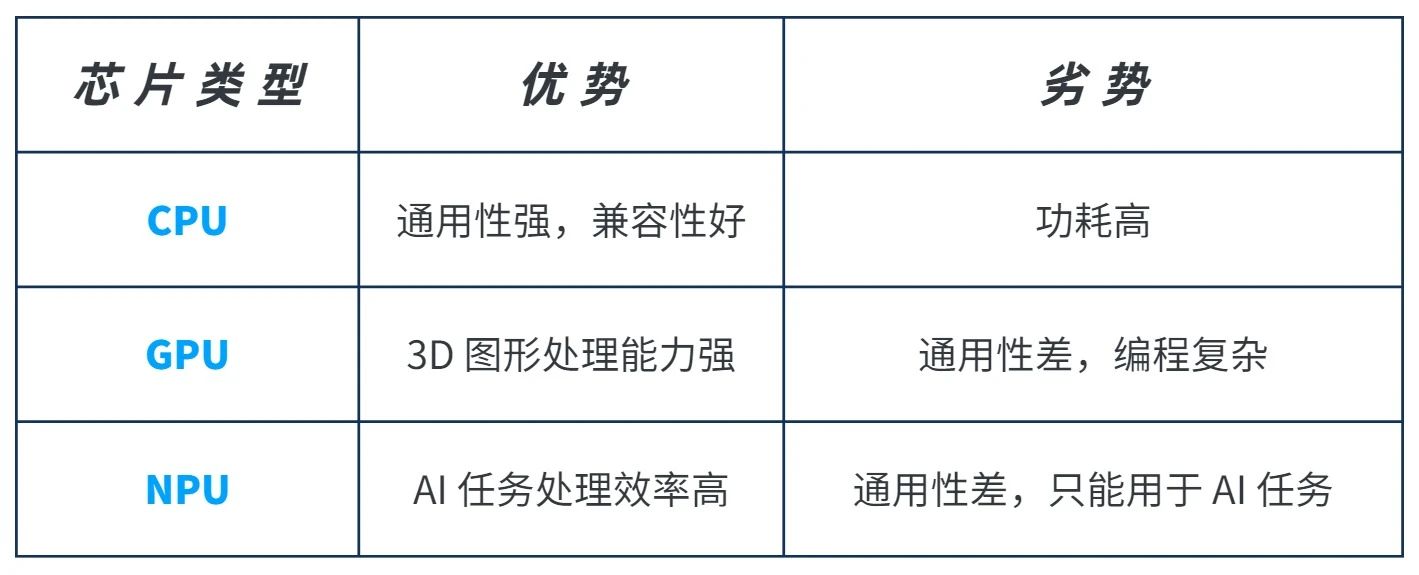

最后,两种芯片基于不同的数字精度的处理也是一项重要的区别。在深度神经网络中,8位精度的专用硬件与较高的精度例如32位操作一般至少能够拥有相同的准确性。而TPU在设计上更注重8位整数和浮点数形式的数值运算,使之更加专注于加速深度学习的特定任务。而NPU则更具通用性,可以在多种任务上具有较强的表现。

结论

总的来说,TPU和NPU都是专为人工智能应用而开发的芯片,它们各自具有一些优点和缺点。TPU的目的在于加速深度学习模型的训练和推理速度,而NPU以提高智能设备的AI性能为目标。除了目的之外,两者在内存体系结构、数字精度和通用性等方面都有所不同。为了实现最佳的AI性能,我们需要仔细评估每种芯片的优劣,在需要的场合下使用最适合的芯片,才能发挥其最大的潜力。

-

图像处理

+关注

关注

27文章

1292浏览量

56757 -

语音识别

+关注

关注

38文章

1741浏览量

112670 -

人工智能

+关注

关注

1791文章

47303浏览量

238585 -

TPU

+关注

关注

0文章

141浏览量

20732 -

NPU

+关注

关注

2文章

286浏览量

18624

发布评论请先 登录

相关推荐

NPU与传统处理器的区别是什么

NPU支持的编程语言有哪些

NPU与机器学习算法的关系

NPU的工作原理解析

如何选择合适的NPU型号

NPU在边缘计算中的优势

NPU技术如何提升AI性能

什么是NPU芯片及其功能

NPU在深度学习中的应用

什么是NPU?什么场景需要配置NPU?

TPU和NPU的区别

TPU和NPU的区别

评论