近日联想集团董事长兼首席执行官杨元庆在媒体沟通会上表示,随着人工智能的发展,尤其是AIGC的爆发会促进智能设备的升级。他认为,今年还不会有太大的影响,明年一定是革命性的影响,促进电脑的升级换代,他预计到明年可以见到AI的手机和电脑。

随着OPEN AI推出ChatGPT以来,行业一直在试图突破大模型在单个强大的消费类GPU上运行的限制。

通常,运行GPT-3需要多个数据中心级英伟达A100 GPU。但是META、谷歌和微软等科技大公司为了推动终端产品市场的发展,在端运行大模型的研发项目陆续出台。

最早是META2月份发布的LLaMA引起了轰动,因为它可以在单个强大的消费类GPU上运行。现在,通过一种被称为量化的技术来进行优化、使模型缩小后,LLaMA可以在配备M1芯片的苹果电脑或较小的英伟达消费级GPU上运行。LLaMA是一个参数大小范围从7B到65B的大型语言模型(“B”是指“十亿参数”,是存储在矩阵中的浮点数,表示模型“知道”的内容)。LLaMA较小尺寸的模型在输出质量和速度方面可以与GPT-3相媲美。

时隔半年后,Meta AI在周二发布了最新一代开源大模型Llama 2。相较于今年2月发布的Llama 1,训练所用的token翻了一倍至2万亿,同时对于使用大模型最重要的上下文长度限制,Llama 2也翻了一倍。Llama 2包含了70亿、130亿和700亿参数的模型。Meta同样在周二宣布,与微软云服务Azure合作,向全球开发者首发基于Llama 2模型的云服务。另外,Meta也与高通宣布,Llama 2将能够在高通芯片上运行,打破市场上英伟达、AMD处理器对AI产业的垄断。

而另一巨头谷歌在5月11日召开 的“2023 Google I/O”技术大会上,谷歌首席执行官Sundar Pichai介绍了最新发布的大语言模型PaLM 2,主要功能包括支持100多种语言、具备逻辑推理、代码生成等,基本上与ChatGPT的最新模型GPT-4类似,PaLM 2提供了Gecko、Otter、Bison和Unicorn四种模型。其中,Gecko非常非常轻巧,可以在移动设备端运行快速运行(手机、Pad等),即便是离线状态也能与应用程序进行交互。谷歌希望开发者通过Gecko模型,加速生成式AI在移动端的开发进程。

PaLM 2采用了一种“计算最优缩放”技术,能在最小的参数实现最大的性能,也就是说开发者可以用最少的算力资源,开发强大的生成式AI应用。AI 大模型的加入,让 Android 14成为真正内置 AI 大模型的操作系统。

其实国内早在3月份元语智能团队又开源了一个ChatYuan系列大模型:ChatYuan-large-v2,支持在单张消费级显卡、PC甚至手机上进行推理使用。ChatYuan-large-v2是ChatYuan系列中以轻量化实现高质量效果的代表模型,仅仅通过0.7B参数量可以实现业界10B模型的基础效果,并且大大降低了推理成本,提高了使用效率。用户可以在消费级显卡、 PC甚至手机上进行推理(INT4 最低只需 400M )。同时,为了更好的提升使用体验,团队已经封装了工具,Chatyuan-large-v2实现了本地可运行,下载后可以直接在本地使用h5版本,进行网页交互。

智能手机产业积极拥抱端侧AI大模型

智能手机的算力早已经超出很多消费电子终端产品,包括平板电脑、笔记本电脑、甚至PC产品,甚至很多芯片厂商的CPUGPU产品设计,已完成兼容了智能手机、平板电脑、笔记本电脑、PC产品、ARVRMR智能手表智能机器人等所有能接入物联网的硬件平台产品。

作为推动智能手机等物联网物种进化的先进技术,与单纯在云端部署生成式 AI 应用和服务相比,端侧部署生成式 AI 在节约服务器成本、保护用户信息安全、提升实时性和实现个性化用户体验等方面带来了更加广阔的应用前景。

在设备上使用生成式AI有很多好处,比如所搜索记录和个人数据是保密的,不会通过远程服务器中转。本地AI也比云端更快,而且可以在飞机上等缺少移动网络服务的地区工作。因此端侧AI大模型在包括智能手机在内的物联网行业一直有着巨大的需求。

早在今年2月份,高通就已经发布了全球首个运行在安卓手机上的图片生成软件Stable Diffusion的终端演示,该手机搭载了骁龙8 Gen2芯片。

目前高通等芯片厂商,正在针对AI大模型端侧部署研发专用的芯片。目前,高通正在将AIGC嵌入下一代高端芯片骁龙8 Gen3中,该芯片将于今年10月底在夏威夷举行的高通骁龙峰会上首次亮相。

在Asghar的实验室中,高通芯片能够处理70亿个参数的AI模型,虽然远远低于OpenAI GPT-3模型的1750亿个参数,但应该适合移动搜索。

高通表示,本年度将能够支持参数达100亿的生成式AI模型在手机上运行,这意味着未来大多数的用例将能够完全依靠手机端就能够完成。高通在技术层面已经做好了准备。

100亿-150亿参数级别的模型可以覆盖绝大多数生成式AI的用例。如果终端已经可以支持这一参数级别,那么运算可全部在终端上进行,无需云端处理运算。届时包括智能手机在内的消费电子产品和其它物联网终端产品会拥有非常丰富的使用场景,会成为真正的个人助理。

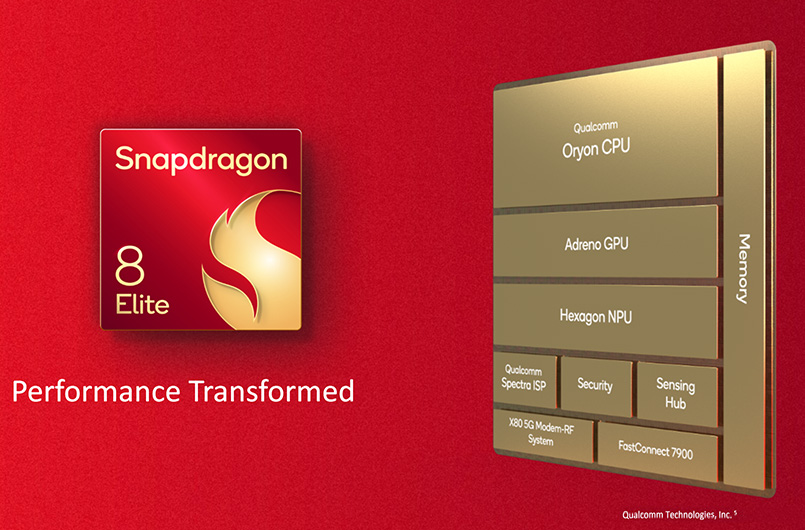

高通AI引擎由多个硬件和软件组件组成,用于在骁龙移动平台上为终端侧AI推理加速。它采用异构计算架构,包括高通Hexagon处理器、Adreno GPU、Kryo CPU和传感器中枢,共同支持在终端上运行AI应用程序。

在2023年世界人工智能大会上,高通展示了全球首个在终端侧运行生成式AI(AIGC)模型Stable Diffusion的技术演示,和全球最快的终端侧语言-视觉模型(LVM)ControlNet运行演示。这两款模型的参数量已经达到10亿-15亿,仅在十几秒内就能够完成一系列推理,根据输入的文字或图片生成全新的AI图像。

高通认为在数据产生的地方直接进行高效推理才是大趋势。而数据产生的地方正是在端侧,比如手机端或电脑端。在高通AI软件栈(Qualcomm AI Stack)的帮助下,手机端的能力更是可以在其他设备端实现复制,如PC、AR/VR、汽车和物联网IoT设备。

同时另一智能移动产品芯片巨头联发科也在近期宣布联合百度发起飞桨和文心大模型硬件生态共创计划,共同推进联发科硬件平台与飞桨和文心大模型适配。本月联发科还宣布运用Meta LIama 2大语言模型和联发科先进的AI处理器(APU)以及完整的AI开发平台(NeuroPilot),建立完整的终端侧AI计算生态,赋能终端设备生成式AI应用。

联发科与百度合作已久,双方合作完成了 Paddle Lite 轻量化推理引擎基于 MediaTek NeuroPilot 人工智能通用软件平台的适配。NeuroPilot 是 MediaTek 为开发者提供的基于本地端侧的 AI 运算解决方案,它为内建 CPU、GPU 和 APU(独立AI 处理器)等异构运算单元的 MediaTek SoC 平台提供完整且强大的软件解决方案。

联发科将于年末推出新一代旗舰移动芯片,将采用针对Llama 2模型而优化的软件栈(NeuroPilot),与搭配支持Transformer模型做骨干网络加速的升级版AI处理器(APU),可减少动态随机存取内存(DRAM)的读写消耗和带宽占用,进一步强化大语言模型和生成式AI应用的性能,助力开发者打造令人惊艳的AI应用,加速终端设备AI应用落地发展,持续为智能手机、汽车、智能家居、物联网等终端设备用户带来振奋人心的生成式AI应用体验。

智能手机厂商闻AI大模型起舞

近年来手机产业发展进入创新瓶颈期,手机厂商正试图寻找新的差异化出路。特别今年以来,随着ChatGPT的横空出世和全民级应用发展趋势,众多手机厂商纷纷入局AI大模型赛道,除谷歌外,荣耀、OPPO、vivo、小米、华为等国产手机巨头。

据业内人士表示,荣耀已经把AI大模型引入端侧,赋能YOYO智慧助手,打造更加个人化、人性化,隐私保护更周全的端侧个人模型;小米将小爱同学升级大模型,小米手机端侧大模型已初步跑通;OPPO、vivo 也计划在系统中整合AI 大模型能力。

8月4日,华为对外发布HarmonyOS 4,将AI大模型能力内置在了系统底层。HarmonyOS 4由华为盘古大模型提供底层支持,希望给用户带来智慧终端交互、高阶生产力效率、个性化服务的全新AI体验变革。

在8月14日晚举办的小米年度演讲中,雷军表示,小米AI大模型最新一个13亿参数大模型已经成功在手机本地跑通,部分场景可以媲美60亿参数模型在云端运行结果。小米旗下人工智能助手小爱同学已开始升级AI大模型能力,正在开启邀请测试。

而OPPO推出了基于 AndesGPT 打造的全新小布助手也即将开启大型体验活动。据介绍, AndesGPT 是 OPPO 安第斯智能云团队打造的基于混合云架构的生成式大语言模型,升级后的小布助手将具备 AI 大模型能力,拥有更强的语义理解对话能力。此外,vivo将在今年10月左右推出新的OriginOS 4.0系统,新系统将内置AI大模型。

INT4量化技术让端模型进化成通用智能体

量化(quantization)和定点数计算取得了不错的成果。一方面是节省了空间,另外硬件定点数的计算效率也通常更高。

模型参数可以采用32位/比特浮点(FP32)格式表示,但不如以定点(fixed point)格式表示,因为这几乎没有精度损失,甚至更高,但计算量却较低。定点数量化模型的位/比特越小,模型存储越小,执行加速越大,这种策略不仅可以减少占用的内存,还可以减少与计算相关的功耗。

在CPU和DSP上对量化网络延迟进行基准测试:与CPU浮点数相比,量化模型实现的速度提高了2-3倍;具有定点数SIMD功能的专用处理器(例如带HVX的Qualcomm QDSP)提速高达10倍。

现在人们已经证明,FP32训练的参数可以改成4位/比特整数(INT4)做推理,没有显著精度损失,甚至训练时候采用INT4也可以。与服务器上训练的模型一般采用32位浮点运算(FP32)不同,端侧大模型端基本上采用INT4计算,大大提高了端侧的处理能力。

在量化技术的支持下,支持INT4计算的端侧AI大模型很快会成功运用到智能手机上,未来也将很快延伸到与智能手机芯片平台相关的其它物联终端产业,如电脑、汽车电子、机器人、智能家居等,端侧AI大模型将引领包括智能手机在内的物联网终端产品,加入到AI进化的下一场产业革命中。

业内人士表示,受限能耗、系统性能、模型迭代效率,边际效益递减等因素,模型的规模增长不会像过去几年一样高速,而是朝更高效的模型结构(e.g. Sparse Activation),训练方式(Self-supervise),更高效的部署(e.g. Distillation)发展。

模型的感知和记忆能力会快速、全面超过人类水平,并且固化下来,形成通用化的应用场景。而模型的动态决策能力,复杂场景的应变能力还有较大的发展空间。模型的可解释性、可控性短期可能不会有比较大的突破,但是大的研究机构会持续投入,并形成一些差异化的竞争力。

在虚拟世界(或者说是现在比较火的元宇宙),未来5~10年可能会先出现比较通用的智能体。原因是基于强化学习的相关技术在虚拟世界有较低的迭代成本和安全顾虑。

-

智能手机

+关注

关注

66文章

18499浏览量

180375 -

AI

+关注

关注

87文章

31000浏览量

269333 -

人工智能

+关注

关注

1792文章

47354浏览量

238815 -

大模型

+关注

关注

2文章

2476浏览量

2818

原文标题:端侧大模型到通用智能体——智能手机AI进化的下一场革命(一)

文章出处:【微信号:AIOT大数据,微信公众号:AIOT大数据】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

全球智能手机中端市场份额大幅下滑

探索智能手机上的生成式AI

图为大模型一体机新探索,赋能智能家居行业

能效比较GPGPU高一个数量级,国产AI芯片让端侧AI大模型高质量落地

谷歌Tensor G5芯片代工转向台积电,强化AI智能手机竞争力

OPPO引领AI手机新时代,全面普及智能生活

英伟达宣布拆股 黄仁勋:下一场工业革命已开始

高通CEO:结合生成式AI的智能手机将引领新升级周期

AI技术的“革命”进入智能手机市场,“魔法大模型”加持荣耀MagicOS 8.0

端侧大模型到通用智能体——智能手机AI进化的下一场革命(一)

端侧大模型到通用智能体——智能手机AI进化的下一场革命(一)

评论