Q应对 AI 发展带来的计算挑战,什么样的处理器才是最佳选择?

为长期运行的计算密集型 AI 训练和大规模 AI 推理选择合适的 CPU 或 GPU,本质上是要为您的应用选择适宜的计算解决方案。相比传统 x86 处理器成本高、能耗大,最新的 Ampere 云原生处理器助力打造高能效、高性能的 AI 推理应用,是其理想的替代方案,同时也是用于 AI 训练和大语言模型(LLM)推理 GPU 的高性价比之选。

从 20 世纪 50 年代的首个实例,到如今更为复杂的机器学习、深度学习,甚至是生成式 AI 技术,高性能计算的需求始终是驱动 AI 计算发展的引擎,但模型的研究和训练往往需要投入高昂的成本。

目前,AI 技术已进入广泛应用的阶段,也出现了为 AI 推理超额配置计算的情况,这导致了高昂的成本支出(无论是硬件的单位成本,还是硬件运行的电力成本)。因此,为不同类型的 AI 工作负载采用 GPU-Only 虚拟机的做法,正在被能够大幅降低 AI 计算能耗的其他方案所替代。

与传统计算相比,运行 AI 需要更高的能耗。Bloomberg 对此进行了详细介绍:ChatGPT3 的参数量达到 1,750 亿,消耗了高达 1.287 千兆瓦时电量,相当于120 户美国家庭一年的耗电量。而类似 ChatGPT4 这样的新模型(预计参数量达到 1.7 万亿),将比 ChatGPT3 消耗更高的电量。

由于 AI 带来的能耗需求飙升,配置适度算力并减少所需的计算量是行业迫在眉睫的需求。云原生计算可助力降低运行成本,为配置硬件层面的适度算力奠定基础,满足当前和未来的计算需求,并降低能耗。

配置适度算力,满足计算和效率需求

云原生处理器是 CPU 架构的一项创新,是 AI 推理切实可靠的新选择,可替代高成本、高能耗的传统 x86 处理器。为 AI 应用程序配置适度算力,意味着您可以决定使用 CPU-Only,或是将云原生处理器的能效、可扩展性和计算性能与 GPU 的并行计算能力相结合。

如您希望拥有价值及能效更高的 AI 解决方案,告别传统方案导致的高成本和高能耗,可遵循以下 3 项简单准则:

保持灵活性,满足未来的计算需求

仅部署可满足应用程序性能需求的计算量,并尽可能多地使用通用处理器,而非专用处理器。此举有助于保持灵活性,以便满足未来的计算需求。

将 CPU-Only 的 AI 推理

从传统 x86 处理器转移至云原生处理器

相比传统的 x86 处理器,您可以借助 Ampere 云原生处理器带来的性能增益,在 CPU-Only 的情况下部署更广泛的 AI 工作负载。

GPU 与高能效的云原生处理器相结合

将 GPU 与高能效的云原生处理器相结合,以处理任务更繁重的 AI 训练或 LLM 推理工作负载。

若您想了解关于 Ampere 云原生处理器能效的更多精彩内容,请参阅指南:《云原生处理器助力数据中心效率劲升三倍》

仅部署您所需的计算量

在 AI 技术发展的研究和训练阶段,GPU 是所有 AI 应用(包括建模和推理)的首选处理器。虽然 GPU 推动了 AI 的发展,但对于许多 AI 应用而言,GPU 提供的算力已经过剩,尤其是针对离线(batch)推理或批量推理而言。

离线推理(Batch Inference)应用是算力要求较低的工作负载,不需要 GPU 的处理能力:为此而购买 GPU,犹如为了 5 公里的上班路程购置豪华跑车——这显然是大材小用。当把同样昂贵的 GPU 硬件分别用于运行大型和小型模型时,小模型可能仅用了 GPU 能力的一小部分。在这些情况下,CPU 可以代替 GPU,帮助您节省能耗、空间和成本。

在处理离线推理时,那些遵循默认做法而采用 GPU 方案的客户,至少错过了两种更合适的优化方案。

方案一

将 GPU 替换成适用于 AI 推理的高性能云原生处理器。

适用于 AI 推理的高性能云原生处理器。

方案二

将 GPU 与云原生处理器进行结合,以实现更高效的 LLM 推理和训练工作。

这正是我们所定义的"适度算力"。

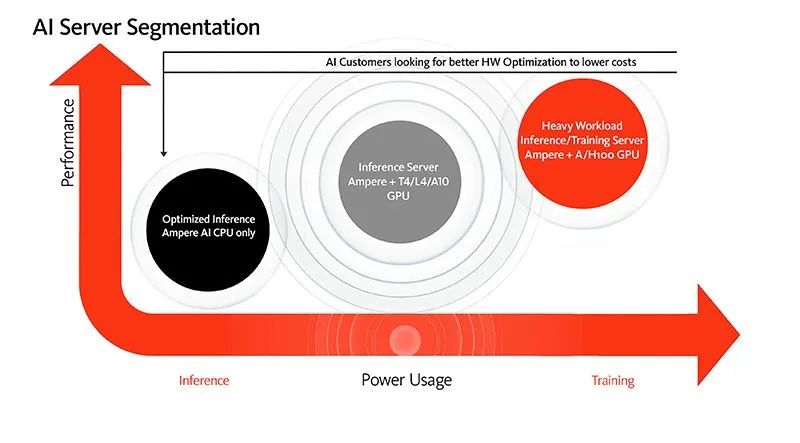

以下模型呈现了如何为 AI 应用程序配置适度算力,同时也对比了性能、计算需求与所需功耗。根据模型,CPU-Only 解决方案是纯 AI 推理计算的优选项,而需要更高性能的应用程序,可以在 CPU 和 GPU 的组合上运行。

当然,CPU 的选择也决定着您将付出的能耗以及获得的每瓦性能。而云原生处理器的性能优势和 Ampere 优化的 AI 软件,让 CPU 成为运行 AI 推理工作负载的理想之选。

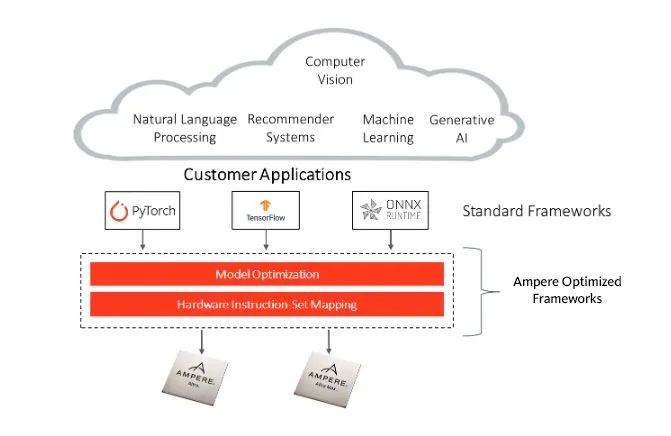

将 AI 推理全部迁移至云原生处理器

欢迎加入云原生社区,这里汇聚了众多开发和设计人员。他们发现仅使用 Ampere 云原生处理器,也能够实现高效的 AI 推理。Ampere 优化的 AI 框架支持所有在最流行 AI 框架中开发的模型,包括 PyTorch、TensorFlow 和 ONNX Runtime,这种丰富的集成提供了无缝的体验,且无需修改 API 或进行额外的模型编码。

Ampere 优化的 AI 框架

相比传统的 x86 处理器,Ampere Altra 系列云原生处理器在 AI 推理方面拥有显著的性能优势,包括:

针对计算机视觉工作负载,性能最高可提升 4 倍*。

针对常见的NLP 工作负载,每瓦性能最高可提升 3 倍*。

Ampere AI 优化软件可提供更高效的 AI 推理。基于 Ampere 处理器的 AI 和 ML 推理工作负载,可通过 Ampere AI 解决方案的软件框架进行优化。通过使用 Ampere AI 解决方案,基于 CPU 的推理工作负载能够获得在成本、性能、可扩展性和能效等方面的优势,同时用户能够使用常见的标准 AI 框架进行编程。这套框架易于使用,无需转换代码,并且免费。

借助 fp16 数据格式的独特支持,Ampere Altra 系列处理器可实现最佳的推理性能——与 fp32 数据格式相比,fp16 数据格式可提供高达 2 倍的额外*加速,并且精度损失微乎其微。

将 GPU 与高能效 CPU 结合,

开展 AI 训练和推理

在需要使用 GPU 的 AI 应用中,繁重的 AI 工作负载由 GPU 处理,而 CPU 则需要充当系统主机。在这样的应用中,因为 GPU 决定了系统性能,所以无论使用哪种 CPU,它们的性能始终相同。

CPU 之间的区别在于其整体效率。与传统 x86 CPU 相比,云原生处理器将为您带来高能效,帮助显著降低系统的总体能耗*,并提供同等的性能。

采用云原生处理器,每台服务器可以节省数百瓦电力,这足以让您在每个机架上再增加一台服务器。虽然看似收益颇微,但实际上通过每机架增加一台服务器,整个数据中心的计算密度将大幅提升。此外,在服务器层面节省能耗还可以减少对冷却系统的依赖,从而节省更多成本,并进一步降低能耗。

云原生处理器与 GPU 相结合,有助于实现目标性能,并降低能耗和总体成本。

未来的 AI:强大、高效、开放

随着 AI 加速涌入我们的生活和工作,我们需要克服的最关键障碍,是如何降低 AI 大规模应用的成本,而适度算力以及模型优化能够带来规模效率。

为计算配置适度算力,不仅需要确保硬件解决方案能满足当前的计算需求,还需要能够支持应用程序扩展,并经得起未来的算力需求考验。Ampere 云原生处理器为您提供广泛的选择,既能满足您当前的需求,同时具备灵活性,可轻松满足您未来的需求。无论您是选择 CPU-Only 的方案,还是 GPU 与 CPU 相结合的解决方案,云原生架构都拥有性能和效率优势,契合您当前和未来的计算需求。

为云计算而生,Ampere 云原生处理器为行业提供可预测的卓越性能、平台可扩展性和空前的能效。

欢迎您与我们的专业销售团队洽谈合作,获取更多信息,或通过我们的开发者体验计划试用 Ampere System。

审核编辑:汤梓红

-

处理器

+关注

关注

68文章

19533浏览量

231846 -

cpu

+关注

关注

68文章

10945浏览量

213878 -

AI

+关注

关注

87文章

32408浏览量

271585 -

人工智能

+关注

关注

1800文章

48076浏览量

242131 -

ChatGPT

+关注

关注

29文章

1578浏览量

8281

原文标题:创芯课堂|用于人工智能(AI)的最佳处理器怎么选?

文章出处:【微信号:AmpereComputing,微信公众号:安晟培半导体】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

人工智能中的处理器如何选择

人工智能中的处理器如何选择

评论