近日,2023百度云智大会于北京圆满落幕。众多人工智能领域专家、行业精英、意见领袖等齐聚一堂,共同站在大模型重构未来的新起点,展望大模型创新发展之路。

作为百度四层架构的坚实算力底座,昆仑芯携两代芯片产品重磅亮相主会场及“智能计算&大模型技术论坛”展区。昆仑芯科技芯片研发总监漆维在专题论坛上进行精彩主题演讲,获得与会嘉宾及各级媒体的广泛关注。

大会期间,昆仑芯以多媒体形式展示芯片产品的领先性能优势,为嘉宾直观呈现昆仑芯产品强大性能以及赋能千行百业的落地成果。

在百度的四层架构中,昆仑芯作为强大算力底座,通过对市场需求的深刻洞察,率先布局大模型领域。同时,昆仑芯与框架、模型、应用层高效协同,通过端到端软硬逐层优化,携手打造大模型端到端解决方案,实现了百家客户、数万片规模部署。

“智能计算&大模型技术论坛”上,昆仑芯科技芯片研发总监漆维带来了“昆仑芯端到端大模型算力解决方案”主题分享。面对大模型时代计算的效率和成本问题,昆仑芯通过架构创新、产品定义创新以及软件创新,打造出基于自研核心架构XPU-R的大模型产品矩阵。针对不同参数量级的大模型场景,昆仑芯兼具显存和成本优势:

昆仑芯AI加速卡R200-8F面向百亿以内参数量级,相比同类型产品性能提升20%;

昆仑芯AI加速器组R480-X8面向百亿至千亿参数量级,性能达到同类型产品的1.5倍以上;

昆仑芯AI加速器组R480-X8集群针对千亿以上参数量级,可实现多机多卡分布式推理。

“作为一款人工智能芯片,从芯片完成设计到真正走向行业落地,生态是其中非常重要的环节。”漆维在演讲中分享了昆仑芯在软件生态方面的成果。目前,昆仑芯提供了针对大模型场景的昆仑芯XFT(XPU Faster Transformer)推理加速库、丰富的云原生插件。同时,昆仑芯已全面拥抱最大的大模型开源社区HuggingFace,打造了xHuggingface开源推理套件,并携手飞桨等生态伙伴构建软硬一体的AI芯片生态。

当前,大模型的技术生态正快速发展,驱动产业实践、行业创新应用,而这离不开AI产业链各企业的加持。在圆桌论坛环节,漆维与同台专家、优秀企业家代表围绕“大模型创新发展之路”展开深入探讨。

漆维表示:“大模型技术的发展为国内AI芯片企业带来了良好的前景,但也带来了算力需求及成本的挑战。昆仑芯始终坚持开拓创新,降低AI算力成本与使用门槛,加强与AI产业链上下游企业的合作,为市场提供更优质的产品和服务。目前,已有两代昆仑芯AI芯片实现量产和规模部署,而在研的下一代产品将为大模型和AIGC等应用提供更佳的性能体验。”

AI算力正成为数字基建的新抓手,以及制约大模型技术发展的关键要素。作为AI芯片领域的领军企业,昆仑芯将继续秉承“让计算更智能”的使命,打造更高性能的芯片产品,提供更普惠的AI算力,携手生态伙伴领跑大模型产业落地。

审核编辑:彭菁

-

芯片

+关注

关注

455文章

50812浏览量

423569 -

人工智能

+关注

关注

1791文章

47274浏览量

238462 -

昆仑芯科技

+关注

关注

0文章

27浏览量

616 -

大模型

+关注

关注

2文章

2448浏览量

2699

原文标题:昆仑芯漆维:多维度创新应对大模型时代的算力挑战

文章出处:【微信号:昆仑芯科技,微信公众号:昆仑芯科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

同风起,耀星河!华为携手伙伴一起创造无限可能

中软国际入选中国电信广东公司大模型生态伙伴库

同风起,耀星河!华为携手伙伴一起创造无限可能

开放原子开源生态大会OpenHarmony生态主题演讲报名开启

携手生态伙伴,Imagination GPU助力边缘生成式AI

芯盾时代携手业界伙伴推动网络安全产业高质量发展

软通动力携手伙伴共创母婴行业垂域大模型

MediaTek携手生态伙伴联合发布《生成式AI手机产业白皮书》

MediaTek携手生态伙伴联合发布《生成式AI手机产业白皮书》,共同定义生成式AI手机

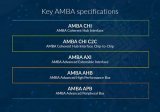

为什么选择将AMBA CHI用于芯粒呢?

先楫高性能MCU HPM6800系列产品生态绽放,共链未来

首个鸿蒙生态创新中心在深揭幕,开启鸿蒙产业新篇章共绘鸿蒙原生应用开发新篇章

芯海科技荣膺卓越伙伴殊荣,携手鸿蒙智联双向赋能智选品牌创新

昆仑芯科技携手生态伙伴领跑大模型产业落地

昆仑芯科技携手生态伙伴领跑大模型产业落地

评论