从云端到网络边缘,NVIDIA GH200、H100 和 L4 GPU 以及 Jetson Orin 模组在运行生产级 AI 时均展现出卓越性能。

NVIDIA GH200 Grace Hopper 超级芯片首次亮相 MLPerf 行业基准测试,其运行了所有数据中心推理测试,进一步扩大了 NVIDIA H100 Tensor Core GPU 的领先优势。

总体测试结果表明,NVIDIA AI 平台无论是在云端还是网络边缘均展现出卓越的性能和通用性。

此外,NVIDIA 宣布推出全新推理软件,该软件将为用户带来性能、能效和总体拥有成本的大幅提升。

GH200 超级芯片在 MLPerf 一骑绝尘

GH200 将一颗 Hopper GPU 和一颗 Grace CPU 连接到一个超级芯片中。这种组合提供了更大内存、更快带宽,能够在 CPU 和 GPU 之间自动切换计算所需要的资源,实现性能最优化。

具体而言,内置 8 颗 H100 GPU 的 NVIDIA HGX H100系统,在本轮每项 MLPerf 推理测试中均实现了最高吞吐量。

Grace Hopper 超级芯片和 H100 GPU 在所有 MLPerf 数据中心测试中均处于领先地位,包括针对计算机视觉、语音识别和医学成像的推理,以及应用于生成式 AI 的推荐系统和大语言模型(LLM) 等对性能要求更高的用例。

总体而言,此次测试结果延续了自 2018 年 MLPerf 基准测试推出以来,NVIDIA 在每一轮 AI 训练和推理中都处于领先性能的纪录。

最新一轮 MLPerf 测试包括一项更新的推荐系统测试,并新增首个 GPT-J 上的推理基准测试。GPT-J 是一个由 60 亿个参数组成的大语言模型(LLM),而 AI 模型的大小通常根据它有多少参数来衡量。

TensorRT-LLM 大幅提升推理能力

为了应对各类复杂的工作负载,NVIDIA 开发了一款能够优化推理的生成式 AI 软件——TensorRT-LLM。该开源库使客户能够在不增加成本的情况下将现有 H100 GPU 的推理性能提升两倍以上。由于时间原因,TensorRT-LLM 没有参加 8 月的 MLPerf 提交。

NVIDIA 的内部测试表明, 在运行 GPT-J 6B 模型时,相较于没有使用 TensorRT-LLM 的上一代 GPU,在 H100 GPU 上使用 TensorRT-LLM 能够实现高达 8 倍的性能提升。

该软件始于 NVIDIA 在对 Meta、AnyScale、Cohere、Deci、Grammarly、Mistral AI、MosaicML(现为 Databricks 的一部分)、OctoML、Tabnine 和Together AI 等领先公司进行加速和优化 LLM 推理时所做的工作。

MosaicML 在 TensorRT-LLM 的基础上添加了所需的功能,并将这些功能集成到他们现有的服务堆栈中。Databricks 工程副总裁 Naveen Rao 表示:“这已成为相当轻而易举的事情。”

Rao 补充说:“TensorRT-LLM 简单易用、功能丰富且高效。它为正在使用 NVIDIA GPU 的 LLM 服务提供了最先进的性能,并使我们能够将节省的成本回馈给我们的客户。”

TensorRT-LLM 是 NVIDIA 全栈 AI 平台持续创新的最新实例。这类持续的软件进步为用户带来了无需额外成本即可实现随着时间不断提升的性能,并且广泛适用于多样化的 AI 工作负载。

L4 为主流服务器增强推理能力

在最新 MLPerf 基准测试中,NVIDIA L4 GPU 运行了所有工作负载,并全面展现了出色的性能。

例如,在紧凑型 72W PCIe 加速器中运行时,L4 GPU 的性能比功耗超出其近 5 倍的 CPU 提高了 6 倍。

此外,L4 GPU 具有专用媒体引擎,与 CUDA 软件搭配使用,在 NVIDIA 的测试中为计算机视觉提供了高达 120 倍的加速。

谷歌云和许多系统制造商现已支持 L4 GPU,为从消费互联网服务到药物研发各行业的客户提供服务。

大幅提升边缘性能

此外,NVIDIA 采用了一种全新模型压缩技术来展示在一个 L4 GPU 上运行 BERT LLM 的性能提升高达 4.7 倍。该结果体现在 MLPerf 的“开放分区”中,这个类别旨在展示新能力。

这项技术有望应用于所有 AI 工作负载。它尤其适用于在空间和功耗受限的边缘设备上运行模型。

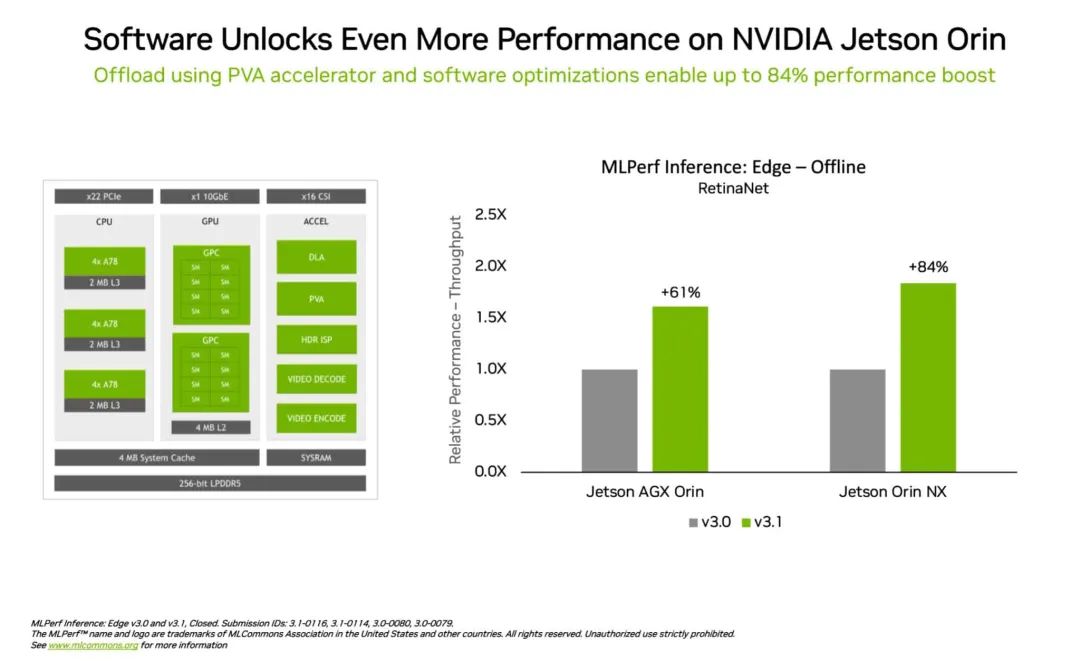

在另一个体现边缘计算领导力的例证中,NVIDIA Jetson Orin 模块化系统将边缘 AI 和机器人应用场景中常见的计算机视觉用例——目标检测的性能比上一轮测试提升高达 84%。

Jetson Orin 性能的提升得益于软件可以充分利用该芯片的最新核心,如一个可编程视觉加速器、一颗 NVIDIA Ampere 架构 GPU 和一个专用深度学习加速器等。

灵活的性能与庞大的生态

MLPerf 基准测试是透明且客观的,因此用户可以根据其结果做出明智的购买决定。该测试还涵盖了丰富的用例和场景,能够让用户获得可靠且可以灵活部署的性能。

本轮提交测试结果的合作伙伴包括微软 Azure 和 Oracle Cloud Infrastructure 等云服务提供商以及华硕、Connect Tech、戴尔科技、富士通、技嘉、惠与、联想、QCT、超微等系统制造商。

总体而言,MLPerf 已得到 70 多家机构的支持,包括阿里巴巴、Arm、思科、谷歌、哈佛大学、英特尔、Meta、微软和多伦多大学等。

NVIDIA 在基准测试中使用的所有软件均可从 MLPerf 软件库中获得,因此每个人都能实现全球领先的结果。我们不断将这些优化措施整合到 NVIDIA NGC 软件中心的容器中供 GPU 应用使用。

点击“阅读原文”阅读技术博客,详细了解我们如何实现这些最新的成果。

原文标题:NVIDIA Grace Hopper 超级芯片横扫 MLPerf 推理基准测试

文章出处:【微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

-

英伟达

+关注

关注

22文章

3739浏览量

90790

原文标题:NVIDIA Grace Hopper 超级芯片横扫 MLPerf 推理基准测试

文章出处:【微信号:NVIDIA_China,微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA Colossus超级计算机集群突破10万颗Hopper GPU

NVIDIA 以太网加速 xAI 构建的全球最大 AI 超级计算机

浪潮信息AS13000G7荣获MLPerf™ AI存储基准测试五项性能全球第一

NVIDIA AI芯片Blackwell推迟发布引热议,公司强调Hopper需求强劲

亚马逊未中断英伟达订单,等待Grace Blackwell更强性能

NVIDIA Grace Hopper点亮AI超级计算新时代

NVIDIA通过CUDA-Q平台为全球各地的量子计算中心提供加速

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片

美国首个Grace Hopper架构超算Venado落地:达10 exaFLOPS

NVIDIA推出搭载GB200 Grace Blackwell超级芯片的NVIDIA DGX SuperPOD™

NVIDIA 推出 Blackwell 架构 DGX SuperPOD,适用于万亿参数级的生成式 AI 超级计算

英伟达Grace-Hopper提供一个紧密集成的CPU + GPU解决方案

AWS成为第一个提供NVIDIA GH200 Grace Hopper超级芯片的提供商

亚马逊云科技与 NVIDIA 宣布开展战略合作,为生成式 AI 提供全新超级计算基础架构、软件和服务

NVIDIA Grace Hopper 超级芯片横扫 MLPerf 推理基准测试

NVIDIA Grace Hopper 超级芯片横扫 MLPerf 推理基准测试

评论