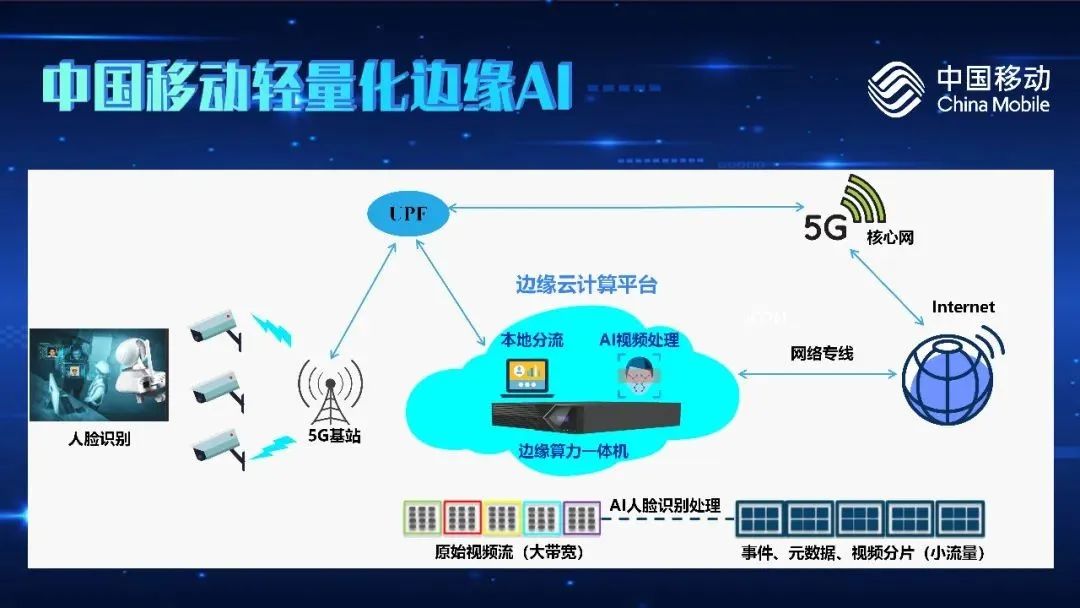

1. 中国移动轻量化边缘AI,让识别更准更快

原文:http://szjj.china.com.cn/2023-09/14/content_42521336.html随着各行各业对AI需求的井喷,边缘AI成为炙手可热的领域。边缘AI能够在靠近数据产生的边缘侧,更高效、更低成本、更安全地进行实时AI分析,已经成为万物互联时代AI应用的关键技术。在刚刚结束的第二届光合组织解决方案大赛中,中国移动智慧家庭运营中心研发的“基于边缘云计算平台的AI智能识别应用”方案,获得了光合组织AI解决方案大赛三等奖。业内人士认为,该方案极大提升了边缘AI的性能与灵活性,将推动边缘侧AI人脸识别的规模化应用。

1:N≤0.5S/人,实现边缘AI性能突破

过去,受制于边缘节点计算性能与成本的制约,AI人脸识别应用广泛部署在云端。但边缘侧数据的上传和结果的下发受网络状况影响较大,往往面临计算响应延迟、网络带宽拥挤等挑战,同时也存在一定的数据安全风险。中国移动智慧家庭运营中心的“基于边缘云计算平台的AI智能识别应用”方案,将原本部署在平台侧的AI识别算法,下沉到以海光异构加速卡算力资源和存储资源为基础设施的边缘节点,实现了实时的、高效的人脸识别功能,极大提升了AI人脸识别的性能,降低了带宽成本。与市场已有的人脸识别方案相比,“基于边缘云计算平台的AI智能识别应用”方案具备三大优势:第一,更高的识别准确度与更快的识别速度。方案精准定位目标人脸中360个以上关键点位置,并使用生成对抗网络的侧脸识别演进算法降低对人脸角度的要求,识别率更高。方案还具备高识别比对速度,达到1:N比对时间(从N个人脸数据中找出1个目标进行匹配)≤0.5S/人的指标,满足多人无感同行需求。第二,实现边缘云平台的统一管理,降本增效。通过轻量云平台技术构建了边缘资源池,方案对AI所需资源统一编排管理,实现融合联动,不仅能够节约建设成本,还大幅降低了管理运维成本。第三,全面的数据安全性。方案底层的海光异构加速芯片通过扩充安全算法指令、集成安全算法专用加速电路等方式,提升了整体方案的数据安全性。在边缘侧处理海量人脸图像,保障了敏感数据不出网,杜绝了隐私数据泄露等安全隐患。此外,基于海光芯片高兼容性、生态应用丰富等特点,该方案具备易于集成的优势。无论是对于固定的安防监控系统,还是移动的智能设备,都可以实现轻松部署,因此在教育、安防、医疗、金融等行业均具有广泛的应用场景。比如,通过用高精度人脸识别系统构建安全校园,解决传统人力安保体系效率低、出错率高等问题。在机场、车站等人流密集的公共安防空间,方案可以在海量数据、高并发的场景中,实现更高效的人脸识别,提升智慧城市管理效率。生态赋能,助力产业链协同创新

“基于边缘云计算平台的AI智能识别应用“方案的脱颖而出,离不开光合组织解决方案大赛的鼎力支持。“光合方案大赛在行业内具有较强的影响力。大赛为我们提供了基于海光异构加速卡的物理机设备、异构算力资源、适配认证以及技术支撑,为模型的训练、推理提供可靠、稳定、高性能的加速能力,有效提升了图像分类及目标检测精度和准确率。”中国移动智慧家庭运营中心一位技术负责人表示。目前,第三届光合组织解决方案大赛已经开启,设置集智计划(人工智能)、桃李计划(教育信息化)、堡垒计划(安全技术应用)三大方向,并为获奖团队提供了1000万的资金与资源支持。光合组织期待与创新企业、机构共建开放、创新的信息技术产业生态!2. 腾讯健康公布医疗大模型 发布多场景AI产品矩阵

原文:http://science.china.com.cn/2023-09/11/content_42516411.htm9月8日,腾讯健康公布医疗大模型,全新发布智能问答、家庭医生助手、数智医疗影像平台等多场景AI产品矩阵,药物发现平台“云深”(iDrug)披露全新的蛋白质结构预测算法框架tFold。腾讯健康总裁吴文达指出,医疗健康的数智化升级已从“先行先试”,转变为“全面拥抱”,人工智能及各类数智化工具的应用将加速普及;腾讯将与合作伙伴共建“TRUST”模式,加强技术创新与数字基建,推动“数智医疗”普惠普及。

让大模型更懂医疗

腾讯杰出科学家、腾讯天衍实验室主任郑冶枫公布了医疗大模型的研发进程。腾讯全新发布的全链路自研混元大模型,拥有超千亿参数规模和超2万亿tokens预训练语料,具备强大的中文创作能力、复杂语境下的逻辑推理能力以及可靠的任务执行能力。以此为基座模型,持续加入涵盖285万医学实体、1250万医学关系,覆盖98%医学知识的医学知识图谱和医学文献,使大模型进一步掌握专业的医学知识。经过3000万覆盖患者、医生、药厂等场景及医疗流程的问答对话进行多任务微调,以及36万组专家医生标注数据的强化学习,让腾讯的医疗大模型在处理医疗需求时更专业、精准,同时也兼顾了患者关怀,更接近人类医生。 目前,腾讯医疗大模型包括文案生成、智能问答、病历结构化和检索、影像报告和辅助诊断等场景大模型,可嵌入医疗环节全流程,在科室导诊、医生推荐、预问诊、医患对话、病历自动生成和智能院务客服等应用场景中实现医疗服务水平和质量的全面提升。

目前,腾讯医疗大模型包括文案生成、智能问答、病历结构化和检索、影像报告和辅助诊断等场景大模型,可嵌入医疗环节全流程,在科室导诊、医生推荐、预问诊、医患对话、病历自动生成和智能院务客服等应用场景中实现医疗服务水平和质量的全面提升。就诊全流程智能升级

腾讯健康用户平台总经理吴志刚介绍,依托医学知识图谱及医疗大模型,AI导辅诊应用进行了全面升级,包括医学智能问答、数字人就医助手、智能自由问诊、病历自动生成、AI合理用药、智能化随访管理、患者全流程管理等应用,为医疗决策全流程提供更精准的辅助,助力患者就医体验以及临床医生、药剂师服务效率和质量的双向提升。诊前阶段的应用除了医学智能问答,还升级了数字人就医助手,能提供7*24h的智能客服及专业科普服务;诊中环节,基于大模型的能力学习百万级医患对话及3000多疾病推演解析,升级了模拟自由对话真实度更强的辅助问诊、更符合书写规范的病历自动生成以及能给出可解释性依据的辅助诊疗等应用;诊后阶段采用人工智能+互联网医疗的新型模式升级了智能化随访管理和患者全流程管理等应用。目前,上海仁济医院已经率先运用腾讯医疗大模型,以互联网医院适老化服务为重点,打造高度拟人化的虚拟数字形象“小威护士”,为老年患者提供更温暖、便捷的医疗服务。多场景推动AI应用普及

在AI驱动药物发现方面,腾讯“云深”(iDrug)平台已同时具备了小分子药物与大分子药物的加速发现能力。据腾讯AIDD技术负责人刘伟介绍,在蛋白质结构预测方面,“云深”(iDrug)平台开发了全新的算法框架tFold,其先进性多次获得国际的蛋白质结构预测评估平台证明;在药物的ADMET属性的预测方面已研发并上线70+个ADMET性质,并通过结合物理学特征和药企合作等数据训练证明能够超越主流软件;开发了两个骨架跃迁分子生成算法发现nM级先导化合物,并在3-4个项目中得到了有效证明,同时还引入了强化学习技术在药物小分子生成方面达成97%的生成分子满足要求。在助力基层服务能力提升方面,腾讯健康还发布了全新的家庭医生助手。腾讯健康战略及医疗产品总经理王倩怡指出,利用微信、企业微信打通医患的沟通渠道,以及医疗大模型的助力,将为医生提供更加智能的签约、咨询、随访、宣教能力。基于医疗大模型的能力,家庭医生助手能够化身“基层AI百事通”,为居民提供精细化的健康管理。在医学影像科研及应用方面,腾讯觅影全面升级了数智医疗影像平台,专注于数字医疗影像云端应用、科研及管理,同时搭载人工智能分析能力,提供产、学、研、管一体化医疗影像解决方案,为医疗机构、科研院校、科创企业提供医疗影像领域的全面支持。平台还将进一步开放20多个腾讯自研的AI引擎,助力科研机构AI模型自主研发及训练。构建数智医疗的“TRUST”模式

目前,腾讯健康小程序已连接超3000家可挂号公立医院、超5000家体检机构,以及超200个城市的疫苗服务;医保电子凭证覆盖超80万家两定机构及超20000家医院;微信渠道的电子健康卡用户超6亿,接入5000多家医院。腾讯健康进一步加强用户与医疗服务的连接效用。腾讯健康总裁吴文达指出,在技术创新上,腾讯健康持续投入医疗AI相关技术研究,累计专利1000多件,并加速转化前沿技术应用到医疗场景;同时,腾讯在算力供给、数据存储、安全防护等数字基础设施方面的积累,将为医疗行业提供可靠的底层保障;此外,借助微信、腾讯会议等广泛的用户能力,人工智能应用可以广泛助力医疗普惠;为此,腾讯健康将进一步推动自身能力、技术和产品开放,与行业共建规范一致的数字医疗标准,打造可复制的创新标杆。3. 人工智能爆火导致用水量飙升:问ChatGPT 50个问题,耗水500毫升

原文:https://new.qq.com/rain/a/20230911A00Z0E00联合国环境规划署曾发布报告称,世界上约三分之二的人口每年至少经历1个月的严重缺水。到2030年,情况预计将更加恶化,世界上近半人口将面临严重的水资源短缺。除了农业和工业用水增长外,人工智能热潮导致的用水量也在飙升,而科技巨头们正因此变得更“饥渴”。 到目前为止,研究人员和开发人员主要关注减少人工智能模型的碳足迹,而经常忽视它们的水足迹。在数据中心培训和部署人工智能模型需要消耗大量的水。举例来说,在微软最先进的美国数据中心培训GPT-3可能直接消耗70万升清洁淡水,这些淡水可用于生产370辆宝马汽车或320辆特斯拉电动汽车。此外,ChatGPT每次涉及20到50个问题的简单对话中,消耗的水量约为500毫升。这乍看起来不算多,但考虑到这款聊天机器人有超过1亿的活跃用户,每个人都参与了多个对话,其用水量相当惊人。不仅仅是微软和OpenAI,在用水量方面,谷歌更是大户。2021年,仅其在美国的数据中心就将消耗127亿升淡水用于冷却,其中约90%都是可饮用水。总体而言,2014年美国数据中心的总用水量估计高达6260亿升。值得称赞的是,大型科技公司都在采取措施来帮助解决这个问题。其中,亚马逊、Meta、谷歌和微软等科技巨头,都承诺到2030年变得“积极用水”,这意味着他们补充的水将超过他们消耗的水。

01 与ChatGPT每次交互耗水500毫升

构建像ChatGPT这类人工智能产品的成本可能很难衡量,其中包括用水成本。训练和部署OpenAI的技术需要大量的水,该公司需要从爱荷华州中部的浣熊河(Raccoon)和得梅因河(Des Moines)的交汇处抽水,为强大的超级计算机降温。这台超算正帮助OpenAI的人工智能系统学习如何模仿人类书写。随着微软、OpenAI和谷歌等领先的科技开发商竞相利用生成式人工智能的热潮,他们都承认,对其人工智能工具日益增长的需求带来了高昂的成本,从订购昂贵的半导体到用水量激增都在推动成本上涨。 但这些科技公司通常对细节守口如瓶。在爱荷华州,很少有人知道该州是OpenAI最先进大语言模型GPT-4的诞生地,直到一位微软高管在一次演讲中说漏了嘴,它“实际上是在得梅因以西的玉米地旁边构建的”。构建大语言模型需要分析大量人类书写文本的模式,所有这些计算都需要大量的电力,并会产生大量的热量。为了在炎热的天气里保持凉爽,数据中心需要抽入大量的水,通常需要降水送入仓库大小、位于建筑外的冷却塔中。任何在公司服务器机房待过的人都知道,你需要先带上毛衣。服务器机房要时刻保持凉爽,温度通常在10摄氏度左右,以防止设备出现故障。保持这一理想温度是一个持续的挑战,因为服务器本身会将电能转化为热量。而冷却塔通常被用来消耗热量,并通过蒸发冷水来保持房间的理想温度。冷却塔可以完成这项工作,但它们需要大量的水。研究人员估计,数据中心平均每千瓦时消耗大约一加仑的水。也不是任何类型的水都可以使用。数据中心使用清洁的淡水来源,以避免海水可能带来的腐蚀或细菌生长。淡水对于控制房间内的湿度也是必不可少的。此外,数据中心也需要大量由水力发电的能源支持,科学家们将这种情况称为“非现场间接用水量”。加州大学河滨分校的研究员任少雷一直在试图计算ChatGPT等生成式人工智能产品对环境的影响。在一篇将于今年晚些时候发表的论文中,任少雷的团队估计,每次你问ChatGPT 5到50个提示或问题时,它就会消耗500毫升的水。当然,其用水量取决于服务器所在的位置和季节。这一估计包括了这些公司没有测量的间接用水,比如为数据中心供电的发电厂降温用水。“大多数人都没有意识到ChatGPT背后的资源消耗情况,”任说。“如果你不知道资源的使用情况,那么我们就无法帮助保护资源。”OpenAI在其声明中回应了这些评论,称该公司正在“充分考虑”如何最好地利用计算能力。“我们认识到,培训大型模型可能是能源和水密集型的,为此会努力提高效率,”该公司表示。02 微软因训练和部署AI用水量飙升34%

微软在其最新的环境报告中披露,从2021年到2022年,该公司全球用水量飙升了34%(达到近17亿加仑,或超过2500个奥运会游泳池储水量)。与外部研究人员对微软人工智能研究相关用水情况相比,这一数字有了大幅增长。 在就用水问题做出回应时,微软在一份声明中表示,它正在投资研究,以衡量人工智能的能源和碳足迹,“同时努力使大语言模型系统在培训和应用方面更有效率”。

在就用水问题做出回应时,微软在一份声明中表示,它正在投资研究,以衡量人工智能的能源和碳足迹,“同时努力使大语言模型系统在培训和应用方面更有效率”。 该公司的声明称:“我们将继续监测我们的排放,加快进度,同时增加使用清洁能源为数据中心供电,购买可再生能源,并通过其他努力实现我们的可持续发展目标,即到2030年实现负碳、水正和零浪费。”微软于2019年对总部位于旧金山的OpenAI进行了第一笔10亿美元的投资。两年多后,这家初创公司推出了ChatGPT,并引发了全球对人工智能进步的关注。作为投资协议的一部分,微软将为OpenAI提供训练人工智能模型所需的计算能力。为了至少完成其中的一部分工作,两家公司把目光投向了爱荷华州的西得梅因,这是个拥有6.8万人口的城市。十多年来,微软一直在那里建设数据中心,以为其云计算服务提供支持。微软在当地建设的第四和第五个数据中心将于今年晚些时候投入使用。微软开始在西得梅因投资时担任市长的史蒂夫·盖尔(Steve Gaer)说:“他们(微软)正在以最快的速度建造这些设施。”他表示,该公司被西得梅因致力于建设公共基础设施的承诺所吸引,并通过纳税为支持这项投资贡献了一笔“惊人”的资金。

该公司的声明称:“我们将继续监测我们的排放,加快进度,同时增加使用清洁能源为数据中心供电,购买可再生能源,并通过其他努力实现我们的可持续发展目标,即到2030年实现负碳、水正和零浪费。”微软于2019年对总部位于旧金山的OpenAI进行了第一笔10亿美元的投资。两年多后,这家初创公司推出了ChatGPT,并引发了全球对人工智能进步的关注。作为投资协议的一部分,微软将为OpenAI提供训练人工智能模型所需的计算能力。为了至少完成其中的一部分工作,两家公司把目光投向了爱荷华州的西得梅因,这是个拥有6.8万人口的城市。十多年来,微软一直在那里建设数据中心,以为其云计算服务提供支持。微软在当地建设的第四和第五个数据中心将于今年晚些时候投入使用。微软开始在西得梅因投资时担任市长的史蒂夫·盖尔(Steve Gaer)说:“他们(微软)正在以最快的速度建造这些设施。”他表示,该公司被西得梅因致力于建设公共基础设施的承诺所吸引,并通过纳税为支持这项投资贡献了一笔“惊人”的资金。 微软在2020年首次表示,它正在为OpenAI开发世界上最强大的超级计算机之一,当时拒绝向媒体透露其部署的位置,但将其描述为“单一系统”,拥有超过28.5万个传统半导体核心和1万个图形处理器,后者是对人工智能工作负载至关重要的芯片。专家们表示,由于需要在计算核心之间传输大量数据,在单个地点对人工智能模型进行预训练至关重要。直到5月下旬,微软总裁布拉德·史密斯(Brad Smith)才透露,该公司已经在爱荷华州建立了“先进的人工智能超级计算数据中心”,专门让OpenAI能够训练其第四代模型GPT-4。这种模型现在支持高级版本的ChatGPT和微软自己的诸多产品,并加速了一场关于遏制人工智能社会风险的辩论。史密斯说:“这个数据中心是由加州工程师设计的,但它实际上是在爱荷华州建造的。”在某些方面,西得梅因是训练强大人工智能系统相对高效的地方,特别是与微软在亚利桑那州的数据中心相比,后者为同样的计算需求消耗的水要多得多。“因此,如果你在微软内部开发人工智能模型,那么你应该把模型的培训安排在爱荷华州,而不是亚利桑那州,”任少雷说。“在训练方面,这两个地方没有什么区别。但在用水和能源小号方面,两者有很大的不同。”在一年中的大部分时间里,爱荷华州的天气足够凉爽,以至于微软可以使用外部空气来保持超级计算机的正常运行,并将热量排出大楼。该公司在一份公开披露的文件中表示,只有当温度超过29.3摄氏度时,它才会利用水来降温。即便如此,微软可能仍然需要使用大量的水,特别是在夏天。根据西得梅因水厂的数据,2022年7月,也就是OpenAI表示完成GPT-4培训的前一个月,微软向其爱荷华州的数据中心群注入了约1150万加仑的水。这相当于该地区总用水量的6%左右,该水厂也为当地居民提供饮用水。2022年,西得梅因水厂的一份文件称,该公司和市政府只会考虑微软未来的特定数据中心项目,前提是这些项目能够“展示并实施技术,大幅降低当前水平的高峰用水量”,以保护住宅和其他商业用户的供水。微软表示,该公司正在直接与自来水厂合作,以解决反馈意见。自来水厂在一份书面声明中表示,微软始终是一个很好的合作伙伴,一直在与当地官员合作,在满足其需求的同时减少水足迹。

微软在2020年首次表示,它正在为OpenAI开发世界上最强大的超级计算机之一,当时拒绝向媒体透露其部署的位置,但将其描述为“单一系统”,拥有超过28.5万个传统半导体核心和1万个图形处理器,后者是对人工智能工作负载至关重要的芯片。专家们表示,由于需要在计算核心之间传输大量数据,在单个地点对人工智能模型进行预训练至关重要。直到5月下旬,微软总裁布拉德·史密斯(Brad Smith)才透露,该公司已经在爱荷华州建立了“先进的人工智能超级计算数据中心”,专门让OpenAI能够训练其第四代模型GPT-4。这种模型现在支持高级版本的ChatGPT和微软自己的诸多产品,并加速了一场关于遏制人工智能社会风险的辩论。史密斯说:“这个数据中心是由加州工程师设计的,但它实际上是在爱荷华州建造的。”在某些方面,西得梅因是训练强大人工智能系统相对高效的地方,特别是与微软在亚利桑那州的数据中心相比,后者为同样的计算需求消耗的水要多得多。“因此,如果你在微软内部开发人工智能模型,那么你应该把模型的培训安排在爱荷华州,而不是亚利桑那州,”任少雷说。“在训练方面,这两个地方没有什么区别。但在用水和能源小号方面,两者有很大的不同。”在一年中的大部分时间里,爱荷华州的天气足够凉爽,以至于微软可以使用外部空气来保持超级计算机的正常运行,并将热量排出大楼。该公司在一份公开披露的文件中表示,只有当温度超过29.3摄氏度时,它才会利用水来降温。即便如此,微软可能仍然需要使用大量的水,特别是在夏天。根据西得梅因水厂的数据,2022年7月,也就是OpenAI表示完成GPT-4培训的前一个月,微软向其爱荷华州的数据中心群注入了约1150万加仑的水。这相当于该地区总用水量的6%左右,该水厂也为当地居民提供饮用水。2022年,西得梅因水厂的一份文件称,该公司和市政府只会考虑微软未来的特定数据中心项目,前提是这些项目能够“展示并实施技术,大幅降低当前水平的高峰用水量”,以保护住宅和其他商业用户的供水。微软表示,该公司正在直接与自来水厂合作,以解决反馈意见。自来水厂在一份书面声明中表示,微软始终是一个很好的合作伙伴,一直在与当地官员合作,在满足其需求的同时减少水足迹。03 谷歌用水量飙升20%,AI竞赛让情况变得更糟

谷歌于7月份发布的2023年环境报告显示,该公司的用水量飙升20%,这在很大程度上也归功于其人工智能工作。这家互联网巨头表示,其2022年消耗了56亿加仑的水,相当于37个高尔夫球场的用水量,其中52亿加仑用于支持其庞大的数据中心运营,比上一年增加了20%。谷歌的用水量上涨幅度并不一致:在俄勒冈州,其用水量很稳定,因为它吸引了公众的注意;而在拉斯维加斯以外,它的用水量翻了一番。在爱荷华州,谷歌同样很饥渴,其Council Bluffs数据中心用水量比其他任何地方都多。谷歌的报告详细介绍了保持大型数据中心运行所需要的环境成本,这些数据中心通常需要大量的水才能保持凉爽。数据显示,随着谷歌和人工智能竞赛中的所有其他科技公司加快建设新的数据中心,它们的用水量很可能会继续上升。2019年,谷歌仅在三个州就为数据中心申请了超过23亿加仑的水。该公司目前在北美拥有14个数据中心,用于支持其产品套件Google Search,以及最近推出的Lamda和Bard等大语言模型。数据显示,仅Lamda就可能需要数百万升水来进行培训,比GPT-3还要多,因为谷歌的几个干渴的数据中心都位于得克萨斯州等炎热的州。

加州大学河滨分校电气与计算机工程系副教授任少雷指出,谷歌用水量增加20%几乎与其计算能力的增长同时发生,而谷歌的计算能力在很大程度上是由人工智能推动的。然而,任少雷表示,他对这种增长能否长期持续持怀疑态度,即使谷歌承诺补充水资源以抵消其使用量。他说:“这只是让他们的水务账目看起来更好,但水仍然被大量消耗。”谷歌表示,2030年是其办公室和数据中心补充120%淡水的最后期限。根据它自己的报告,目前它只补充了6%的淡水。谷歌目前消耗的大部分水都是“可饮用的”,足够干净,可以用作饮用水。谷歌在最新报告中指出,该公司已经考虑到缓解“当地的水资源压力”(水资源短缺的另一种方法),并表示到 2022 年,其淡水抽取量的 82% 将来自水资源相对丰富的地区。对于剩下的18%,谷歌称其正在探索新的合作伙伴和机会来改善用水情况,但随着更多的地方面临水资源短缺,它可能会面临越来越大的阻力。2019年,谷歌计划在亚利桑那州梅萨建立一个数据中心,保证每天最多供水400万加仑。但正如媒体最近指出的那样,亚利桑那州已经面临水资源短缺困扰,这可能会阻止其批准谷歌类似的交易。事实上,谷歌的一位发言人表示,一旦数据中心建成,那里将使用“风冷技术”。这表明谷歌正在努力寻找更可持续的用水策略,以应对不断增长的用水需求。04 Meta新AI模型用水总量惊人微软和谷歌并不是唯一感到越来越饥渴的公司。Facebook母公司Meta也在亚利桑那州建设一个数据中心,2022年用水量超过260万立方米(约合6.97亿加仑),主要用于冷却数据中心。此外,Meta最新的大语言模型Llama 2,也需要大量的水来训练。

今年7月份,Meta发布了名为Llama 2的大型新人工智能模型。科技行业的人都感到很兴奋,除了任少雷,他对训练这些大语言模型需要消耗的水量感到担心。任少雷估计,训练Llama 2需要的用水总量高达1090万升,如果不包括水力发电,则为280万升。普通人平均每天要喝大约3升水。Meta没有透露它用了多少水来训练这个人工智能模型。不过,该公司确实披露了耗电量。任少雷以此为基础,研究了Meta数据中心在使用能源和水方面的效率。他说,Llama 2几乎是Meta今年早些时候推出的上一款大型人工智能模型Llama 1的水足迹的两倍。数据中心已经消耗了大量的能源,人工智能的蓬勃发展预计将大幅增加这种消耗。任少雷表示:“如果用电量增加,碳足迹和水足迹等其他东西也会随之增加。” Meta发言人没有就任少雷的估算进行置评。Meta的数据中心在2021年使用了超过500万立方米的水,大约相当于13.3亿加仑。该公司尚未分享2022年的数据。到今年年底或者明年,Meta将在亚利桑那州建成并扩建一个数据中心,其用水量将继续攀升。

加州大学河滨分校电气与计算机工程系副教授任少雷指出,谷歌用水量增加20%几乎与其计算能力的增长同时发生,而谷歌的计算能力在很大程度上是由人工智能推动的。然而,任少雷表示,他对这种增长能否长期持续持怀疑态度,即使谷歌承诺补充水资源以抵消其使用量。他说:“这只是让他们的水务账目看起来更好,但水仍然被大量消耗。”谷歌表示,2030年是其办公室和数据中心补充120%淡水的最后期限。根据它自己的报告,目前它只补充了6%的淡水。谷歌目前消耗的大部分水都是“可饮用的”,足够干净,可以用作饮用水。谷歌在最新报告中指出,该公司已经考虑到缓解“当地的水资源压力”(水资源短缺的另一种方法),并表示到 2022 年,其淡水抽取量的 82% 将来自水资源相对丰富的地区。对于剩下的18%,谷歌称其正在探索新的合作伙伴和机会来改善用水情况,但随着更多的地方面临水资源短缺,它可能会面临越来越大的阻力。2019年,谷歌计划在亚利桑那州梅萨建立一个数据中心,保证每天最多供水400万加仑。但正如媒体最近指出的那样,亚利桑那州已经面临水资源短缺困扰,这可能会阻止其批准谷歌类似的交易。事实上,谷歌的一位发言人表示,一旦数据中心建成,那里将使用“风冷技术”。这表明谷歌正在努力寻找更可持续的用水策略,以应对不断增长的用水需求。04 Meta新AI模型用水总量惊人微软和谷歌并不是唯一感到越来越饥渴的公司。Facebook母公司Meta也在亚利桑那州建设一个数据中心,2022年用水量超过260万立方米(约合6.97亿加仑),主要用于冷却数据中心。此外,Meta最新的大语言模型Llama 2,也需要大量的水来训练。

今年7月份,Meta发布了名为Llama 2的大型新人工智能模型。科技行业的人都感到很兴奋,除了任少雷,他对训练这些大语言模型需要消耗的水量感到担心。任少雷估计,训练Llama 2需要的用水总量高达1090万升,如果不包括水力发电,则为280万升。普通人平均每天要喝大约3升水。Meta没有透露它用了多少水来训练这个人工智能模型。不过,该公司确实披露了耗电量。任少雷以此为基础,研究了Meta数据中心在使用能源和水方面的效率。他说,Llama 2几乎是Meta今年早些时候推出的上一款大型人工智能模型Llama 1的水足迹的两倍。数据中心已经消耗了大量的能源,人工智能的蓬勃发展预计将大幅增加这种消耗。任少雷表示:“如果用电量增加,碳足迹和水足迹等其他东西也会随之增加。” Meta发言人没有就任少雷的估算进行置评。Meta的数据中心在2021年使用了超过500万立方米的水,大约相当于13.3亿加仑。该公司尚未分享2022年的数据。到今年年底或者明年,Meta将在亚利桑那州建成并扩建一个数据中心,其用水量将继续攀升。4. Nvidia发布TensorRT-LLM开源软件 提升高端GPU芯片上的AI模型性能

原文:https://new.qq.com/rain/a/20230911A075ZW00Nvidia近日宣布推出一款名为TensorRT-LLM的新开源软件套件,扩展了Nvidia GPU上大型语言模型优化的功能,并突破了部署之后人工智能推理性能的极限。

生成式AI大语言模型因其令人印象深刻的功能而变得流行,而且扩大了人工智能的可能性,被广泛应用于众多行业,让用户能够通过聊天机器人“与数据对话”、总结大型文档、编写软件代码、以及发现理解信息的新方法。Nvidia公司超大规模和高性能计算副总裁Ian Buck表示:“大型语言模型推理变得越来越难。模型的复杂性不断增加,模型变得越来越智能,也变得越来越大,这是很自然的,但当模型扩展到单个GPU之外并且必须在多个GPU上运行的时候,就成了一大难题。”在人工智能方面,推理是模型处理那些前所未见的新数据的一个过程,例如用于总结、生成代码、提供建议或者回答问题,是大型语言模型的主力。随着模型生态系统的迅速扩展,模型也变得越来越大,功能越来越多,这也意味着模型变得如此之大以至于无法同时运行在单个GPU上,而必须将其分开。开发人员和工程师必须手动将工作负载分开或分段,协调执行,以便实时获得响应。TensorRT-LLM就是通过“张量并行性”帮助解决这个问题的,允许跨多个GPU进行大规模的高效推理。除此之外,由于当今市场中有各种各样的大型语言模型,所以Nvidia针对目前主流的大型语言模型对核心进行了优化。该软件套件包括了完全优化的、可立即运行的大型语言模型版本,包括Meta Platform的Llama 2、OpenAI的GPT-2和GPT-3、Falcon、MosaicMPT和BLOOM。

生成式AI大语言模型因其令人印象深刻的功能而变得流行,而且扩大了人工智能的可能性,被广泛应用于众多行业,让用户能够通过聊天机器人“与数据对话”、总结大型文档、编写软件代码、以及发现理解信息的新方法。Nvidia公司超大规模和高性能计算副总裁Ian Buck表示:“大型语言模型推理变得越来越难。模型的复杂性不断增加,模型变得越来越智能,也变得越来越大,这是很自然的,但当模型扩展到单个GPU之外并且必须在多个GPU上运行的时候,就成了一大难题。”在人工智能方面,推理是模型处理那些前所未见的新数据的一个过程,例如用于总结、生成代码、提供建议或者回答问题,是大型语言模型的主力。随着模型生态系统的迅速扩展,模型也变得越来越大,功能越来越多,这也意味着模型变得如此之大以至于无法同时运行在单个GPU上,而必须将其分开。开发人员和工程师必须手动将工作负载分开或分段,协调执行,以便实时获得响应。TensorRT-LLM就是通过“张量并行性”帮助解决这个问题的,允许跨多个GPU进行大规模的高效推理。除此之外,由于当今市场中有各种各样的大型语言模型,所以Nvidia针对目前主流的大型语言模型对核心进行了优化。该软件套件包括了完全优化的、可立即运行的大型语言模型版本,包括Meta Platform的Llama 2、OpenAI的GPT-2和GPT-3、Falcon、MosaicMPT和BLOOM。应对动态工作负载的“运行中批处理”机制

由于大型语言模型本身的性质,模型的工作负载可能是高度动态的,工作负载的需求和任务使用情况也可能会随着时间的推移而发生变化,单个模型可以同时用作聊天机器人来提问和回答,也可以用于总结大型文档和简短文档。因此,输出大小可能会出现完全不同的数量级。为了应对这些不同的工作负载,TensorRT-LLM引入了一种称为“运行中批处理”的机制,这是一个优化调度的过程,把文本生成过程分解为多个片段,以便可以将移入或者移出GPU,这样在开始新一批之前就不需要完成整批工作负载了。以前,如果有大型请求的话,例如对非常大的文档进行摘要提取,那么后面所有的内容都必须等待该过程完成才能使队列继续前进。Nvidia一直在与众多厂商合作优化TensorRT-LLM,包括Meta、Cohere、Grammarly、Databricks和Tabnine。在他们的帮助下,Nvidia不断简化软件套件中的功能和工具集,包括开源Python应用用户界面,用于定义和优化新架构以定制大型语言模型。例如,MosaicML在将TensorRT-LLM与其现有软件堆栈集成时在TensorRT-LLM之上添加额外的功能。Databricks公司工程副总裁Naveen Rao表示,这是一个简单的过程。“TensorRT-LLM易于使用,功能丰富,包括令牌流、动态批处理、分页注意力、量化等,而且效率很高,为使用 NVIDIA GPU的大型语言模型服务提供了最佳性能,并使我们能够将节省的成本回馈给我们的客户。”Nvidia称,TensorRT-LLM及其带来的好处(包括运行中批处理功能)可以让使用Nvidia H100提取文章摘要的推理性能提高1倍多。在使用GPT-J-6B模型进行对CNN/每日邮报文章摘要的A100测试中,仅H100就要比A100快4倍,启用TensorRT-LLM优化后,速度快了8倍。TensorRT-LLM为开发人员和工程师提供了深度学习编译器、优化的大型语言模型内核、预处理和后处理、多GPU/多节点通信功能、以及简单的开源API,使他们能够快速优化和执行大型语言模型生产的推理。随着大型语言模型继续重塑数据中心,企业需要更高的性能就意味着开发人员比以往任何时候都更需要能够为他们提供具备功能和访问权限的工具,以提供更高性能的结果。TensorRT-LLM软件套件现已可供Nvidia开发人员计划中的开发人员抢先体验,并将于下个月集成到用于生产型AI端到端软件平台Nvidia AI Enterprise的NeMo框架中。5. 魔法打败魔法,AI数据需要AI解决方案

原文:https://new.qq.com/rain/a/20230914A07W7X00根据Kompprise委托进行的“非结构化数据管理状况”调查 显示,人工智能正成为IT和商业领袖面临的主要数据管理挑战。研究显示,公司在很大程度上允许员工使用生成型人工智能,但三分之二(66%)的公司担心它可能带来的数据治理风险,包括隐私、安全以及供应商解决方案中缺乏数据源透明度。这项由数据管理供应商Kompprise委托进行的“非结构化数据管理状况”调查收集了美国和英国拥有1000多名员工的公司的300名企业存储IT和业务决策者的回复。虽然只有10%的组织不允许员工使用生成人工智能,但大多数组织担心不道德、有偏见或不准确的输出,以及公司数据泄露到供应商的人工智能系统中。为了应对这些挑战,同时也从人工智能中寻找竞争优势,研究发现,40%的领导者正在采取多管齐下的方法来降低人工智能中非结构化数据的风险,包括存储、数据管理和安全工具,以及使用内部工作组来监督人工智能的使用。领导者面临的最大非结构化数据管理挑战是“在不干扰用户和应用程序的情况下移动数据”(47%),但紧随其后的是“为人工智能和云服务做准备”(46%)。“生成式人工智能对数据治理和保护提出了新的问题,” NAND Research首席分析师Steve McDowell表示,“研究显示,IT领导者正在努力在快速推出生成式人工智能解决方案的同时,负责平衡企业数据的保护,但这是一个困难的挑战,需要采用智能工具。”“IT领导者正在将重点转移到利用生成性人工智能解决方案上,但他们希望在这样做时有所限制, ” Kompprise首席执行官Kumar Goswami补充道,“人工智能的数据治理需要正确的数据管理策略,包括跨数据存储孤岛的可见性、数据来源的透明度、高性能的数据移动性和安全的数据访问。”

6. 俄IT巨头Yandex开发GPT大模型,称与ChatGPT抗衡“只是时间问题”

原文:https://www.163.com/dy/article/IE9Q30M00511B8LM.html俄媒 Russia Today 当地时间 9 日报道,当地科技巨头 Yandex 在采访中表示,该公司开发的 YandexGPT 相比于美国竞争对手 OpenAI 开发的 ChatGPT 而言,具有更大的前途。 andex 的搜索和广告技术业务部主管 Dmitry Masyuk 表示,YandexGPT 在生成俄语内容时的表现已经能够“稳步超越”ChatGPT 3.5 版本,甚至在许多情况下提供了优于 ChatGPT 4.0 的回答,更表示 YandexGPT 与其美国对手抗衡将“只是时间问题”。而跟 Meta 公司开发的 Llama-2-7b 相比,YandexGPT 也能够生成“更好的回答”,包括生成英语内容的情况。Dmitry Masyuk 也称,公司正在不断评估其生成式 AI 与 ChatGPT 的技术进展情况。很难对这两个系统进行比较,它们可能各有所长。比如说,一个能够解决物理学问题、撰写童话故事、给 CEO 写信的神经网络在某些方面做得更好,而在其他方面稍显逊色,那么总体来看,这个系统该说它“更好”,还是“更差”呢?IT之家注:Yandex 的大模型产品于今年 5 月首发亮相,包含聊天机器人、AI 助手,能够生成、重构或汇总基于文本内容的信息,并可解决其他业务有关问题。今年 9 月,该公司推出了这款大模型产品的升级版 ——YandexGPT 2,号称能够解决更多问题,用于更多场景,提供更加精确的答案。 ———————End——————— 点击阅读原文进入官网

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

RT-Thread

+关注

关注

31文章

1285浏览量

40094

原文标题:【AI简报20230915期】耗水量激增!AI竞赛变得更为困难,AI数据需要AI解决方案

文章出处:【微信号:RTThread,微信公众号:RTThread物联网操作系统】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

AI for Science:人工智能驱动科学创新》第4章-AI与生命科学读后感

的深入发展。

3. 挑战与机遇并存

尽管AI在生命科学领域取得了显著的成果,但也面临着诸多挑战。例如,数据隐私、算法偏见、伦理道德等问题都需要我们认真思考和解决。同时,如何更好地将AI

发表于 10-14 09:21

《AI for Science:人工智能驱动科学创新》第二章AI for Science的技术支撑学习心得

。

4. 物理与AI的融合

在阅读过程中,我对于物理与AI的融合有了更加深入的认识。AI for Science不仅依赖于数据,还需要结合物

发表于 10-14 09:16

平衡创新与伦理:AI时代的隐私保护和算法公平

,如果医生和患者都能了解AI推荐治疗方案的原因,将大大增加对技术的接受度和信任。

算法公平性的保障同样不可或缺。AI系统在设计时就需要考虑到多样性和包容性,避免因为训练

发表于 07-16 15:07

risc-v多核芯片在AI方面的应用

应用中的成本。

最后,RISC-V多核芯片不仅可以应用于AI边缘计算领域,还可以扩展到其他领域,如数据中心、云计算、自动驾驶、机器人等,为这些领域提供高效、灵活和安全的解决方案。

总的来说,RISC-V

发表于 04-28 09:20

开发者手机 AI - 目标识别 demo

。

NNRt host 实现了NNRt HDI接口功能,通过对接底层AI芯片接口为上层应用提供NPU硬件推理的能力。

功能实现

JS从相机数据流获取一张图片,调用Native的接口进行目标识别的处理

发表于 04-11 16:14

ai_reloc_network.h引入后,ai_datatypes_format.h和formats_list.h报错的原因?

当准备使用神经网络的relocatable方式,将ai_reloc_network.h头文件加入程序编译后,ai_datatypes_format.h在cubeIDE和Keilc里分别报如下错误

发表于 03-14 06:23

NanoEdge AI的技术原理、应用场景及优势

NanoEdge AI 是一种基于边缘计算的人工智能技术,旨在将人工智能算法应用于物联网(IoT)设备和传感器。这种技术的核心思想是将数据处理和分析从云端转移到设备本身,从而减少数据传输延迟、降低

发表于 03-12 08:09

【AI简报20230915期】耗水量激增!AI竞赛变得更为困难,AI数据需要AI解决方案

【AI简报20230915期】耗水量激增!AI竞赛变得更为困难,AI数据需要AI解决方案

评论