NEWS

9月22日,华为全联接大会2023期间,华为计算产品线总裁张熙伟发表《算力为基,共筑AI新生态》主题演讲,他表示:华为将深耕算力底座,聚焦鲲鹏、昇腾基础软硬件创新,携手伙伴与开发者,打造开放、易用平台,使能百模千态,共赢数智未来。

华为计算产品线总裁张熙伟

以下是演讲全文

尊敬的伙伴、开发者朋友们,大家上午好!

很高兴与大家再次相聚在华为全联接大会2023,分享计算产业的生态进展与规划,畅想AI时代。

人工智能正进入百模千态的大模型时代,对AI的生态发展提出了新的挑战。

一方面,大模型快速演进,融合算子、加速库更加丰富,需要更加开放的技术体系,让开发者更灵活的实现大模型创新。

另一方面,随着参数、数据快速增长,大模型的开发、调试、优化更复杂,业界需要更易用的全流程使能平台,加速大模型的开发与部署。

另外,大模型训练投入大,软硬件工程能力要求高,行业有更强的商业变现诉求。需要全产业链伙伴合理分工,高效协同,才能实现商业共赢。

过去四年,昇腾围绕软硬件协同、AI框架与工具链,持续夯实基础,发展技术与商业生态,支撑了全国20多个城市人工智能计算中心的建设,同时我们深入行业应用场景,服务金融、运营商、互联网等行业的智能化升级。

这一切都离不开每一位伙伴和开发者的共同努力,再次感谢大家一路同行,对昇腾的信赖与支持。

面向大模型时代,我们将持续聚焦伙伴与开发者的需求,全面升级昇腾基础软硬件,以开放、易用的平台使能百模千态;以高效协同的生态赋能千行万业。

01全面开放,灵活选择使能大模型创新

平台的开放和兼容一直是伙伴和开发者最为关心的问题。昇腾面向算子、框架、加速库和大模型全面开放,广泛支持、兼容业界生态,为大模型创新提供更多灵活选择。

首先,昇腾提供丰富的融合算子,如主流的FlashAttention、FFN等,可在昇腾上实现性能倍级提升;

其次,昇腾已全面支持PyTorch、飞桨、昇思等业界框架,同时PyTorch社区也在持续增强对昇腾的支持,今年10月社区将发布2.1版本,原生支持昇腾,欢迎大家下载使用。

在加速库与开发套件上,除了兼容业界主流的DeepSpeed、Megatron外,昇腾自主构建了大模型加速库AscendSpeed,提供丰富的大模型训练并行能力。同时,HuggingFace社区最新的Transformers、Accelerate等代码仓也已原生支持昇腾,开发者直接下载,安装即用。

模型层面上,目前已有50+主流的基础大模型基于昇腾训练迭代,昨天也有9家伙伴发布了大模型训推一体机,为行业提供更加丰富的选择。

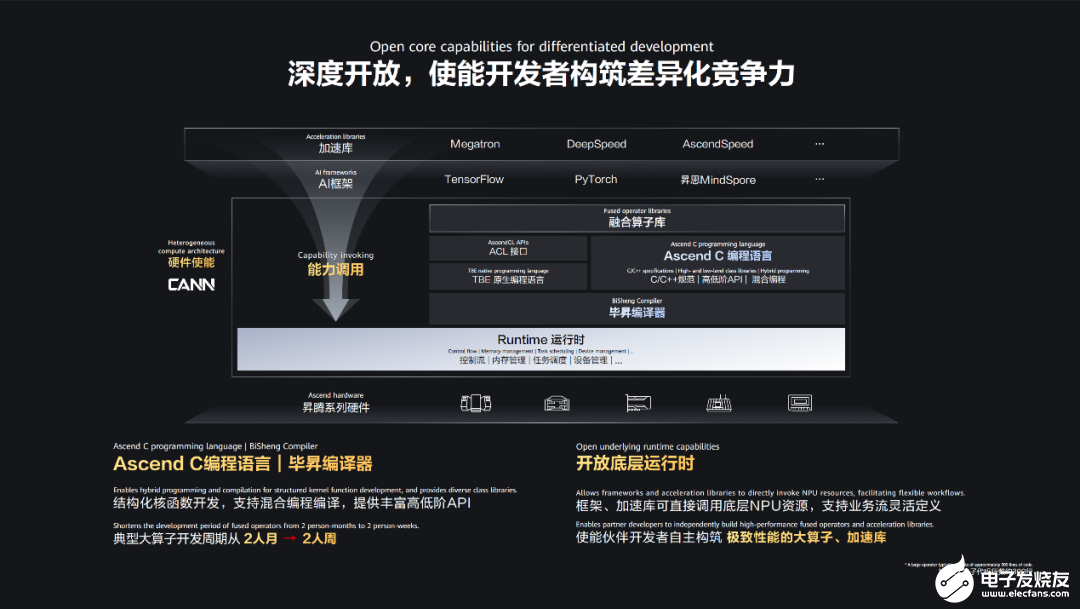

02深度开放,使能开发者构筑差异化竞争力

算子和加速库是决定大模型训练与推理性能的关键,为支撑开发者孵化出更高性能的自定义算子、加速库,我们新增开放底层运行时,开发者可直接使用NPU上的核资源、控制流、任务调度等接口,原生构建差异化竞争力,各类接口将于年底前陆续开放。

在编程上,今年5月发布的Ascend C编程语言,简化开发逻辑,匹配开发习惯。这半年来持续升级迭代,支持混合编程与编译,增加归一化、三角函数等API,300余行大算子的开发周期从最初的2人月降到现在的2人周,大幅提升大模型创新效率。

03ModelZoo2.0正式发布上线

为了更好的发育大模型生态,昇腾社区全新升级了原有的ModelZoo,在已提供数百个预训练模型的基础上,年底前将持续上线40多个昇腾亲和的预训练大模型,同时支持各类大模型在线的功能体验 与性能对比,开放全流程的大模型开发工具与套件,支撑开发者快速实现大模型的二次开发。今天,ModelZoo 2.0正式上线昇腾社区。

欢迎访问昇腾社区ModelZoo 2.0,也欢迎各位伙伴和开发者使用并反馈建议,共建大模型生态开源开放的新阵地。

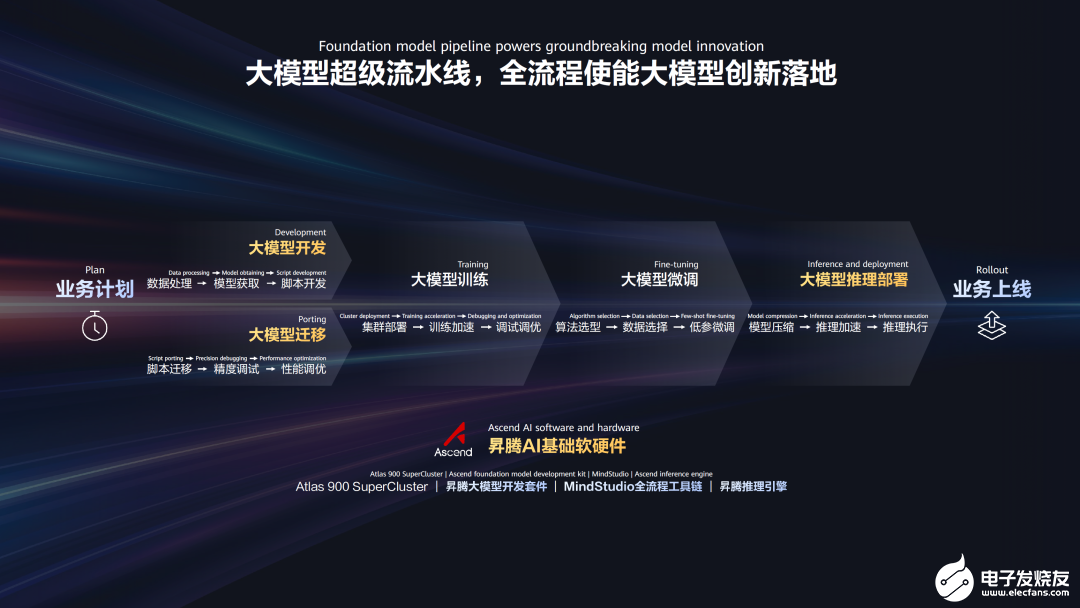

04大模型超级流水线,全流程使能大模型创新落地

大模型创新涉及多个阶段,是个复杂的系统工程,除了以昇腾的大算力来加速训练外,我们还提供了大模型超级流水线,以友好的大模型开发环境和统一的全流程工具链,加速大模型的开发、迁移与部署。

在脚本开发阶段,我们将经验沉淀成为大模型开发套件,覆盖业界主流的LLaMA、BLOOM、GLM等20多个开源大模型,并支持在PyTorch和昇思框架上使用。

针对开发套件已支持的大模型,通过调用高阶API,十几行代码即可构建出完整的大模型脚本。通过多种并行算法,几行代码即可实现复杂的多维混合并行。同时提供了丰富的低参微调模板,支持一键启动微调,并生成模型评估报告。

为了帮助大家将已有的大模型敏捷的迁移至昇腾上,我们提供了一站式工具链MindStudio。

首先,千亿大模型全量脚本的迁移,多数仅需两行代码,针对定制算子也只需轻量的代码修改;如迁移出现精度偏差,MindStudio还支持精度数据自动导出与溢出分析,周级实现精度优化。

其次,性能调优一直是最挑战的环节,随着BatchSize的增大,算力、内存和并行数据量随之增加,如何提升系统资源利用率尤为重要。为此,MindStudio提供集群性能数据分析与调优能力,如算子瓶颈分析、内存占用统计、慢卡通信定位和分布式策略优化等功能,大幅降低训练集群的调优难度。

推理部署是大模型落地的“最后一公里”,快速部署与高效执行是核心。

-

一方面,昇腾CANN的能力可开放给客户自有的推理引擎,帮助客户完成推理部署。

-

另一方面,我们也提供昇腾推理引擎,将模型压缩、推理加速和推理执行等能力,以统一API接口提供出来,方便伙伴开发推理应用。同时昇腾推理引擎支持多种推理执行方式,比如PyTorch、昇思的带框架推理、ONNX离线推理以及Triton的推理服务化。

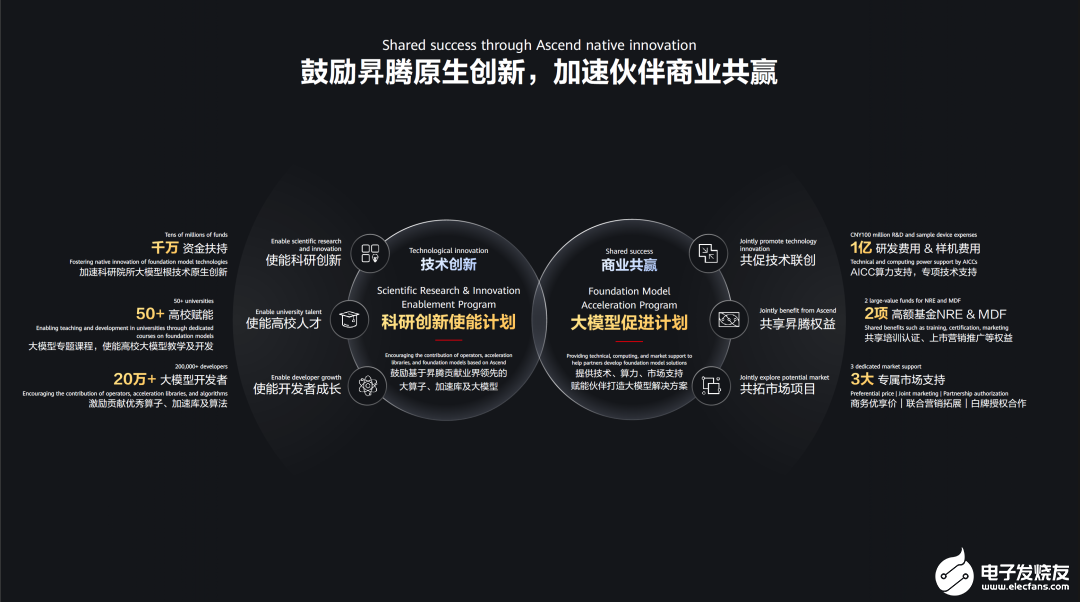

为共筑繁荣的大模型生态,实现伙伴商业共赢。昇腾围绕科研创新使能计划和大模型促进计划,鼓励开发者基于昇腾原生创新,打造更具竞争力的场景化解决方案。

技术创新上,我们将每年投入千万资金扶持科研院所,推出系列大模型课程赋能高校教学,围绕开发者成长路径,激发价值创新。

商业方面,我们将投入一亿资金支持大模型的技术联创,大模型伙伴可享受NRE和MDF两项权益,获得三大专属的市场支持。

技术赋能商业成功,商业牵引技术进步,双轮驱动,共同打造更加协同的人工智能新生态。

06以AI赋能openEuler更智能,以openEuler使能AI更高效

人工智能的飞速发展对操作系统也带来了深刻影响。

▌一方面,大模型让欧拉更智能。

面向终端用户,Windows 12结合AI为大家带来了无限期待,面向数字基础设施,欧拉作为首个广泛支持AI的开源操作系统,正在颠覆传统的命令行交互方式。我们使用ChatGLM基础模型,基于大量欧拉操作系统的代码和数据,训练出了EulerCopilot,初步实现代码辅助生成、问题智能分析、系统辅助运维等功能。以前需要多领域专家协同解决的问题,未来都可以交给EulerCopilot。

▌另一方面,欧拉使能AI更高效。

欧拉通过异构资源统一管理与调度,实现CPU和XPU的深度融合,以更全局、更均衡和更精细化的视角统筹内存和算力,充分挖掘空闲资源,提升有效利用率,进而提升AI训练和推理性能。这些功能都会持续贡献社区,并合入23.09与24.03LTS版本发布。

未来欧拉将携手伙伴、社区开发者,面向快速发展的行业需求,集成更多AI能力,高效统筹异构算力,致力于将欧拉打造成为全球领先的开源操作系统。

智能化的加速发展需要坚实的数字化底座,数字化的深度决定智能化的高度,过去几年鲲鹏积极构建开放的软硬件平台,深耕行业数字化。

07鲲鹏全栈升级,使能伙伴更卓越,加速千行万业智能化

为了更好的赋能伙伴,服务客户,我们持续升级鲲鹏软硬件平台。

昨天,我们发布了天池架构,支持伙伴面向千行万业,快速推出差异化机型。

基础软件方面,openEuler全场景协同能力持续增强,进一步提供负载动态感知等关键能力,做到开箱即优。

同时,我们还升级了鲲鹏BoostKit和DevKit 2大套件,八大主流场景性能持续提升,通过四大场景化SDK助力鲲鹏高效原生开发。

人才是产业发展的根基,高校是人才培养的摇篮。3年前,华为联合教育部启动了智能基座项目,通过与72所高校的共同努力,积累了大量的鲲鹏、昇腾教学经验与资源。在高校人才峰会上,智能基座项目将升级走向2.0,持续深化产教融合与科教融合。

高校学生是产业的未来,而开发者则代表了产业当下,我们将依托 “鲲鹏、昇腾”两大社区,围绕 “众智和开发者成长”两大计划,通过 “创新大赛与创享日”两大活动,持续培育开发者,让开发者成为计算产业发展的中坚力量。

大模型带来新生态,大时代迎来新机遇。让我们携手奋进,众智合力,以算力为基,构筑开放、易用、协同的新生态,共创美好的数智新未来!

原文标题:算力为基,共筑AI新生态

文章出处:【微信公众号:华为】欢迎添加关注!文章转载请注明出处。

-

华为

+关注

关注

216文章

34481浏览量

252226

原文标题:算力为基,共筑AI新生态

文章出处:【微信号:huaweicorp,微信公众号:华为】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

算力为基,共筑AI新生态

算力为基,共筑AI新生态

评论