摘要

传感器融合对于自动驾驶和自主机器人是至关重要,毫米波雷达-相机融合系统由于其互补的传感能力而广受欢迎。然而,这两个传感器之间的精确校准对于确保有效融合和提高整体系统性能更为重要。两者之间的校准包括内参校准和外参校准,后者对于实现精确的传感器融合尤为重要。

不幸的是,许多基于目标的校准方法需要复杂的操作程序和精心设计的实验条件,这给研究人员带来了挑战。为了解决这个问题,本文引入了一种新的方法,该方法利用深度学习从原始毫米波雷达数据(即距离-多普勒角数据)和相机图像中提取共同特征。我们的方法不是显式地表示这些共同特征,而是隐式地利用这些共同特征来匹配来自两个数据源的相同对象,具体来说,提取的共同特征作为一个例子,展示了毫米波雷达和相机系统之间的在线无目标校准方法。通过这种基于特征的方法实现了对外参变换矩阵的估计,为了提高校准的准确性和稳健性,应用了RANSAC和Levenberg-Marquardt(LM)非线性优化算法来推导矩阵,在真实环境的实验证明了提出的方法的有效性和准确性。

主要贡献

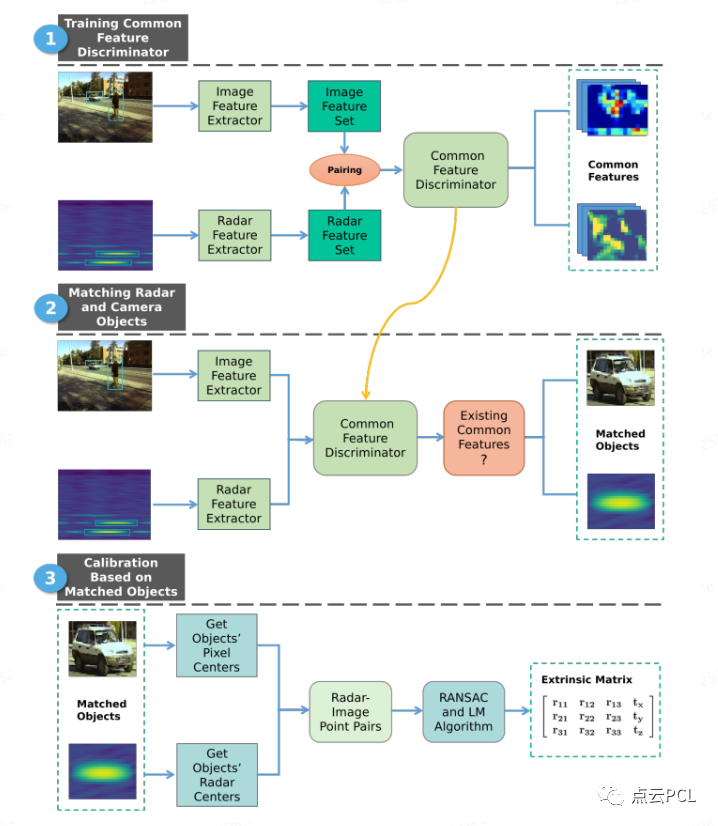

毫米波雷达和摄像头是互补的传感方式,广泛用于自动驾驶和机器人等应用。无论照明和天气条件如何,毫米波雷达都能提供准确的距离、速度和角度信息,而相机则能捕捉高分辨率的视觉信息。毫米波雷达和相机的结合提高了感知能力,并可在动态环境中执行物体识别、检测和跟踪等任务。毫米波雷达和相机之间的校准对于传感器融合至关重要,因为它们的传感原理不同,尤其是对于确定它们的相对姿态。一种很有前途的方法是使用深度学习从原始毫米波雷达数据中提取有用的特征,并探索雷达和图像特征之间的关系,以估计外部变换矩阵,如图1所示:

图1:所提出的毫米波雷达相机在线外参校准方法的框架。该方案展示了校准毫米波雷达和摄像头传感器所涉及的顺序步骤。该方法首先训练深度学习共同特征鉴别器,以确定毫米波雷达和相机数据中检测到的对象是否共享共同特征。随后基于共同特征的存在,利用训练的共同特征鉴别器在毫米波雷达和相机视图中找到匹配对象。最后,基于这些匹配对象,形成相应的相机-毫米波雷达点对进行校准。

与传统的基于目标的方法不同,所提出的方法不仅降低了复杂性和配置要求,而且使系统能够进行在线重新校准,减轻了外参矩阵随时间的潜在风险。这种能力在动态环境中尤其重要,在动态环境下,振动、温度变化和一般磨损等因素会影响毫米波雷达和相机传感器之间的位姿。这项工作的贡献如下:

1) 开发一个深度学习模型,从原始毫米波雷达数据中学习有用的特征,并探索雷达和图像特征之间的关系,以获得共同特征。

2) 第一种已知的方法利用毫米波雷达和相机的共同特征来实现在线无目标物校准方法,并解决了传统校准方法的挑战,例如需要特定的校准目标和手动步骤,使所提出的方法在现实场景的应用中更加实用和有效。

内容概述

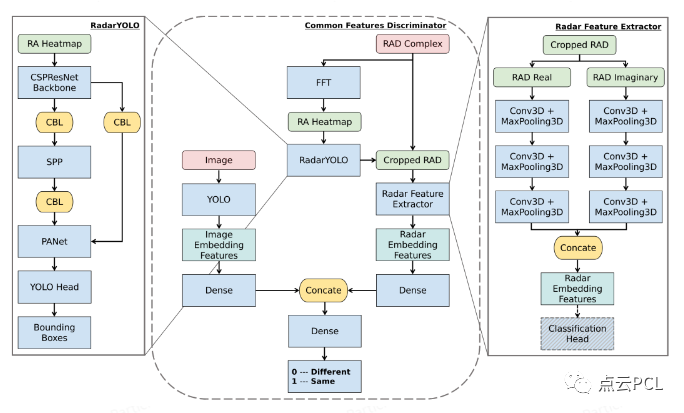

A.问题表述

毫米波雷达与相机校准涉及求解变换矩阵,该变换矩阵建立图像像素坐标系(PCS)中的一个点与毫米波雷达坐标系(RCS)中的另一个点之间的对应关系。该变换矩阵包括分别通过内参校准和外参校准获得的内参矩阵和外参矩阵。在毫米波雷达相机外参校准中,目标是使用已知的相机内参和RCS中的点与PCS中的对应点之间的一组N对应关系来确定外参矩阵。假设RCS中的一个点表示为Pr,其在PCS中的相应点表示为Pp,则它们之间的变换可以表示为:

B.基于常见特征的点对应匹配

基于前面的讨论,解决毫米波雷达和相机坐标系统相关的外参矩阵的关键是在毫米波雷达和相机视图之间找到足够数量的点对应。传统的研究人员依靠使用独特的校准目标物,如角反射器,来提高雷达和相机图像中物体的可探测性。这些目标作为参考点,有助于在两种传感器之间建立准确的点对应关系。然而,对于无目标校准方法,我们不使用特定的校准目标,也不事先了解毫米波雷达和相机视图中的对象。幸运的是,基于在毫米波雷达和相机检测中观察到的与相同物体相对应的共同特征,我们可以匹配这些物体,并进一步对准它们的中心,从而产生点对应关系。

从毫米波雷达和相机检测中提取的共同特征为识别和关联两种模态中的对象提供了有价值的信息。这些特征可以包括反射率、纹理、大小和运动模式。通过分析这些特征,我们可以识别出在毫米波雷达和相机数据中表现出相似模式或特征的物体。

由于毫米波雷达数据中的低分辨率和高噪声等固有限制,使用传统算法提取特征可能具有挑战性。然而深度学习在特征提取方面表现出了比较好的效果,非常适合应对这些场景。鉴于YOLO模型在图像特征提取方面的成功,以及我们研究毫米波雷达和相机数据之间共享特征的目标,选择使用基于YOLO的方法来提取共同特征。通过使YOLO模型适应毫米波雷达数据,可以利用其强大的特征提取能力来识别和提取相关的雷达特征。这使我们能够检测毫米波雷达帧中的物体。同时YOLO模型检测和识别相机图像中物体的能力使我们能够识别雷达和相机数据之间的共同特征。

此外,基于提取的雷达和图像特征,我们构建了另一个深度神经网络,专门致力于发现两种模态之间的共享特征和匹配特征。该网络旨在学习提取的特征之间存在的复杂关系和模式,能够从雷达和相机数据中识别和对齐相应的特征。最终可以有效地探索和利用雷达和相机数据共享的共同特征。

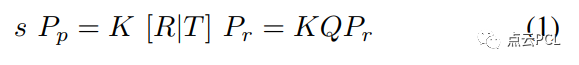

图2:基于YOLO的公共特征网络的体系结构。CSPResNet:跨阶段部分ResNet。CBL:Convolution3D+批量标准化+LeakyReLU。SPP:空间金字塔池。

图2直观地展示了基于YOLO的公共特征网络的结构,并突出了其关键组件和层,以便于全面理解。该网络包括三个主要组件:基于YOLO的雷达探测器,它以原始雷达数据生成的快速傅立叶变换(FFT)热图作为输入,并输出包含检测目标的绑定框;三维卷积神经网络(CNN)雷达特征提取器,其将从雷达检测器获得的边界框作为输入,并对这些边界框所包含的距离-方位-多普勒(RAD)数据进行裁剪,然后基于分类的准确性来确定提取特征的质量;以及全连接公共特征鉴别器,其利用YOLO提取的图像特征以及雷达检测器和雷达特征提取器提取的雷达特征来确定在图像中检测到的物体和雷达检测到的对象是否是同一实体。

**C.毫米波雷达相机外部校准解决方案**

利用深度学习提取的共同特征,可以进行对象匹配和对应识别。通过比较毫米波雷达和相机视图中检测到的物体的特征,我们可以确定哪些物体相互对应。然后可以利用公共特征中编码的空间信息来提取这些物体的中心,这使我们能够在雷达和图像像素坐标系之间建立点对应关系。基于所获得的特征点对应关系,可以进行外参校准矩阵的估计。这本质上是一个用于最小化重投影误差的非线性问题。LM算法结合了最速下降和高斯-牛顿方法的优点,已被广泛用于解决非线性最小二乘问题。

然而,为了确保收敛到全局最优解,该算法需要对外参矩阵给出良好的初始值。在本文的方法中,基于RANSAC(随机样本一致性)算法的校准矩阵的初始估计用作后续LM最小化的初始猜测,RANSAC是一种迭代方法,旨在使用最小的可能对应集来估计数学模型的参数,同时有效地排除异常值。在外参校准的背景下,RANSAC有助于解决噪声雷达测量和雷达相机点对应关系变化带来的挑战。在使用RANSAC过滤掉不合适的对应关系并获得校准矩阵的鲁棒初始估计之后,剩余的点对应关系被用作输入以解决PnP问题。这种两步方法结合了RANSAC在处理异常值方面的优势和迭代LM优化算法的准确性,为在存在噪声雷达测量和点对应变化的情况下进行外参校准提供了有效的解决方案。

实验

实验装置如图5所示,笔记本电脑和NVidia Jetson Xavier GPU使用以太网和USB电缆与雷达摄像头系统建立连接,以收集数据。

图5:实验设置

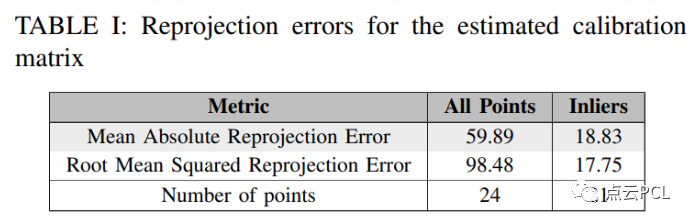

表I给出了用于评估校准矩阵准确性的评估指标,包括平均绝对重投影误差(MARE)和均方根重投影误差。MARE表示投影雷达点与其对应图像点之间的平均绝对差,而RMSRE则测量投影图像点与实际图像点间的总体偏差。

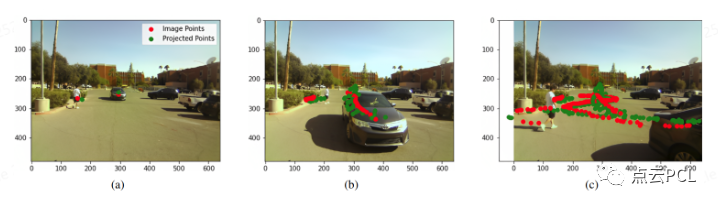

使用获得的校准矩阵将雷达点投影到图像上的结果进一步支持了对我们校准性能的评估,如图4所示。从图4a中可以明显看出,图像点和投影雷达点彼此非常接近,投影雷达点主要落在图像中目标(即汽车和人)占据的区域内。图4b和图4c显示了与两个目标的运动相对应的图像点和投影雷达点的轨迹。可以观察到,雷达和图像轨迹表现出良好的对准,特别是考虑到雷达点的高度可变性。这些视觉结果突出了所提出的校准方法的实用性和有效性,即使在雷达测量中存在固有波动的情况下也是如此。

图4:使用获得的校准矩阵将雷达点投影到图像上。(a) 将各个雷达点投影到图像中的相应目标上,即汽车和人。(b) 图像点和投影雷达点的轨迹对应于帧39处的两个目标的移动。(c) 图像点和投影雷达点的轨迹对应于帧204处两个目标的移动。

总结

根据毫米波雷达和相机的共同特点,提出了一种在线无目标的毫米波雷达和相机外参校准方法,所提出的方法利用深度学习技术从原始毫米波雷达数据和相机图像中提取共同特征,从而能够在不需要特定校准目标的情况下估计外部变换矩阵,实验验证了所提出方法的有效性,证明了其在具有挑战性的真实世界环境中进行可靠和精确的雷达相机外部校准的潜力。这项研究为毫米波雷达相机传感器融合领域做出了贡献,并为校准技术的进一步进步和扩大所提出方法的应用提供了基础,未来的工作可能侧重于进一步提高校准方法的效率和适应性,并探索可视化和解释毫米波雷达和相机数据之间的共同特征。

审核编辑:刘清

-

传感器

+关注

关注

2551文章

51134浏览量

753845 -

机器人

+关注

关注

211文章

28445浏览量

207205 -

RCS

+关注

关注

0文章

57浏览量

12715 -

自动驾驶

+关注

关注

784文章

13826浏览量

166493 -

毫米波雷达

+关注

关注

107文章

1044浏览量

64387

原文标题:基于毫米波雷达和相机共同特征的在线无目标物的外参标定方法

文章出处:【微信号:3D视觉工坊,微信公众号:3D视觉工坊】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

毫米波雷达与超声波雷达的区别

基于毫米波雷达的手势识别算法

基于毫米波雷达的手势识别神经网络

基于毫米波雷达和多视角相机鸟瞰图融合的3D感知方法

一种基于毫米波雷达和相机系统之间的在线无目标校准方法

一种基于毫米波雷达和相机系统之间的在线无目标校准方法

评论