导读

本文介绍了由香港中文大学和粤港澳大湾区数字经济院联合提出的基于 Diffusion 的 Inversion 方法 Direct Inversion,可以在现有编辑算法上即插即用,无痛提点。

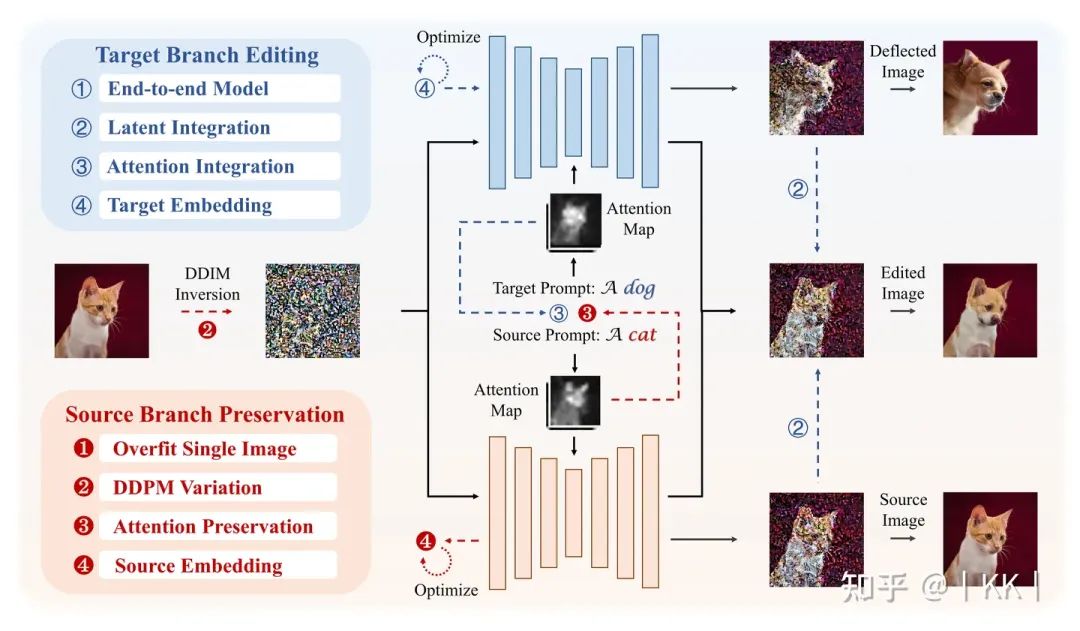

现有主流编辑算法大多为双分支结构,一个分支主要负责编辑,另一个分支则负责重要信息保留,Direct Inversion 可以完成(1)对两分支解耦(2)使两分支分别发挥最大效能,因此可以大幅提升现有算法的编辑效果。

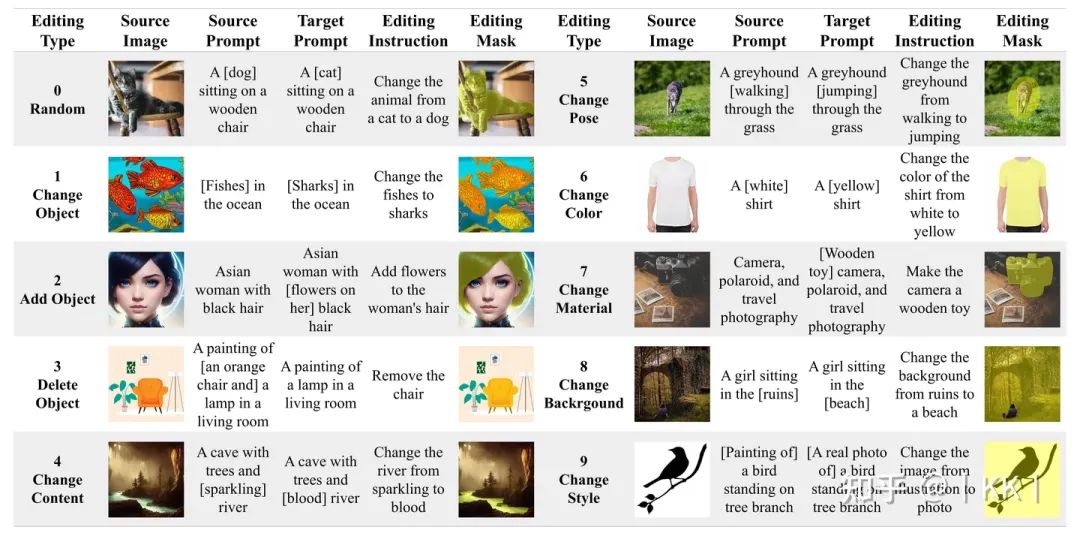

同时,为了更加公平公正的进行基于 text 的编辑效果对比,这篇文章提出了 PIE-Bench,一个包含 700 张图片和 10 个编辑类别的“图片-编辑指令-编辑区域”数据集,并提供一系列包含结构保留性、背景保留性、编辑结果与编辑指令一致性、编辑时间四个方面的评测指标。

数值结果和可视化结果共同展示了Direct Inversion的优越性。

主页:https://idea-research.github.io/DirectInversion/

代码:https://arxiv.org/abs/2310.01506

论文:https://github.com/cure-lab/DirectInversion

这篇论文是如何发现过往方法问题,并找到新解决方案的呢?

基于 Diffusion 的编辑在近两年来一直是文生图领域的研究重点,也有无数文章从各个角度(比如效果较好的在Stable Diffusion的Attention Map上特征融合)对其进行研究,作者在文章中进行了一个比较全面的相关方法review,并把这些方法从“重要信息保留”和“编辑信息添加”两个方面分别进行了四分类,具体可以参见原文,此处不再赘述。

这里提到了一个编辑的重点,也就是“重要信息保留”和“编辑信息添加”。事实上,这两个要点正是编辑所需要完成的两个任务,比如把图1的猫变成狗,那红色的背景和猫的位置需要保留,这就是“重要信息保留”;同时编辑要完成“变成狗”的任务,这就是“编辑信息添加”。

为了完成这两个任务,最为直觉,也是使用最多的方式就是:使用两个分支来完成这两件事,一个用来保留信息,一个用来添加信息。之前的编辑算法大多可以划分出这两个分支,但可能隐含在模型中或者没有显式割离,也正是在这篇文章中,作者将两个概念划分清楚并给出了过往方法的分类。

到现在为止,已经弄清楚了编辑的两个分支及其各自作用,但编辑不仅仅只需要这两个分支,还需要重要的一步,也就是Inversion。

图1 基于 Diffusion 的编辑算法总结

我们都知道,Diffusion是一个把噪声映射到有用信息(比如图片)的过程,但 Diffusion 到噪声的过程是单向的,它并不可逆,不能直接像VAE一样直接把有用信息再映射回到隐空间,即,可以根据一个噪声得到图片,但不能根据一张图片得到“可以得到这张图片的噪声”,但这个噪声又在编辑中非常重要,因为它是双分支的起点。

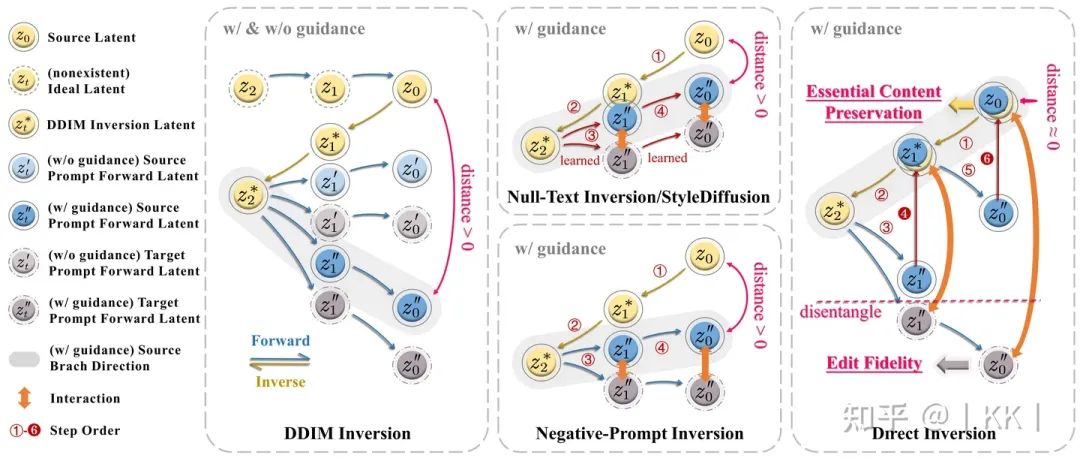

所以大部分人就采用了一种近似的方法,即 DDIM Inversion,它能够将图片映射到噪声,但从这个噪声得到的新图片就会稍微偏离原图片一点(如图DDIM Inversion上标注的distance),其实如果不给模型文本控制条件,偏离还不太严重,但当文本的控制加强时,偏离就会逐渐不可接受。

因此,一系列的 Inversion 方法被提出用来修正这一偏差,比如著名的基于优化的 Null-Text Inversion,而在无数方法进行尝试和探索之后,大家似乎得到了一个 common sense:好的偏离修正必须要包含优化过程。所以这篇文章就更加深入的探索了一下基于优化的inversion(或者说修正)到底在做什么。

这些方法在优化什么?优化真的必要吗?

基于优化的Inversion方法通常使用一个模型输入变量(如Null Text)存储刚刚提到的偏差,而这一偏差则作为优化过程中的loss,通过梯度下降来拟合变量。因此优化的过程本质上就是把一个高精度的偏差存储在了一个低精度的变量中(该变量的数值精度相对 noise latent 更不敏感)。

但这种做法是存在问题的:(1)优化相当于在推导过程中训练,非常消耗时间,比如Null-Text Inversion通常需要两三分钟编辑一张图片;(2)优化存在误差,因此不能完全消除“偏差”,如图2 Null-Text Inversion/StyleDiffusion中画出的,保留分支与原始inversion分支之间的偏差只是被缩小并没有被消除,这就使得重要信息的保护没有发挥到最大限度;(3)优化得到的变量其实在Diffusion模型训练过程中并未出现过,因此相当于进行了强制赋值,会影响模型输入和模型参数之间数据分布的协调。

回到上文提到的双分支编辑,之前的方法训练好优化的变量之后,就会将其同时送入到编辑分支和保留分支(其实不仅仅是基于优化的方法,非基于优化的方法也没有将两分支解耦),根据上面的分析,其实可以发现一个很简单的改进策略:将可编辑分支和保留分支解耦,使两个分支充分发挥各自效能。

图2 各类 Inversion 方法对比

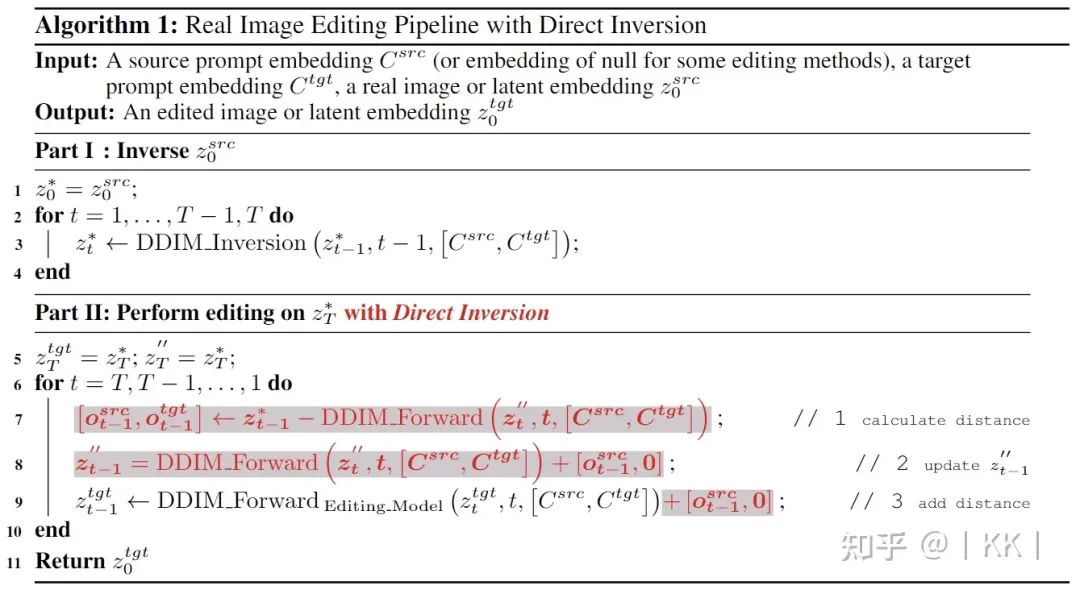

Direct Inversion

这篇文章通过解耦编辑分支和保留分支,仅用三行代码就能够大幅提升现有编辑算法效果(如图3中伪代码),具体做法非常简单,即:将保留分支加回到原始DDIM Inversion路径,而保持编辑分支不被影响。

图3 伪代码

PIE-Bench

尽管基于 Diffusion 的编辑在近几年引起了广泛关注,但各类编辑方法的评估主要依赖于主观且不确定性的可视化。因此这篇文章为了系统验证所提出的Direct Inversion,并对比过往Inversion方法,以及弥补编辑领域的性能标准缺失,构建了一个基准数据集,名为PIE-Bench(Prompt-based Image Editing Benchmark)。

PIE-Bench包括700张图像,涵盖了10种不同的编辑类型。这些图像均匀分布在自然和人工场景(例如绘画作品)中,分为四个类别:动物、人物、室内和室外。PIE-Bench中的每张图像都包括五个注释:源图像提示语句、目标图像提示语句、编辑指令、主要编辑部分和编辑掩码。值得注意的是,编辑掩码注释(即使用一个mask指示预期的编辑区域)在准确的指标计算中至关重要,因为期望编辑仅发生在指定的区域内。

图4 PIE-Bench

实验效果

数值结果

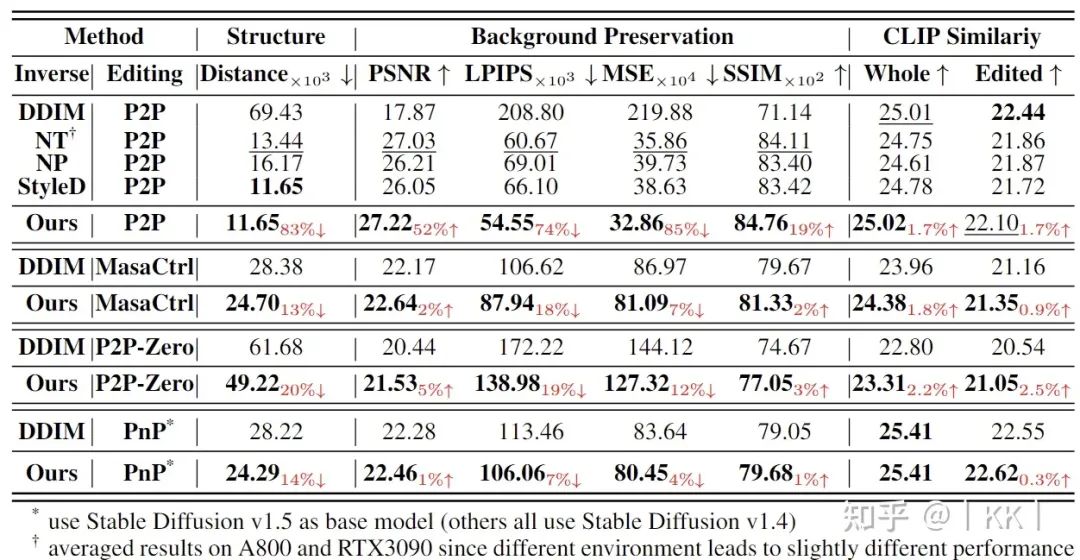

在各个编辑算法上对比不同Inversion和Direct Inversion 算法效果

Direct Inversion 在多种编辑方法上对比其他 inversion 方法的效果。编辑方法:Prompt-to-Prompt (P2P), MasaCtrl, Pix2Pix-Zero (P2P-Zero), Plug-and-Play (PnP), Inversion方法:DDIM Inversion (DDIM), Null-Text Inversion (NT), Negative-Prompt Inversion (NP), StyleDiffusion (SD)

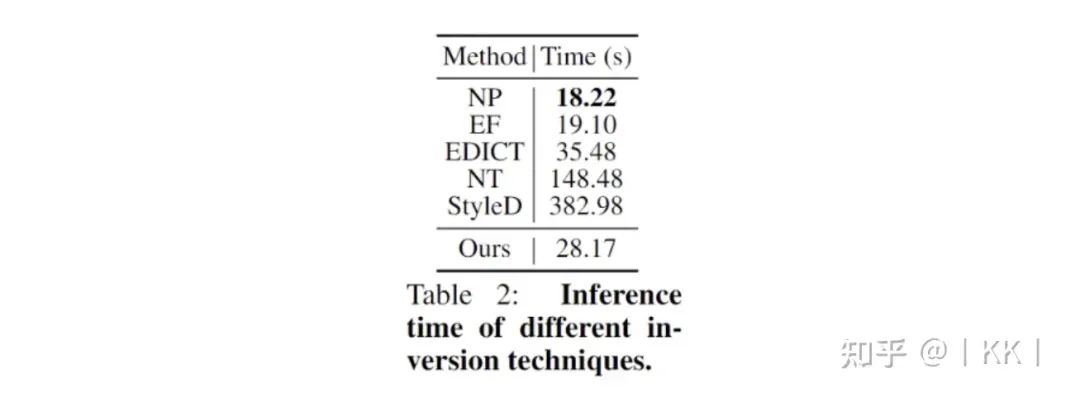

各类 Inversion 算法运行时间对比

运行时间对比

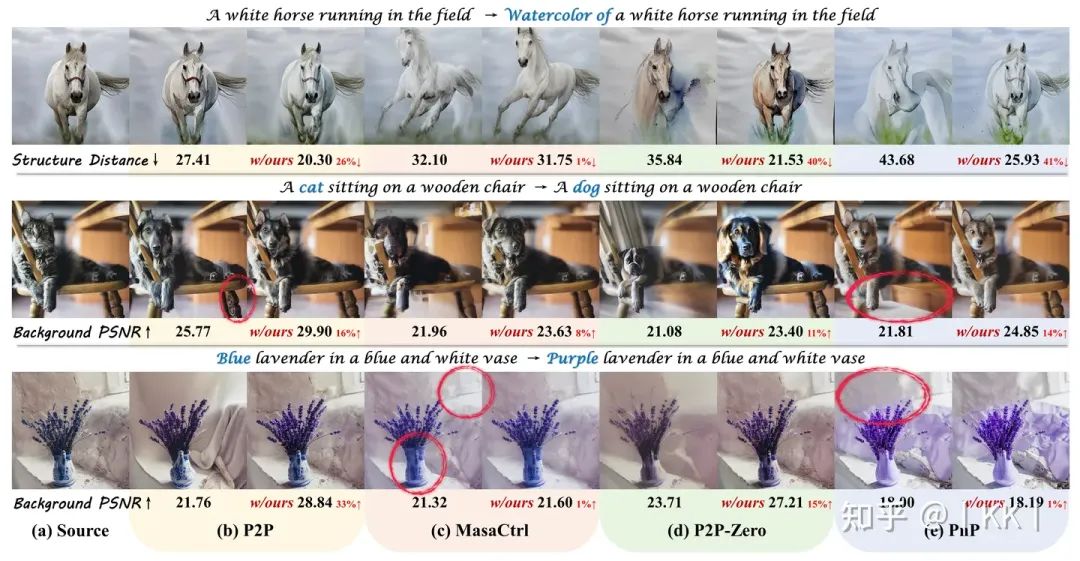

可视化对比

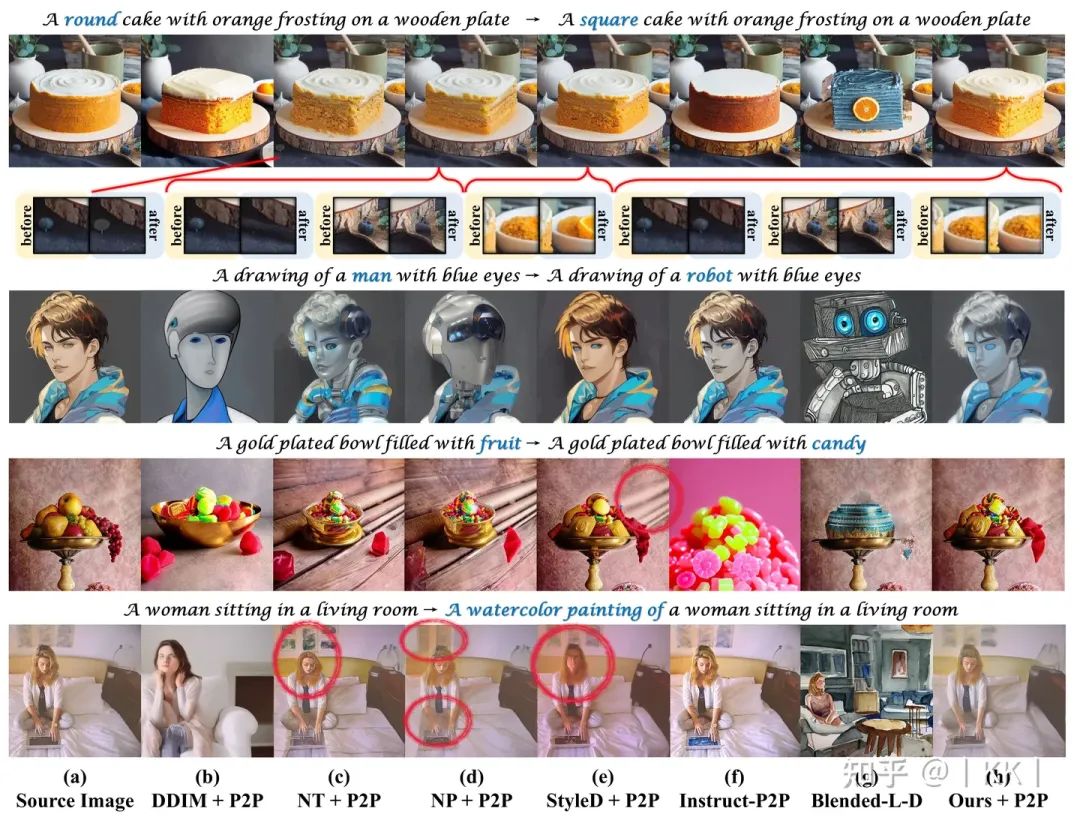

图5 Direct Inversion 与四种基于 Diffusion 的编辑方法结合后在各种编辑类别(从上到下依次为:风格转移、物体替换和颜色变更)上的性能提升,每组结果第一列为未加 Direct Inversion,第二列为添加 Direct Inversion

图6 不同 inversion 和编辑技术的可视化结果

更多可视化和消融实验结果可以参考原论文。

-

算法

+关注

关注

23文章

4615浏览量

93000 -

代码

+关注

关注

30文章

4793浏览量

68702 -

数据集

+关注

关注

4文章

1208浏览量

24726

原文标题:简单有效!Direct Inversion:三行代码提升基于扩散的图像编辑效果

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

请问前三行是什么意思?

请问这三行代码是固定这样写的吗?

三行搞定独立按键

STM32之三行按键宏定义

什么是三行按键?有什么用

EditGAN图像编辑框架将影响未来几代GAN的发展

谷歌新作Dreamix:视频扩散模型是通用视频编辑器,效果惊艳!

AI图像编辑技术DragGAN开源,拖动鼠标即可改变人物笑容

生成式 AI 研究通过引导式图像结构控制为创作者赋能

伯克利AI实验室开源图像编辑模型InstructPix2Pix,简化生成图像编辑并提供一致结果

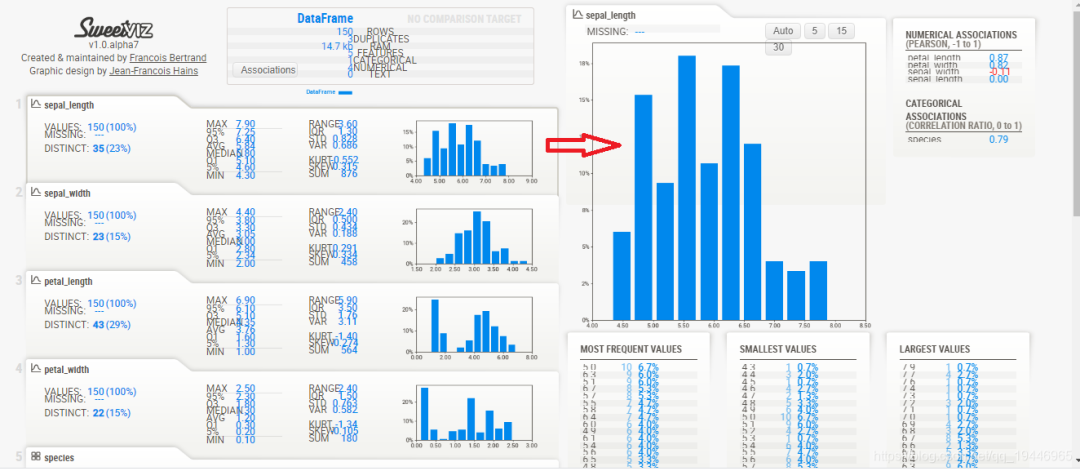

Sweetviz: 让你三行代码实现探索性数据分析

放下你的PhotoShop!无限图像编辑已开源!

Direct Inversion:三行代码提升基于扩散的图像编辑效果

Direct Inversion:三行代码提升基于扩散的图像编辑效果

评论