电子发烧友网报道(文/周凯扬)从回答问题对话到写文章,ChatGPT这类应用已经帮我们展示了生成式AI带来的第一波震撼,从OpenAI的路线也可以看出,他们已经在努力把处理对象从单纯的文字,转换成图片、音频乃至视频了。但这也意味着待处理的数据大小以数量级提升,毕竟再长的文本和视频文件大小比起来还是相去甚远。

I/O瓶颈

要想进一步提升生成式AI的处理性能,我们就不得不看下背后为其提供动力的基础设备,也就是GPU、AI加速器、高带宽内存和光模块。AI模型发展的早期,只需单个GPU甚至是CPU就能处理简单的AI模型,而如今这些先进的AI模型,没有大型机柜组成的服务器和成千上万个GPU,是很难运行起来的。

比如特斯拉老版的自动驾驶训练超算,就是由720个节点的8x英伟达A100 GPU构成的,算力高达1.8 EFLOPS。小鹏于去年建成的智算中心扶摇算力规模高达600PFLOPS,预计也用到了上千块GPU。

尽管部署大量GPU是扩展算力的最直接途径,但与此同时传统的互联方案还是创造了巨大的I/O瓶颈,严重影响了GPU的性能利用率,导致更多的时间花在了等待数据而不是处理数据上。

为此,常用的方案变成了添加更多的GPU来弥补性能和计算效率上的损失,可这样的趋势已经在逐渐被淘汰,因为从减少碳足迹的角度来看,全球范围内各个国家都在开始考虑减少数据中心的能源损耗了。

光子IC

除此之外,另一解决方案就是利用光模块来解决速度慢的节点间电气连接,然而光模块成本较高、密度较低,所以需要更高速、端到端又能降低成本互联方案,即芯片到芯片之间的光学I/O。

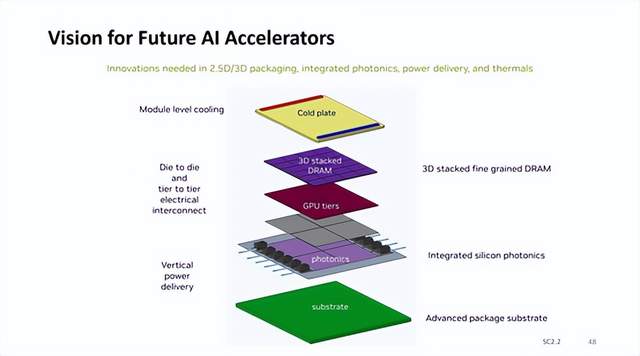

利用更高带宽的光学连接取代诸多并行和高速串行I/O通道,这一愿景促使了行业对近封装光学和共封装光学的追求。相较外部可插拔的管模块,光子IC可将光学I/O集成到GPU封装内部,用来与其他的GPU节点进行直接通信,进一步提高了AI算力的扩展效率,满足了当下持续增长的AI需求。

近期,Sivers Semiconductors就在欧洲光通信展览会上展出了他们打造的八波长分布式反馈(DFB)激光器阵列,该阵列集成在了Ayar Labs的SuperNova多波长光源中,支持GPU之间最高4TB/s的数据传输。根据Ayar Labs提供的数据,新的光源配合它们的TeraPHY封装内光学I/O Chiplet,还提供了低上10倍的延迟和8倍的传输能效。

这样的表现无疑极大地提升GPU的性能利用效率,解决当下生成式AI在I/O性能瓶颈上的燃眉之急。尽管光子计算芯片目前尚不能替代传统的电子半导体器件,但从解决带宽和延迟需求上已经有了长足的进步。

写在最后

面对生成式AI模型大小的指数级上涨,以及逐渐庞大起来的推理数据量,传统的I/O性能必然会面临淘汰,而光子IC为高性能的AI芯片提供了一条更快更高效的通路。不过仍然需要注意的是,光子IC与传统IC还有设计与制造上的区别,比如需要特定的设计工具以及工艺等。因此要想发展光子IC跟上这一波趋势,就必须从EDA和晶圆代工厂开始抓起。

-

IC

+关注

关注

36文章

5950浏览量

175594

发布评论请先 登录

相关推荐

英伟达AI加速器新蓝图:集成硅光子I/O,3D垂直堆叠 DRAM 内存

谷歌Vertex AI助力企业生成式AI应用

使用OpenVINO GenAI API的轻量级生成式AI

生成式AI的基本原理和应用领域

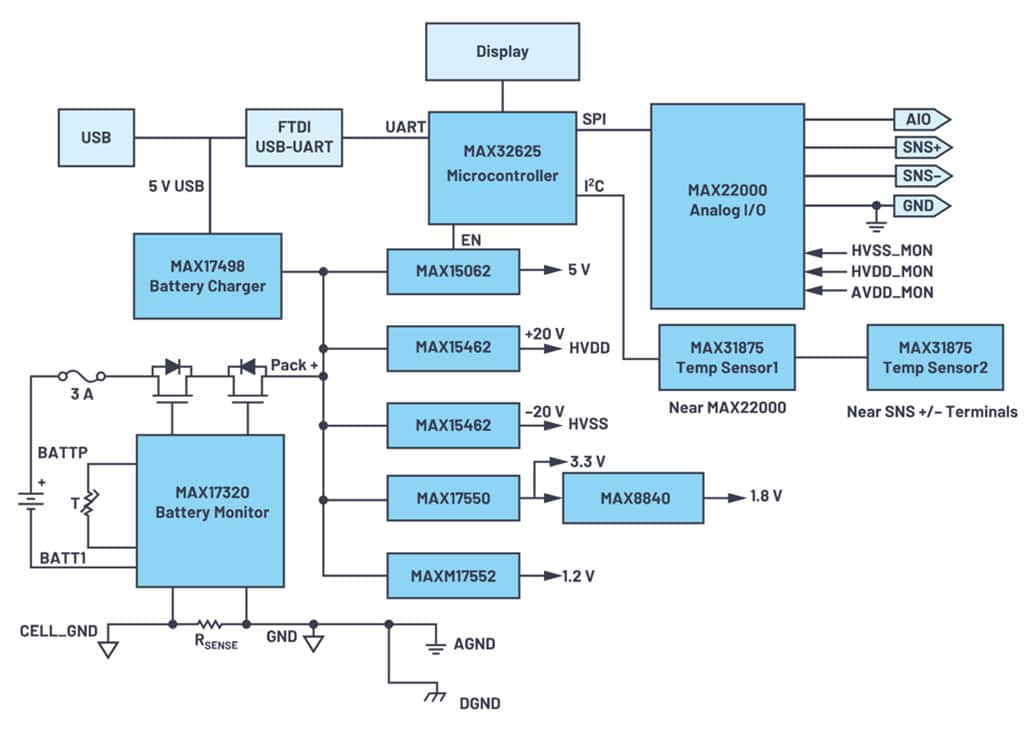

软件可配置模拟 I/O 的设计理念

生成式AI的I/O瓶颈,或许可以用光子IC来突破

生成式AI的I/O瓶颈,或许可以用光子IC来突破

评论