技术将逐渐成为高质量数据的“第一生产力”。

“人工智能会改变世界,那谁会改变人工智能?”著名计算机科学家李飞飞曾多次发问。

回看人工智能60多年的发展历史,大部分时间里,研究者对这个问题给出的答案恐怕都是“模型”。

直到2012年,在ImageNet大规模视觉识别挑战(ILSVRC)上,杰弗里·辛顿带领团队创造了深度学习的“ImageNet时刻”。“数据”第一次站在人工智能舞台的聚光灯下。

某种程度上,大模型的智能涌现,是ImageNet在自然语言理解(NLP)领域“复制”成功的结果。

过去半年,在国内外逐渐解开“大模型谜团”的过程中,数据、算法、算力这“三驾马车”在人工智能中扮演的角色正在被重新分配。技术驱动的高质量数据,正在成为驱动模型能力提升的最关键要素。与之相伴的AI数据服务行业也迎来了全新的时代。

1.大模型时代,“数据为王”?

大模型时代,整个数据服务行业都在面临一次“翻新”。

正如汽油需要从原油中提炼才能供汽车使用一样,AI产业链条中,大多数据为非结构化数据,AI公司通过数据标注获得结构化数据,以此“喂养”算法进行AI训练,最终生成的模型数据可用于各种场景,从而激发数据的AI价值。因此,数据标注一直是人工智能深度学习路径下不可或缺的存在。

“大模型时代,数据为王。”这是部分行业观察者给出的一则判断。当前的AI大模型训练过程中,算法端逐渐向Transformer神经网络“收敛”,算力端依赖于具备大规模并行计算能力的AI服务器集群,数据端则需要涵盖巨量数据的大规模数据集持续投喂。

必须承认,大模型的智能涌现是三大要素彼此交织的工程学胜利。但某种程度上,算力决定了模型能力的“下限”,而在实际应用场景中,数据质量决定了模型能力的“上限”。

数据是直接影响AI大模型落地效果的关键因素。相比于模型算法和底层算力,高质量数据更为稀缺。

大模型时代,所谓“高质量”数据,也有了更丰富的含义。

Mckinsey Global Institute研究报告表明:深度学习模型对训练数据的数据量、多样性和更新速度方面提出较高要求。具体而言,约1/3的算法模型每月至少更新一次,约1/4的算法模型每日至少更新一次。算法模型的持续更新,将进一步拓展各领域训练数据的需求空间。

大模型的研发和应用链路更长。简单来看,大模型训练包含“模型方案设计-数据采集-数据清洗-数据标注-数据质检-模型训练-模型测试-模型评估”八大环节。

其中,“数据采集-数据清洗-数据标注-数据质检”四步是AI基础数据服务的关键技术流程;在模型训练环节,大模型也对预训练数据、微调数据(SFT/RLHF)需求量更大且对质量要求更高;在模型评估和应用环节,模型评估标准、测试数据集,以及应用阶段的Prompt工程成为基础数据服务企业面临的新挑战。

需求端的变化重构了数据服务领域原有的游戏规则,传统数据标注行业“作坊式”的工作模式和工作效率越来越无法满足激增的“工业化”数据需求。

基础数据服务企业一方面要夯实交付能力,提升数据质量和作业效率;同时还要开拓各类算法、AI辅助等技术,以弥补重人力投入带来的高成本、低效率等问题。

长久来看,基础数据服务需要一条更完善、更高效的“智能流水线”,来匹配大模型时代的新需求。

2.给数据建一套“智能流水线”

国外一家初创企业已经走在前列。

ChatGPT爆火后,AI数据服务商Scale AI被当作“站在OpenAI背后的公司”而备受关注。

自2016年成立以来,Scale AI在最初四年专注为人工智能/机器学习模型所需要的数据做标注。在之后的时间,Scale AI逐渐向下游扩展,开发自有模型,并逐步进入人工智能产业链的更多环节。

2020年,成立5年的Scale AI突破了1亿美元的ARR,成为有史以来最快达到这一里程碑的公司之一。

ScaleAI爆发性成长的根源在于,它颠覆了数据标注行业作为“劳动密集产业”的历史,并以一己之力将行业推向“技术密集型”产业。

商业世界中,时代更替、优胜劣汰的故事屡见不鲜,国内也开始浮现一个声音——谁是“中国的Scale AI”?

中国基础数据服务市场大致有互联网企业、初创企业及传统数据服务商三类玩家。

其中,传统数据服务商大多“重人力,轻技术”,多依赖众包或外包模式起家,延续一直以来的“人海战术”,能够满足部分低端需求,具备部分AI辅助标注能力,但整体欠缺算法能力。

创业公司则“重技术,轻人力”,从智能化标注工具的小赛道切入,较成熟的创业公司建有自己的数据标注基地,逐渐形成全栈式交付能力。

相比之下,互联网企业虽然不算入局最早的,却是起点最高的。互联网企业有充足的资金、人才和技术储备,能够强势整合平台资源,加注技术研发,是近年来AI数据服务领域发展势头最猛的力量。

三大玩家均在不同程度“对标”ScaleAI,向人工智能产业链下游延伸,并拉开数据采标的智能化变革。然而,真正拥有一套完整智能化流水线的玩家却不多。

火山引擎,已经率先展开探索。

据火山引擎AI数据中心负责人金亮介绍,火山引擎AI数据服务已经给数据搭建了一套“智能化流水线”,即智能化标注平台。该平台包含两大能力套件——智能作业套件及智能管理套件。

智能作业套件基于标注领域的模型,建设了机标、预标、辅标的智能作业能力矩阵,以模型能力部分替代和全部替代人工标注作业;辅以模型持续优化流程及智能评估、调度能力,保障整体模型覆盖度和提效表现。

作业套件沉淀了多种标注模板,包含ASR,NLP,CV等全品类的模板覆盖。如ASR的短语音标注、长语音标注、图像的关键点、矩形框,点云、2/3D融合标注、连续帧、离散帧等标准模板,能够保障数据安全、平台操作便捷且可定制化。项目经理只需要简单配置一下,便可以执行任何类型的任务。

平台集成了预标注与边标边训和主动学习式的模型,用各类模型辅助甚至代替部分人工操作。同时根据不同的项目阶段,选择适合的模型能力接入相应的项目阶段。

例如,在数据标注初期,火山引擎AI数据服务利用模型过滤大量数据,即进行模型预标,减少人工作业的数据量。模型预标后,只需抽取置信度不高的少量数据,由标注员进行确认或修改即可。既完成交付,也能够给模型提供反馈,持续提升模型性能。

此外,火山引擎AI数据服务还会利用模型进行纠错,即标注员提交的结果会过一遍模型,两者相差过大模型会进行纠错,避免标注员提交质量显著偏低的结果。在质检作业时,模型可以辅助筛选需重点质检任务或直接完成数据的验收,最终可实现约20%-40%的效率提升。

智能管理套件则基于NLP和对话模型的交付助理GPT、作业助理GPT等助理能力,通过模型的场景优化和策略引擎,实现管理过程中的智能预警和干预,以及业务知识的个性化查询,提升整体管理效率,降低培训成本。

此外,金亮表示,基于智能化标注平台,火山引擎AI数据服务团队也摸索了一套“人机结合”的作业模式。“我们把复杂的业务通过技术拆解成最小单元,把每一个小业务变成简单的业务,做机器标注解决,若干个简单的任务,最后通过技术进行合并,让使用者都能低门槛使用火山引擎的标注平台。”金亮说。

在无数次实战中,火山引擎AI数据服务已经形成完整的一站式服务能力体系。

AI链路上,火山引擎AI数据服务可支持数据采集、清洗、标注、格式处理、数据管理、模型训练与运维、模型评测等AI基建能力;

算法技术上,其可支持CV、智能语音、NLP等机器学习/深度学习算法,及LLM、SD等类别的大模型训练数据;

服务类型上,可提供高质量的定制化采标服务、模型优化和迭代、预标模型定制化、智能化数据服务平台等产品服务;

应用场景上,可覆盖行业95%以上的业务场景,应用于泛互、社交娱乐、媒体咨询、自动驾驶、智能金融、智能家居、推荐理解、智慧医疗等垂类场景。

2021年火山引擎AI数据服务迎来了第一家客户——国内某top级别的自动驾驶解决方案商。 客户要求的项目类型是图像BEV算法标注(即“鸟瞰图的标注”,基于图像/Lidar/多模态数据的3D检测与分割任务),并要求交付图片准确率要达到98%以上。 为实现超预期交付,项目经理直接带着团队到客户现场驻场,参与客户车辆测试路跑数十公里,想尽各种办法,最大程度贴合客户真实的业务场景,为客户量身定制质量管理方案。最终,该项目达到了99.6%的交付准确率。 超客户预期的高质量交付结果帮助客户将自动泊车指数提升了304%。也正因如此,首家客户和火山引擎在AI数据服务上的合作一直持续到了今天。 接下来的两年中,火山引擎AI数据服务成长迅速。 目前,火山引擎AI数据服务也面向火山方舟提供多项服务。 火山方舟是火山引擎发布的大模型服务平台,面向企业提供模型精调、评测、推理等全方位的平台服务(MaaS,即Model-as-a-Service)。目前,“火山方舟”集成了百川智能、出门问问、复旦大学MOSS、IDEA研究院、澜舟科技、MiniMax、智谱AI(以拼音首字母排序)等多家AI科技公司及科研院所的大模型。 “企业使用大模型,首先要解决安全与信任问题”,火山引擎总裁谭待表示,“火山方舟”实现了大模型安全互信计算,为企业客户确保数据资产安全。基于“火山方舟”独特的多模型架构,企业可同步试用多个大模型,选用更适合自身业务需要的模型组合。 火山引擎AI数据服务已经向火山方舟提供包括RLHF多轮对话训练、SFT阶段数据精调标注、RM排序数据精调训练、问答改写精调标注、文本大模型综合标注模板及Prompt工程指令库等服务。 火山引擎AI数据服务正在探索一条以技术为主引擎的高质量数据道路。

3.技术,高质量数据的“第一生产力”

三年前,整个“数据”行业迎来一次历史性转折。 2020年4月,中共中央、国务院发布《关于构建更加完善的要素市场化配置体制机制的意见》,将数据作为与土地、劳动力、资本、技术并列的生产要素,要求“加快培育数据要素市场”。 一时间,各种声音开始解读——这一变化究竟意味着什么? 相关政策指出,数据要素涉及数据生产、采集、存储、加工、分析、服务等多个环节,是驱动数字经济发展的“助燃剂”。换言之,数据要真正成为生产要素,意味着数据不能是“一盘散沙”,而需要以“数据”为中心,生长出一条完整的产业链。 如今,数字经济已然行至水深处,不少领域甚至开始走入“无人区”。此时此刻,人工智能,则是让数字经济走出无人区,通往开阔地带的一把锁;高质量的数据养料,则是打开这把锁的一把密钥。 在数据的“智能流水线”背后,是一整套体系的系统性升级。 基础设施层,基于云服务的AI训练全栈式服务,可以充分衔接AI基础数据服务及模型训练过程;平台层,工具链及AI标注平台为模型训练整体提效;工具层,各类AI辅助标注工具提高各环节服务质量,最终实现模型训练过程中的快速迭代。 火山引擎AI数据中心负责人金亮告诉「甲子光年」,目前AI标注工具正处于半自动化状态,能够实现简单的数据标注。但未来,随着生成式AI技术的发展,AI对语音、语义、图像分割等理解能力实现重要突破,AI标注工具则能实现AI全自动化/半自动化高交互的终极状态。 回看AI数据服务的发展历程,整个行业都正在经历从无序到有序,从劳动密集型产业到技术密集型产业的华丽蜕变。如今,率先布局智能化数据生产线的火山引擎AI数据服务,则已经取得先发优势,技术将逐渐成为高质量数据的“第一生产力”。

-

数据采集

+关注

关注

39文章

6131浏览量

113727 -

智能化

+关注

关注

15文章

4897浏览量

55463 -

人工智能

+关注

关注

1792文章

47354浏览量

238834 -

大模型

+关注

关注

2文章

2476浏览量

2820

原文标题:大模型时代,如何搭建数据的“智能化流水线” ?|甲子光年

文章出处:【微信号:jazzyear,微信公众号:甲子光年】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

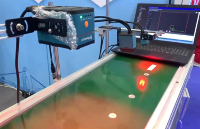

工业读码器解决方案在自动化流水线上扫描条码的应用

SMT流水线布局优化技巧

行云流水线 满足你对工作流编排的一切幻想~skr

ADS5413 CMOS流水线模数转换器(ADC)数据表

MT6701磁编码IC在自动化插件流水线中的应用

大模型时代,如何搭建数据的“智能化流水线”?

大模型时代,如何搭建数据的“智能化流水线”?

评论