本文内容来自“AI产业热潮带动服务器、交换机、光模块及相关芯片行业蓬勃发展”,重点分析国外大模型厂商产品、国内主要大模型产品,以及AI热潮给服务器、交换机、光模块及芯片产业带来的发展机会。

2022年 11 月,美国 OpenAI 公司在 GPT-3.5 的基础上推出聊天机器人 ChatGPT。相比于之前的主流 AI 模型,ChatGPT 通过采用 Transformer 算法以进行自然语言处理。

2023 年 3 月,OpenAI 公司应势推出新的 GPT-4。GPT-4 是对ChatGPT 的重大升级迭代,不仅具备更加强大的语言理解能力,还能够处理图像内容。GPT-4可以生成更长、更复杂、更准确、更多样化的文本字符串,并在人们输入图像时做出响应,可以更好地避免 GPT-3.5 在处理某些问题时可能出现的错误,保证问题解决过程的规范和准确。

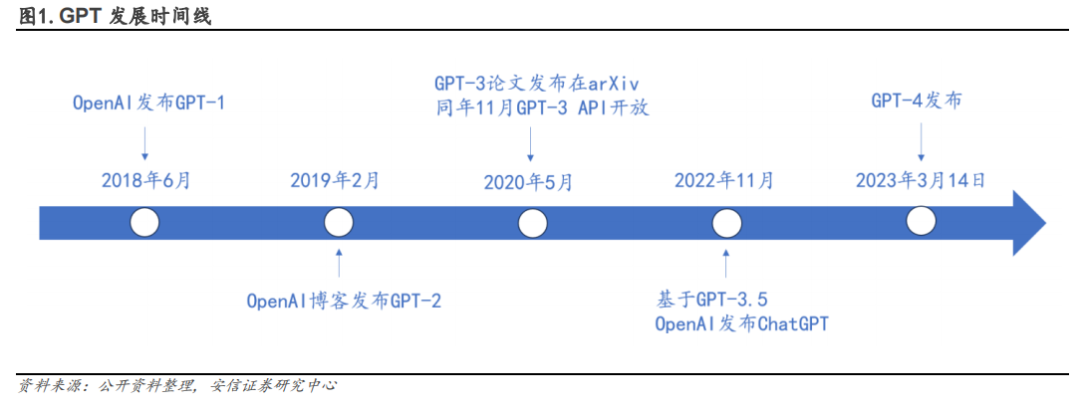

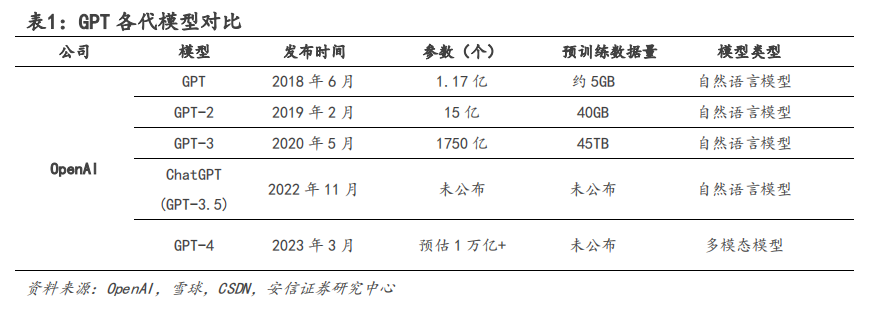

截至目前,GPT 经历了从 GPT-1 发展至 GPT-4 的迭代升级。

自 ChatGPT 推出以来,国内外各企业纷纷入局,大模型发展如火如荼。目前市面主流的 AI 服务器配备 Nvidia Ampere 架构的计算卡 A100。

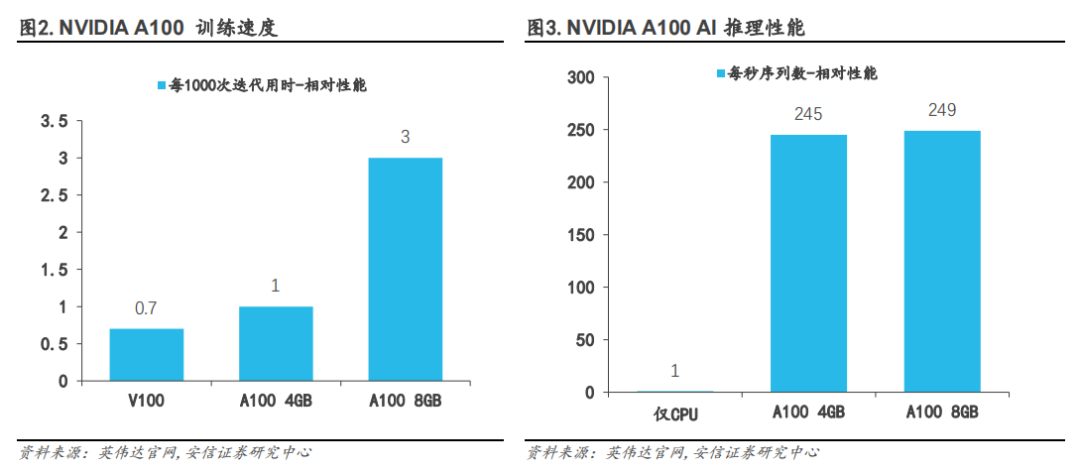

A100 的性能比上一代产品 V100 提升高达 20 倍,可划分为七个 GPU 实例,根据变化的需求进行动态调整。A100 的单精度浮点计算能力峰值可达 19.5TFLOPS,双精度浮点算力可达9.7TFLOPS。相比 V100,A100 80GB 可针对大型模型提供高达三倍的 AI 训练速度;相比 CPU,A100 80GB 可提供高达 249 倍的 AI 推理性能。OpenAI 公司在推出 GPT-3 和 ChatGPT 时即使用英伟达的 NVIDIA A100 GPU 来训练和运行。

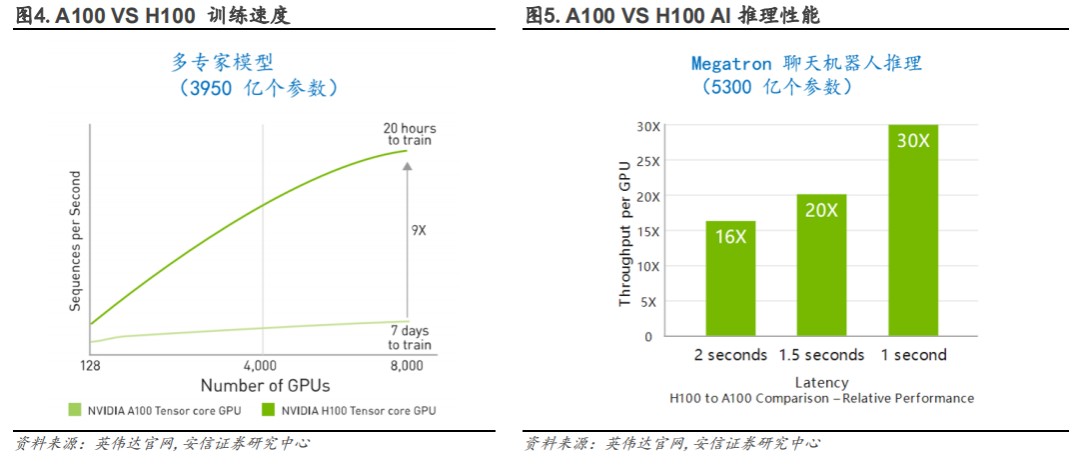

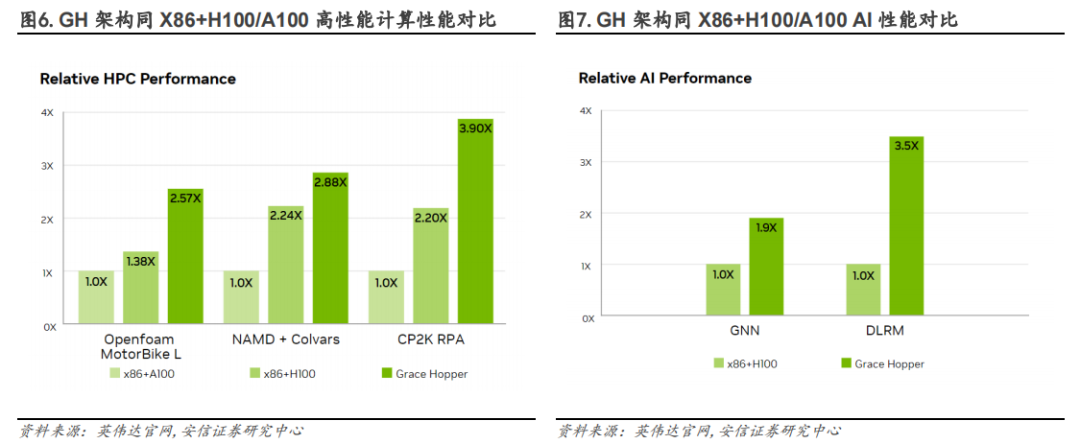

针对算力需求巨大的 ChatGPT 及其他大模型,英伟达推出 NVIDIA H100 NVL。NVIDIA H100NVL 是具有 94GB 内存和加速 Transformer 引擎的大语言模型(LLM)专用解决方案。H100 的单精度浮点计算能力峰值可达 34 TFLOPS,双精度浮点算力可达 67 TFLOPS。与 NVIDIA A100GPU 相比,NVIDIA H100 在大型语言模型上具有高达 9 倍的训练速度和 30 倍的 AI 推理性能,进一步巩固英伟达在 AI 芯片市场的领先地位。

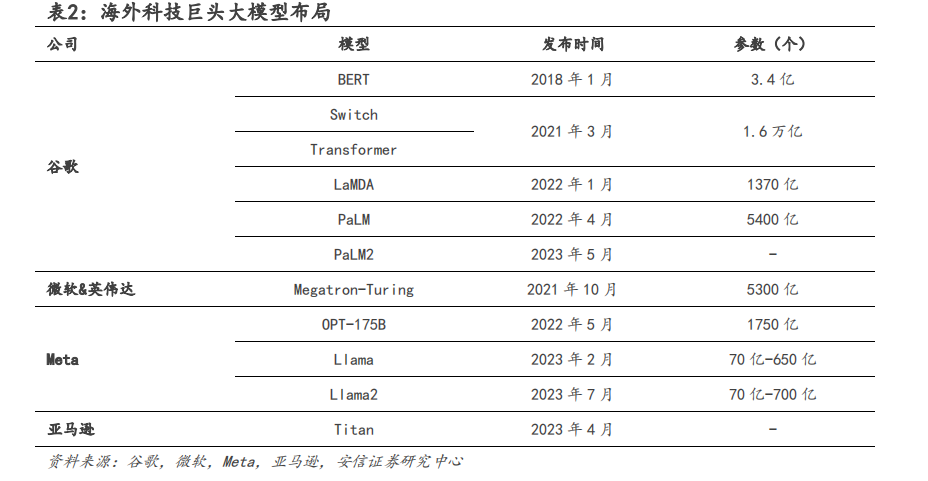

1、海外巨头争夺 AI 领域主动权

3 月 16 日微软推出 AI 版 Office“全家桶”:Microsoft 365 Copilot。2023 年 7 月 18 日,微软于 Inspire 合作伙伴大会上宣布,面向 Office 365 E3、E5、商业标准版和商业进阶版的订阅商户,Microsoft 365 Copilot的定价为每个用户每月 30 美元。

2022 年,谷歌推出了 5400 亿参数大模型 PaLM,而 2023 年 5 月 10 日,谷歌又发布了 PaLM2,部分能力已经超越了 GPT-4。谷歌推出基于 LaMDA 的 Bard 用来对标 ChatGPT。Bard 的 LaMDA模型训练参数达 1370 亿个。在 2023 年 3 月 21 日,谷歌宣布开放 Bard 公测,并于 2023 年 4月 10 日改用更强大的 PaLM 大型语言模型以增加其运算能力。随着全球 AI 接入潮兴起,谷歌也将 Bard 应用到谷歌搜索和办公软件中。DuetAI 是应用于 GoogleWorkspace 的办公类 AI工具,用来对标微软 Copilot,可以自动生成文档、表格和图片。

2022 年 5 月,MetaAI 发布了基于 1750 亿参数的超大模型 OPT-175B。2023 年 2 月,Meta 宣布将推出针对研究社区的“Meta 人工智能大型语言模型”系统“LlaMA”。2023 年 7 月,MetaAI 发布了第二代语言大模型 Llama2,模型开源且可免费用于商业用途。依照测试结果,700亿参数的结果同常见的闭源模型 GPT-3.5 在 MMLU 和 GSM8K 水平上较为接近,但在生成代码的能力上存在较大差距。微软在随后的 Inspire 合作伙伴大会上同时宣布在 Azure 云计算平台上相应深度整合 Llama2 模型框架。亚马逊的 AWS 云也加入和 Meta 的合作中。

2023 年 4 月 13 日,亚马逊云服务部门宣布推出自有大型语言模型泰坦,模型初始可分为两种,第一类名为 Titan Text,为生成式 LLM,可用于总结、文字生成等。第二类名为 TitanEmbedding,专注于将文字输入转换为参数化的表达,相应的技术已被用于亚马逊商品的推荐算法中。

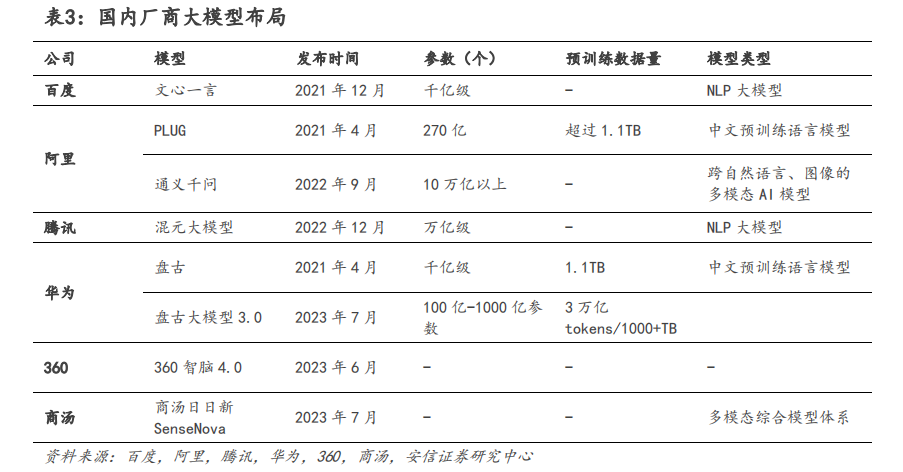

2、国内大厂加速布局大模型

国内厂商也在加速研发大模型,各大互联网巨头纷纷入局 AI 大模型。

百度最早于 2019 年推出预训练模型 ERNIE 1.0,历经多次迭代,百度文心大模型形成了基础大模型、任务大模型、行业大模型三级体系。框架层面上,百度提供了中国首个开源的产业级深度学习框架-飞桨PaddlePaddle,百度构建了文心大模型+飞桨深度学习平台的商业模式,落地应用方向广泛,涵盖金融、能源、电力、航天、互联网等领域。

2022 年 9 月,阿里发布通义大模型系列。通义大模型分为统一模型底层、通用模型层和专业模型层。目前,阿里通义大模型已落地应用于电商、医疗、娱乐、设计、金融等行业,服务超过 200 个场景。2023 年 4 月 11 日,阿里正式推出大语言模型通义千问。此外,阿里还推出了用户共建 AI 模型服务型平台“魔搭社区”,目前社区内已集聚了 180 多万 AI 开发者和900 多个优质 AI 模型。2023 年 7 月 7 日上海世界人工智能大会上公司 CTO 表示,阿里云将向大模型创业公司提供全方位的服务,包括最强大的算力和开发工具。

华为云团队 2020 年开始发展 AI 大模型,2021 年 4 月发布盘古大模型。2023 年 7 月 7 日,华为于公司开发者大会 2023 上正式发布 AI 大模型华为盘古大模型 3.0。模型提供 100 亿参数、380 亿参数、710 亿参数和 1000 亿参数的系列化基础大模型。此外,华为一站式 AI 开发平台 ModelArts 为盘古大模型的训练、推理迭代发展持续提供优化支持。目前,盘古大模型已在 100 多个行业场景完成验证,涵盖能源、零售、金融、工业、医疗、环境、物流等。

腾讯于 2022 年 12 月推出了万亿中文 NLP 预训练模型混元 AI 大模型。目前,腾讯混元大模型涵盖 NLP 大模型、CV 大模型、多模态大模型和众多行业模型。腾讯也打造了一站式机器学习生态服务平台——太极机器学习平台,为混元大模型提供底层支持。受益于腾讯自身业务广泛,混元大模型在腾讯内部已与腾讯广告、微信、QQ、游戏等产品结合,在广告提效层面效果显著。同时,混元大模型还通过腾讯云实现对外的商业化。

2023 年 4 月 18 日,字节跳动旗下火山引擎发布自研 DPU 等系列云产品,并推出升级版的机器学习平台,支持万卡级大模型训练。2023 年 6 月 28 日,字节跳动公布了公司在大模型业务的最新进展,并发布了大模型服务平台“火山方舟”,提供模型的训练、推理、评测、精调等功能服务。目前集成了百川智能、出门问问、复旦大学 MOSS、IDEA 研究院、澜舟科技、MiniMax、智谱 AI 等多家公司及团队的大模型。

科大讯飞于 2023 年 5 月推出星火认知大模型,目前已在教育、办公、汽车、数字员工等行业中落地应用。在发布会上,董事长刘庆峰表示未来科大讯飞将在保护伦理和安全的前提下发展认知大模型,同时联合开发者推动认知大模型应用落地,共建人工智能“星火”生态。2023年 6 月 13 日,360 集团发布认知型通用大模型“360 智脑 4.0”,并宣布 360 智脑已接入 360旗下产品,如搜索引擎、浏览器和安全卫士中。同时,借助 360 长期在互联网安全方面的积累,公司建立了“安全大脑”大模型,以监管大模型中的不当行为。

2023 年 7 月 7 日,商汤推出大模型体系“商汤日日新 SenseNova”的多方位全面升级及体系下一系列大模型产品的落地成果,其中包括金融领域的客服、投研分析降本增效;医疗场景内辅助导诊问诊、辅助决策;移动终端内智能交互、内容交互;线下场景的故障识别、缺陷判断;线上直播短视频平台的数字人应用及营销工具;智能汽车领域的集安全效率为一体的智能座舱体验等。

3、人工智能行业加速服务器、AI 芯片、交换机、光模块产业

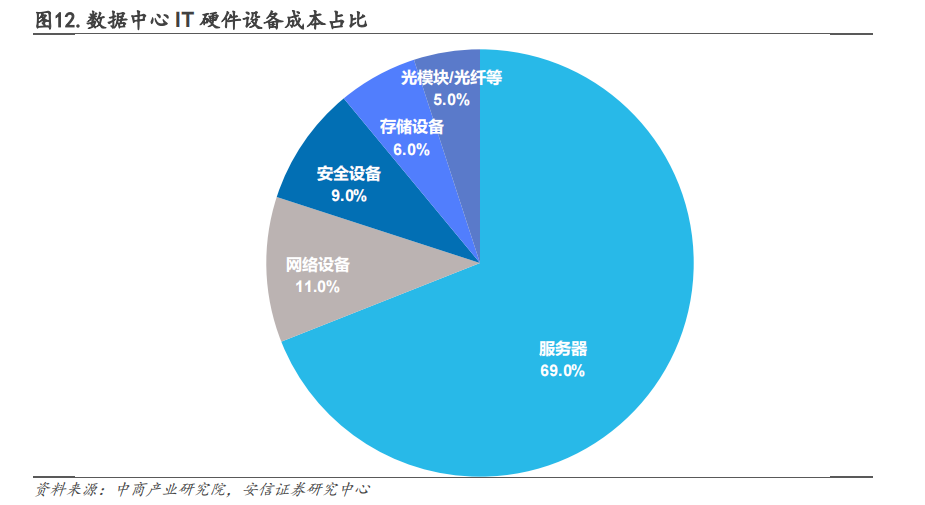

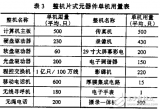

人工智能的快速发展推动数据使用量的飙升,推动数据中心基础设施建设的快速增长。数据中心基础设施主要包括 IT 设备、非 IT 设备、软件及建设工程。在 IT 设备采购成本中,服务器占比最大达 69%。网络设备(即交换机和路由器)、安全设备、存储设备和光模块/光纤等分别占数据中心设备采购成本的 11%、9%、6%和 5%,不同方案成本占比略有不同,但总体上服务器成本占 IDC 硬件成本70%左右。

到 2023 年中旬,AI 服务器市场出货量接近 60 万台,相比上年同期增长约 39%。根据TrendForce 预估,2023 年全球 AI 服务器出货量将接近 120 万台,同比增长 38.4%,占整体服务器出货量的比重约 9%。到 2025 年将增长至近 190 万台,2022-2025 年期间年平均增长率达 41.2%。预计 2030 年全球算力规模达到 56 ZFlops,平均年增速达到 65%。

从全球市场份额占比来看,2021 年浪潮信息市占率达 20.9%,位列行业第一。其次为戴尔、HPE、联想、IBM,占比分别为 13.0%、9.2、5.8%、4.1%。

-

芯片

+关注

关注

456文章

50889浏览量

424251 -

服务器

+关注

关注

12文章

9205浏览量

85550 -

交换机

+关注

关注

21文章

2645浏览量

99727

原文标题:AI热潮带动服务器、交换机、光模块及芯片蓬勃发展

文章出处:【微信号:AI_Architect,微信公众号:智能计算芯世界】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

AI热潮带动服务器、交换机、光模块及芯片蓬勃发展

AI热潮带动服务器、交换机、光模块及芯片蓬勃发展

评论