本文来自边缘域 AI 的“寒武大爆发”,自 ChatGPT 问世以来,从 GPT-1 到 GPT-3.5,GPT 模型的智能化程度不断提升,GPT-4 多模态模型的发布进一步加速产业革命。ChatGPT 对智能终端的赋能开启新一轮“寒武大爆发”时代。

根据在网络中的位置,AI 芯片可以分为云端 AI芯片 、边缘和终端 AI 芯片;根据其在实践中的目标,可分为训练(training )芯片和推理(inference )芯片。

云端主要部署高算力的 AI 训练芯片和推理芯片,承担训练和推理任务,具体有智能数据分析、模型训练任务和部分对传输带宽要求比高的推理任务;

边缘和终端主要部署推理芯片,承担推理任务,需要独立完成数据收集、环境感知、人机交互及部分推理决策控制任务。

全球新一轮 AI 风暴渐起,各家大厂相继发布多款 AI 产品和大模型突破进展,可以预见未来训练和推理端需要的算力将呈指数级增长。单 AI 芯片或计算架构或面临传输时延、功耗、成本等多方面因素制约,因此,未来 AI 运算将呈现边云协同的多层次算力网络趋势,AI 训练迭代优化等复杂性任务主要在云端,实时、局部数据处理和推理任务主要在边缘侧。

1、边缘 AI 芯片:打通推理加速的“最后一公里”

目前边缘计算市场上参与者众多,不同阵营厂商正以不同的路线共同推动边缘计算快速发展。以英特尔、AMD 等为代表的芯片厂商积极推出 CPU、GPU、FPGA、DPU、IPU 等边缘算力芯片;亚马逊、微软等云服务厂商将云计算能力向设备和用户侧延伸,扩充云数据中心的外延,将云原生的统一编程模式通过边缘网关的能力应用到设备构成的边缘云,主打云边协同一体化

严格意义上的边缘 AI 市场,包括边缘终端市场和边缘服务器市场两类。边缘终端市场是指直接在终端设备上做计算的 AI 芯片,对于功耗和能效要求比较高,包括针对特定应用的 SOC 芯片和通用加速器独立芯片两种形态。另一种针对边缘服务器市场,通常以处理器加上通用型深度学习加速芯片为主流方案,传统巨头英伟达、华为等在此市场有较深布局。而本文则将重点讨论边缘终端市场的芯片架构,边缘服务器市场暂不涉及。

2、计算芯片:NPU 算力是“兵家必争之地”

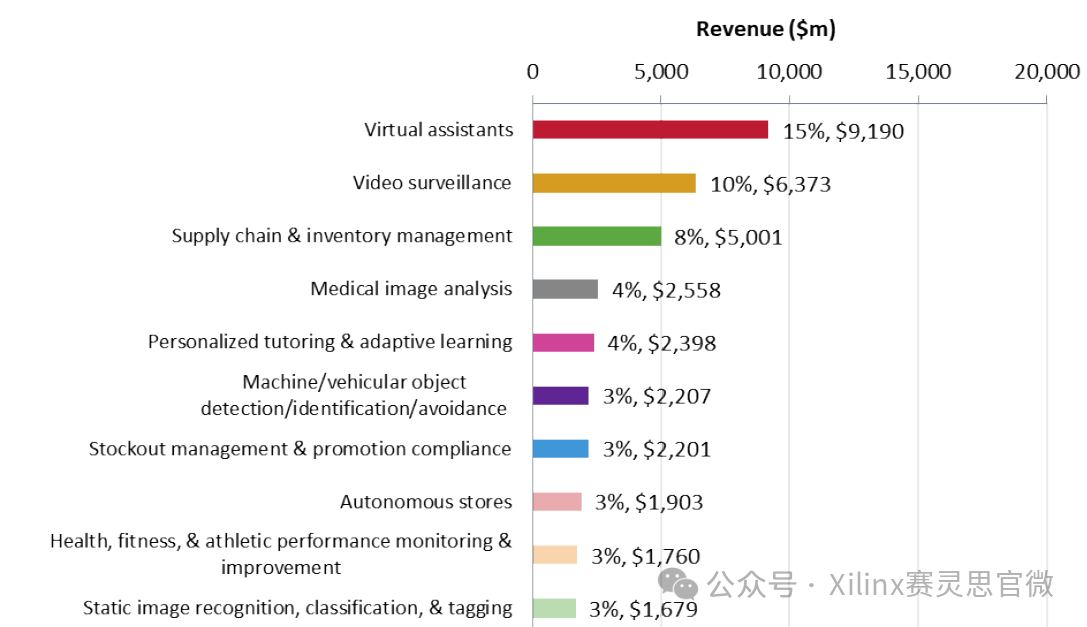

在经历文本、图像、语音等生成式 AI 系统陆续落地之后,我们认为视频将是后续 AIGC 落地的重要应用场景,人机交互的输入端也将从文字、语音识别扩展至机器视觉等形态。智能终端的主控芯片也将从传统的音视频编解码功能,扩展至更高性能、更大算力的要求。

目前,实现智能终端算力的最常用方式是在 SoC 芯片中内置 NPU 模块,即神经网络处理单元。这是专为物联网人工智能设计的处理器模块,用于加速神经网络的运算,解决传统芯片在神经网络运算时效率低下的问题,特别擅长处理视频、图像类的海量多媒体数据。

国内芯片厂商均在加大自研 NPU 能力,以把握 AI 浪潮。以阿里平头哥的含光 800 为例,其是一款面向数据中心 AI 应用的人工处理推理芯片,采用台积电12nm 制程,集成高达 170 亿颗晶体管。

含光 800 自研 NPU 架构为 AI 推理专门定制和创新,包括专有计算引擎和执行单元、192M 本地存储(SRAM)以及便于快速存取数据的核间通信,从而实现了高算力、低延迟的性能体验。含光 800 还支持主流的深度学习框架,包括 TensorFlow、MXNet、ONNX 等,能够以行业领先的性能和效率来处理推理任务。

除专门推出 NPU 推理芯片,国产 SoC 厂商也在加大 NPU IP 自研力度,以丰富和提升 SoC 人工智能处理能力。如瑞芯微目前已迭代了 4 代 NPU 的 IP,不断提升对神经网络模型的支持和效率,公司最新旗舰芯片 RK3588 支持 6 Tops 的NPU 算力,可以赋能各类 AI 场景,给复杂场景的本地离线 AI 计算、复杂视频流分析等应用提供了各种可能。

晶晨股份也基于在多媒体音视频领域的长期积累和技术优势,致力于叠加神经网络处理器、专用 DSP 等技术,通过深度机器学习和高速的逻辑推理/系统处理,并结合行业先进的 12nm 制造工艺,形成了多样化应用场景的人工智能系列芯片,公司的 A311D 系列人工智能芯片最高可支持 5Tops的 NPU 算力。

-

AI芯片

+关注

关注

17文章

1894浏览量

35102 -

边缘计算

+关注

关注

22文章

3103浏览量

49138 -

大模型

+关注

关注

2文章

2490浏览量

2865

原文标题:边缘域 AI 的“寒武大爆发”

文章出处:【微信号:AI_Architect,微信公众号:智能计算芯世界】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

英飞凌发布边缘AI软件新品牌DEEPCRAFT™

研华科技边缘AI平台荣获2024年IoT边缘计算卓越奖

RISC-V,即将进入应用的爆发期

NVIDIA IGX平台加速实时边缘AI应用

算力概念股寒武纪20cm涨停市值重回千亿

边缘AI需求爆发,边缘计算网关亟待革新

边缘AI网关,将具备更强大的计算和学习能力

主流边缘AI算法,在安防、零售、交通等领域的应用

边缘AI需求大爆发,恩智浦在安全连接和模拟电源方面有怎样的思考?

AI边缘盒子助力安全生产相关等场景

边缘域AI的“寒武大爆发”

边缘域AI的“寒武大爆发”

评论