来源:溪流之海洋人生

作者:陈友淦 许肖梅

多年来,从非相干水声通信到相干水声通信,直扩、跳频、OFDM、Turbo均衡、时间反转和自适应等各种理论和技术均被引入水声通信中,以期克服复杂多变海洋环境对水声通信信号的影响。但是,目前仍无法研制出一种能适用于各类海洋环境、可满足通用水声业务误码率、速率和距离等需求的水声通信机,更难以进行大规模水声通信组网应用、实现稳健可靠的海洋物联网。一个重要原因是,海洋环境大动态变化引起的水声信道复杂时-空-频变特性,使得传统各种理论和技术仍难以实时、合理、有效地与之进行良好的自适应匹配设计。近年来,人工智能技术在无线通信、大气、教育、医疗、金融和社会决策等各领域的快速发展,为突破水声通信所面临的传统技术瓶颈带来新思路。本文将对国内外人工智能技术在水声通信物理层和网络层中的应用探索进行梳理和总结。

一、人工智能技术

1956年,计算机科学家在达特茅斯会议提出了“人工智能”概念,其初衷在于利用机械工具代替人类进行某些简单枯燥的工作。随着机器学习、深度学习等人工智能一些子集的迅速发展,尤其是2015年以来,人工智能开始大爆发,主要原因有:①算力条件大幅提升,高性能GPU的广泛应用使得并行计算变得更快、更便宜、更有效,深度学习取得突破;②大数据的发展,无限拓展的存储能力和大数据的组合,使得图像数据、文本数据、交易数据、映射数据等全面海量爆发。深度学习作为机器学习中的一个新方向,其以更逼近人工智能的方式成为当前最主流的人工智能技术,是当今人工智能大爆炸的核心驱动。

图1给出了人工智能、机器学习和深度学习的发展关系。人工智能的研究经历了“推理-知识-学习”的不同发展阶段,机器学习是实现人工智能的一个重要途径。作为人工智能的一个重要分支,机器学习理论主要是设计和分析让计算机可自主“学习”的算法,即从数据中自动分析获得规律,并利用规律对未知数据进行预测的算法。按学习方式分,机器学习可分为:监督学习、非监督学习、半监督学习和强化学习。按算法分类,则可分为回归算法、决策树学习、贝叶斯方法、支持向量机、聚类算法、遗传算法、人工神经网络、深度学习、降低维度算法和集成学习等。需要强调的是,由于机器学习的范围非常庞大,有些算法很难明确归类到某一类;而对于有些分类而言,同一分类的算法也可以针对不同类型的问题。

图1 人工智能与机器学习、深度学习的关系

在人工智能的实现方式上,主要有计算机编程和模拟2种。目前,计算机编程仅能实现形式上的智能,而通过对人类或者某些生物的行为或思维方式的模拟则可以实现更高级的智能。例如,常见的直接受大自然启发而产生的人工智能算法(启发式算法)有:模拟退火、人工神经网络、遗传算法、进化规划、集群智能、强化学习和人工免疫系统等。以模拟自然界为核心思路的人工智能算法,在优化问题等领域得到了广泛应用,例如规划路线、设计方案等。

二、水声通信中的人工智能技术

根据人工智能技术发展的不同阶段,其在水声通信中的应用也由经典的智能算法(如模拟退火、集群智能中的蚁群算法等),逐步发展到强化学习中的Q-learning等机器学习算法,乃至深度神经网络等深度学习算法。相关人工智能算法紧紧围绕海洋环境动态变化、水声信道物理特性而展开。

⒈水声领域应用人工智能的主要思路

在水声领域应用人工智能技术,主要思路是结合水声信道窄带宽、大时延、强多途、大起伏、大动态变化、高噪声等固有的水声物理特性,选择合适的智能算法进行针对性地设计和改进,以求解决水声通信及组网存在的以下几个典型问题:

⑴水声传输的吸收衰减与窄带。

海水对声波的吸收衰减随频率升高而指数上升,因此水声通信的可用频率带宽很窄,通信速率低。比如,在几十到100km的远距离水声通信系统中,可用带宽不足1kHz。要想提高通信速率,就只能降低通信距离,这也是人工智能时代,在海洋物联网框架下,研制高频短距、宽带高速和节能便携水声节点,实现大规模高速水声通信组网观测和数据交互的主要技术背景依据;现在有研究毫米波水声通信技术(频率用150kHz~1.5MHz),但通信距离短,仅为几百米。

⑵水声传输的大时延、强多途与时空不确定。

声波在水中的低速传播造成水声数据传输的大时延特性,同一信号的声波从不同路径抵达接收端时的多途时延差异极为显著,在不同海洋环境(空间)条件下、在不同时间条件下,从毫秒级、百毫秒级到秒级皆有可能,这种不确定的大时延扩展,给接收端数据处理和组网协议设计均带来极大困难。同时,多途还会造成信号的某些频率被增强而某些频率被削弱的频率选择性衰落现象,且不同空间位置结果差异极大,空间选择性衰落现象也极不确定。

为此,多途时延扩展是时空不确定条件下信道的时间扩展,水声信道存在“大时延扩展不确定,强频域起伏不确定”现象。

⑶水声传输的多普勒、大起伏与时空不确定。

水下通信设备收发端之间由于波浪、湍流、潮汐等因素会不可避免地引起漂移,同时水下航行器也会有相对运动,该相对运动速度一般是每秒几米数量级,而由于声波在水中的低速传播,两者比值在10-2~10-3,多普勒频移因子数量级约为10-3,因此,水声数据传输的多普勒扩展效应显著。同时,多普勒扩展还会造成信号的某些时刻被增强而某些时刻被削弱的时域包络大起伏问题,即时间选择性衰落现象,且不同海洋环境(空间)条件下、不同时间条件下,波浪、涌浪、湍流、内波的不确定性会造成多普勒扩展(频率扩展)的不确定性。

为此,多普勒扩展是时空不确定条件下信道的频率扩展,水声信道存在“大频率扩展不确定,强时域包络起伏不确定”现象。

可见,水声信道固有的时延-多普勒双扩展现象均具有时空不确定性,这也是迄今为止水声信道尚无统一的标准模型的原因。利用强化学习对水声信道进行自适应学习,便于水声通信系统参数设置,实现基于强化学习的自适应编码调制,是人工智能技术突破水声通信技术瓶颈的关键所在。

⑷海洋噪声干扰严重。

海洋环境中的噪声来源主要包括潮汐、洋流、海面波浪、地震活动、海洋生物群体和交通航运等等。由于声波在水中传播的共有属性,这些噪声的频段往往与水声通信设备所用频段存在交叉重叠的现象。因此,水声信号的接收信噪比往往比较低,这是利用深度神经网络等人工智能技术解决水声通信接收机信号处理难题的出发点。

⑸水声通信网所需的高处理能力、低功耗、便携的水声节点研制需求。

应用于大规模水声通信组网的节点长期部署在水下,对其充电或更换电池的成本极高,为此,在满足高处理能力、便携的前提下,低功耗是进行水声节点接收机信号处理和水声通信组网协议设计要考虑的重要因素。例如,在水声通信组网协议中应用人工智能技术时,常把高性能指标作为约束条件,以功耗为代价函数,建立优化模型,通过集群智能、强化学习等人工智能技术,获得最低功耗目标函数下的参数设置,作为网络最优参数设置。

⑹水声通信及组网的敏感性与保密性需求。

由于水声通信及组网在社会、经济、科学和军事等方面均有重要应用价值,海洋物联网框架下,海洋观测中的水声数据具有一定的敏感性和保密性。利用强化学习进行水声物理层防攻击认证、水声网络层防干扰攻击等,均是人工智能技术在水声通信及组网安全方面的有益探索。

⒉水声领域应用人工智能相关算法

根据上述水声信道特性和水声数据传输特点,不少改进了的人工智能算法,已被尝试应用于水声通信的不同场景和目标。

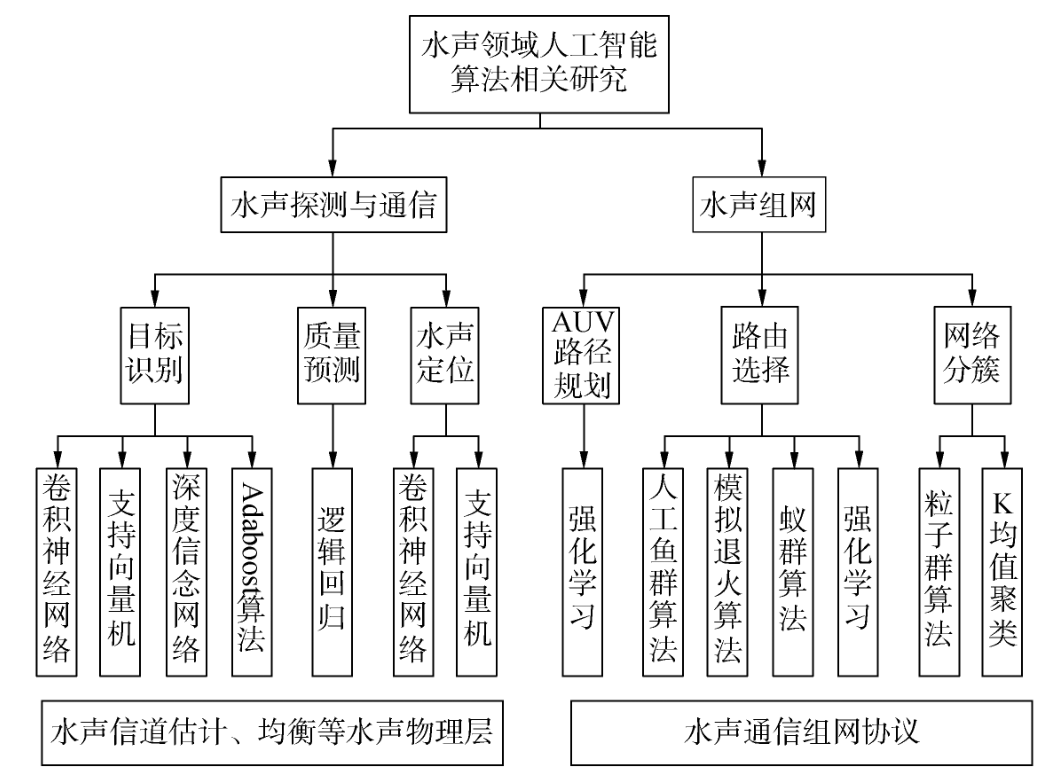

图2梳理了目前水声领域应用人工智能相关算法的部分研究情况。

图2 水声领域人工智能算法相关研究

从应用对象看,人工智能技术在水声通信中的应用可大致分为2类:①以水声探测和节点间通信为主要应用场景的物理层方面,包括水声目标识别、水声定位、水声信道估计、水声信道均衡、水声自适应调制、水声通信质量预测等;②以水声通信组网为主要应用场景的网络层方面,包括以低功耗为主要目标的水声网络路由设计、网络拓扑分簇、节点功率分配、AUV辅助的水声数据搜集路径规划和水声网络安全等。

从时间角度看,2010年以前,水声通信中应用人工智能技术的研究比较少,该阶段人工智能算法通常被视为一种性能较好的优化算法而应用于解决水声通信领域的某个具体问题,例如在中国知网中,有利用支持向量机进行水声信道均衡、水下目标识别等文献,但尚未体现人工智能的巨大潜力;近年来,尤其是2017-2018年以来,以强化学习、深度学习、深度神经网络为主要特征的新一代人工智能技术,开始被大量探索和应用于水声调制信号分类、水声接收机处理、水声自适应调制、水声通信网络协议、水声网络服务质量等方面,显示出出色的性能增益;同时,业界已开始超前部署海洋物联网框架下水声通信网络与人工智能相结合的策略方案。

目前,水声通信中应用新一代人工智能技术的研究正在兴起,相关文献尚不算多。

三、水声通信物理层的人工智能技术

⒈水声目标识别

Roberts等根据采集到的9种36条不同鱼类、每条鱼200~300个的回声数据,利用级联两层支持向量机设计了特征融合、决策融合和协作融合的算法,无需对视图几何形状进行假设,即可实现不同鱼类的多视图宽带声学分类。研究结果表明,相对于单一视图的声学分类方法,该方法错误率下降了50%以上。

McQuay等利用深度卷积神经网络,采用支持向量机对深度学习特征集进行处理,实现了对鲸鱼发声信号的自动识别。对一年时间内在加拿大海洋观测网搜集到的5573个鲸鱼发声事件、累计28685min的数据进行实验测试,结果表明,采用深度特征学习方法的平均识别准确率达到98.69%(两类)和94.48%(多类)。

杨士莪等采用支持向量机对水面舰船辐射噪声目标信号识别进行了研究,提出差分进化粒子群混合算法,通过对惩罚因子和核函数宽度参数的优化选取,达到优化系统支持向量机模型的目的。海试数据表明,在训练样本占实验数据总数分别为87.5%、75.0%、66.7%和50.0%的情况下,分类精度依次为100%、88.33%、86.25%和72.5%,与网格搜索方法比,整体有了显著提高。

Chen等提出基于深度信念网络模型和堆叠降噪自编码器模型以识别不同水下目标的辐射噪声;杨宏晖等提出基于加权样本与特征选择的机器学习自适应增强(AdaBoost)与支持向量机集成相结合的算法,2组水声目标数据测试表明,在样本数量分别减少到45%和50%、特征数量分别减少到33%和51%的情况下,该算法仍可获得更高的分类准确率。

此外,胡长青、方世良和童峰等分别采用支持向量机对水下声呐目标识别、舰船噪声识别和水声调制信号识别进行了研究;蒋佳佳等基于连续小波变换和人工神经网络对抹香鲸和长鳍领航鲸分类进行了研究;Ding等采用深度神经网络对水声通信信号调制分类进行了研究。

⒉水声目标定位

Fischell等利用模拟的双基地散射场数据来训练支持向量机回归模型,然后应用于马萨诸塞州湾实验收集的7~9kHz线性调频啁啾水声数据,进行水下目标方位角估计,估计差异与相对源定位方法实验观察的结果一致,效果良好;Pinheiro等则基于支持向量机与自相关核回归方法,与AUV导航系统耦合,降低了定位算法对反射声波或水声信道起伏特性的敏感性,改善了定位精度。

Houégnigan等利用深度神经网络设计距离估计算法,实现了对单一传感器小型阵列或小孔径拖曳阵列的水下定位。海试结果表明,在典型值为300m左右但最远可达8km的范围内,对采集的869个样本,采用预训练的浅层神经网络和深度神经网络2种方法,平均误差分别为4.3%和3.5%。

程恩等在传统锚节点选择算法基础上,考虑水声通信开销、节点剩余能量、声线传播弯曲特性等影响,引入粒子群算法建立锚节点优化机制,通过迭代计算得出最优传感器节点组合以提高定位精度。仿真结果表明,该算法计算量小、收敛速度快、定位精度高,可有效提高节点能量利用、平衡定位性能和能量利用效率。潘翔等还采用支持向量机技术对水下目标定位进行了研究。

⒊水声信道估计与均衡

Mahmutoglu等提出了一种基于粒子群算法的水声通信自适应决策反馈均衡器,不依赖于信道特性,收敛速度快,兼顾高通信性能和低计算复杂度;李春国等则提出一种改进的粒子群优化算法,可同时估计每条水声传播路径的多普勒尺度、时延和幅值等参数,在估计精度和计算复杂度两方面均优于匹配追踪方法和分数傅里叶变换方法。

付晓梅、王学田等针对水声OFDM通信系统的信道估计,提出2种基于深度神经网络的信道估计器,利用接收到的导频符号和正确的信道脉冲响应对深度神经网络模型进行训练,然后估计出信道脉冲响应。实验结果表明,该方法在误码率和归一化均方误差方面均优于最小二乘法和反向传播神经网络法。

李振兴、赵俊渭等研究了基于支持向量机的水声信道盲均衡算法,非常适合于水声触发通信和快衰落水声信道,但该算法通过二次规划迭代完成收敛,计算量很大;童峰等则提出先利用支持向量机进行盲均衡器权系数初始化,再切换至运算量较小的常数模算法,湖试结果表明,时变水声信道条件下,性能优于经典支持向量机盲均衡算法。

此外,郭业才、王卫等还针对水声信道研究了基于平衡正交多小波变换的模糊神经网络盲均衡算法、改进遗传优化的正交小波盲均衡算法。

⒋水声自适应调制通信技术

Wang等针对长期运行的定期点对点水声通信系统,提出将水声自适应传输问题建模为部分可观测的马尔可夫决策过程,并基于强化学习框架开发了在线算法,以递归方式估计水声信道模型参数,跟踪水声信道动态,实现使系统长期成本最小化的最佳发射参数设置。湖试结果表明,相对于理想非因果信道状态信息的基准方法,所提方法可实现良好的性能。

Song等提出了一种基于强化学习Dyna-Q算法的水声自适应调制通信策略,采用有效信噪比作为水声信道状态参数,根据数据通信的真实情况与仿真经验,预测信道状态和通信吞吐量,然后利用该结果结合接收端返回的信道状态选择调制参数,使通信吞吐量最大化。仿真结果表明,与直接反馈有效信噪比方案比,Dyna-Q算法可取得更高的通信吞吐量。

苏为等基于信息服务质量要求、先前的传输质量和能量消耗等网络感知状态信息,提出了一种基于强化学习的水声通信自适应调制编码方案,实现动态选择水声通信系统调制和编码策略。水池和海试数据表明,与基准方案比,提高了吞吐量,并以更少的能耗降低了误码率。

此外,Alamgir等则在自适应调制编码基础上,使用支持向量机、K最近邻算法、伪线性判别法和增强回归树法进行调制编码分类研究,进一步提升了水声自适应调制编码效果。

⒌水声通信质量预测

Kalaiarasu等提出采用基于逻辑回归机器学习模型研究水声通信性能的时空变化,研究风速、潮汐、流速等环境因素以及水声通信设备参数因素,对量化的水声通信数据包传输成功率的性能影响。仿真结果表明,在给定环境条件参数和水声设备参数条件下,所提模型可预测水声通信性能的时空变化。

该方面研究,目前尚较少见相关文献报道,但这种以海洋环境要素数据驱动的机器学习模型研究,对发展水声大数据、利用深度学习进行水声通信质量预测,选择最优参数配置具有重要意义。

总体而言,在水声通信物理层方面,水声目标识别、水声目标定位和水声信道估计与均衡等研究,兼用了传统智能算法和深度学习等新型人工智能算法;而水声自适应调制技术和水声通信质量预测等研究,则是随深度学习等新型人工智能技术的发展而成为可能的新探索方向,是水声领域发挥人工智能技术的潜力所在。如张友文等还研究了基于深度学习的时变水声信道单载波通信接收机处理技术。结合水声信道特性进行研究,是人工智能技术在水声通信物理层应用获得突破的关键所在。

四、水声通信网络层的人工智能技术

下面以水声通信组网为应用场景,介绍人工智能技术在水声通信网络层方面的研究成果。

⒈水声网络路由协议

Xu等提出了一种基于多种群萤火虫算法的水声通信网络路由方案,设计了3种萤火虫协调规则,在建立、选择和优化路由时结合了各水下传感器节点的数据相关性和采样率。仿真结果表明,与基于向量转发、分布式水下聚类方案比,该方案在数据包交付比率、能量消耗和网络吞吐量等方面均可取得较好的性能。

陈友淦等提出在水声通信网络中,分别将蚁群算法、人工鱼群算法融入水声协作通信技术进行水声路由节点选择。仿真结果表明,所提算法可利用蚁群算法、人工鱼群算法寻找全局最优的能力,得到一种使系统总能耗最低的路由线路,同时获得协作增益和集群智能算法增益,进一步延长了水声通信网络的生命周期。

Li等通过结合人工鱼群算法中的拥挤因子和蚁群算法中的伪随机路由选择策略,提出了一种人工鱼群与蚁群混合的算法。仿真结果表明,该混合算法同时吸收了2种算法的优势,避免了路由算法陷入局部优化和停滞,同时加快了路由收敛速度,尤其适用于大规模水声通信网络的应用场景。

Fei、Plate等将强化学习中的Q-learning算法引入到水声通信网络路由选择中,节点通过存储其直接邻居节点的路由信息(Q值)来计算路由决策。仿真结果表明,由于Q值估计考虑了水声节点的能量消耗以及相邻节点之间的剩余能量分布,可优化网络总能量消耗,网络寿命比基于向量转发的方法平均寿命延长20%,若考虑结合水下节点运动的优化选择,则可进一步提升性能。

此外,Mitchell等提出将Q-learning算法与ALOHA协议相结合的介质访问控制方法,以有效使用水声信道;Javaid等提出基于Q-learning的高效平衡型数据搜集路由协议,以解决水声通信网络路由转发的能量洞问题;魏晓辉等则提出一种基于递归神经网络的水声监测网络框架,放弃自动重传机制,以减少长端到端延迟和能量消耗。

⒉水声网络拓扑分簇

Makhoul等提出了一种基于单向方差分析模型增强型K-means算法的2层数据融合聚类方法,以处理水声通信网络节点之间的空间相似性问题,协调节点间的数据传输,以减少网络内部通信、降低能量消耗,获得聚类效益。利用布放于印度洋5000×5000m2范围内的240个传感器节点所搜集的数据进行仿真分析,结果表明,与前缀频率滤波法比,所提算法可降低70%的能量消耗。

LI、ZHANG等提出了一种基于粒子群优化的低复杂度、可并行处理实现全局最优的聚类算法,该算法的粒子适应度函数设计考虑了水声通信网络的簇头能量、簇头负荷和簇范围3个优化目标。仿真结果表明,该算法可有效改善水声通信网络负载均衡;相比于LEACH算法在运行60轮后网络即停止工作,所提算法可让网络工作持续运行144轮时间,有效延长了网络生存期。

⒊水声节点功率分配

Dobre等针对全双工水声中继能量捕获网络,考虑中继节点从海洋环境中捕获的能量、节点剩余电量、信道状态信息和干扰水平等过去信息和当前信息,提出采用强化学习优化策略得到每个时间段的最优发射功率,以实现端到端长期总效率最大化的目标。仿真结果表明,在捕获能量不足的情况下,所提功率分配策略比在线贪婪功率分配策略具有更高的累加率。

冯义志等针对水声多载波码分多址通信网络,提出了一种基于改进粒子群算法的多目标功率控制方案,通过设计一个由接收机功耗和信噪比组成的适应度函数,解决了不同节点到基站距离不相同造成的远近效应问题,同时有效降低了节点功耗,改进了系统误码率性能。

金志刚等针对正交频分多址多跳水声通信网络,提出使用粒子群算法对其子信道进行功率分配。仿真结果表明,与基于握手的介质访问控制协议相比,所提方案降低了节点间数据冲突导致的数据包丢失概率;在低功耗情况下,有效提高了网络吞吐量,降低了网络平均端到端时延。

⒋AUV辅助的水声数据搜集路径规划

姜春晓等针对海洋物联框架下水声通信网络利用AUV进行数据搜集的问题,提出采用基于蚁群算法和遗传算法2种近似最优启发式算法,以降低AUV路径规划的计算复杂度;吴杰宏等则提出一种距离演化非线性粒子群优化算法,可避开涡流方向障碍物,能耗比线性粒子群优化算法降低了1.049×107J。

韩光洁等针对水声通信网络中利用AUV进行数据搜集的问题,提出了一种基于强化学习的区域划分事件动态竞争数据搜集算法,以解决多任务分配和负载均衡问题。仿真结果表明,该算法在降低端到端传输时延的同时,可显著降低传输能耗,保证负载均衡。

⒌水声网络安全

肖亮等在文献中,提出了一种基于强化学习的物理层认证来检测水声通信网络中的欺骗攻击,与基准物理层认证比,提高了欺骗检测准确性与网络效用;在有关文献中提出了一种基于强化学习Q-learning水声通信网络抗干扰方法,在未知干扰器信道增益情况下,各水声传感器节点自行选择发射功率,以实现对动态环境的有效抗干扰;在有关文献中,则进一步提出一种基于深度Q网络的抗干扰攻击水声数据传输框架,应用强化学习控制最优传输功率,并用水声节点移动性控制解决水声网络中存在的干扰攻击,水池实验表明,该方法可进一步降低误码率,对抗反应性干扰。同时,韩光洁等也开展了利用支持向量机建立水声通信网络节点传输信任模型等水声网络安全方面的研究。

总体而言,在水声通信网络层方面,无论是水声网络路由协议还是组网分簇、节点功率分配,或是AUV辅助的路径规划、网络安全等研究,传统智能算法或深度学习等新兴人工智能技术,均是作为优化算法,从水声组网的不同应用问题而展开研究。比如,Sundarasekar等还开展了基于深度学习和离散时间随机控制过程的水声通信网络自适应能量感知节能与服务质量研究。紧紧围绕水声组网的特殊技术难题进行研究,是人工智能技术在水声通信网络层发挥潜力的关键所在。

五、结论

近二十年来,人工智能技术在水声通信与水声通信组网中的研究,从利用支持向量机进行水声目标识别定位、水声信道估计与盲均衡,到利用集群智能算法进行水声通信网络路由优化,再到利用深度学习、深度神经网络进行水声接收机处理、节点功率分配和水声网络安全设计,融合程度越来越深,相关研究方兴未艾。

未来,人工智能与水声通信进行下一步交叉研究的方向,主要包括:⑴针对于海洋环境大动态变化的复杂水声信道响应问题,研究融合人工智能算法在水声通信中的应用;⑵针对水声通信样机与海洋环境的普适性难题,研究海洋环境要素数据驱动的深度学习自适应技术;⑶针对海试成本高、海试数据标准不统一问题,研究小样本学习或样本数据量的增广设计;⑷针对水声节点功耗受限问题,研究兼具学习效果好、低复杂度的深度学习技术。

审核编辑:汤梓红

-

gpu

+关注

关注

28文章

4830浏览量

129776 -

人工智能

+关注

关注

1800文章

48083浏览量

242151 -

机器学习

+关注

关注

66文章

8460浏览量

133412 -

水声通信

+关注

关注

0文章

18浏览量

10768 -

深度学习

+关注

关注

73文章

5527浏览量

121875

原文标题:陈友淦、许肖梅:人工智能技术在水声通信中的研究进展

文章出处:【微信号:AI智胜未来,微信公众号:AI智胜未来】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

人工智能是什么?

百度人工智能大神离职,人工智能的出路在哪?

【免费名额30个】手把手教你快速学习和应用人工智能技术

人工智能技术及算法设计指南

2019年人工智能技术峰会落幕,大咖演讲PPT火热出炉!

路径规划用到的人工智能技术

目前人工智能教育研究最深入最经典的白皮书:德勤《全球人工智能发展白皮书2019》精选资料分享

【开源硬件系列04期】AI人工智能技术带给EDA的机遇和挑战(文中含回放+课件)

《移动终端人工智能技术与应用开发》人工智能的发展与AI技术的进步

《移动终端人工智能技术与应用开发》+快速入门AI的捷径+书中案例实操

《移动终端人工智能技术与应用开发》+理论学习

人工智能技术在军事情报领域的应用背景

人工智能技术在水声通信中的研究进展

人工智能技术在水声通信中的研究进展

评论