在大型基础模型的推动下,人工智能的发展近来取得了巨大进步,尤其是 OpenAI 的 GPT-4,其在问答、知识方面展现出的强大能力点亮了 AI 领域的尤里卡时刻,引起了公众的普遍关注。

GPT-4V (ision) 是 OpenAI 最新的多模态基础模型。相较于 GPT-4,它增加了图像与语音的输入能力。该研究则旨在通过案例分析评估 GPT-4V (ision) 在多模态医疗诊断领域的性能,一共展现并分析共计了 128(92 个放射学评估案例,20 个病理学评估案例以及 16 个定位案例)个案例共计 277 张图像的 GPT-4V 问答实例(注:本文不会涉及案例展示,请参阅原论文查看具体的案例展示与分析)。

-

ArXiv 链接:https://arxiv.org/abs/2310.09909

-

百度云下载地址:https://pan.baidu.com/s/11xV8MkUfmF3emJQH9awtcw?pwd=krk2

-

Google Drive下载地址:https://drive.google.com/file/d/1HPvPDwhgpOwxi2sYH3_xrcaoXjBGWhK9/view?usp=sharing

总结而言,原作者希望系统地评估 GPT-4V 如下的多种能力:

-

GPT-4V 能否识别医学图像的模态和成像位置?识别各种模态(如 X 射线、CT、核磁共振成像、超声波和病理)并识别这些图像中的成像位置,是进行更复杂诊断的基础。

-

GPT-4V 能否定位医学影像中的不同解剖结构?精确定位图像中的特定解剖结构对识别异常、确保正确处理潜在问题至关重要。

-

GPT-4V 能否发现和定位医学图像中的异常?检测异常,如 肿瘤、骨折或感染是医学图像分析的主要目标。在临床环境中,可靠的人工智能模型不仅需要发现这些异常,还需要准确定位,以便进行有针对性的干预或治疗。

-

GPT-4V 能否结合多张图像进行诊断?医学诊断往往需要综合不同成像模态或视图的信息,进行整体观察。因此探究 GPT-4V 组合和分析多图信息的能力至关重要。

-

GPT-4V 能否撰写医疗报告,描述异常情况和相关的正常结果?对于放射科医生和病理学家来说,撰写报告是一项耗时的工作。如果 GPT-4V 在这一过程中提供帮助,生成准确且与临床相关的报告,无疑将提高整个工作流程的效率。

-

GPT-4V 能否在解读医学影像时整合患者病史?患者的基本信息和既往病史会在很大程度上影响对当前医学影像的解读。在模型预测过程中如果能综合考虑到这些信息去分析图像将使分析更加个性化,也更加准确。

-

GPT-4V 能否在多轮交互中保持一致性和记忆性?在某些医疗场景中,单轮分析可能是不够的。在长时间的对话或分析过程中,尤其是在复杂的医疗环境中,保持对数据认知的连续性至关重要。

原论文的评估涵盖了 17 个医学系统,包括:中枢神经系统、头颈部、心脏、胸部、血液、肝胆、肛肠、泌尿、妇科、产科、乳腺科、肌肉骨骼科、脊柱科、血管科、肿瘤科、创伤科、儿科。

图像来自日常临床使用的 8 种模态,包括:X 光、计算机断层扫描 (CT)、磁共振成像 (MRI)、正电子发射断层扫描 (PET)、数字减影血管造影 (DSA)、 乳房 X 射线照相术、超声波检查和病理学检查。

论文指出,虽然 GPT-4V 在区分医学影像模态和解剖结构方面表现出很强的能力,但在疾病诊断和生成综合报告方面却仍面临巨大挑战。这些发现突出表明,虽然大型多模态模型在计算机视觉和自然语言处理方面取得了重大进展,但仍远未达到有效支持真实世界的医疗应用和临床决策的要求。

测试案例挑选

原论文的放射学问答来自于 Radiopaedia,图像直接从网页下载,定位案例来自于多个医学公开分割数据集,病理图像则来自于 PathologyOutlines 。在挑选案例时作者们全面的考虑了如下方面:

-

公布时间:考虑到 GPT-4V 的训练数据极有可能异常庞大,为了避免所选到的测试案例出现在训练集中,作者只选用了 2023 年发布的最新案例。

-

标注可信度:医疗诊断本身具有争议和模糊性,作者根据 Radiopaedia 提供的案例完成度,尽量选用完成度大于 90% 的案例来保证标注或诊断的可信程度。

-

图像模态多样性:在选取案例时,作者尽可能地展示 GPT-4V 对于多种成像模态的响应情况。

在图像处理时作者也做了如下规范化以保证输入图像的质量:

-

多图选择:考虑到 GPT-4V 支持的最大图像输入上限为 4,但部分案例会有超过 4 张的相关图像,首先作者在选取案例时会尽可能避免这种情况,其次在不可避免地遇到这种案例时,作者会根据 Radiopaedia 提供的案例注释挑选最相关的图像。

-

截面选择:大量的放射图像数据为 3D(连续多帧二维图像)形式,无法直接输入 GPT-4V,必须挑选一个最有代表性的截面代替完整的 3D 图像输入 GPT-4V。根据 Radiopaedia 的案例上传规范,放射医生在上传 3D 图像时被要求选择一个最相关的截面。作者们利用了这一点,选用了 Radiopaedia 推荐的轴截面替代 3D 数据进行输入。

-

图像标准化:医疗图像的标准化设计窗宽窗位的选择,不同的视窗会突出不同的组织,作者们使用的 Radiopaedio 案例上传时放射专家所选择的窗宽窗位输入图像。对于分割数据集而言,原论文则采用了 [-300,300] 的视窗,并作 0-1 的案例级的归一化。

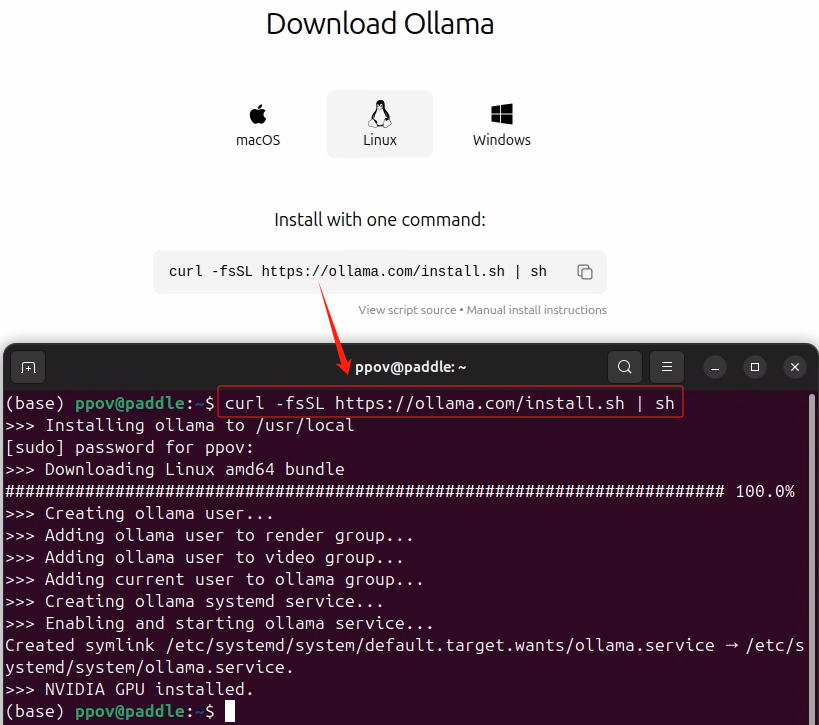

原论文的测试均使用了 GPT-4V 的网页版,第一轮问答用户会输入图像,然后展开多轮的问答。为了避免上下文的互相影响,对于每次新的案例,都会新建一个问答窗口进行问答。

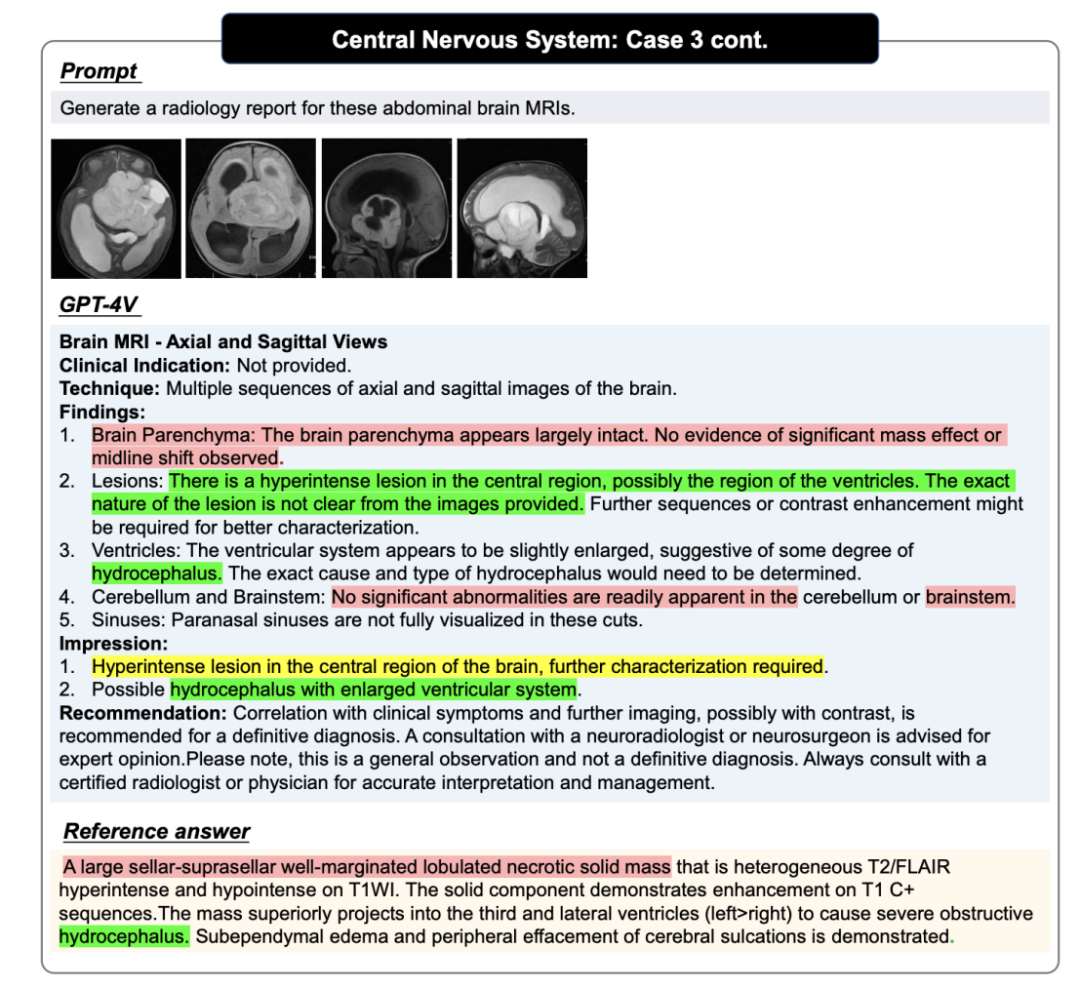

GPT-4V 问答案例,图中红色代表错误,黄色代表不确定,绿色代表正确,Reference 中的颜色则代表对应判断的依据,未标记颜色的句子需要读者自行判断正确性,更多案例以及案例分析请参考原论文

GPT-4V 问答案例,图中红色代表错误,黄色代表不确定,绿色代表正确,Reference 中的颜色则代表对应判断的依据,未标记颜色的句子需要读者自行判断正确性,更多案例以及案例分析请参考原论文

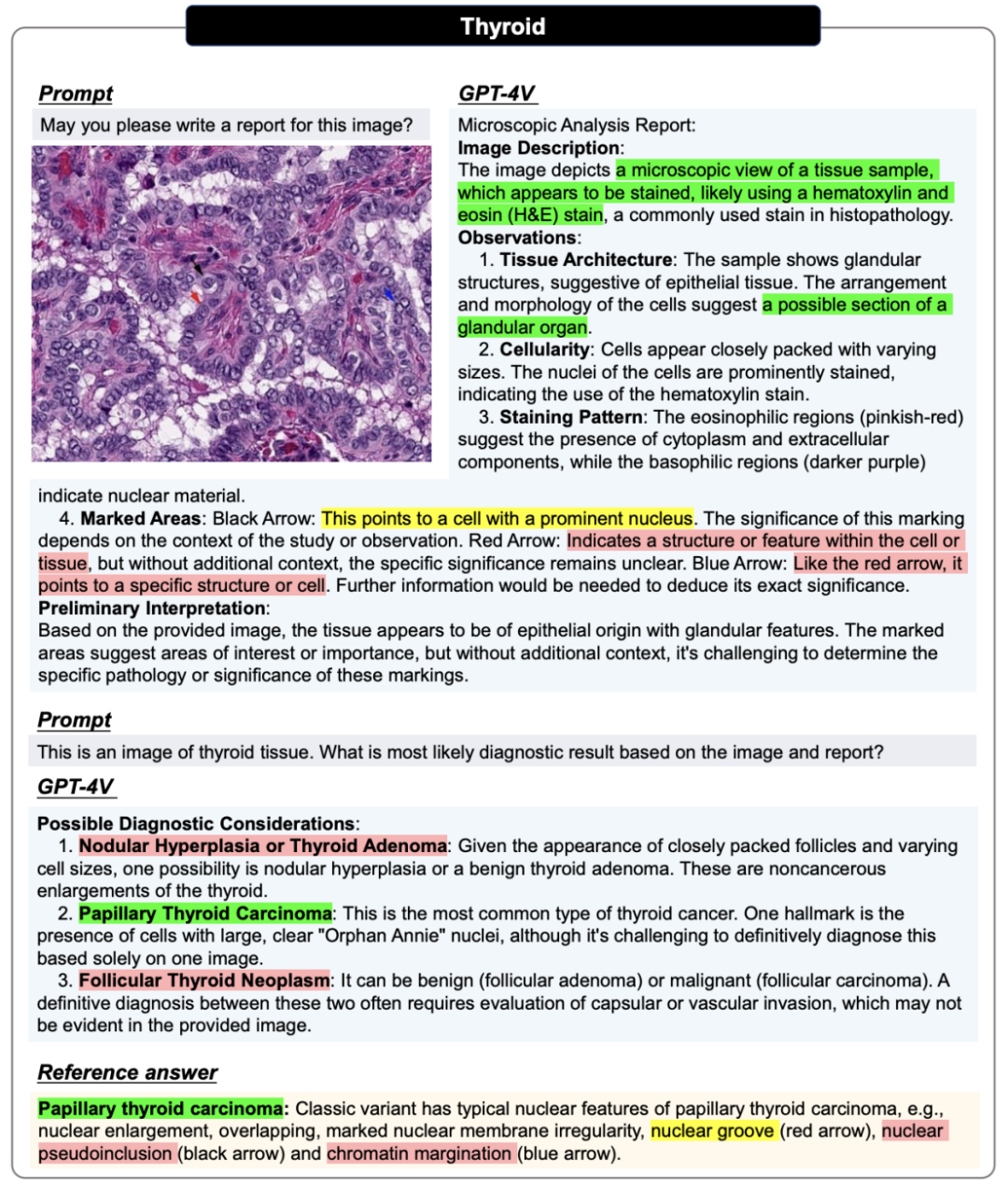

在病理评估中,所有图像都会进行两轮对话。第一轮询问能否仅根据输入图像生成报告。这一轮的目的是评估 GPT-4V 能否在不提供任何相关医疗提示的情况下识别图像模态和组织来源。在第二轮中,用户会提供正确的组织来源,并询问 GPT-4V 是否能根据病理图像及其组织来源信息做出诊断,希望 GPT-4V 能修改报告并提供明确的诊断结果。

病理图像的案例展示,更多案例以及案例分析请参考原论文

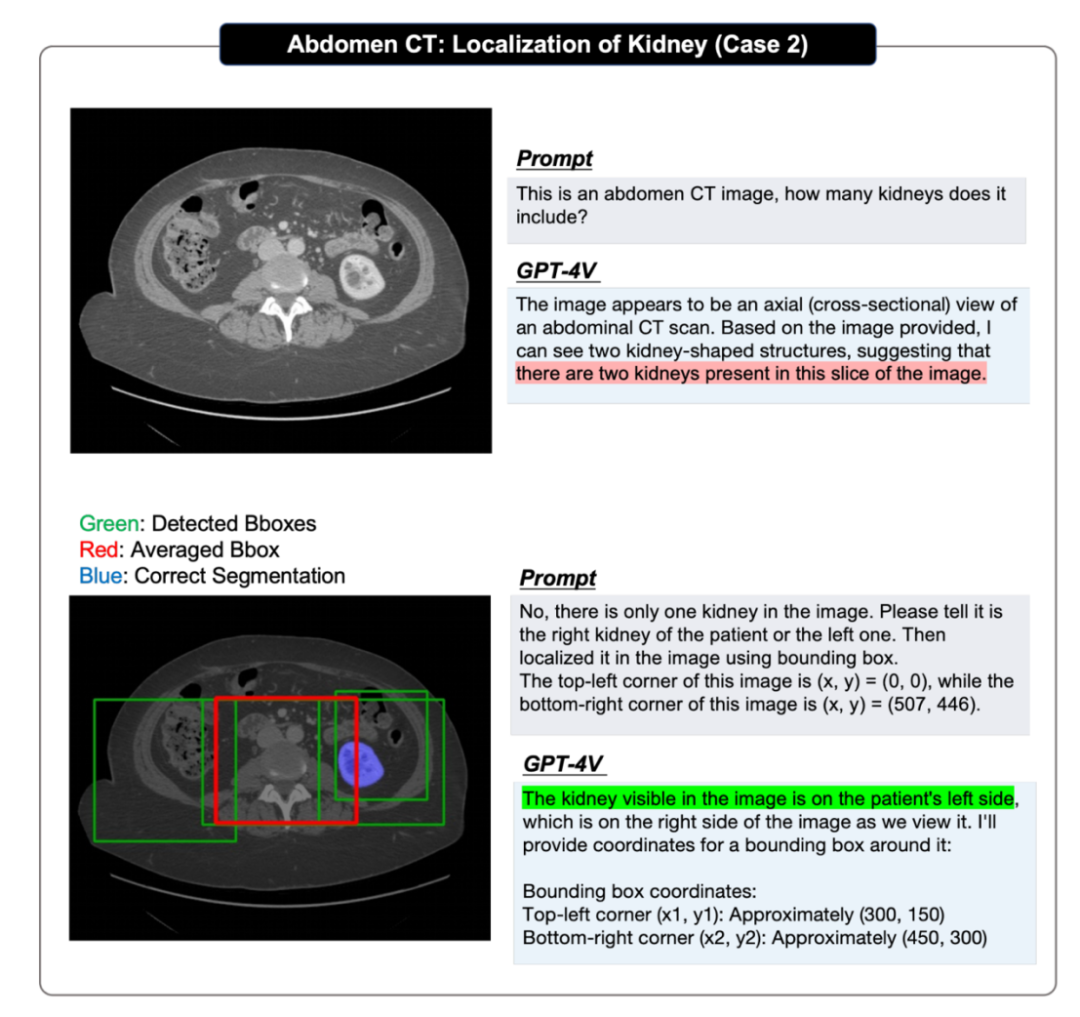

在定位评估中,原论文采取了循序渐进的方式:首先测试 GPT-4V 是否能识别出所提供图像中目标的存在;然后要求它根据图像左上角为(x,y)=(0,0)和右下角为(x,y)=(w,h)生成目标的边界框坐标,并对每个单一定位任务重复评估多次,以获得至少 4 个预测边界框,计算它们的 IOU 分数,并选出最高的一个来证明其上限性能;然后得出平均边界框,计算 IOU 分数,以证明其平均性能。

定位问答的案例展示,更多案例以及案例分析请参考原论文

测评中的局限性

当然原作者也提到了一些测评中的不足与限制:

1. 只能进行定性而非定量的评估

鉴于 GPT-4V 只提供在线网页界面,只能手动上传测试用例,导致原评估报告在可扩展性方面受到限制,因此只能提供定性评估。

2. 样本偏差

所选样本均来自在线网站,可能无法反映日常门诊中的数据分布情况。尤其是大多数评估病例都是异常病例,这可能会给评估带来潜在偏差。

3. 注释或参考答案并不完整

从 Radiopaedia 或者 PathologyOutlines 网站上获得的参考描述大多没有结构,也没有标准化的放射学 / 病理学报告格式。特别是,这些报告中的大部分主要侧重于描述异常情况,而不是对病例进行全面描述,并不能直接作为完美的回复简单对比。

4. 只有二维切片输入

在实际临床环境中,包括 CT、MRI 扫描在内的放射图像通常采用 3D DICOM 格式。然而,GPT-4V 最多只能支持四张二维图像的输入,所以原文在测评时只能输入二维关键切片或小片段(用于病理学)。

总之,尽管评估可能并不彻底详尽,但原作者们相信,这一分析仍旧可以为研究人员和医学专业人员提供了宝贵的见解,它揭示了多模态基础模型的当前能力,并可能激励未来建立医学基础模型的工作。

重要观察结果

原测评报告根据测评案例,概括了多个观察到的 GPT-4V 的表现特点:

放射案例部分

作者们根据 92 个放射学评估案例和 20 个定位案例得出如下观察结果:

1. GPT-4V 可以辨识出医疗图像的模态以及成像位置

对于大多数图像内容的模态识别、成像部位判定以及图像平面类别判定等任务,GPT4-V 都表现出了良好的处理能力。例如,作者们指出 GPT-4V 能很容易区分核磁共振、CT、X 光等各种模态;判断图像所描述的人体具体部位;判断出核磁共振图像的轴位、失状位和冠状位等。

2. GPT-4V 几乎无法做出精确的诊断

作者们发现:一方面,OpenAI 似乎设置了安全机制,严格限制了 GPT-4V 做出直接诊断;另一方面,除了针对非常明显的诊断案例,GPT-4V 的分析能力较差,仅局限于列举出可能存在的一系列疾病,而不能给出较为精确的诊断。

3. GPT-4V 可以生成出结构化的报告,但是内容大部分并不正确

GPT-4V 在绝大多数情况下都能生成较为标准的报告,但作者们认为,相比于整合程度更高且内容更灵活的手写报告,在针对多模态或多帧图像时,它更倾向于逐图描述且缺乏综合能力。因此内容大部分参考价值较小且缺乏准确性。

4. GPT-4V 可以辨识出医学图像中的标记以及文本注释,但并不能理解其出现在图像中的意义

GPT-4V 展现出较强的文本识别、标记识别等能力,并且会尝试利用这些标记进行分析。但作者们认为,其局限性在于:其一,GPT-4V 总是会过度利用文本和标记且图像本身成为次要参考对象;其二,它鲁棒性较低,常常会误解图像中的医学注释和引导。

5. GPT-4V 可以辨识出医疗植入器械以及它们在图像中的位置

在大多数案例中,GPT4-V 都能正确识别到植入人体的医疗设备,并较为准确地定位它们的位置。并且作者们发现,甚至在一些较为困难的案例中,可能出现诊断错误,但判断医疗设备识别正确的情况。

6. GPT-4V 面对多图输入时会遇到分析障碍

作者们发现,在面对同一模态的不同视角下的图像时,GPT-4V 尽管会展现出相比于进输入单张图的更好的分析能力,但仍然倾向于分别对每张视图进行单独的分析;而在面对不同模态的图像混合输入时,GPT-4V 更难得出综合了不同模态信息的合理分析。

7. GPT-4V 的预测极易受到患者疾病史的引导

作者们发现是否提供患者疾病史会对 GPT-4V 的回答产生较大影响。在提供疾病史的情况下,GPT-4V 常常会将其作为关键点,对图中的潜在异常做出推断;而在不提供疾病史的情况下,GPT-4V 则会更倾向于将图像作为正常案例进行分析。

8. GPT-4V 并不能在医学图像中定位到解剖结构和异常

作者们认为 GPT-4V 定位效果较差主要表现为:其一,GPT-4V 在定位过程中总是会得到远离真实边界的预测框;其二,它在对同一幅图的多轮重复预测中表现出显著的随机性;其三,GPT-4V 显示出了明显的偏置性,例如:脑部 MRI 图像中小脑一定位于底部。

9. GPT-4V 可以根据用户的多轮交互,改变它的既有回答。

GPT-4V 可以在一系列的互动中修改其响应,使之正确。例如,在文中所示的例子中,作者们输入了子宫内膜异位症的 MRI 图像。GPT-4V 最初错误地将盆腔 MRI 分类为膝关节 MRI,从而得到了一个不正确的输出。但用户通过与 GPT-4V 的多轮互动对其进行纠正,最终做出了准确的诊断。

10. GPT-4V 幻觉问题严重,尤其倾向将患者叙述为正常即使异常信号极为显著。

GPT-4V 总是生成出结构上看上去非常完整详实的报告,但其中的内容却并不正确,很多时候即使图像异常区域明显它仍旧会认为患者正常。

11. GPT-4V 在医学问答上不够稳定

GPT-4V 在常见图像和罕见图像上的表现差异巨大,在不同的身体系统方面也展现出明显的性能差别。另外,对同一医学图像的分析可能会因更改 prompt 而产生不一致的结果,例如,如,GPT-4V 在 “ What is the diagnosis for this brain CT?” 的 prompt 下最初判断给定的图像为异常,但后来它生成了一个认为同一图像为正常的报告。这种不一致性强调了 GPT-4V 在临床诊断中的性能可能是不稳定和不可靠的。

12. GPT-4V 对医疗领域做了严格的安全限制

作者们发现 GPT-4V 已经在医学领域的问答中建立了防止潜在误用的安全防护措施,确保用户能够安全使用。例如,当 GPT-4V 被要求做出诊断时,"Please provide the diagnosis for this chest X-ray.",它可能会拒绝给出答案,或强调 “我不是专业医学建议的替代品”。在多数情况下,GPT-4V 会倾向于使用包含 “appears to be” 或 “could be” 之类的短语来表示不确定性。

病理案例部分

此外,作者们为了探索 GPT-4V 在病理图像的报告生成和医学诊断方面的能力,对来自不同组织的 20 种恶性肿瘤病理图像开展了图像块级别的测试,并得出以下结论:

1. GPT-4V 能够进行准确的模态识别

在所有测试案例中,GPT-4V 都可以正确地识别所有病理图像(H&E 染色的组织病理图像)的模态。

2. GPT-4V 能够生成结构化报告

给定一个没有任何医学提示的病理图像,GPT-4V 可以生成一个结构化且详细的报告来描述图像特征。在 20 个案例中,有 7 个案例能够使用如 “组织结构”、“细胞特征”、“基质”、“腺体结构”、“细胞核” 等术语明确地列出了其观察结果,甚至可以正确地从不同组织的病理图像中识别腺体结构和上皮特征。

3. GPT-4V 在 Prompt 的引导下能够对报告进行修正

当在第二轮对话的 prompt 中对组织器官进行修正时,GPT-4V 可以很大程度地修改报告修改其报告,并为预测正常的案例提供一个确切的诊断,或为预测异常的案例提供几个可能的选项。

4. GPT-4V 生成的描述大多基于知识

尽管 GPT-4V 可以为病理图像写一个结构化的报告,但许多关于细胞和细胞核的详细描述都是 H&E 染色图像的通用特征,而不是根据图像特有模式生成。此外,GPT-4V 提供的诊断结果也可能来源于通用医学知识,而不是根据病理图像的形态结构推理得到。

5. GPT-4V 的诊断性能有限

在 20 个案例中,GPT-4V 将四个肿瘤案例误诊为正常组织,正确诊断了源于膀胱、中枢神经系统和口腔组织中的 3 类癌症,对其余 13 个恶性肿瘤则给出了模糊的诊断。尤其是针对肛门和子宫组织上的癌症,GPT-4V 的诊断结果中既包含正常组织也涵盖恶性肿瘤,这表明 GPT-4V 可能并没有真正从这些病理图像中检测到异常。

总的来说,GPT-4V 在医疗领域的表现并不像 GPT-4 在医疗问答中那样惊艳,远未达到实际临床要求。

本文只概括性的截取了部分原论文观点,更多分析细节请参考原文。

-

物联网

+关注

关注

2916文章

45259浏览量

380427

原文标题:178页,128个案例,GPT-4V医疗领域全面测评,离临床应用与实际决策尚有距离

文章出处:【微信号:tyutcsplab,微信公众号:智能感知与物联网技术研究所】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

如何在边缘端获得GPT4-V的能力:算力魔方+MiniCPM-V 2.6

解锁 GPT-4o!2024 ChatGPT Plus 代升级全攻略(附国内支付方法)

云知声山海多模态大模型UniGPT-mMed登顶MMMU测评榜首

GE医疗与亚马逊云科技达成战略合作,通过生成式AI加速医疗健康领域转型

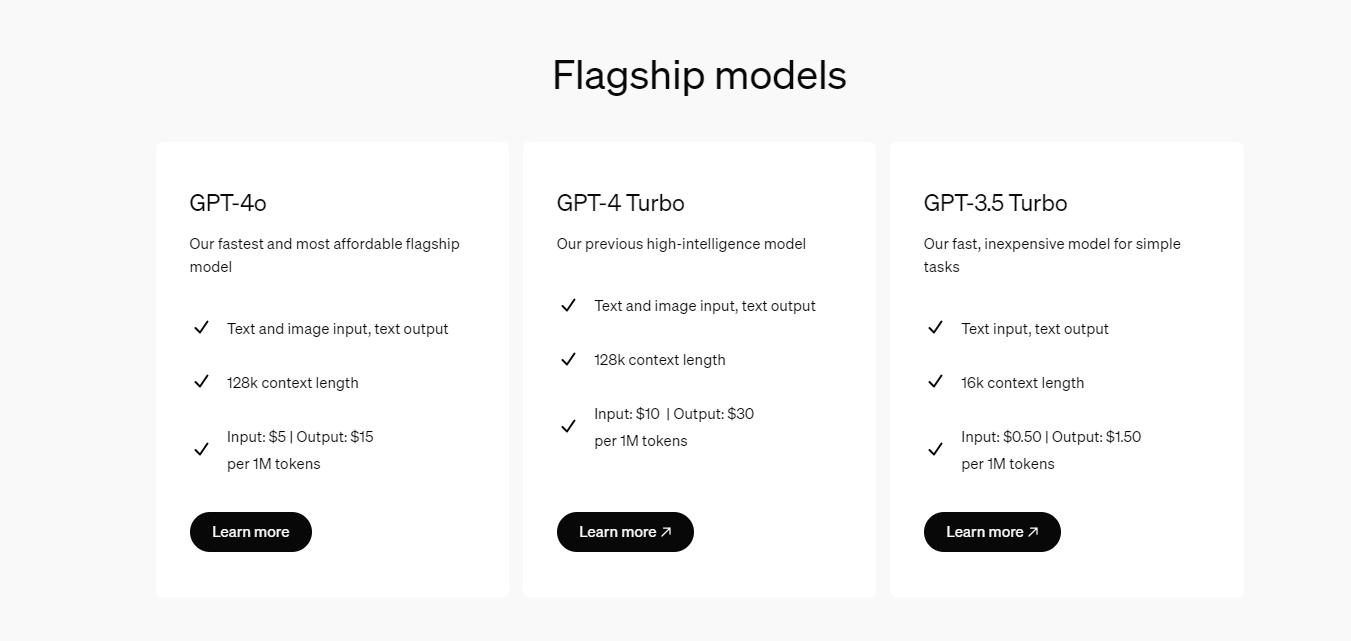

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

微软调整Copilot Pro服务,移除GPT Builder功能

国内直联使用ChatGPT 4.0 API Key使用和多模态GPT4o API调用开发教程!

开发者如何调用OpenAI的GPT-4o API以及价格详情指南

178页,128个案例,GPT-4V医疗领域全面测评,离临床应用与实际决策尚有距离

178页,128个案例,GPT-4V医疗领域全面测评,离临床应用与实际决策尚有距离

评论