ChatGPT 的爆火掀起了 AI 大模型热潮,也进一步拉动了算力需求的爆发,面对呈指数级增长的算力需求,如何用得起、用得上、用得好算力成为大家普遍关心的问题。那么,在大规模 AI 模型训练中,如何保证算力的高效利用?有哪些技术或方法可以提升训练的效率和稳定性?AIGC 应用如何下沉到终端?近日,InfoQ《极客有约》邀请到了英特尔中国技术部总经理高宇,为大家分享《AIGC 时代,如何提升端侧算力利用效率?》。

以下为访谈实录,完整视频参看:https://www.infoq.cn/video/w4UPiNImmKac6OSgpEiP

姜雨生:欢迎大家来到 InfoQ 极客有约,我是今天的特邀主持人,微软软件工程师姜雨生。本期直播,我们邀请到了英特尔中国技术部总经理高宇老师来给我们做分享。今天的直播主题是《AIGC 时代,如何提升端侧算力利用效率?》。先请高宇老师给大家做一个简单的介绍。

高宇:InfoQ 的朋友们,大家晚上好。我是高宇(Gary Gao),来自英特尔中国,负责英特尔中国技术支持团队的工作。今天,我非常荣幸与大家分享关于在端侧实现 AIGC 的热门话题。

生成式 AI 技术的发展与挑战

姜雨生:去年推出的 ChatGPT 引起了广泛关注,掀起了大型 AI 模型的热潮,企业和个人对算力的需求呈现出爆发性增长。这轮 AI 算力需求的爆发给您带来最大的感受是什么?行业发生了哪些变化?

高宇:这一轮生成式 AI 热潮确实代表了技术上的一个重大突破,无论是给消费者、商业客户还是数据科学家,都带来了巨大的潜力和影响。从去年 ChatGPT 3.5 正式发布以来,它展示出的智能和生成文本的能力让整个学术界、消费市场和最终用户都感到震惊。在短时间内,ChatGPT 3.5 已成为全球最受欢迎的应用之一,这一成就令人印象深刻。我认为,它对整个行业的影响可以从正面和挑战两个维度来分析。

从正面来看,首先,生成式 AI 极大地改善了用户体验。以前的搜索引擎和智能问答系统在知识方面相对固定,而生成式 AI 具有强大的学习和涌现能力,这是以前所没有的。因此,用户体验得到了显著改善。

其次,它激发了学术界和企业界对这项技术的研究兴趣。在过去的半年里,全球企业和知名的学术机构都大量投入到生成式 AI 的研究中。这种巨大的资金和智力投入使我们相信未来几年生成式 AI 的发展将非常迅猛,因为许多人都在进行相关研究和突破。

第三,我们看到生成式 AI 目前主要应用于人机对话,但我们更看好它在各种行业中,尤其是垂直行业中的应用潜力。例如,目前人们正在探讨用于医疗领域的大型模型,专为银行系统设计的大型模型,甚至为金融等垂直行业开发的模型。因此,我们对它在这些领域的应用前景非常期待。

当然,大型模型的出现和生成式 AI 的发展确实带来了一些重要挑战。在这方面,我们可以总结为以下几点。

首先,几乎所有大型科技公司都加入到了这个浪潮中。因此,这个领域的应用进展非常迅速,有时候可能会出现一些重复性工作,甚至资源浪费。

第二,数据隐私和可靠性是一个重大问题。个人数据的保护以及互联网上的开源内容如何得到保护都是重要考虑因素。此外,还涉及到更深层次的问题,例如对问题的解释、价值观的取向和正确判断等,这些都是全新的挑战。

英特尔倡导的 AI 不仅关注性能和能力,还强调负责任的 AI。这也是领先厂商共同的理念,即人工智能的发展应该以对社会负责任的态度为基础。总之,生成式 AI 对我们行业带来了重要冲击,后续我们可以深入探讨这些挑战的细节。

算力成本居高不下,如何找到破解之法?

姜雨生:无论是模型训练还是模型调用,计算资源的需求都在不断增加。这背后伴随着高昂的成本,对许多企业而言,这成为了业务扩展的一道巨大障碍。您怎么看算力贵这一现象?随着技术的发展,算力贵的现状会有所改善吗?

高宇:目前,大家都不得不承认算力成本有待解决。因此,大家都对这个行业的情况非常关注。我们可以分析一下导致算力成本上升的原因。

首先,运行生成实验,特别是训练模型所需的 GPU 性能相对较高,因此整个 GPU 以及 GPU 卡的成本较高,它需要更大的 GPU 芯片来提供更高的算力。此外,它还需要更快的内存,通常采用 HBM(High Bandwidth Memory,高带宽内存)内存架构,这也增加了成本。再加上需要用 8 卡互联的训练机,整机的物料成本非常昂贵,这是导致成本高昂的原因之一。

第二,与之前提到的问题相关,现在几乎所有人都涌入了这个行业,导致了短期内供大于求的情况。一度出现了 GPU 卡供不应求的情况,这已经从去年年底开始,需求量大但供应相对不足。

第三,整个大型 GPU 服务器或智算中心的运营成本极高,包括场地和能源消耗。一个标准的 GPU 服务器机柜功耗至少为 30 千瓦,而大多数数据中心机柜通常只能达到 10 千瓦到 20 千瓦之间,无法满足 30 千瓦的要求,这也增加了成本因素。

当然,我们还需要考虑一点,因为生成式 AI 仍处于早期阶段,所以在许多算法优化和资源利用方面还有改进的空间。因此,有望在未来降低算力成本。

姜雨生:在目前算力贵这个方向,英特尔目前有哪些相关的解决方案,这面方便给我们大概介绍一下吗?

高宇:我们需要思考一个根本性问题,即如何应对昂贵的算力这一行业性的难题。我们有几个想法,虽然稍后我们还会谈及产品方面的问题,但现在我们首先想从行业角度提出一些大的思路。

首先,我们认为当前的推理部分应该更加分布式和层次化,充分利用云、边缘和终端的不同层次来部署推理算力,以充分发挥算力性能。具体来说,我们的建议是在云端进行大规模的训练,这是云侧的任务。此外,云侧适合大集群训练,部署超大型模型,例如 ChatGPT 等超过 100 亿的模型。第三,云侧适合部署高并发的场景,即当用户数量庞大时,需要同时满足所有客户的需求,这也需要云端来实现。

对于不属于以上几种情况的 AI 推理算力,我们建议将其下沉到边缘侧。如今,运营商和企业都拥有许多边缘侧数据中心,虽然这些数据中心规模较小,机器配置的算力相对较低,但足以支持多种类型的大型模型的推理。根据我们的判断,大约在 10 亿到 30 亿之间的模型可以考虑部署在边缘侧,因为边缘侧可以使用性能稍微较低端的 GPU 卡或 CPU 进行推理,性能足够。此外,在边缘侧部署可以提供更好的低延迟体验,成本也较低。

下沉的第二步就是把它部署在端侧。我们认为一些规模较小的模型,比如小于 10 亿参数的模型,经过一定的优化和量化,以及低精度的比特量化后,完全可以部署到个人计算机(PC)或虚拟私有云(VPC)等设备上。将其部署到端侧带来两个明显的好处。首先,它的性能延迟是最低的,因为不需要经过网络传输,减少了任何网络延迟。此外,边缘侧部署还有一个重要的优势,即对个人隐私的最大程度保护,因此数据泄露的风险几乎不存在。因此,从大的原则上讲,我们希望将大型模型转化为云、边缘和终端三层协同的架构,这应该是未来发展的趋势之一。

姜雨生:有观众提问,在算力优化方面,我们业界还有没有一些通用的方案?

高宇:我们了解到,在当前的研究领域中,一个备受关注的通用方案是针对低比特量化的优化。目前,大多数部署在云端的模型采用的是 FP16(16 位浮点数)的精度。然而,如果要将模型部署在边缘侧或终端侧,通常的做法是首先将其量化为 INT8(8 位整数),然后可以进一步将其量化为更低比特位,如 INT5、INT4 或 INT3,这都是可能的,而且我们看到在这方面行业已经取得了一些显著的进展。

AIGC 应用如何下沉到终端?

姜雨生:我认为开发者会积极采用 AIGC 的大型模型,因为这是未来的趋势。在过去,我们主要在云服务器上运行 AIGC 应用,包括我自己目前使用的一些 Azure 云上的产品。但云端 AI 也存在延迟和各种限制等方面的一些短板。那么,AIGC 应用有下沉到终端的可行性吗?

高宇:根据我们目前的研究成果,我可以告诉大家,针对英特尔的最新平台,也就是第 13 代(以及后续推出的第 14 代,采访时第 14 代酷睿尚未发布)酷睿处理器家族,我们已经取得了非常不错的优化结果。这个平台不仅适用于笔记本电脑,还包括台式机。我相信许多开发者和用户在购买电脑时都会选择最新的酷睿平台。

以第 13 代酷睿平台为例,我们的优化结果可以使模型从 7 亿参数到 18 亿参数都能够流畅运行。特别是在 7 亿到 13 亿参数范围内,性能效果非常出色,即使超过 13 亿参数,模型也可以运行,尽管速度稍慢,但我们认为基本上也可以满足用户的需求。当然,我们目前的优化主要是在 CPU 上进行的,但下一步我们将充分发挥平台内的集成显卡(IGPU)能力,以进一步提升速度。

此外,对于未来,我想提到最近引起广泛关注的一项重要消息,那就是我们披露了英特尔即将发布的下一代平台,内部代号为 Meteor Lake,正式品牌叫做 Core Ultra。这个平台不仅具有强大的 CPU 算力,还将 GPU 算力提高了一倍,因此 GPU 算力非常强大。另外,它还内置了专用的 AI 加速器(NPU),可以提供超过 11 tops 的峰值算力。因此,在下一代平台上,我们将能够充分利用三种计算资源,包括 CPU、GPU 和 NPU 的算力,以实现更出色的性能。这是我们下一代平台的亮点,敬请期待。

姜雨生:英特尔之前提出在 PC 端侧跑 AIGC 应用,具体是如何实现的?在软硬件层面是如何提升算力利用效率,实现算力优化的?

高宇:我来简要介绍一下我们目前正在发布的开源框架,它叫做 BigDL,是专门为英特尔的处理器和 GPU 开发的一个低比特量化框架。感兴趣的观众可以进入在 GitHub(https://github.com/intel-analytics/BigDL) 上查看,下载我们的 BigDL 开源代码,进行实验。

BigDL 有一些显著特点。首先,它支持低比特量化,从 INT8 到 INT5、INT4、INT3 等各种低比特的数据精度,从而提供更好的性能,并减少内存占用。这一点尤其重要,因为在边缘计算领域,除了性能挑战之外,内存也相对较低,所以低比特量化是解决这个问题的一种方法。

此外,BigDL 支持多种平台,包括英特尔的各种 CPU 系列,从 Xeon 处理器到酷睿处理器等。它还支持英特尔的各种 GPU 系列,包括英特尔 Flex 系列用于数据中心的专用显卡以及英特尔锐炫( Arc) 系列面向消费者的显卡。

姜雨生:我也确实感受到了在个人电脑上运行大型模型以及进行内容生成的可能性,特别是在我的个人电脑上装备了这些硬件的情况下。实际上,我也想了解一下一些相关的技术,如果要大规模普及,关键的主要指标可能是颠覆,即用户在他们的实际工作和生活中所体验到的变革。那么 AI 能够在端侧带给用户哪些具体的体验提升?

高宇:从我们现在的观察来看,大型模型在端侧用户领域可能有几个可能的应用场景。首先,大型模型可以成为每个用户的个人超级助手。这种大型模型可以在云端运行,同时也可以通过我们刚刚提到的低比特量化技术在个人电脑上运行,从而提供更好的用户体验。这是第一个应用场景。

第二,它可以用于文档处理,包括提取文档的核心思想和纠正文档中的语法错误等任务。对于这种应用场景,更适合将模型部署在端侧,因为许多文档包含一些个人属性,用户可能不愿意将其上传到云端。

第三,我们观察到大型模型,特别是 Diffusion 模型,在图像生成方面具有出色的能力,这对于许多设计师来说是一个强大的工具。许多图形、图像和三维设计公司积极采用 Stable Diffusion 以及相关衍生模型,以帮助设计师生成各种图片和画面,从而实现事半功倍的效果。

姜雨生:将 AIGC 相关应用以预装软件的方式适配到未来的电脑中,是否是 PC 创新的一个新方向?它对于 PC 应用效率的提升是否有着大幅超越以往的预期?

高宇:当然,答案是肯定的。在未来的个人电脑上,无论是笔记本还是台式机,它们的算力已经足以支持像 7 到 13 亿级别的大型语言模型在本地运行。这种潜力已经存在,接下来我们可以期待不同的商业模式的出现。

首先,我们可能会看到一些商业软件集成了中小型大语言模型,将其变成了生成式人工智能的专业商业软件。这些软件还有可能集成了 Stable Diffusion 等功能,从而成为一种可用于文本生成和其他工作流程的商业软件。因此,可以期待在桌面平台上出现集成生成式人工智能能力的商业软件,这是一个可能的落地方式。

另外一种方式是鼓励更多的 OEM 制造商,也就是个人电脑的品牌制造商,为自己的产品开发专门针对硬件优化的生成式人工智能软件,并将其预装在他们的电脑上,以提高最终用户的体验,使电脑更易于使用和更具趣味性。这种辅助性软件可以提升用户的使用体验,增加趣味性,我认为这也是一个非常有潜力的方向。

端侧运行大模型存在哪些挑战?

姜雨生:有观众提问,端侧跑这些大模型有没有一些难点我也比较关注这个问题,端侧跑大模型有没有一些相对不适用的场景或内容?

高宇:端侧与云侧相比,目前存在两大限制。首先,端侧的计算能力明显不如云端强大。这是显而易见的。第二,端侧的内存相对有限。当前,笔记本电脑和 PC 的主流配置通常为 16GB 内存。明年我们可能会看到更多配置为 32GB 内存的 PC,但即使是 32GB 内存,相对于云端来说,内存仍然有限。因此,端侧需要应对以下两个主要挑战。

首先,模型的参数量需要受限,通常在 130 亿以下。其次,必须进行低比特量化,这是一种必不可少的手段。经常有人问一个常见的问题,即将一个 FP16 模型量化为 INT4 后,精度损失似乎很大,这对大型模型的性能会产生什么影响?我们目前的基本结论是,在大型语言模型的情况下,从 FP16 到 INT4 后,回答问题的质量会略微下降,但下降幅度并不是很大。如果我们使用评分机制,原来的模型可能是 85 分的模型,经过量化后,可能会下降到 82 分左右,所以大致是一个个位数的质量下降。但是在内存方面,收益是非常大的,这是一个权衡。

然而,对于 Stable Diffusion 模型而言,如果将 FP16 量化为 INT8,整个图像生成的质量下降会比较大。因此,对于运行稳定扩散模型的端侧,我们仍然坚持使用 FP16。幸运的是, Stable Diffusion 模型的参数量不是很大,因此即使在端侧,FP16 的性能也完全可以胜任。

姜雨生:在端侧执行一些生成式内容和场景时,精确度并不是特别重要,尤其是对于一些模型复杂度不太高的情况来说,这种方式会更加合适。下一步,英特尔有哪些技术探索和产品规划呢?有哪些技术难题是我们在未来需要解决的?

高宇:对于英特尔未来的产品规划,目前英特尔在生成式 AI 领域有几个主要的产品家族,可以从云端、边缘和端侧三个维度来介绍。

在云端,英特尔的关键产品是 Gaudi2,这是 英特尔 Habana 最新推出的产品。Gaudi2 具有非常高的算力性能,它还具有大容量的显存,目前 Gaudi2 的配置为 96GB 的 HBM2 显存,因此可以容纳更多的模型。此外,英特尔还推出了专门针对中国市场定制的 Gaudi2 中国版本。云端英特尔还有一款产品叫做 Xeon HBM,它是一款针对大模型推理而设计的 CPU,内置了 64GB 的 HBM2 高速内存,这对于大型语言模型的推理性能提升非常有帮助。

边缘侧,英特尔推出了两款显卡产品,一款是英特尔 Flex 系列,另一款是锐炫( Arc) 系列。Flex 系列是为数据中心和服务器设计的无风扇 GPU 产品,而 Arc 系列则是面向消费者市场的显卡,在算力方面也非常强大,可以满足边缘侧推理的要求。这些产品将为边缘侧大模型推理和 Stable Diffusion 提供强大的支持。

总的来说,英特尔在生成式 A I 领域有一系列强大的产品,覆盖了云端、边缘和端侧,为不同应用场景提供了多样化的解决方案。

姜雨生:有观众提问,端侧模型跟云端模型有可以配合的方式吗?

高宇:端侧模型和云端模型可以进行协同配合,一种可能流行的做法是由端侧模型进行问题的初步预判断。这个端侧模型可以是相对轻量级的,用于判断用户问题的导向方向。如果这个初步判断结果显示性能足以在端侧大模型上运行,那么模型可以在端侧执行。但如果判断需要更强大的计算能力,那么就可以将任务传递到云端进行更大型的模型推理。这种方式可能比较容易实现,因为它避免了对同一个模型进行拆分,尽管拆分模型也是一种可能的方式,但会更加复杂。

姜雨生:如果希望在个人电脑上运行之前所描述模型相关的内容,最低配置要求如何?

高宇:关于个人电脑的配置,主要取决于您的耐心和使用场景,当然这是个半开玩笑,但基本上,为了达到基本的用户体验要求,我们建议以下配置:

处理器(CPU):最好选择第 13/14 代酷睿处理器,尤其是选择 I7 或更高级别的型号。如果有预算,并且想要更出色的性能,选择 I9 处理器会更好,正如我在之前的演示视频中展示的那样。

内存(RAM):至少 16GB RAM 是起点,但更好的选择是 32GB RAM。此外,要注意内存的速度,因为现在的内存,尤其是 DDR5 内存,速度范围从入门级的 5677 MHz,一直提升到高达 7233 MHz。内存速度越快,性能表现通常越好。再次强调,大型模型通常对内存带宽要求较高,因此提高内存带宽会带来更大的性能收益。

散热设计:除了硬件配置,还要考虑系统的散热设计。良好的散热设计可以让 CPU 在 Turbo 模式下更长时间地运行,从而提高性能表现。

选择适合需求的个人电脑配置是一个综合考虑的过程。明年新发布的电脑新品通常会公布其运行大型模型的性能指标,用户可以根据厂商提供的指标来选择适合自己需求的配置,这应该会更准确地满足你的期望。

当然了,我认为目前大模型仍然存在一些挑战,尤其是在处理模型的一些幻觉问题方面,这个问题在整个行业中仍然是一个难点,需要不断攻克。

-

cpu

+关注

关注

68文章

10855浏览量

211594 -

算力

+关注

关注

1文章

965浏览量

14794 -

大模型

+关注

关注

2文章

2425浏览量

2645

原文标题:当大模型被塞进PC:如何提升算力利用效率?

文章出处:【微信号:AI前线,微信公众号:AI前线】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

【「大模型时代的基础架构」阅读体验】+ 未知领域的感受

浅析三大算力之异同

摩尔线程GPU算力底座助力大模型产业发展

曙光携手“算力互联公共服务平台”提高全国算力匹配效率

存内计算WTM2101编译工具链 资料

大算力时代, 如何打破内存墙

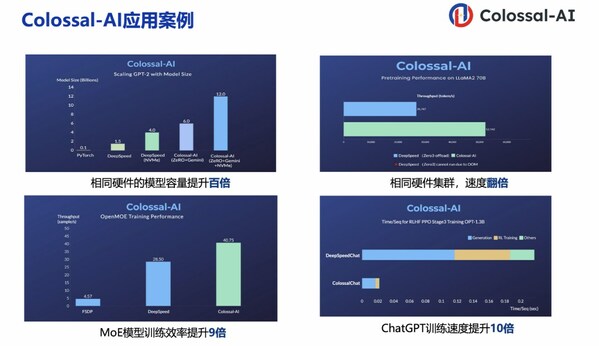

潞晨科技Colossal-AI + 浪潮信息AIStation,大模型开发效率提升10倍

iBeLink KS MAX 10.5T大算力领跑KAS新领域

智能算力规模超通用算力,大模型对智能算力提出高要求

当大模型被塞进PC:如何提升算力利用效率?

当大模型被塞进PC:如何提升算力利用效率?

评论