国内芯片未来能否实现替代?

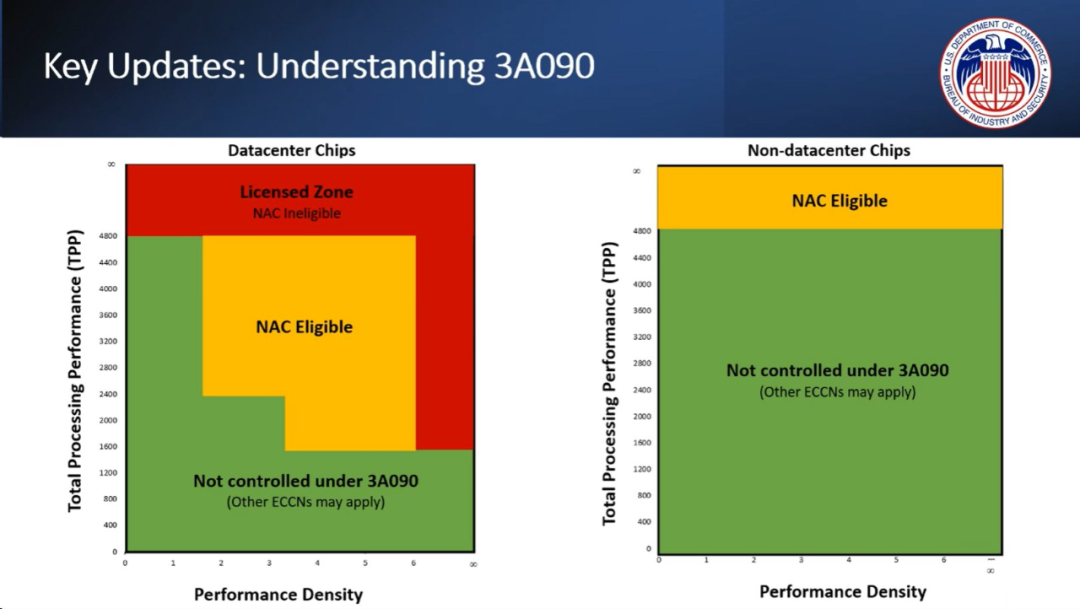

10 月 17 日,美国商务部放出最严对华出口管制规定,H800 等 AI 加速器成为制裁的焦点。因为制裁涉及显卡功率和算力的限制,继 H100 之后,英伟达专为符合要求设计的定制芯片也因此受限。

新的禁令已在 10 月 23 日生效。有经销商表示,在 A800 和 H800 GPU 无法进口后,英伟达为国内市场专门开发了一款新服务器芯片和两款新 GPU,英伟达将在未来几天内向国内制造商交付三款新芯片。

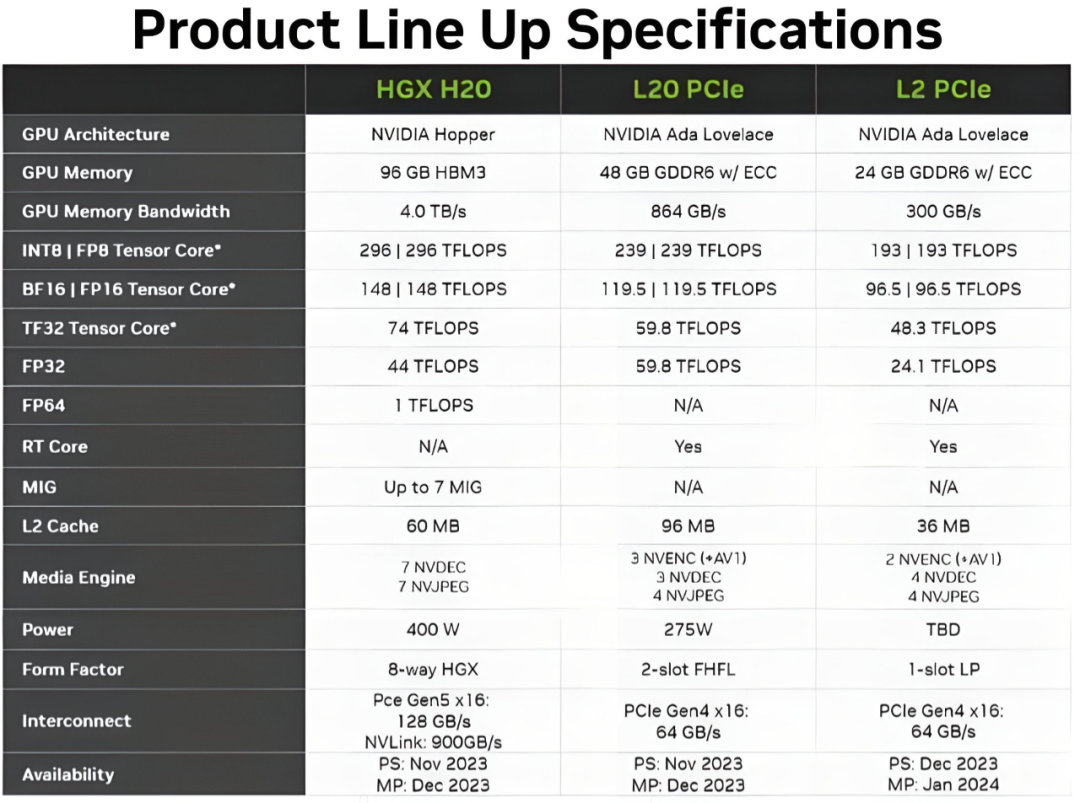

继 A800 和 H800 GPU 之后,英伟达开发了 HGX H20 以及 GPU L20 和 L2,它们分别对应人工智能的训练、推理和端侧应用场景,将于今年底发布并量产。

本周四,一些媒体首次报道了英伟达特供芯片的消息。报道称,这三款新产品是在 H100 GPU 的基础版本基础上进行修改的,采用的是最新架构,但性能大幅度缩减。H100 GPU 是一种用于人工智能训练的高端 GPU,已于 2022 年 8 月被禁止在国内销售。

其中,HGX L20 是基于 Hopper 架构的 HGX 形式加速卡。该型号提供高规格 HBM3 内存,容量为 96 GB,带宽达到 4Tb/s。在计算性能方面,该型号的 INT8 算力为 296 TFLOPS,通过 Tensor Core 在 BF16 中可达到 148 TFLOPS,在 FP32 中为 44 TFLOPS,在 FP64 中为 1 TFLOP。最后,它具有 PCIe 5.0 接口以及 900 GB/s NVLINK 链路。

L20 和 L2 是分别配备 48 GB 和 24 GB GDDR6 的 PCIe 卡,内存带宽分别为 864 GB/s 和 300 GB/s。它们的 GPU 核心型号是 AD102,公布的性能数据如下:

L20:239 TFLOPS (FP8) – BF16 中为 119.5 TFLOPS – FP32 中为 59.8 TFLOP

L2:193 TFLOPS (FP8) – BF16 中为 96.5 TFLOPS – FP32 中为 24.1 TFLOP

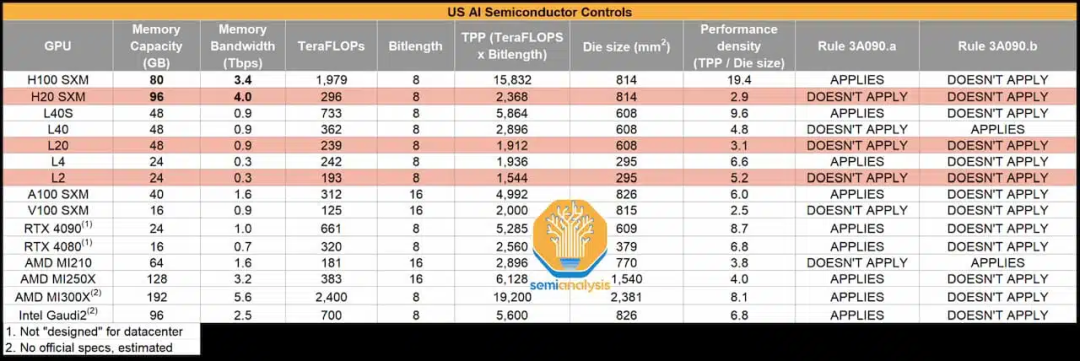

与目前业内标杆 H100 相比,这些显卡在内存和带宽方面相近,功耗更低,但算力数字非常有限,特别是在 TFLOPS 方面:H20 的纸面算力不及 H100 的 20%。

显然,目前的规格完全是按照新的出口限制设计的。

它们比之前以 H800 和 A800 形式提供的性能也要差得多,但如果英伟达用于 AI 和 HPC 的软件堆栈对于一些客户来说无法放弃,为了获得最新的 Hopper 架构,人们或许仍然愿意采用降低规格后的产品。

分销商表示,其已于本周早些时候听取了有关进展情况的简报,并表示符合美国最新出口规则的新芯片将作为 A800 和 H800 的替代品提供给国内客户。

在业务受阻的情况下,英伟达仍然努力寻求遵守限制,提供产品,这表明了中国市场对于芯片公司的重要性。英伟达数据中心业务面向中国的收入占整体的 20% 至 25%,而该业务是英伟达目前营收最大的部门。

上月底曾有报道称,英伟达可能因为新的禁令被迫取消了价值 50 亿美元的先进芯片订单。

另一方面,近日也有消息称,国内科技公司正在采购国产 910B 芯片作为英伟达芯片的替代,其能力已经基本做到可对标英伟达 A100。

-

芯片

+关注

关注

455文章

50851浏览量

423865 -

AI

+关注

关注

87文章

30946浏览量

269185 -

英伟达

+关注

关注

22文章

3778浏览量

91148

原文标题:英伟达特供版芯片将上市:性能最高不到H100的20%

文章出处:【微信号:CVer,微信公众号:CVer】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

英伟达特供版芯片将上市:性能最高不到H100的20%

英伟达特供版芯片将上市:性能最高不到H100的20%

评论