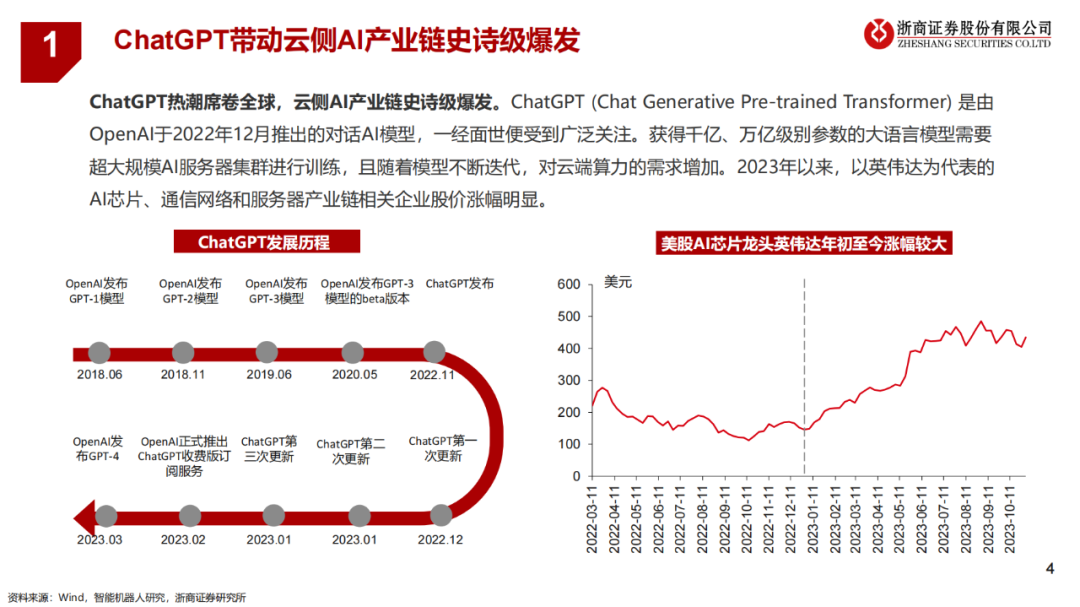

ChatGPT是由OpenAI于2022年12月推出的对话AI模型,一经面世便受到广泛关注。获得千亿、万亿级别参数的大语言模型需要超大规模AI服务器集群进行训练,且随着模型不断迭代,对云端算力的需求增加。2023年以来,以英伟达为代表的AI芯片、通信网络和服务器产业链相关企业股价涨幅明显。

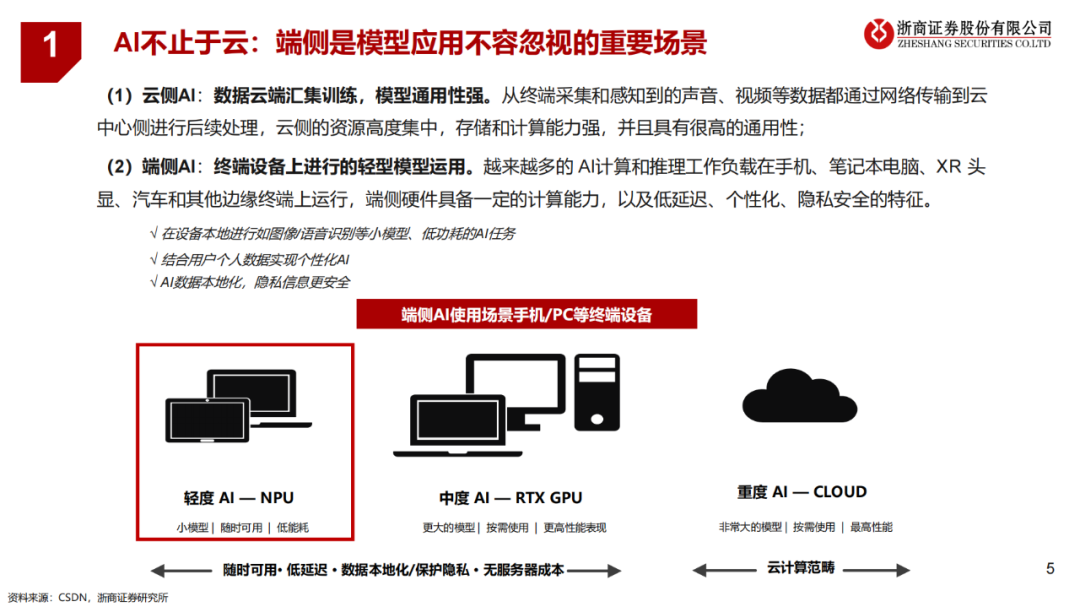

(1)云侧AI:数据云端汇集训练,模型通用性强。从终端采集和感知到的声音、视频等数据都通过网络传输到云中心侧进行后续处理,云侧的资源高度集中,存储和计算能力强,并且具有很高的通用性;

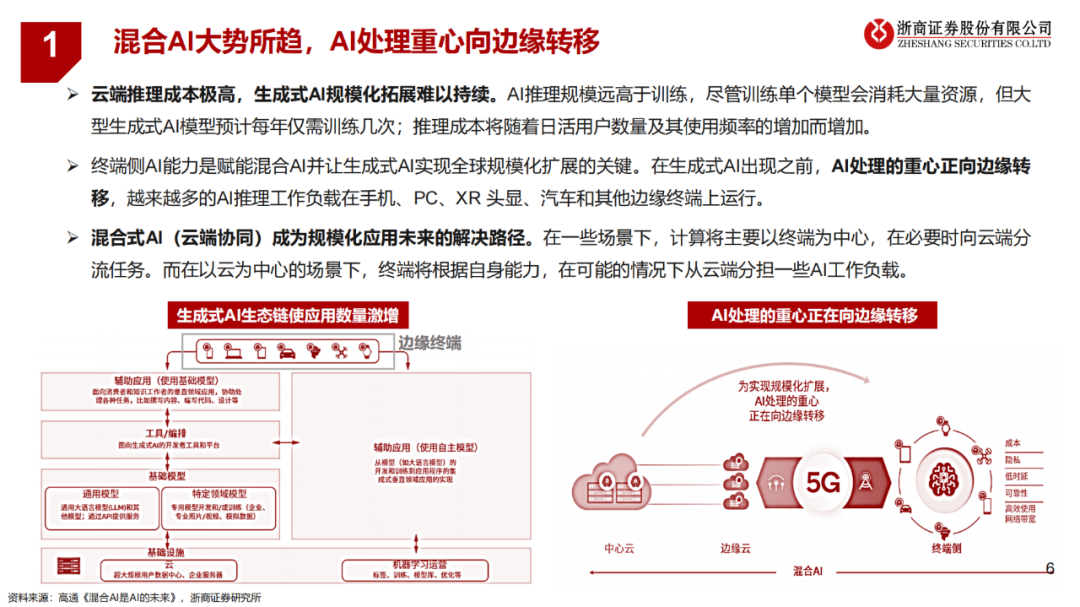

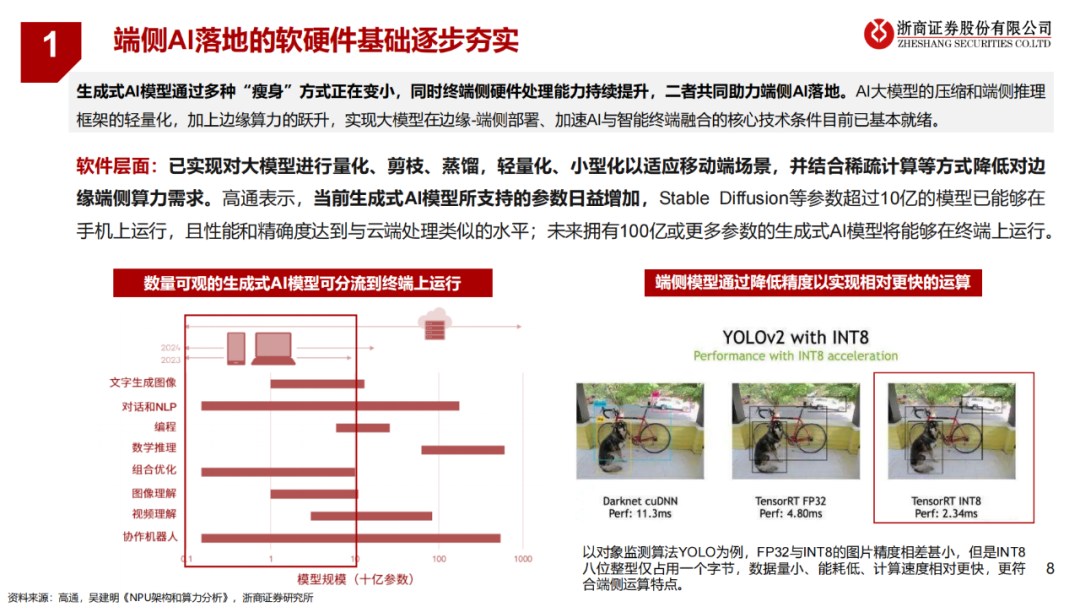

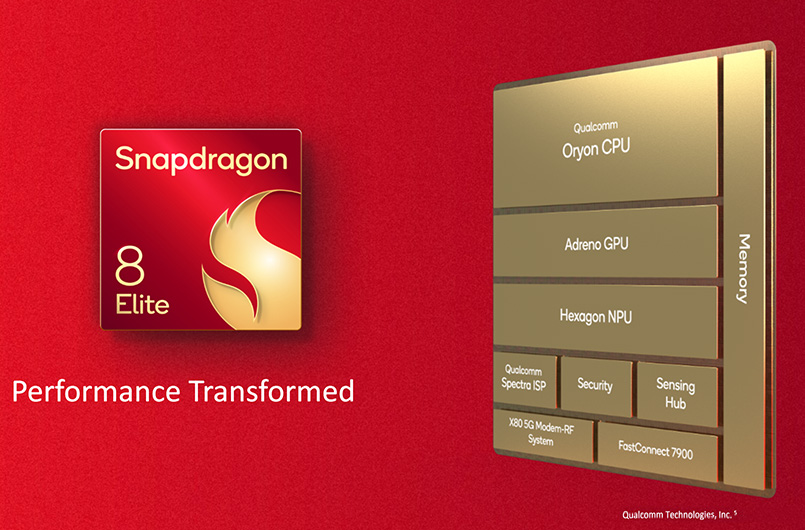

(2)端侧AI:终端设备上进行的轻型模型运用。越来越多的 AI计算和推理工作负载在手机、笔记本电脑、XR 头显、汽车和其他边缘终端上运行,端侧硬件具备一定的计算能力,以及低延迟、个性化、隐私安全的特征。

端侧AI的四大优势:隐私和安全、低延时、可靠性、低成本。

✓ 隐私和安全:端侧AI从本质上有助于保护用户隐私,因为查询和个人信息完全保留在终端上。数据的存储计算等都在本地,避免了传到云端可能带来的数据安全问题。对于企业和工作场所等场景中使用端侧AI,这有助于解决保护公司保密信息的难题。例如,用于代码生成的编程助手应用可以在终端上运行,不向云端暴露保密信息。

✓ 低延时:当生成式AI查询对于云的需求达到高峰期时,会产生大量排队等待和高时延,甚至可能出现拒绝服务的情况数据的存储计算在本地处理、本地响应方面时间更短速度更快。

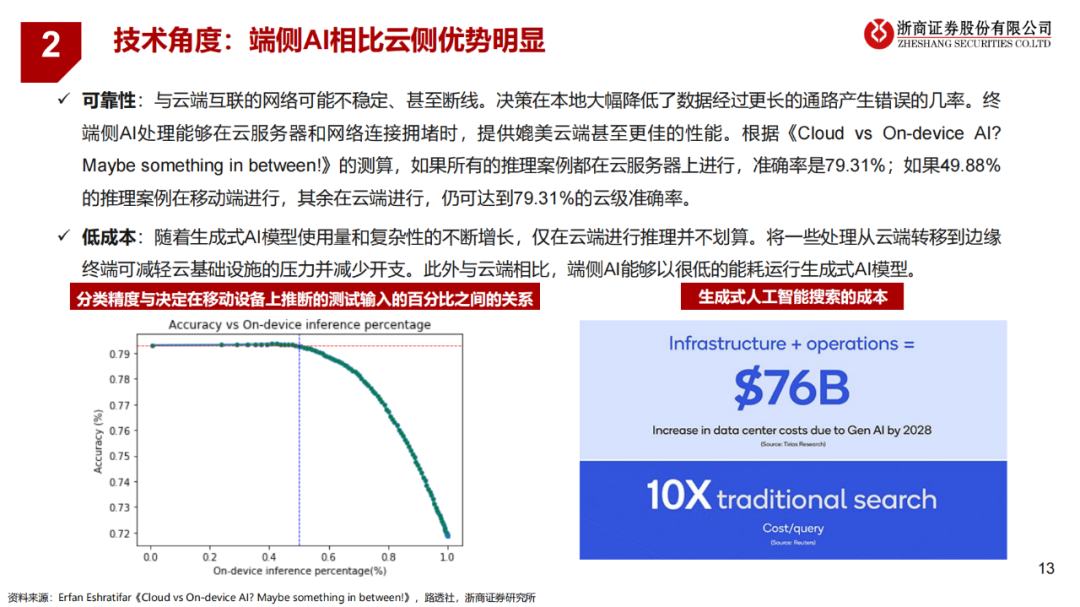

✓ 可靠性:与云端互联的网络可能不稳定、甚至断线。决策在本地大幅降低了数据经过更长的通路产生错误的几率。终端侧AI处理能够在云服务器和网络连接拥堵时,提供媲美云端甚至更佳的性能。如果所有的推理案例都在云服务器上进行,准确率是79.31%;如果49.88%的推理案例在移动端进行,其余在云端进行,仍可达到79.31%的云级准确率。

✓ 低成本:随着生成式AI模型使用量和复杂性的不断增长,仅在云端进行推理并不划算。将一些处理从云端转移到边缘终端可减轻云基础设施的压力并减少开支。此外与云端相比,端侧AI能够以很低的能耗运行生成式AI模型。

-

AI

+关注

关注

87文章

30959浏览量

269230 -

语言模型

+关注

关注

0文章

526浏览量

10277 -

数据云

+关注

关注

0文章

11浏览量

2588

原文标题:端侧AI研究:2024 AI“下凡”

文章出处:【微信号:AI_Architect,微信公众号:智能计算芯世界】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

中信建投建议关注端侧AI模组机会

端侧AI浪潮已来!炬芯科技发布新一代端侧AI音频芯片,能效比和AI算力大幅度提升

广和通端侧AI解决方案驱动性能密集型场景商用型场景商用

广和通端侧AI解决方案荣膺MWCS 2024边缘AI计算最佳创新奖

广和通发布基于高通 QCM6490和QCS8550处理器的端侧AI解决方案

广和通发布基于高通QCM6490和QCS8550的端侧AI解决方案,使AI“更接地气”

广和通发布基于高通QCM6490和QCS8550的端侧AI解决方案,使AI“更接地气”

端侧AI研究:2024 AI“下凡”

端侧AI研究:2024 AI“下凡”

评论