在生成式 AI 领域,构建企业级大语言模型(LLM)需要具备采集高质量数据、设置加速基础设施和优化模型方面的专业知识。

开发者可以从预训练模型开始,根据自己的用例对模型进行微调,从而节省时间并使其解决方案更快地投入市场。开发者需要一种简单的方法来试用模型,并通过 API 集成这些模型来评估其能力。这有助于他们确定哪种模型最适合其应用。

NVIDIA AI Foundation Models

NVIDIA AI Foundation Models是由精心挑选的社区模型和 NVIDIA 构建的模型组成,并针对峰值性能进行了优化。开发者可以通过 API 或图形用户界面直接在浏览器中快速使用这些模型,无需进行任何设置。这些模型通过NVIDIA TensorRT-LLM和激活感知权重量化(AWQ)技术进行优化,以便确定最高吞吐量和最低延迟的配置,并且在 NVIDIA 加速计算堆栈上大规模运行。

NVIDIA Nemotron-3 8B 系列 LLM 介绍

NVIDIA Nemotron-3 8B系列模型为想要构建生产就绪生成式 AI 应用的客户提供了基础。这些模型是基于可靠的数据集构建,其运行性能可媲美规模远超它们的模型,因此非常适合企业部署。

NVIDIA Nemotron-3 8B 系列模型的一大关键优势在于其具有多语言功能,这使其成为全球企业的理想选择。这些模型精通 53 种语言,包括英语、德语、俄语、西班牙语、法语、日语、中文、意大利语和荷兰语。

该系列模型还采用了一系列对齐技术,包括监督微调(SFT)、人类反馈强化学习(RLHF)以及全新的NVIDIA SteerLM定制化技术,使客户可以在推理时调整模型。无论是自定义模型还是从头开始运行模型,这些变体为支持各种不同的用例打下了基础。

Nemotron-3 8B 系列模型包含:

-

Nemotron-3-8B-Chat-SteerLM:一个基于 NV-Nemotron-3-8B 基本模型的生成式语言模型,专为在推理过程中使用户能够采用 SteerLM 技术控制模型输出而定制。

-

Nemotron-3-8B-QA:一个基于 NV-Nemotron-3-8B 基础模型的生成式语言模型,可针对问题回答指令进行进一步微调。

经过 NVIDIA 优化的社区模型

此外,NVIDIA 还提供领先的社区模型,这些模型均经过 NVIDIA TensorRT-LLM 的优化,具有最高的性价比,企业机构可根据企业应用对它们进行自定义。这些模型包括:

-

Llama 2:最流行的 LLM 之一,能够根据提示生成文本。

-

Stable Diffusion XL:一种热门的生成式 AI 模型,可使用文本创建富有表现力的图像。

-

Mistral 7B:一种能遵循指令、完成请求并生成有创意的文本格式的 LLM。

-

Contrastive Language-Image Pre-Training (CLIP):一种流行的开源模型,能同时理解图像和文本,从而完成图像分类、物体检测等任务。

当开发者确定了合适的基础模型后,就可以轻松地对这些模型进行微调和部署,无论是在自己的基础设施上,还是通过NVIDIA DGX Cloud在 NVIDIA 维护的基础设施上。

下面让我们一起体验、定制和部署微调后的 Llama 2 模型。

体验 Llama 2

NVIDIA 提供了一个易于使用的界面,使开发者能够直接在浏览器上与 Llama 2 模型进行交互。只需在提示字段中输入文本并点击生成,模型就会立即开始生成信息回复。

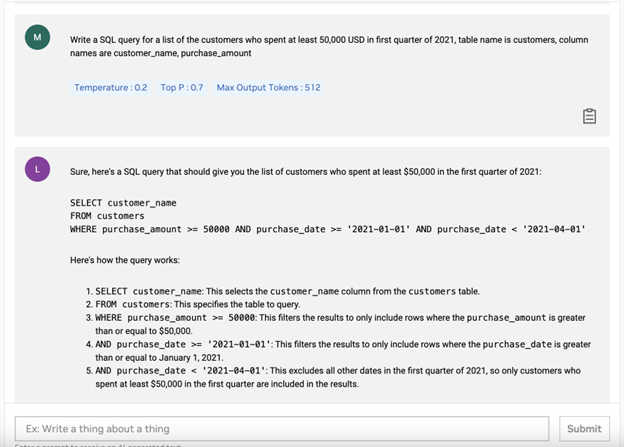

在图 1 中,用户要求模型进行 SQL 查询,检索 2021 年第一季度至少消费 50,000 美元的客户名单。模型不但正确理解了用户的查询,并提供了答案和详细解释。

图 1. Llama 2 模型对 SQL 查询“获取 2021 年第一季度

至少消费 50,000 美元的客户名单”所做出的响应

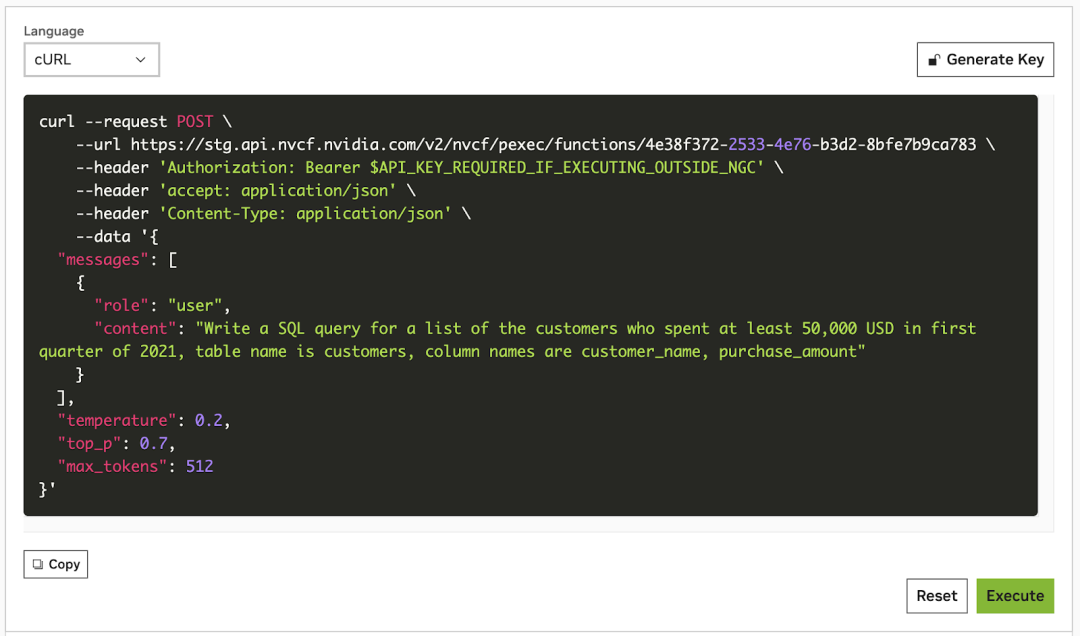

而开发者通常对代码更感兴趣。因此,NVIDIA 也直接在浏览器中提供了一个 API 小工具,让用户可以通过 API 无缝体验这些模型。

如要试用这个浏览器内置的 API,请单击 API 模式,然后从下拉菜单中选择您倾向的语言。图 2 显示了通过 cURL 调用该 API 的 API 指令。

图 2. 用于体验 Llama 2 模型的

浏览器内置 API 小工具(cURL 语言)

自定义模型

通常情况下,一般模型无法满足开发者的需求,必须使用专有数据进行微调。因此,NVIDIA 提供了多种自定义可用模型的途径。

NVIDIA NeMo是一个端到端企业级云原生框架,开发者可用它来构建、定制和部署具有数十亿参数的生成式 AI 模型。此外,NeMo 还提供用于微调 LLM(如 Llama)的 API。

为了快速上手,我们也提供了一个 NVIDIA LaunchPad 实验室。这个通用的试验场可对最新的 NVIDIA 企业级软硬件进行全方位测试。

该 LaunchPad 实验室体验中的以下示例使用自定义数据集对 Llama 2 7B 文本-文本模型进行了微调,以更好地执行问答任务。

-

如要开始使用,请单击“Llama 2 微调实验室”(https://www.nvidia.com/en-us/launchpad/ai/customize-llama-2-with-enterprise-data/)并申请访问。在 Launchpad 上工作时,Llama 2 模型文件会以 .nemo 检查点的形式预先下载,从而实现与 NVIDIA NeMo Framework 的微调兼容性。

-

模型准备就绪后,我们从 Hugging Face 加载 Dolly 数据集(https://huggingface.co/datasets/databricks/databricks-dolly-15k)并对其进行预处理,删除不必要的字段、重命名某些字段,以更好地适应提示调整任务,并将数据集分割成训练文件和测试文件。

dataset=load_dataset("aisquared/databricks-dolly-15k")上面所示的是一个数据样本。为了适应特定的用例,数据集可以互换。

{ "question": "When did Virgin Australia start operating?", "context": "Virgin Australia, the trading name of Virgin Australia Airlines Pty Ltd, is an Australian-based airline. It is the largest airline by fleet size to use the Virgin brand. It commenced services on 31 August 2000 as Virgin Blue, with two aircraft on a single route.[3] It suddenly found itself as a major airline in Australia's domestic market after the collapse of Ansett Australia in September 2001. The airline has since grown to directly serve 32 cities in Australia, from hubs in Brisbane, Melbourne and Sydney.[4]", "answer": "Virgin Australia commenced services on 31 August 2000 as Virgin Blue, with two aircraft on a single route.", "taskname": "genqa" } -

然后,通过更新默认 NeMo 配置文件的某些字段来设置微调作业,以适应当前的训练任务。接着,使用 NeMo 训练脚本启动作业,运行微调并在过程中生成模型检查点。

-

微调任务完成后,我们就可以运行笔记本内推理,生成一些示例输出,并评估微调后模型的性能。

-

接着让我们来看看这样一个示例输出。我们在上下文中提供了两种产品的描述:割草机和厨房机器人,并询问模型割草机是否由太阳能供电。

该模型准确地把握了上下文,并给出了“是”的回答。在对该模型进行微调后,它就能够根据所提供的上下文准确回答我们的问题了。

{ "input": "Context: The Auto Chef Master is a personal kitchen robot that effortlessly turns raw ingredients into gourmet meals with the precision of a Michelin-star chef. The Eco Lawn Mower is a solar powered high-tech lawn mower that provides an eco-friendly and efficient way to maintain your lawn. Question: Is the lawn mower product solar powered? Answer:", "pred": "Yes", "label": "Yes, the Eco Lawn Mower is solar powered.", "taskname": "genqa" }

部署模型

NVIDIA AI FoundationEndpoints提供完全无服务器和可扩展的 API,这些 API 可部署在您自己的云或NVIDIA DGX Cloud上。填写此表(https://developer.nvidia.com/login)即可开始使用 AI Foundation Endpoints。

您还可以使用NVIDIA AI Enterprise在自己的云或数据中心基础设施上进行部署。这一端到端的云原生软件平台凭借其企业级的安全性、稳定性、可管理性和支持,能够加速生产级生成式 AI 的开发和部署。当您准备从实验转向生产阶段时,就可以使用 NVIDIA AI Enterprise 的企业级运行时来微调和部署这些模型。

更多信息

通过这篇文章,我们了解了 NVIDIA AI Foundation 模型是如何通过提供易于使用的模型体验界面,以及简化的模型微调和部署路径,从而帮助企业开发者找到适合各种用例的模型。

欢迎探索NVIDIA NGC 目录中提供的不同AI Foundation 模型(https://catalog.ngc.nvidia.com/ai-foundation-models),找到适合您的模型。

GTC 2024 将于 2024 年 3 月 18 至 21 日在美国加州圣何塞会议中心举行,线上大会也将同期开放。点击“阅读原文”或扫描下方海报二维码,立即注册 GTC 大会。

原文标题:利用 NVIDIA AI Foundation Models 构建自定义企业级生成式 AI

文章出处:【微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

-

英伟达

+关注

关注

22文章

3770浏览量

90986

原文标题:利用 NVIDIA AI Foundation Models 构建自定义企业级生成式 AI

文章出处:【微信号:NVIDIA-Enterprise,微信公众号:NVIDIA英伟达企业解决方案】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

NVIDIA推出全新生成式AI模型Fugatto

NVIDIA助力Amdocs打造生成式AI智能体

在设备上利用AI Edge Torch生成式API部署自定义大语言模型

生成式AI在制造业的应用现状和前景展望

NVIDIA与思科合作打造企业级生成式AI基础设施

NVIDIA AI助力SAP生成式AI助手Joule加速发展

NVIDIA携手Meta推出AI服务,为企业提供生成式AI服务

NVIDIA AI Foundry 为全球企业打造自定义 Llama 3.1 生成式 AI 模型

揭秘NVIDIA AI Workbench 如何助力应用开发

利用 NVIDIA AI Foundation Models 构建自定义企业级生成式 AI

利用 NVIDIA AI Foundation Models 构建自定义企业级生成式 AI

评论