Tensor Core GPU 掀起了一股生成式 AI 模型的淘金热。无论是帮助学生完成数学作业、计划假期,还是学习准备六道菜的饭菜,生成式 AI 都准备好了答案。但这只是人工智能的一个方面,并不是每个应用程序都需要它。

人工智能——现在是一个包罗万象的术语,指的是使用算法来学习、预测和做出决策的过程——模仿人类智能。它可以承担诸如识别面孔和模式以及解释解决问题的数据等工作。许多任务可以通过人工智能实现自动化,以提高生产力,并将对人脑来说过于复杂或需要太多手动工作的数据链接在一起。

但是,利用 AI 所需的计算能力差异很大,具体取决于应用程序和 AI 的类型。3 级自动驾驶需要与使用 AI 监控客户流量的零售应用程序截然不同的 AI。任务越复杂,结果越准确,对 AI 计算能力的需求就越大,训练 AI 必须收集的数据就越多。

那么,开发人员应该如何做出正确的 AI 选择呢?“人工智能需要从数据中学习,”西门子EDA集成电路设计验证AI/ML解决方案产品经理Dan Yu说,“每个开发人员需要问的第一个问题是,‘我在哪里可以获得数据来训练我的人工智能和机器学习模型?第三方数据可能可用,但您必须对其进行验证,以确保它是正确的数据,并且 AI/机器学习模型做出正确的预测。如果没有数据,就没有机器学习。

至少 70% 的 AI 训练时间用于查找正确的数据、清理数据以及从数据中提取有用的信息,这是很常见的。大部分余额都花在了微调人工智能和机器学习模型上。

“当我们谈论训练、微调和将人工智能机器学习模型部署到应用程序中时,许多自动驾驶领域的领导者都在努力寻找足够有意义的数据,”Yu 说。“他们可能有办法从行车记录仪和传感器(如汽车周围的激光雷达)收集大量数据,但大多数数据在训练人工智能模型时没有用。您希望模型能够体验所有难以想象的场景。例如,一栋建筑物刚刚倒塌在您的车辆前方。你的行动是什么?作为人类,我们知道我们想逃跑。它存在于人类基因中。但是,如果没有遇到这种情况,它就不在AI基因中。如果你没有数据来训练人工智能做某事,人工智能只会假设什么都没发生,自动驾驶汽车就会继续行驶。数据是无处不在的人工智能的关键部分。

人工智能的好处是有代价

的 人工智能在制造业、汽车、金融、医疗保健、教育、农业、智慧城市、娱乐、国防、能源、零售和数据中心等领域的作用越来越大。人工智能芯片现在安装在台式机和笔记本电脑中。然而,人工智能为众多行业带来的所有好处都不是免费的。

NVIDIA 的 Tensor Core GPU 的成本高达 40,000 美元,功耗高达 700W。对于科学和语言建模等高端应用,需要高性能机器学习系统,例如 Cerebras 的机器学习系统。由2.2万亿个晶体管和6,850个AI优化计算内核组成的新的第二代晶圆级处理器(WSE-000)将耗资数百万美元,并具有多个冗余4KW电源。

“每个人都在谈论生成式人工智能可以为你做的一切,但有一个隐藏的成本,”Ampere首席产品官Jeff Wittich说。“如果我们只关心运行最大性能,人工智能将很快成为世界第一大能源用户。如今,数据中心产生的一氧化碳已占全球的 3% 左右2——不仅仅是航空和航运。人工智能将需要更多倍的计算能力,而这很快就会失控。这可以比作拥有一辆赛车。当然,它可以跑得非常快,但它需要大量的燃料。对于比赛来说,这没关系。对于每个人来说,每天驾驶其中之一将是灾难性的。

优化模型和提高计算利用率是关键。“如今,许多 AI 推理模型都在耗电的 GPU 上运行,”Wittich 说。“这些 GPU 非常强大,可以快速运行模型,但我们越来越多地看到它们的功能没有得到充分利用。许多公司不需要一直使用所有电源,而 GPU 在闲置时仍在使用电源。

AI的类型

生成式 AI 和预测性 AI 是两种截然不同的 AI。前者需要高性能和密集计算,而后者可以使用低成本的SoC来实现。

瑞萨电子高级总监兼业务、加速和生态系统负责人Kaushal Vora表示:“当今的AI用例大致可分为两个领域——生成式AI和预测性AI。“生成式人工智能的主要目标是生成新内容,而预测性人工智能的目标是分析数据以做出预测和业务决策。生成式 AI 利用基础模型和转换器来针对语言学、文本、图像、视频等领域的广泛和大规模应用。这些模型往往非常大,通常消耗数百 GB 的内存,并且需要在云中以 GPU 和 CPU 的形式进行超大规模计算来训练和运行推理。

相比之下,预测性 AI 在资源受限的网络层上运行,例如网络边缘和物联网端点。“这种类型的人工智能通常也被称为边缘人工智能或TinyML,”Vora说。“边缘/端点的一些领域和用例正在迅速采用人工智能,包括语音作为人机通信、环境传感和预测分析以及机器维护的用户界面。我们看到广泛的垂直行业采用。运行这种AI的计算引擎通常是具有几个GOPS(每秒千兆操作)的微控制器,或者是性能低于1 TOPS的微处理器。

与此同时,生成式 AI 正在推动服务器级别对极高 AI 性能的需求。Synopsys AI/ML 处理器产品经理 Gordon Cooper 表示,该级别的关键性能指标 (KPI) 与性能有关,这意味着人们需要等待多长时间才能让生成式 AI 给出答案,以及面积和功耗/热成本。“唯一需要大量生成式人工智能(1,000+ TOPS)的实时应用是L3/L4自动驾驶。鉴于对生成式人工智能的兴奋和炒作,关于如何最好地将这些功能转移到边缘设备,人们提出了许多问题。算法必须发展。像 ChatGPT 这样的东西需要太多参数。实时人工智能的性能水平需要提高才能满足需求。

选择正确的 AI

在选择正确的 AI设计时需要考虑许多因素,包括项目目标、准确性要求、灵活性、中央计算与边缘计算以及设计权衡。

1) 项目目标

选择合适的 AI 取决于应用程序要求。您需要生成式 AI 还是预测性 AI 就足够了?复杂性、准确性、延迟、安全性、隐私性和安全性要求是什么?因为人工智能不是免费的,所以仅仅因为其他人都在做人工智能就包括人工智能是没有意义的。迟早,人工智能的炒作会消失。

例如,在使用聊天机器人将客户引导到正确部门的一般客户服务应用程序中,自然语言处理能力和流畅性很重要,但延迟和安全性并不是主要问题。几秒钟的延迟并不重要。相反,在自动驾驶中,准确性、延迟、安全性和安全性都非常重要。制动时延迟几秒钟可能会导致碰撞。用于控制娱乐系统的车内语音控制助手则是另一回事。故障可能会造成不便,但不会造成紧急情况。

同样重要的是要记住,每个决定都会影响整体预算。

2)什么才足够好?

一些开发人员倾向于不惜一切代价追求完美,或者至少想要高性能和准确性。但对于许多 AI 应用程序来说,达到 90% 的准确率就足够了。超过 95% 虽然可行,但成本可能非常高。因此,从最低要求开始。如果任务可以以 90% 的准确率得到满足,请到此为止。

3) 准确性 在做出 AI 芯片设计决策时,需要考虑多种因素,例如准确性、性能、移动性、灵活性和预算。

Synopsys战略营销经理Ron Lowman认为,两个简单的问题决定了将哪种AI芯片用于哪些应用。“首先,成功所需的最低精度是多少?其次,你能花多少钱来达到这个精度?人工智能只是一种新的生产力工具,随着时间的推移,非常聪明的工程师和企业家将对其进行迭代,以改进大量流程,类似于电力驱动电机而不是手动曲柄。如果您需要高精度和合理的预算,NVIDIA 的产品是合理的选择。但是,如果您可以接受低精度且预算较低,则可以选择成本低得多的 AI 芯片或 AI 加速有限甚至没有 AI 加速的传统 SoC。如果这些芯片需要移动且高效/低功耗,但预算较低,则可以接受更高效且精度较低的 SoC。如果你需要高精度和低功耗,这很昂贵,需要ASIC,或者你必须等到我们在新设计上迭代几代人。

最昂贵的类别是具有大量 AI 加速的 SoC,可处理高度定制的压缩算法。汽车需要高精度,并且需要移动和低功耗。“这意味着必须设计出比最高性能的 GPU/AI SoC 更高效的新 SoC,这需要大量投资。然后添加可靠性组件,“Lowman说。

人工智能设计标准中最重要的因素是准确性。

“精度通常受到位分辨率和/或算法选择的影响,”Cooper说。“使用转换器算法,其精度优于CNN,需要支持最新架构进步的神经网络和足够的位分辨率来实现精度 - 尽管在很大程度上依赖于算法。在准确性之后,性能至关重要。如果你不能达到每秒可用的帧数,世界上所有的准确性都无济于事,即使它在很大程度上取决于用例。其他因素包括成本(通常与芯片面积有关)、功耗和开发工具的易用性。

4) 灵活性

对于需要灵活性和快速软件升级的设计,可以考虑采用嵌入式 FPGA 方法。

Flex Logix 首席技术官 Cheng Wang 表示:“在实施 AI 时,无论是在芯片上还是在系统上,了解机器学习应用程序不断变化的工作负载需求都很重要。“你需要设计灵活性,因为人工智能领域的发展太快了。您的芯片设计周期为三到五年,并且需要立即进行软件升级。我们正在努力提高开发人员的意识。

集中式 AI 计算与边缘 AI 计算 虽然云计算提供了需要强大计算

能力的 AI 解决方案,但许多其他实时应用(如智慧城市、零售、增强现实和预防性维护)可能会从边缘 AI 中受益。

但是,这取决于正在构建的应用程序类型以及必须在其中工作的资源边界。

“传统上,从人工智能的角度来看,我们有一个以云为中心的智能模型,”瑞萨电子的Vora说。“如果我们真的想在网络的极端边缘和端点实现智能,就必须以一种高效、实时响应和具有成本效益的方式完成。”

这意味着在端点内的微型计算机上运行独立于云的推理引擎。

“去中心化的智能模型具有巨大的技术和经济效益,”Vora说。“作为设计师/架构师/产品开发人员,在定义阶段的早期考虑 AI/ML 并了解您必须使用哪些资源和系统约束至关重要。有多种软件和硬件架构可供选择。在使用边缘和端点应用程序时,请寻找一个合作伙伴/供应商,不仅提供芯片,还提供 AI/ML 工具、参考解决方案和软件的整体生态系统。

AI/ML应该在产品的定义阶段考虑,因为硬件选择主要由系统级需求和资源限制驱动。

大多数基于传感器的应用都可以使用植根于信号处理、数学和统计学的更简单的经典机器学习算法来解决。机器视觉和语音识别等更复杂的应用需要深度学习方法。用例的复杂性将影响硬件选择,包括在软件中运行 AI 的纯 CPU、与神经加速引擎相结合的 CPU、专用 AI SoC 和高性能 CPU/GPU。

展望未来:人工智能有两条道路。一个提供非常高的性能,但会消耗大量能量。另一个则更注重能源效率和优化。两者都有市场需求。

预计软件和硬件的新人工智能创新将继续发展。许多新的解决方案来自科技巨头和初创企业,包括 Axelera、SiMa.ai、Flex Logix、Quadric、Expedera、NeuReality、Kneron、Hailo.ai 等。以下是一些来自初创公司的例子。

根据 MLCommons ML Perf 3.1 基准测试中的封闭边缘功率类别,为 ML 边缘计算设计的“拖放式”无代码可视化编程据说优于该领域的一些当前领导者。

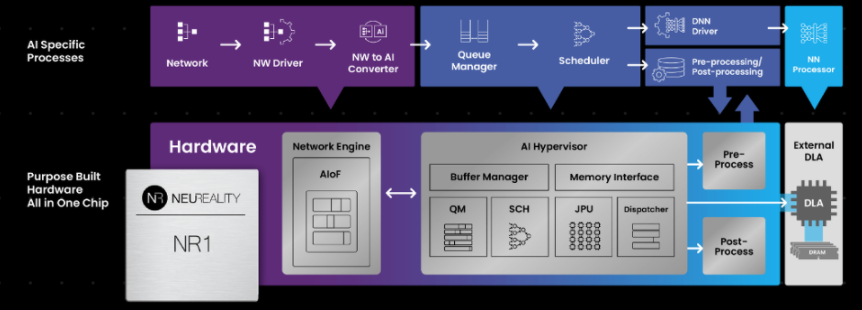

另一个进步是 AI 推理服务器架构试图取代传统的以 CPU 为中心的多用途 AI 解决方案。运行 ChatGPT 每天可能要花费数百万美元。运营效率现在变得越来越重要。系统级解决方案可以优化和扩展 AI 工作流程,以降低网络连接处理单元的整体运营成本。新的以人工智能为中心的方法更加基于硬件,可以更快地执行指令处理。

图 1:基于硬件的以 AI 为中心的架构依赖于网络连接的处理单元来执行大部分 AI 工作流。来源:NeuReality

最后,虽然 GPU 在 AI 应用中受到广泛关注,但在软件更新方面,嵌入式 FPGA 功耗更低、可扩展性更强且更灵活。这很重要,因为 AI 算法变化非常快,无论是为了提高性能和兼容性,还是出于安全原因。

结论

人工智能创新将继续加速。从长远来看,人工智能开发将更强大、更节能、更低成本,为开发者提供更多的人工智能选择

-

传感器

+关注

关注

2552文章

51246浏览量

754840 -

云计算

+关注

关注

39文章

7840浏览量

137562 -

gpu

+关注

关注

28文章

4754浏览量

129080 -

AI

+关注

关注

87文章

31158浏览量

269505 -

机器学习

+关注

关注

66文章

8428浏览量

132778

发布评论请先 登录

相关推荐

如何选择正确的AI?AI的类型有哪些?

如何选择正确的AI?AI的类型有哪些?

评论