电子发烧友网报道(文/李弯弯)今年以来,国内外大模型可以说是蓬勃发展。国外OpenAI已经陆续推出GPT-3.5,GPT-4以及升级版GPT-4 Turbo,并且已经实现较大规模的应用。据其统计,至今已有来自全球200万开发者正在使用OpenAI的API,92%的世界500强公司正在使用OpenAI的产品搭建服务,且ChatGPT的周活用户数达到1亿人。

此外Google、Anthropic、Cohere、Meta都在大模型上都有相应的进展。国内百度、阿里、腾讯、百川智能等也都发布了其大模型产品。据此前百度创始人、董事长兼首席执行官李彦宏表示,截至10月份,国内已经发布238个大模型。可以看到,国内外科技巨头及AI初创企业都投入到大模型的研究中。然而当下,大模型如何实现商业化应用成了业界关注的重点。

大模型商业化路径

大模型的商业模式基本可以分为两类:to C和to B。to C方面,目前来说已经有几个很好的案例,最为典型的就是OpenAI。去年11月底,OpenAI推出ChatGPT,两个月获得1亿月活用户,4个月后,月活用户突破10亿。巨大的用户积累让OpenAI有了实施to C业务的基础,今年2月,OpenAI推出付费订阅版ChatGPT Plus,每月收费20美元。

随后美国涌现出一大批类似的产品,基本都是面向C端使用,订阅付费模式。据应用商店监测平台Sensor Tower的数据,2023年上半年AI应用下载量同比增长114%,突破3亿次,超出2022年全年水平;此外,AI应用内购收入同比激增175%,逼近4亿美元。

向C端收费主要是基于OpenAI的大模型建立的应用,有一个案例,也是最早在C端赚到钱的公司——Jasper。最早在2020年,OpenAI推出GPT-3,次年,Jasper成立,通过接入GPT-3模型,针对市场营销场景做精调,自动生成各种风格的营销文案,当年就赚了3000万美元。

文案写作是一个需求明确的市场,用AI生成文案,只要效果比人好,就会有人买单。Jasper的用户中一度有超过四分之三的人每个月支付80美元甚至更多,来获得各种写作模板套件。它在2021年的收入超过给它提供底层技术的OpenAI。

后来,美国有非常多创业公司,调用大模型的API来打造新的应用,最火爆的是AI对话机器人和Midjourney这类AI图像生成产品,在应用商店分别贡献了49%、31%的下载量。据调查,这类公司一度比基础大模型公司更赚钱。有人在今年6月统计了全球月访问量最高的50个AIGC网站,发现名单上90%的应用有收入,几乎所有公司都采用订阅制。

在国内,第一个尝试此种商业模式的是百度,百度文心一言在11月1日上线专业版,每月收费59.9元。另外还有一款应用,就是今年7月火过一阵的妙鸭相机,收费9块9。

to B方面,一种是通过开放API接口的方式赚取收益,就如上文提到的Jasper,它接入OpenAI的GPT-3模型,需要向OpenAI支付调用API的授权费用。至今已有来自全球200万开发者正在使用OpenAI的API,可见OpenAIto B客户体量之大。

在国内,商汤也在走这样的模式,今年上半年商汤发布日日新大模型,产品并没有向C端消费者开放,它直接面向政企客户开放API接口。

to B业务方面还有另一种方式,即SaaS模式,AI厂商借助大模型的能力,给企业做方案、改系统、跑流程,最终降本增效,从而向客户收费。造物云创始人邱懿武此前在接收媒体采访的时候表示,他们曾帮助一家电子烟品牌做产品设计,花了100万找传统设计公司做了100多个方案,现在通过AI大模型,生成800个设计方案只花了10块钱的算力成本。

国内大模型发展现状

从目前的情况来看,国内大模型走B端市场更多,也就是之前大家提得比较多的行业大模型。即用行业数据对通用大模型进行精调形成的行业大模型,在特定领域实现应用。国内科技大厂从基础大模型做起,搭配行业大模型,抢占各大垂直行业,比如华为发布盘古大模型后,很快就在金融、制造、矿山、气象等垂直领域布局了垂直大模型,形成广泛覆盖。

互联网大厂也倾向于将自研的通用大模型,跟自己的云业务结合,如百度、腾讯、阿里等,在自己的云平台上搭载多个大模型然后把模型、算力、工具打包,以AI开发平台的形式对外提供服务。比如,百度的文心千帆大模型平台,企业可以在平台上选择基座大模型,调用各种工具,在云端做推理、微调及托管,生成自己的大模型,然后定制化开发产品。这种就不是单纯的调用API接口,对于客户来说更方便好用。

当前,国内外企业在大模型方面采用两种方式,一种是开源,一种是闭源。开源即开放源代码,允许开发者查看、修改和分发开源代码;闭源则与之对应,用户只能对产品有使用的权利,没有修改的权利。如Meta公司的ChatLLaMA就是国际上最为主流的开源大模型之一。在国内百川智能之前也推出了几款开源的大模型,据该公司介绍,其发布的Baichuan-7B/13B两款开源大模型累计下载量已超过600万次。

在这种开源大模型的协助下,国内外也涌现更多大模型产品。开源本身有它的好处,它有助于技术的快速迭代与创新,形成繁荣的生态。然而太多企业沉迷于研发属于自己的通用大模型,对于整个产业的商业化发展并不是一件特别好的事情。

近期,李彦宏就这个话题发表了观点,在他看来,目前,国内已经发布238个大模型,大模型太多,而模型之上开发的AI原生应用太少。他认为,人类进入AI时代的标志,不是产生很多的大模型,而是产生很多的AI原生应用。大模型本身是一个基础底座,类似操作系统,那么最终开发者要依赖为数不多的大模型来开发出各种各样的原生应用。

“不断地重复开发基础大模型是对社会资源的极大浪费。”他表示,由于没有智能涌现能力,专用大模型的价值其实非常有限。只有当模型的参数规模足够大,训练数据量足够多并且能够不断投入,进行迭代,才能够产生智能涌现,大模型才能具有触类旁通的能力。大模型的产业化模式,应该是把基础模型的通用能力和行业领域的专业知识相结合。

写在最后

当下,探索大模型商业化应用是重点。同时可以很明显的看到,大模型正在向边缘端渗透,尤其是在手机上的应用,大模型技术正逐步成为手机的标配。

今年以来,多家手机厂商相继传出其手机端侧的大模型已经跑通。本月初,vivo发布五个大模型矩阵,并于11月13日推出全球首个百亿大模型在终端跑通的大模型手机;小米创始人雷军也在近期表示,小米AI大模型最新一个13亿参数大模型已经成功在手机本地跑通;今年8月份,华为鸿蒙OS 4也宣布接入大模型。

当然,要将参数动辄百亿、千亿级的大模型放进手机端,也存在难点,成本高、自研难、算力消耗大等,这是手机及芯片厂商需要共同探讨解决的难关。

此外,大模型的持续研发带来的安全性问题也需要引起重视。最近OpenAI的人事变动风波,就起源于领导层对大模型安全性问题考量的分歧。据称,OpenAI两位顶尖研究人员 Jakub Pachocki 和 Szymon Sidor开发出了名为Q-Star的模型,它能够以前所未有的能力来解决数学问题。消息称,该模型的演示在OpenAI内部流传,其发展速度令一些关注人工智能安全的研究人员感到震惊。

Q-Star能够取得这种突破,本身基于Ilya Sutskever启动于2021年的一项重要工作:GPT-Zero。该项目研究如何使用计算机生成的数据——而不是现实世界的数据,例如从互联网上提取的文本或图像——来训练新模型。GPT-Zero获得了突破,于是OpenAI克服了高质量语料不足的障碍,一下子有了足够多的高质量数据来训练新模型。

Ilya对Q-Star持谨慎和警惕的态度,他担心该项目的持续突破将带来严重的危机,因此出现了最近的OpenAI人事变动风波。种种事件显示,科技企业在积极推进大模型研发和商业化应用的同时,也需要更多的关注它的持续突破可能带来的风险。

-

应用

+关注

关注

2文章

439浏览量

34363 -

AI

+关注

关注

87文章

33436浏览量

273978 -

大模型

+关注

关注

2文章

2923浏览量

3670

发布评论请先 登录

相关推荐

远东控股接入DeepSeek大模型 探索AI与产业深度融合新路径

添越智创基于 RK3588 开发板部署测试 DeepSeek 模型全攻略

DeepSeek模型成功部署,物通博联在 AI 赋能工业上持续探索、不断前行

AI大语言模型开发步骤

AI大模型的最新研究进展

AI大模型的商业应用案例分析

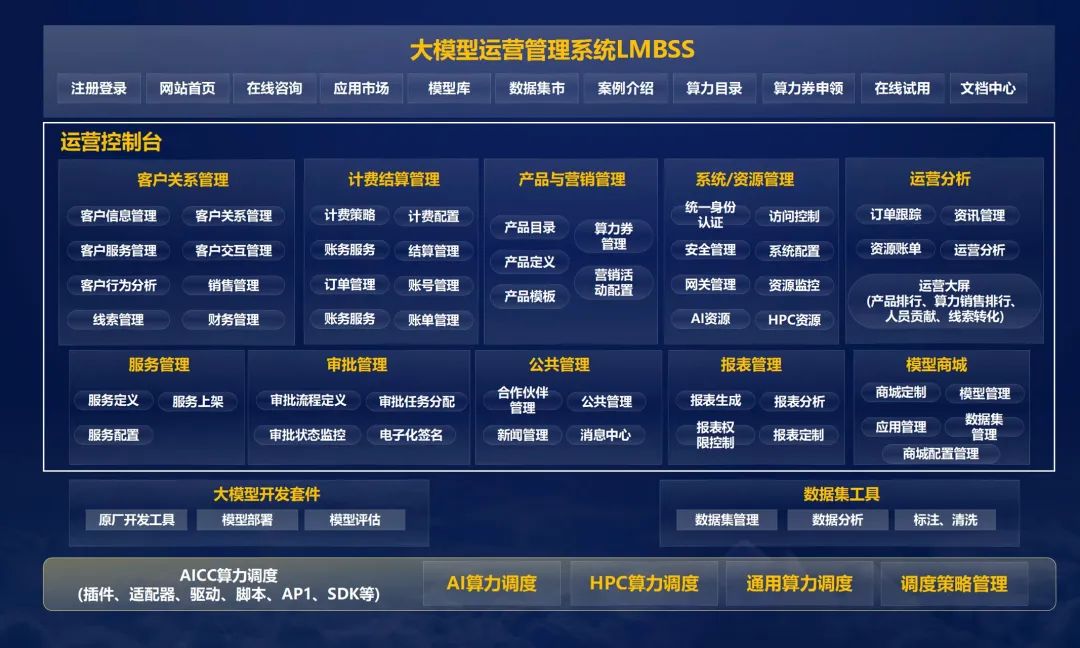

中软国际大模型运营管理系统推动AI商业化

聆思CSK6视觉语音大模型AI开发板入门资源合集(硬件资料、大模型语音/多模态交互/英语评测SDK合集)

大模型应用商业化落地关键:给企业带来真实的业务价值

大模型商业化路径探索!国内大模型多,开发的AI原生应用太少

大模型商业化路径探索!国内大模型多,开发的AI原生应用太少

评论