Orca-2-13B[1] 是微软最新发布的 Orca 2 系列中的一款模型,Orca 2 另外还提供 7B 版本。Orca 2系列模型是由 LLAMA 2 基础模型中微调而来。Orca 2系列模型擅长推理、文本总结、数学问题解决和理解任务,是在原始 13B Orca 模型的基础上进一步发展而来,模仿更强大的 AI 系统推理过程从而提高小型模型在复杂任务中的能力。

本文将以 Orca-2-13B 为例,将介绍:

如何在你自己的设备上运行 Orca-2-13B

如何为 Orca-2-13B 创建一个与 OpenAI 兼容的 API 服务

你也可以使用同样的方式运行 Orca-2-7B 模型,只需要替换 Orca-2-7B模型的 GGUF 格式的下载链接。

我们将用 Rust + Wasm 技术栈来开发和部署这个模型的应用程序。无需安装复杂的 Python 包或 C++ 工具链!了解我们为什么选择 Rust+Wasm 技术栈[2]。

在自己的设备上运行 Orca-2-13B

步骤 1:通过以下命令行安装 WasmEdge[3]。

curl-sSfhttps://raw.githubusercontent.com/WasmEdge/WasmEdge/master/utils/install.sh|bash-s----pluginwasi_nn-ggml

步骤 2:下载模型 GGUF 文件[4]。由于模型文件有几 GB,所以可能需要很长时间。

curl-LOhttps://huggingface.co/second-state/Orca-2-13B-GGUF/resolve/main/Orca-2-13b-ggml-model-q4_0.gguf

步骤 3:下载一个跨平台的可移植 Wasm 文件,用于聊天应用。该应用能让你用命令行与模型进行交流。戳这里[5]查看该应用的 Rust 源代码。

curl-LOhttps://github.com/second-state/llama-utils/raw/main/chat/llama-chat.wasm

就这样。接下来,可以通过输入以下命令在终端与模型进行聊天。

wasmedge--dir.:.--nn-preloaddefaultAUTO:Orca-2-13b-ggml-model-q4_0.ggufllama-chat.wasm-pchatml-s'YouareOrca,anAIlanguagemodelcreatedbyMicrosoft.Youareacautiousassistant.Youcarefullyfollowinstructions.Youarehelpfulandharmlessandyoufollowethicalguidelinesandpromotepositivebehavior.'--stream-stdout

这个可移植的 Wasm 应用会自动利用你设备上的硬件加速器(如 GPU)。

在我的 Mac M1 32G 内存设备上,它的速度约为每秒 9.15 个token。

[USER]:What isanOrca? [ASSISTANT]: Anorca,orkillerwhale,isalargetoothedpredatorbelongingtotheoceanicdolphinfamily.Theyarehighlyintelligentandsocialanimals,knownfortheircuriosityandplayfulness. [USER]:

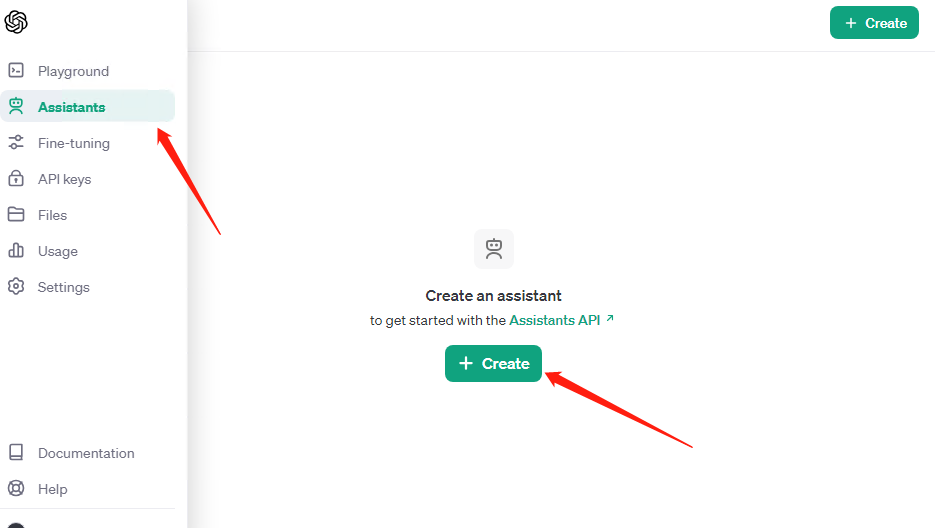

为 Orca-2-13B 创建一个与 OpenAI 兼容的 API 服务

一个与 OpenAI 兼容的网络 API 能让 Orca-2-13B 与大量的 LLM 工具和代理框架(如 flows.network、LangChain 和 LlamaIndex)一起工作。

首先,先下载一个 API 服务器应用。它也是一个可以在许多 CPU 和 GPU 设备上运行的跨平台可移植 Wasm 应用。

curl-LOhttps://github.com/second-state/llama-utils/raw/main/api-server/llama-api-server.wasm

然后,使用以下命令行启动模型的 API 服务器。

wasmedge--dir.:.--nn-preloaddefaultAUTO:Orca-2-13B.Q5_K_M.ggufllama-api-server.wasm-pchatml

从另一个终端,你可以使用 curl 与 API 服务器进行交互。

curl-XPOSThttp://0.0.0.0:8080/v1/chat/completions-H'accept:application/json'-H'Content-Type:application/json'-d'{"messages":[{"role":"system","content":"YouareahelpfulAIassistant"},{"role":"user","content":"WhatisthecapitalofFrance?"}],"model":"Orca-2-13B"}'

就这样。WasmEdge 是运行 Orca-2-13B 大模型应用程序最简单、最快、最安全的方式[6]。试试看吧!

审核编辑:刘清

-

C++语言

+关注

关注

0文章

147浏览量

6986 -

python

+关注

关注

56文章

4792浏览量

84621 -

硬件加速器

+关注

关注

0文章

42浏览量

12763 -

Rust

+关注

关注

1文章

228浏览量

6598 -

OpenAI

+关注

关注

9文章

1078浏览量

6479

原文标题:跨设备运行微软最新大语言模型 Orca-2-13B,只需4个命令行

文章出处:【微信号:Rust语言中文社区,微信公众号:Rust语言中文社区】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

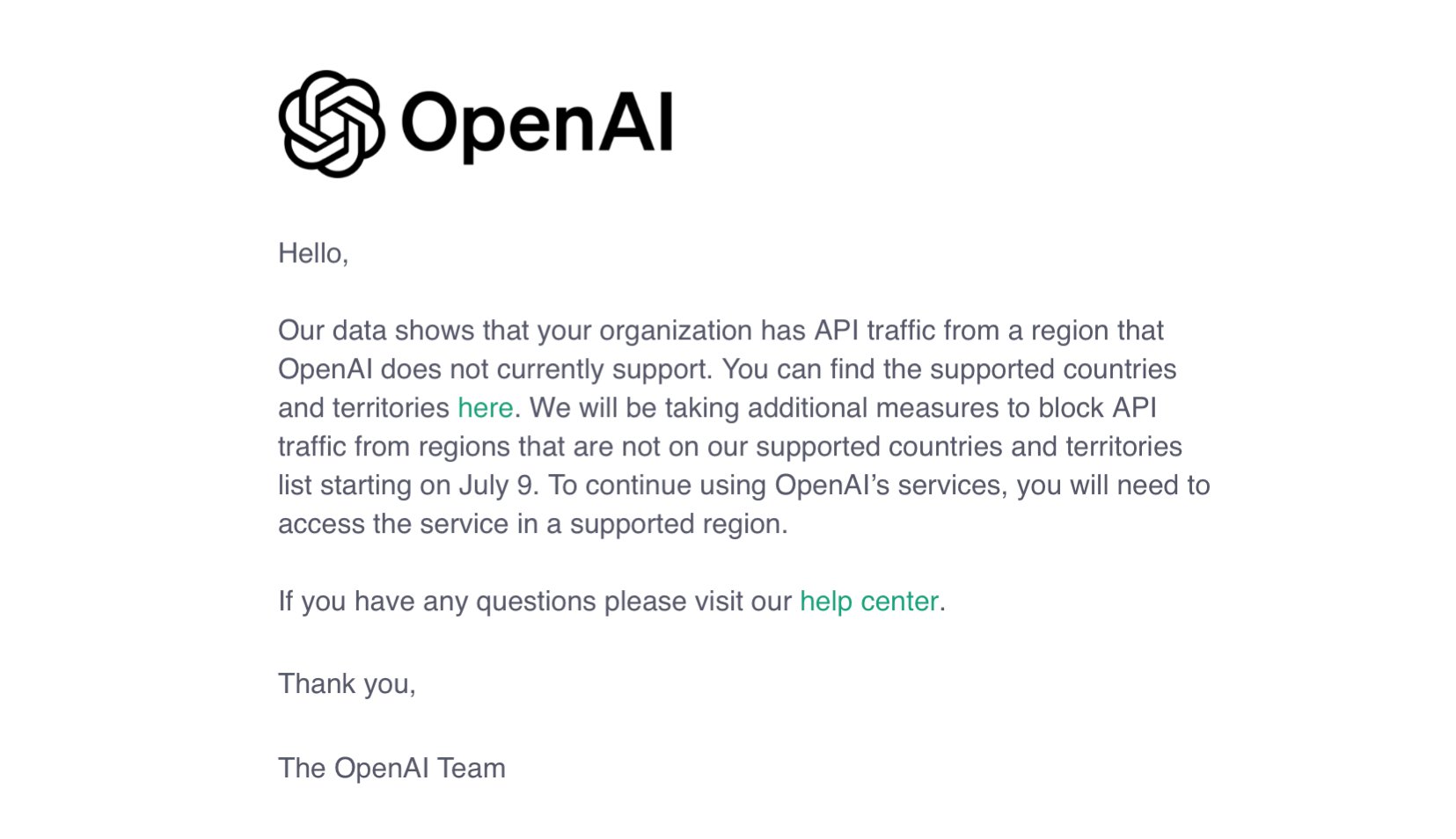

OpenAI断供API,国产大模型替代方案低成本迁移

OpenAI暂不推出Sora视频生成模型API

OpenAI发布o1模型API,成本大幅下降60%

微软终止中国大陆个人Azure OpenAI服务,为国内大模型带来机遇

华纳云:使用 WireMock 在开发和测试中模拟 API 服务

esp32上使用chatGPT做一些有意思的事情

OpenAI api key获取并可调用GPT-4.0、GPT-4o、GPT-4omini

如何使用espconn api实现一个Web服务器?

OpenAI将终止对中国提供API服务

OpenAI发出警告信:多国开发者面临API封锁 OpenAI API解决方案

OpenAI API Key获取:开发人员申请GPT-4 API Key教程

OpenAI 深夜抛出王炸 “ChatGPT- 4o”, “她” 来了

OpenAI API Key获取与充值教程:助开发者解锁GPT-4.0 API

如何为Orca-2-13B创建一个与OpenAI兼容的API服务呢?

如何为Orca-2-13B创建一个与OpenAI兼容的API服务呢?

评论